安装伪分布式流程

1.关防火墙

2.设置IP地址

3.设置network文件hosts映射文件

4.安装jdk 5.安装hadoop

6.配置hadoop: hadoop-env.sh、core-site.xml、hdfs-site.xml、 Mapred-site.xml、yarn-site.xml

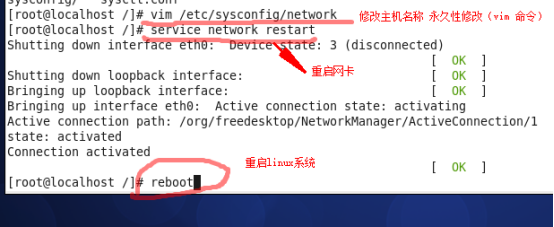

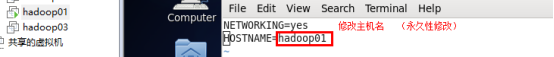

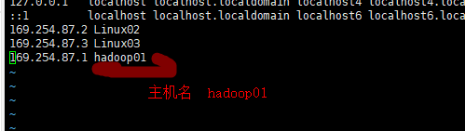

1 修改主机名(永久性: /etc/syscofig/network)

1.1重启网卡(命名行重启)

1.2 机器重启(reboot)

1.3 配置映射 vim/etc/hosts 识别本主机的映射

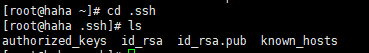

2 单节点的配置免密:

参考秘钥笔记

ssh -keygen -t rsa (生成私钥)

查看文件夹.ssh ()

ssh -copy-id 192.168.80.1

3 修改 hadoop-env.sh

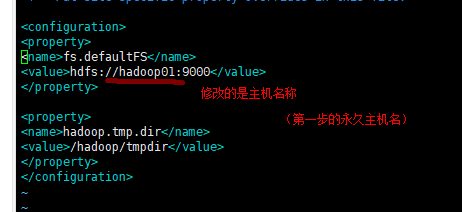

4 修改 core-site.xml (namenode服务的)

<property>

<name></name>

<value></value>

</property>

4.1 :namenode 的主机名和端口号 :主机名自己的 9000

4.2 hadoop 集群格式化之后形成的 (name 写死) (value路径:最好不要写成/root)

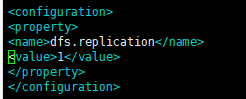

5 修改 hdfs-site.xml (副本数量) 3

Mv hah.txt haha1.txt

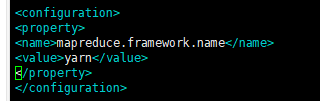

6 修改mapred-site.xml.template mr---->yarn

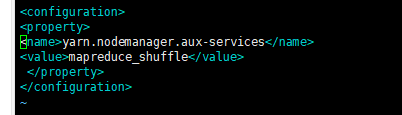

7 修改yarn-site.xml (服务于yarn) mr 运行在yarn上

Hdfs:分布式的 nodemanager (namenode) resourceManager(datenode)

一主多从的关系

统计一段时间内淘宝用户的登录:

1 记录(张三,1)(李四,1)(张三,1)(张三,1)(王五,1)(李四,1).。。。。。。。。。。

2mr :map(k,v)

(张三,(1,1,1))(李四,(1,1))(王五,1)

(张三,3)(李四,2)(王五,1) (shuffle:数据的从新分发)

reduce (合并)

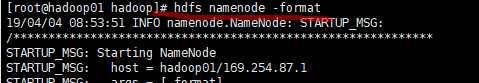

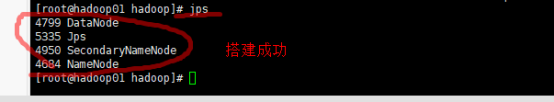

8 集群进行format

Hdfs namenode -format 产生 fsimage edits