参考自:

https://blog.csdn.net/qq_16234613/article/details/79679393

定义

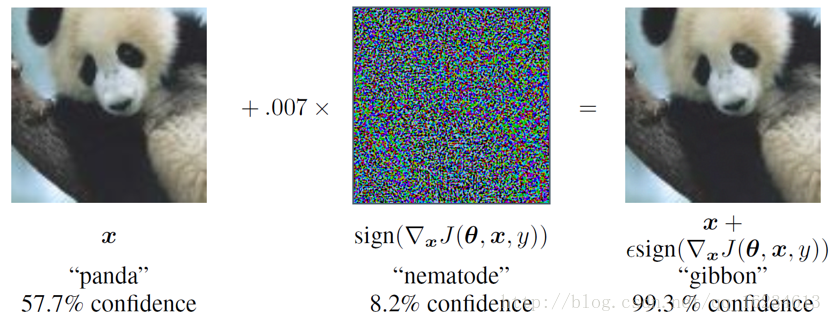

深度模型具有良好的泛化能力同时,也具有极高脆弱性。以分类为例:只需要通过故意添加细微的干扰所形成的输入样本(对抗样本),模型以高置信度给出了一个错误的输出。

当然这问题不仅出现在深度模型中,在其他机器学习模型也存在。“对抗样本”是安全方面非常好的一个议题,因为它代表了AI安全领域里的一种具体的问题。

如上样本x的label为熊猫,在对x添加部分干扰后,在人眼中仍然分为熊猫,但对深度模型,却将其错分为长臂猿,且给出了高达99.3%的置信度。

原因

很多人认为是模型的高度非线性导致的该问题。但《EXPLAINING AND HARNESSING ADVERSARIAL EXAMPLES》解释恰恰由于其线性本身导致的。

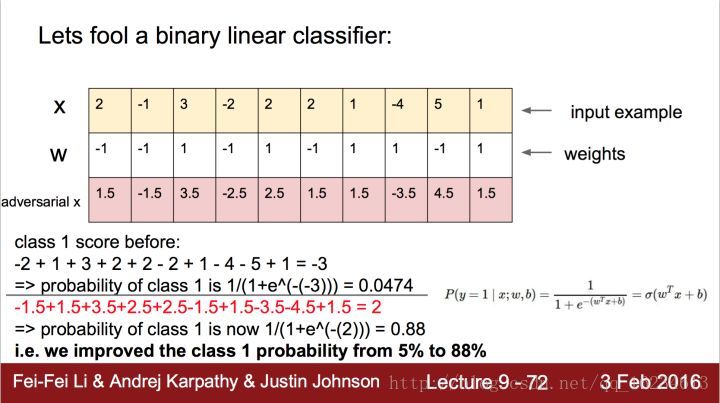

以y = W^T * X举例(W是权重,X是输入)。如果X’ = X + t,t为干扰,W^T * X’ = W^T * X + W^T * t,也就是多出一个 W^T * t项,W和t维数很大时,即使很小扰动,累加起来也很可观。

以上图二类器举例:只需一个小小改变,分类器就从5%的置信度上升到88%的置信度。

上图是识别鸟类模型,可以看到模型的模型神经元主要激活部分在鸟的头部,而对于对抗样本,模型会在类似于鸟头部的产生激活,从而错分。也就说明误导不仅对于最后输出,对底层的特征提取就开始了。一定程度上说明由于模型关注点只在于鸟头部,而对整体特征关注不足,导致容易受到局部视野的影响(是否由于卷积核过小缘故?)。

攻击分类

目前存在三种攻击模型的方式:

White-box attack:白盒攻击,对模型和训练集完全了解

Black-box attack:黑盒攻击:对模型不了解,对训练集不了解或了解很少

Real-word attack:在真实世界攻击。如将对抗样本打印出来,用手机拍照识别。

targeted attack:使得图像都被错分到给定类别上。

non-target attack:事先不知道需要攻击的网络细节,也不指定预测的类别,生成对抗样本来欺骗防守方的网络。

攻击方法

基于梯度的方法:

使用梯度下降来生成对抗样本。

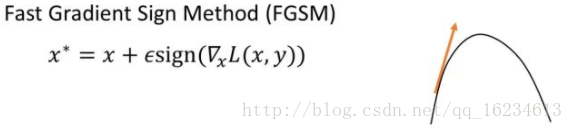

Fast Gradient Sign Method(FGSM,快速梯度法):给定一张图像,输入到神经网络,得到输出结果,使用梯度下降法修改原图使得预测结果变差。

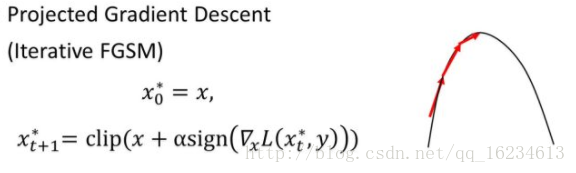

Iterative FGSM(迭代梯度法):多次使用FGSM。

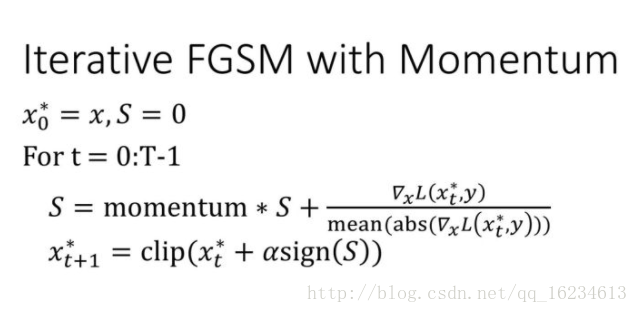

Iterative FGSM with Momentum(动量迭代梯度法):添加了momentum。

基于优化的方法:

使用精心设计的metrics来生成对抗样本。

防御方法

当放大图像时人眼还是能看到的观察到对抗样本的区别。

图像去噪:

廖方舟使用传统方法(中值滤波等)和深度网络模型U-Net试图使用去燥方法解决问题(PGD Pixel Guided Denoiser)。效果不佳,虽然绝大部分噪声被消除了,但是并没有增加分类准确率。他们研究将对抗样本和去噪后的图像输入到网络中,计算网络每一层的特征的距离。发现如果只是普通的噪声,比如高斯噪声,这些噪声的影响会随着网络的加深而逐渐变小;但是对于对抗样本的噪声,这些噪声的影响会随着网络的加深而逐渐变大。这一趋势在图像经过基本的去噪后仍然存在。后来提出HGD(High-Level Representation Guided Denoiser)方法。

对抗训练:生成对抗样本训练模型

其他

Deep neural networks are easily fooled, Nguyen et al, 2015

Practical black-box attacks against deep learning systems using adversarial examples, Papernot et al, 2016

Adversarial examples in the physical world, Goodfellow et al, 2017

Explaining and harnessing adversarial examples, Goodfellow et al, 2015

Distillation as a defense to adversarial perturbations against deep neural networks, Papernot et al., 2016

Vulnerability of deep reinforcement learning to policy induction attacks, Behzadan & Munir, 2017

Adversarial attacks on neural network policies, Huang et al. 2017

论文及PPT下载链接:https://pan.baidu.com/s/1i5Qszx7,密码:2qc9