1.开发环境

pycharm2017.3.3

python3.5

2.网络爬虫的定义

网络爬虫,也叫网络蜘蛛(web spider),如果把互联网比喻成一个蜘蛛网,spider就是一只在网上爬来爬去的蜘蛛,网络爬虫就是根据网页的地址来寻找网页的,也就是URL。举一个简单的例子,我们在浏览器的地址栏中输入的字符串就是URL,例如:https://www.baidu.com/

URL就是统一资源定位符(uniform resource location),他的一般格式如下(带方括号[]的为可选项)

protocol://hostname[:port]/path/[:parameters][?query]#fragment

URL的格式由三部分组成:

(1)protocol:第一部分就是协议,例如百度使用的就是https协议;

(2)hostname[:port]:第二部分人就是主机名(还有端口号为可选参数),一般网站默认的端口号为80

(3)path:第三部分就是主机资源的具体地址,如目录和文件名等,网络爬虫就是根据这个URL来获取网页信息的

3.简单爬虫实例

在Python3.x中,我们可以使用urllib这个组件抓取网页,urllib是一个URL处理包,这个包中集合了一下处理url的模块,如下:

(1)urllib.request模块是用来打开和读取URLs的;

(2)urllib.error模块包含一些由urllib.request产生的错误,可以使用try进行捕捉处理

(3)urllib.parse模块包含了一些解析URLs的方法;

(4)urllib.robotparser模块用来解析robots.txt文本文件,它提供了一个单独的RobotFileParser类,通过该类提供的can_fatch()方法测试爬虫是否可以下载一个页面

我们使用urllib.request.urlopen()这个接口函数就可以很轻松的打开一个网站,读取并打印信息

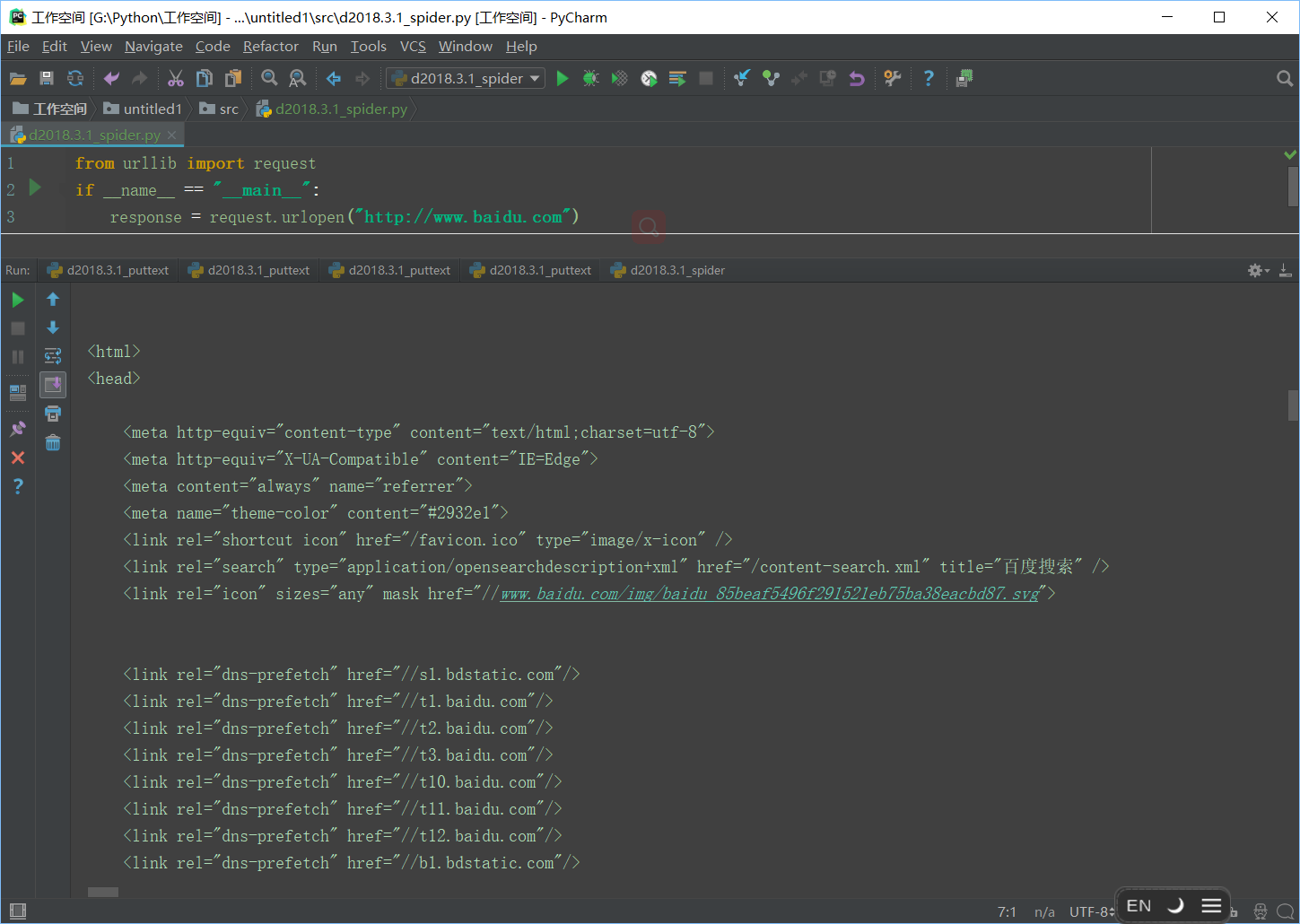

下面来写一个简单的程序实现一下

1 from urllib import request 2 if __name__ == "__main__": 3 response = request.urlopen("http://www.baidu.com") 4 html = response.read() 5 print(html)

运行结果(可以看到进度条还能拉倒很远)

这都是些什么鬼玩意呢

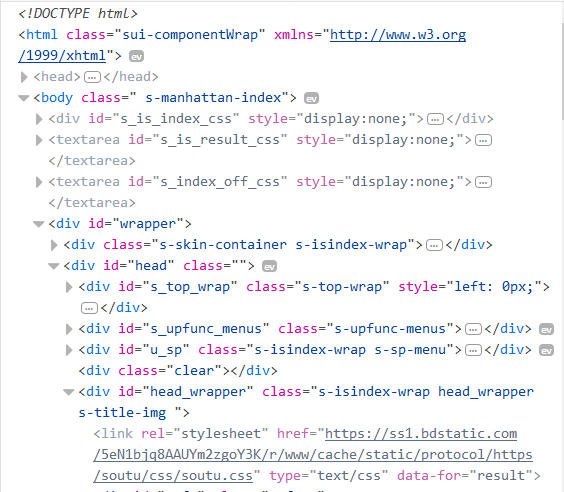

拿来对比一下,浏览器中打开www.baidu.com,查看页面元素,快捷键F12(浏览器最好用火狐或者Chrome)

东西都一样,就是格式有点乱,可以通过简单的decode()命令将网页的信息进行解码并显示出来,在代码中添加一句html=html.decode("utf-8")即可

1 from urllib import request 2 3 if __name__ == "__main__": 4 response = request.urlopen("http://www.fanyi.baidu.com/") 5 html = response.read() 6 html = html.decode("utf-8") 7 print(html)

输出正常的html格式

当然编码方式不是我们猜出来的,是查出来的,在查看元素中找到head标签,打开,看到charset="utf-8",就是编码方式

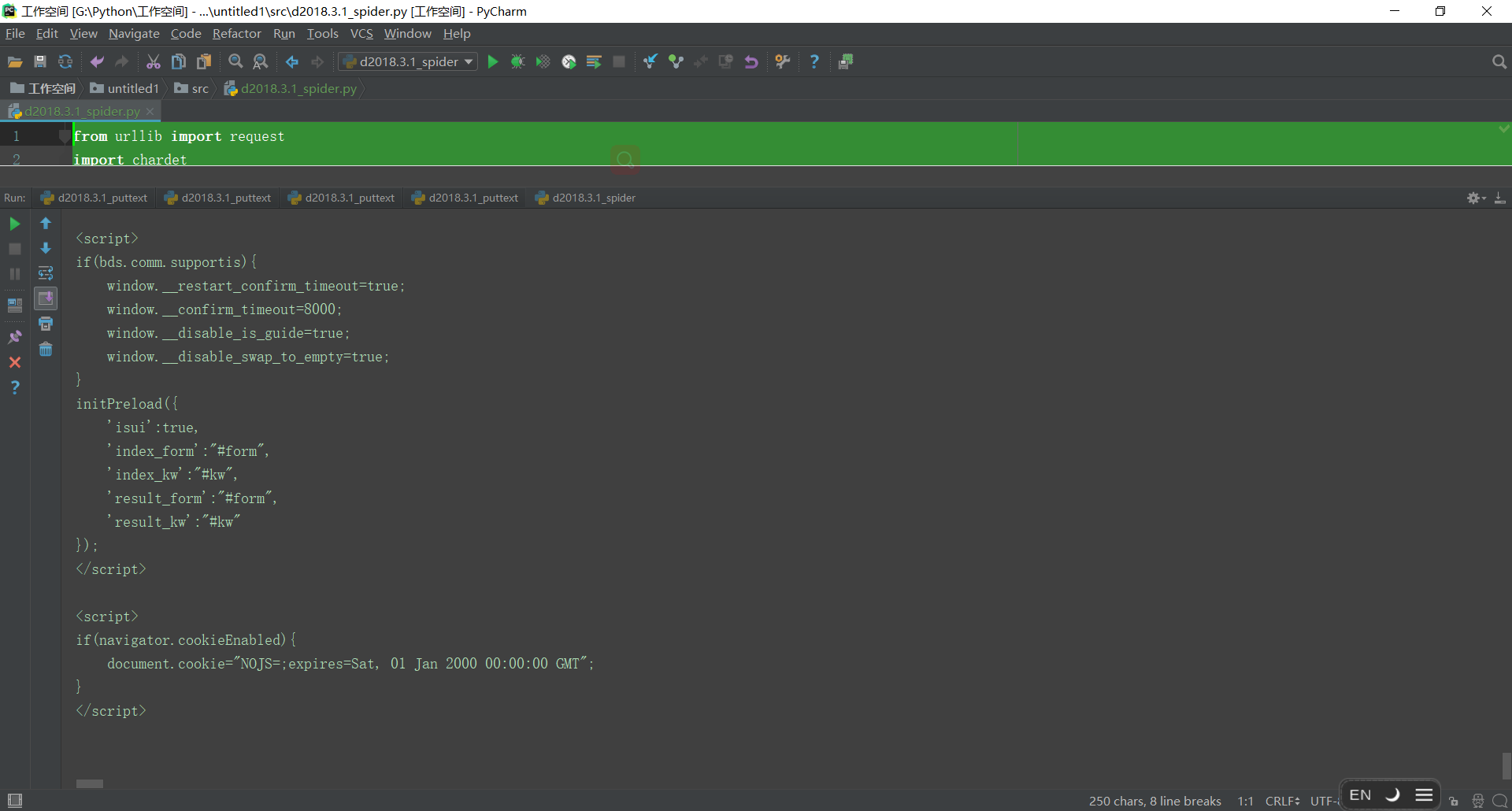

4.自动获取网页编码方式的方法

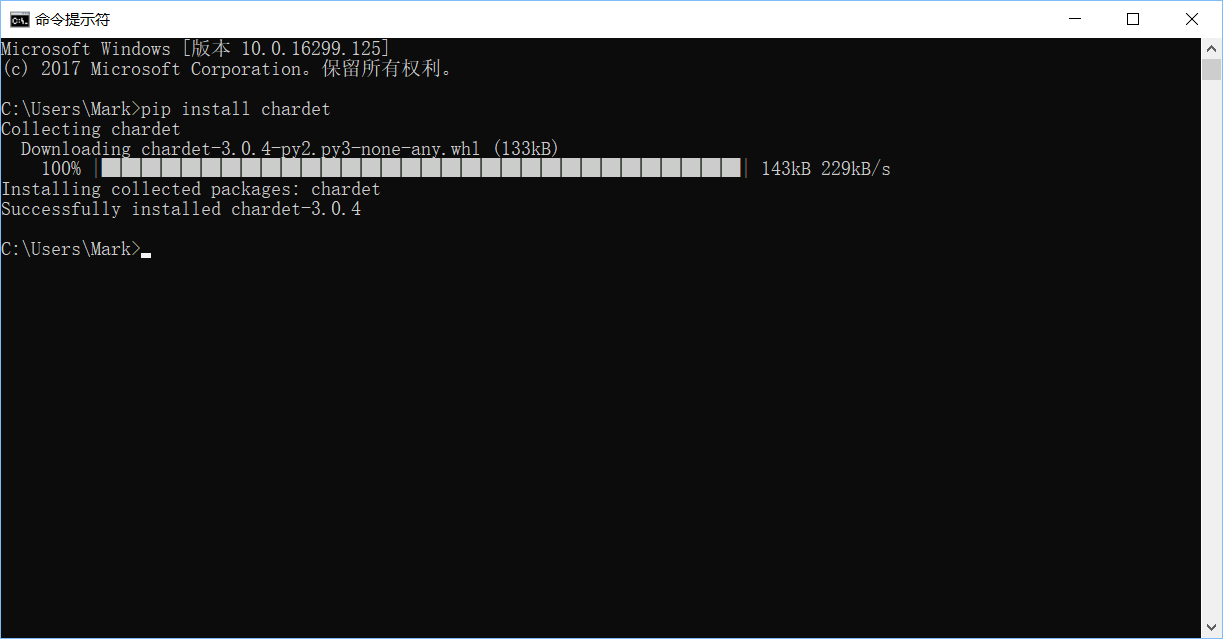

这里采用第三方库的方法,安装chardet

1 pip install chardet

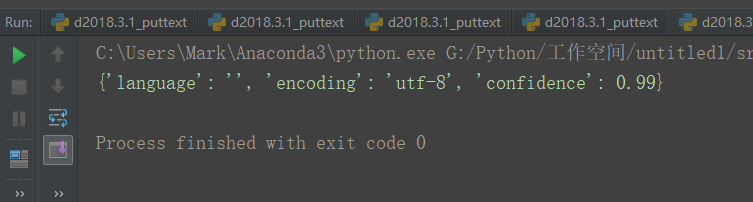

对代码稍作修改用来判断网页的编码方式

1 from urllib import request 2 import chardet 3 if __name__ == "__main__": 4 response = request.urlopen("http://www.baidu.com") 5 html = response.read() 6 #html = html.decode("utf-8") 7 charset = chardet.detect(html) 8 print(charset)

可以看到返回的是字典,最后也可以整合一下

1 from urllib import request 2 import chardet 3 if __name__ == "__main__": 4 response = request.urlopen("http://www.baidu.com") 5 html = response.read() 6 charset = chardet.detect(html) 7 html = html.decode(charset.get('encoding')) 8 9 print(html)

完美