概

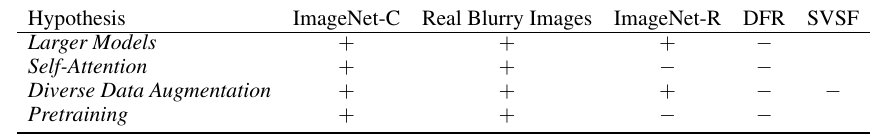

作者通过或采样或人造的数据集ImageNet Renditions, DeepFashion Remixed, StreetView StoreFronts来验证七个假设:

- 更大的模型能够提高鲁棒性;

- self-attention能够提高鲁棒性;

- diverse data augmentation 能够提高鲁棒性;

- 在更大更复杂的数据集上进行预训练能够提高鲁棒性;

- CNN更倾向于纹理信息, 这会破坏鲁棒性;

- 鲁棒性主要用在IID上的测试数据的正确率所反映(即提高泛化性的最有效途径是提高测试精度(IID上的));

- 人造数据所带来鲁棒性对于现实生活中j'kjk偏移没有帮助.

主要内容

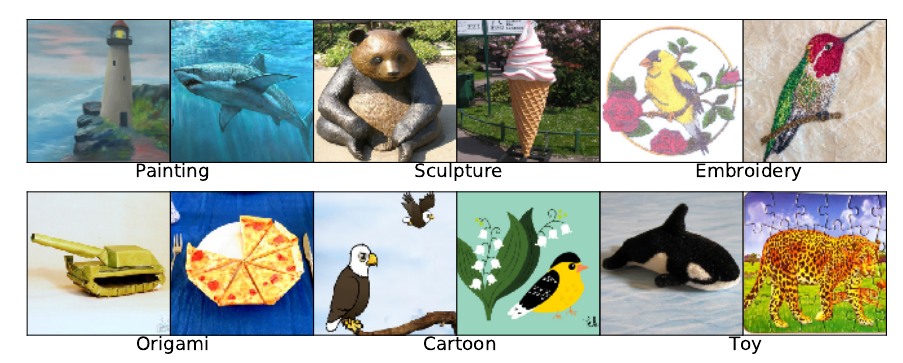

ImageNet-R

ImageNet-R包含了ImageNet中的200个类的艺术加工后的结果:

注: 原ImageNet是不包含艺术加工后的数据的.

StreetView StoreFronts (SVSF)

SVSF是从 Google StreetView imagery中采样的数据集, 包含3种不同类型的分布迁移: 国家, 年份 和 拍摄硬件(摄像机).

训练集: 于2019年, 在美国/墨西哥/加拿大通过新式摄像系统拍摄的照片;

测试集:

| Year | Country | Camera | |

|---|---|---|---|

| 1 | 2017 | US/Mexico/Canada | new |

| 2 | 2018 | US/Mexico/Canada | new |

| 3 | 2019 | France | new |

| 4 | 2019 | US/Mexico/Canada | old |

DeepFashion Remixed

DFR包括一个训练集和8个测试集, 测试集和训练集的差别在于在某个属性上有差异.

| object size | object occlusion | camera viewpoint | camera zoom | |

|---|---|---|---|---|

| Training | medium | medium | side/back | no zoom-in |

| 1 | small | medium | side/back | no zoom-in |

| 2 | large | medium | side/back | no zoom-in |

| 3 | medium | minimal | side/back | no zoom-in |

| 4 | medium | heavy | side/back | no zoom-in |

| 5 | medium | medium | frontal | no zoom-in |

| 6 | medium | medium | not-worn | no zoom-in |

| 7 | medium | medium | side/back | medium zoom-in |

| 8 | medium | medium | side/back | large zoom-in |

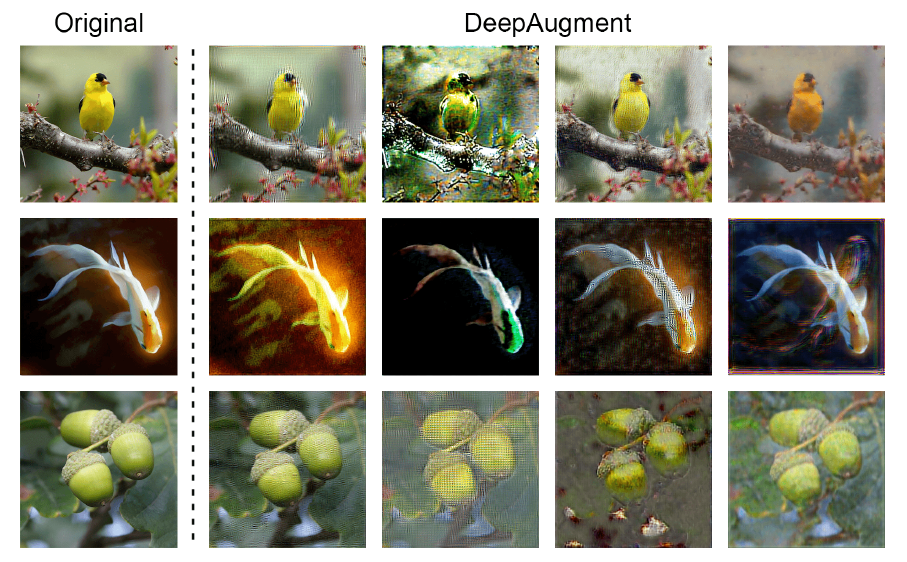

DeepAugment

DeepAugment算是一种特殊的augmentation, 即一个image-to-image的网络\(h(\cdot; \theta)\), 通过\(h(x; \theta + \delta)\), 网络参数上的扰动使得得到diverse的图片, 这些扰动包括: zeroing, negating, convolving, transposing, applying activation functions ...

实验结论

1,2,3,4四个假设对于ImageNet-C和真实的模糊图片是有效的, 但对于DFR, SVSF中的分布偏移却都不奏效. Larger Models和Diverse Data Augmentation对于ImageNet-R是有效果的(后者, 即 DeepAugment + AugMix的结果非常好).

对于CNN更偏向纹理信息, 从ImageNet-R中可以瞥见一二, 普通的CNN在ImageNet-R上的泛化性很差, 但是通过diverse data augmentation可以缓解这一问题(因为其在一定程度上打乱了纹理信息). 但是这类假设在DFR, SVSF却并不奏效, 这大概也说明texture bias并非是影响鲁棒性的唯一因素.

对于第六点, 虽然IID上的正确的确很重要, 但是正如上表所示, 大模型, diverse的数据增强对于泛化性很大的帮助(但是对于IID收效甚微).

对于最后一点, 即人造数据的作用, 显然人造数据的确是能够增加泛化性的, 虽然这类方法在面对地理偏移等时效果不明显.