理解分类与监督学习、聚类与无监督学习

(1)简述分类与聚类的联系与区别。

分类任务就是通过学习得到一个目标函数f,把每个属性集x映射到一个预先定义的类标号y中。分类是根据一些给定的已知类别标号的样本,训练某种学习机器(即得到某种目标函数),使它能够对未知类别的样本进行分类。这属于supervised learning(监督学习)。通过学习来得到样本属性与类标号之间的关系。

用自己的话来说,就是我们根据已知的一些样本(包括属性与类标号)来得到分类模型(即得到样本属性与类标号之间的函数),然后通过此目标函数来对只包含属性的样本数据进行分类。

而聚类指事先并不知道任何样本的类别标号,希望通过某种算法来把一组未知类别的样本划分成若干类别,聚类的时候,我们并不关心某一类是什么,我们需要实现的目标只是把相似的东西聚到一起,这在机器学习中被称作 unsupervised learning (无监督学习)。通常,人们根据样本间的某种距离或者相似性来定义聚类,即把相似的(或距离近的)样本聚为同一类,而把不相似的(或距离远的)样本归在其他类。聚类的目标:组内的对象相互之间时相似的(相关的),而不同组中的对象是不同的(不相关的)。组内的相似性越大,组间差别越大,聚类就越好。

分类作为一种监督学习方法,要求必须事先明确知道各个类别的信息,并且断言所有待分类项都有一个类别与之对应。但是很多时候上述条件得不到满足,尤其是在处理海量数据的时候,如果通过预处理使得数据满足分类算法的要求,则代价非常大,这时候可以考虑使用聚类算法。

(2)简述什么是监督学习与无监督学习。

监督学习:从给定的训练数据集中学习出一个函数(模型参数),当新的数据到来时,可以根据这个函数预测结果。监督学习的训练集要求包括输入输出,也可以说是特征和目标。训练集中的目标是由人标注的。

无监督学习:输入数据没有被标记,也没有确定的结果。样本数据类别未知,需要根据样本间的相似性对样本集进行分类(聚类,clustering)试图使类内差距最小化,类间差距最大化。通俗点将就是实际应用中,不少情况下无法预先知道样本的标签,也就是说没有训练样本对应的类别,因而只能从原先没有样本标签的样本集开始学习分类器设计。

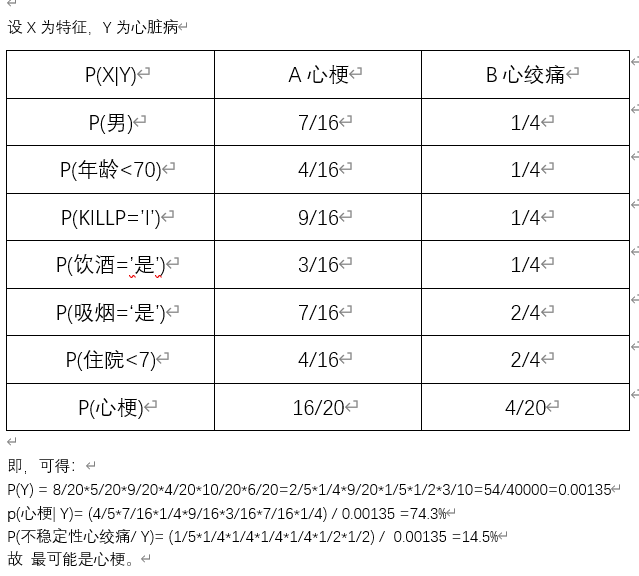

朴素贝叶斯分类算法 实例

利用关于心脏病患者的临床历史数据集,建立朴素贝叶斯心脏病分类模型。

有六个分类变量(分类因子):性别,年龄、KILLP评分、饮酒、吸烟、住院天数

目标分类变量疾病:

–心梗

–不稳定性心绞痛

新的实例:–(性别=‘男’,年龄<70, KILLP=‘I',饮酒=‘是’,吸烟≈‘是”,住院天数<7)

最可能是哪个疾病?

上传手工演算过程。

|

性别 |

年龄 |

KILLP |

饮酒 |

吸烟 |

住院天数 |

疾病 |

|

|

1 |

男 |

>80 |

1 |

是 |

是 |

7-14 |

心梗 |

|

2 |

女 |

70-80 |

2 |

否 |

是 |

<7 |

心梗 |

|

3 |

女 |

70-81 |

1 |

否 |

否 |

<7 |

不稳定性心绞痛 |

|

4 |

女 |

<70 |

1 |

否 |

是 |

>14 |

心梗 |

|

5 |

男 |

70-80 |

2 |

是 |

是 |

7-14 |

心梗 |

|

6 |

女 |

>80 |

2 |

否 |

否 |

7-14 |

心梗 |

|

7 |

男 |

70-80 |

1 |

否 |

否 |

7-14 |

心梗 |

|

8 |

女 |

70-80 |

2 |

否 |

否 |

7-14 |

心梗 |

|

9 |

女 |

70-80 |

1 |

否 |

否 |

<7 |

心梗 |

|

10 |

男 |

<70 |

1 |

否 |

否 |

7-14 |

心梗 |

|

11 |

女 |

>80 |

3 |

否 |

是 |

<7 |

心梗 |

|

12 |

女 |

70-80 |

1 |

否 |

是 |

7-14 |

心梗 |

|

13 |

女 |

>80 |

3 |

否 |

是 |

7-14 |

不稳定性心绞痛 |

|

14 |

男 |

70-80 |

3 |

是 |

是 |

>14 |

不稳定性心绞痛 |

|

15 |

女 |

<70 |

3 |

否 |

否 |

<7 |

心梗 |

|

16 |

男 |

70-80 |

1 |

否 |

否 |

>14 |

心梗 |

|

17 |

男 |

<70 |

1 |

是 |

是 |

7-14 |

心梗 |

|

18 |

女 |

70-80 |

1 |

否 |

否 |

>14 |

心梗 |

|

19 |

男 |

70-80 |

2 |

否 |

否 |

7-14 |

心梗 |

|

20 |

女 |

<70 |

3 |

否 |

否 |

<7 |

不稳定性心绞痛 |

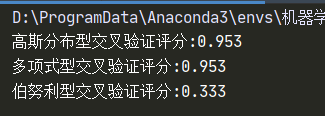

使用朴素贝叶斯模型对iris数据集进行花分类

尝试使用3种不同类型的朴素贝叶斯:

- 高斯分布型

- 多项式型

- 伯努利型

并使用sklearn.model_selection.cross_val_score(),对各模型进行交叉验证。

"""

@author Rakers

@time 2020.05.11

"""

from sklearn.model_selection import cross_val_score #交叉验证

from sklearn.naive_bayes import GaussianNB # 高斯分布型

from sklearn.naive_bayes import MultinomialNB # 多项式型

from sklearn.naive_bayes import BernoulliNB # 伯努利型

from sklearn.datasets import load_iris #iris数据集

iris = load_iris()

# 高斯分布型

gnb1 =GaussianNB() # 构造建立模型

gnb1.fit(iris.data ,iris.target) # 模型训练,拟合

scores =cross_val_score(gnb1 ,iris.data ,iris.target ,cv=10)

print("高斯分布型交叉验证评分:%.3f " %scores.mean())

# 多项式型

mnb = MultinomialNB()

mnb.fit(iris.data, iris.target) # g构造模型

scores =cross_val_score(mnb ,iris.data ,iris.target ,cv=10)

print("多项式型交叉验证评分:%.3f " %scores.mean())

# 伯努利型

bnb = BernoulliNB()

bnb.fit(iris.data, iris.target) # g构造模型

scores =cross_val_score(bnb ,iris.data ,iris.target ,cv=10)

print("伯努利型交叉验证评分:%.3f " %scores.mean())

运行截图