200813_tensorflow2---1、基础

一、总结

一句话总结:

讲课的时候可以考虑就像这样讲,把需要的基础东西先过一遍,用什么讲什么,这样减轻记忆力,极好的

1、常用函数 t.Variable?

①、tf.Variable()将变量标记为“可训练”,被标记的变量会在反向传播中记录梯度信息。神经网络训练中,常用该函数标记待训练参数。

②、tf.Variable(初始值) w=tf.Variablet(tf.random.normal([2,2],mean=0,stddev=1)

2、常用函数 t.data.Dataset.from_tensor_slices?

①)、切分传入张量的第一维度,生成输入特/标签对,构建数据集

②)、data=tf.data.Dataset.from_tensor_slices((输入特征,标签)) (Numpy和Tensor格式都可用该语句读入数据)

3、常用函数 t.GradientTape with?

(①)、结构记录计算过程,gradient求出张量的梯度

(②)、with tf.Gradient Tape() as tape:grad=tape.gradient(函数,对谁求导)

with tf.Gradient Tape() as tape:

若干个计算过程

grad=tape.gradient(函数,对谁求导)

4、常用函数enumerate?

(一)、enumerate是python的内建函数,它可遍历每个元素(如列表、元组或字符串),组合为:索引元素,常在for循环中使用。

(二)、enumerate(列表名)

seq=['one','two','three'] for i,element in enumerate(seq): print(i,element) 运行结果: 0 one 1 two 2 three

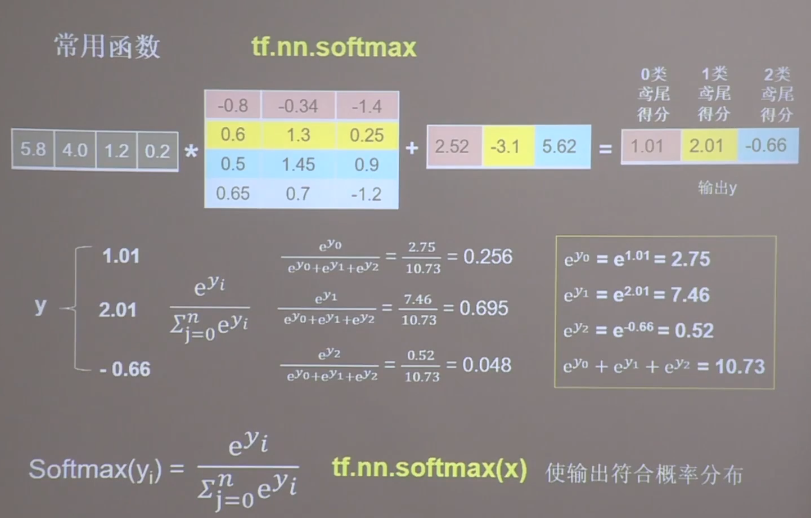

5、softmax的公式的确很简单:tf.nn.softmax(x)?

$$frac { e ^ { y _ { i } } } { sum _ { j = 0 } ^ { n } e ^ { y _ { i } } }$$

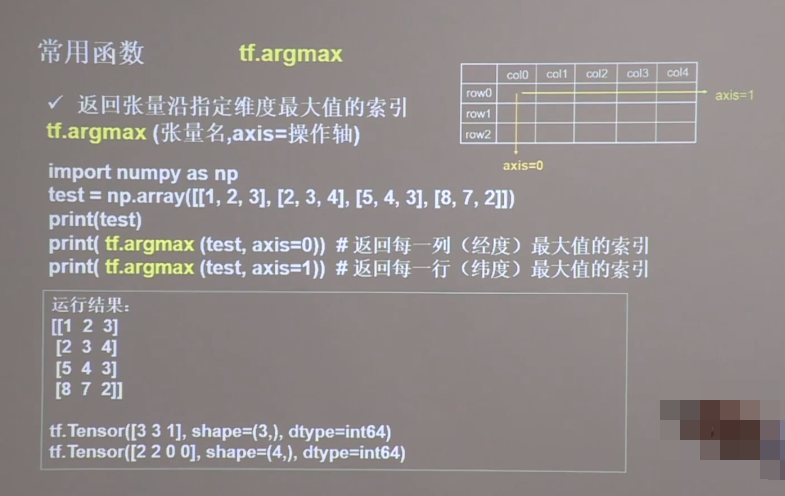

6、常用函数tf.argmax?

返回张量沿指定维度最大值的索引tf.argmax(张量名,axis=操作轴),axis为0取列,axis为1取行

二、基础

博客对应课程的视频位置: