论文链接:https://arxiv.org/pdf/1902.10909.pdf

这篇论文的思路非常简单,就是把BERT用来同时做意图分类和槽填充,其中[CLS]对应的隐藏状态(h_1)用来做句子分类:

[y^i = softmax(W^ih_1+b^i)

]

同时又拿最后一层每个subword对应的隐藏状态(h_2, ..., h_T)做token分类:

[y_n^s = softmax(W^sh_n + b^s), n in 1, ..., N

]

联合模型的目标函数为两个子任务极大似然之积:

[p(y^i, y^s|x) = p(y^i|x)prod_{n=1}^N p(y_n^s|x)

]

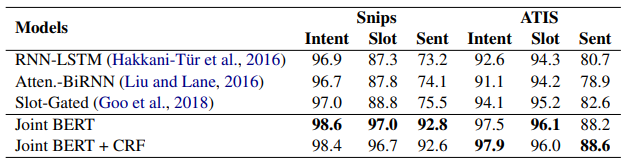

实验结果: