原文:https://blog.51cto.com/beanxyz/2134125

背景介绍

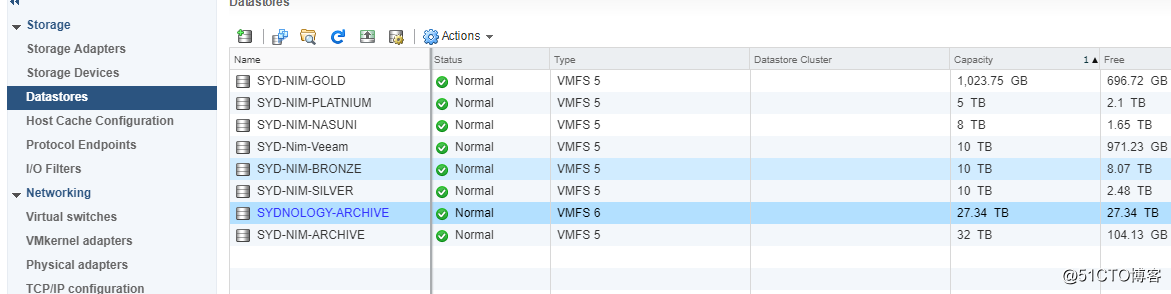

公司之前用的存储是Nimble Storage,上面大概有25T左右的空间都是历史的归档文件服务器,平常访问不多,又占据空间,为了节约空间,我们打算弄个低端的NAS存储,把这些不怎么用的服务器都挪过去。想到就做,给供应商下单买了一个Synology NAS的设备。一周后到货,豆子着手开始配置。

基本流程

- NAS设备设置ISCI Target和LUN

- 物理交换机上配置一个单独的VLAN,物理连线

- Vsphere web client上面配置vmkernal,iscsi 端口绑定等等

- 测试

下面看具体步骤

1. NAS

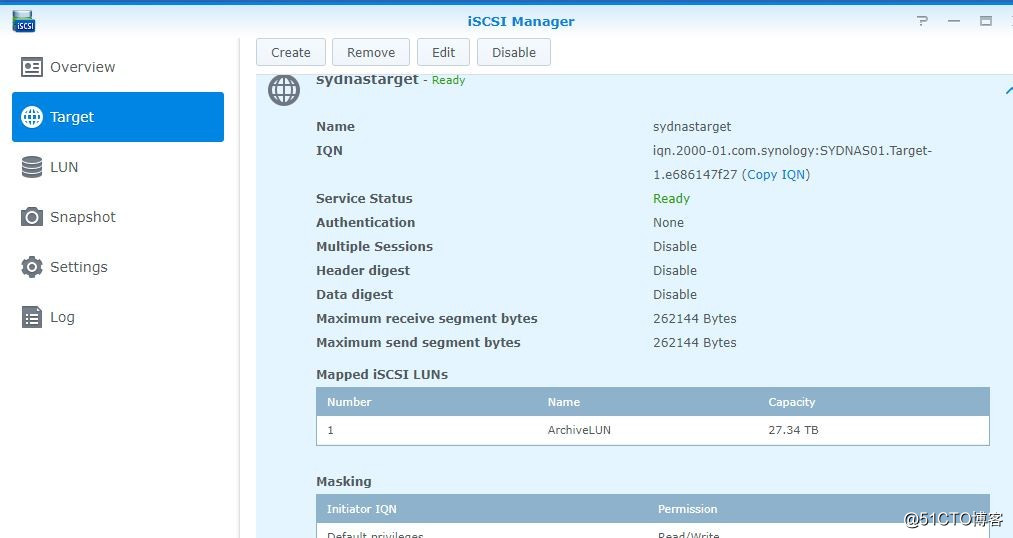

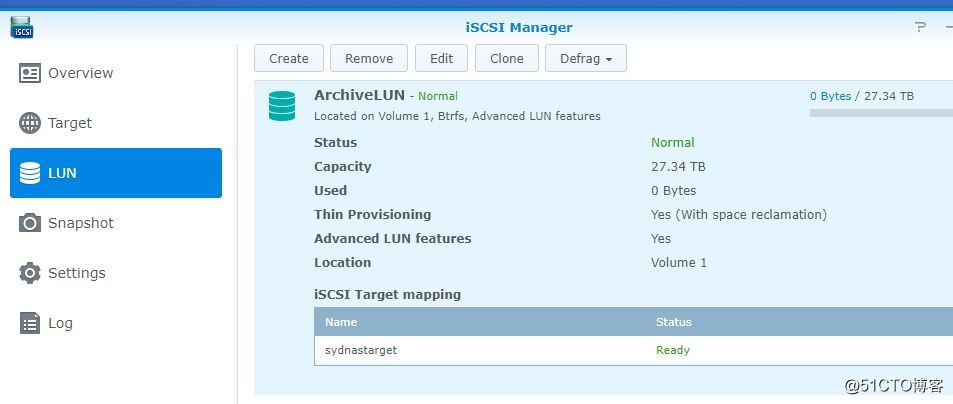

需要进入 ISCSI Manger,在这里设置ISCSI target 和 LUN

设置好的界面如下所示

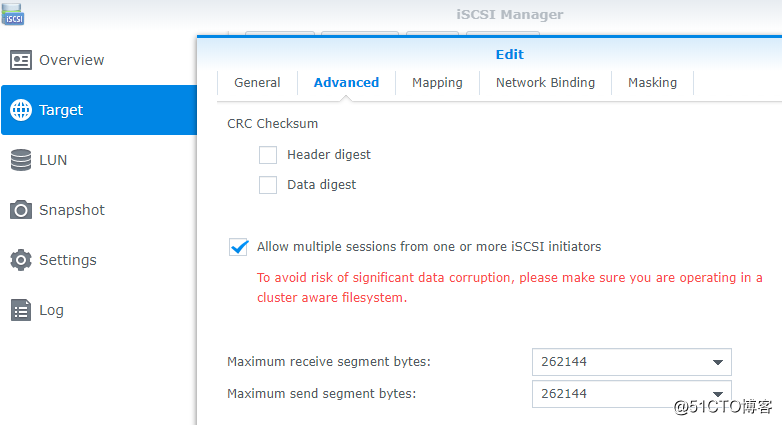

值得一提的是在Target的高级设置里面,一定要勾选 Allow multiple sessions from one or more iSCSI initiators, 这个是为了后面配置MPIO多路径访问,不然默认只会生成一条访问路径

2. 物理交换机配置和连接

我设置的网络结构很简单,就是找了一个普通HP 2920 交换机,上面单独开了一个VLAN,ESXi主机和NAS上面各自连接了2根线上去。

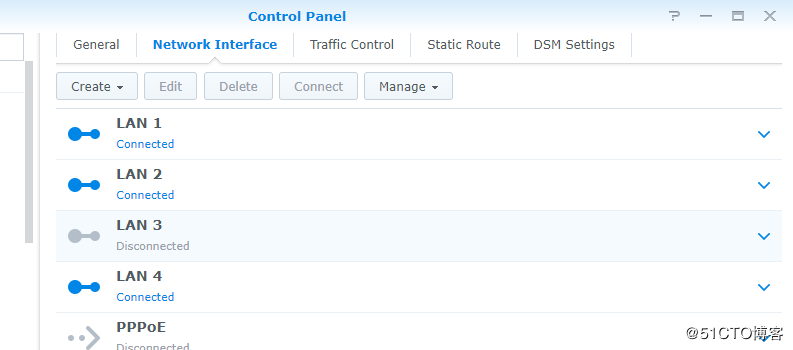

NAS提供了4个网卡接口,LAN1和LAN2 我作为ISCSI的链接,LAN4作为管理接口

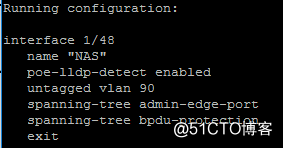

交换机上直接设置一个layer2的VLAN即可

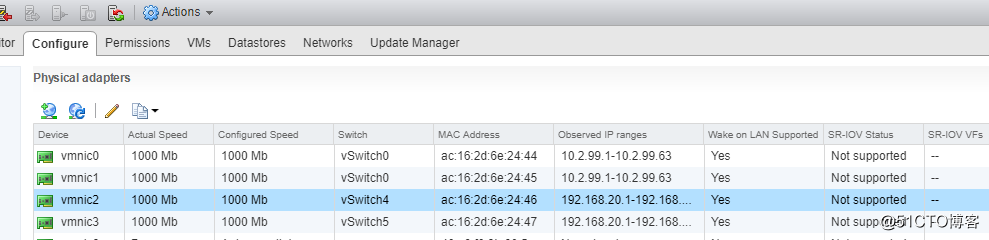

ESXi 上我随便找了2个1G端口

3. Web Client 配置Multipath端口绑定

豆子用的是Vsphere 6.5, 配置需要从 Vsphere Web Client上设定。

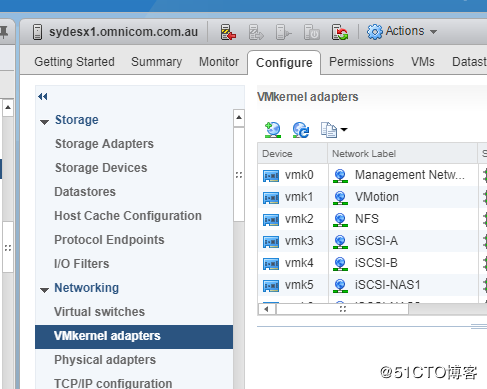

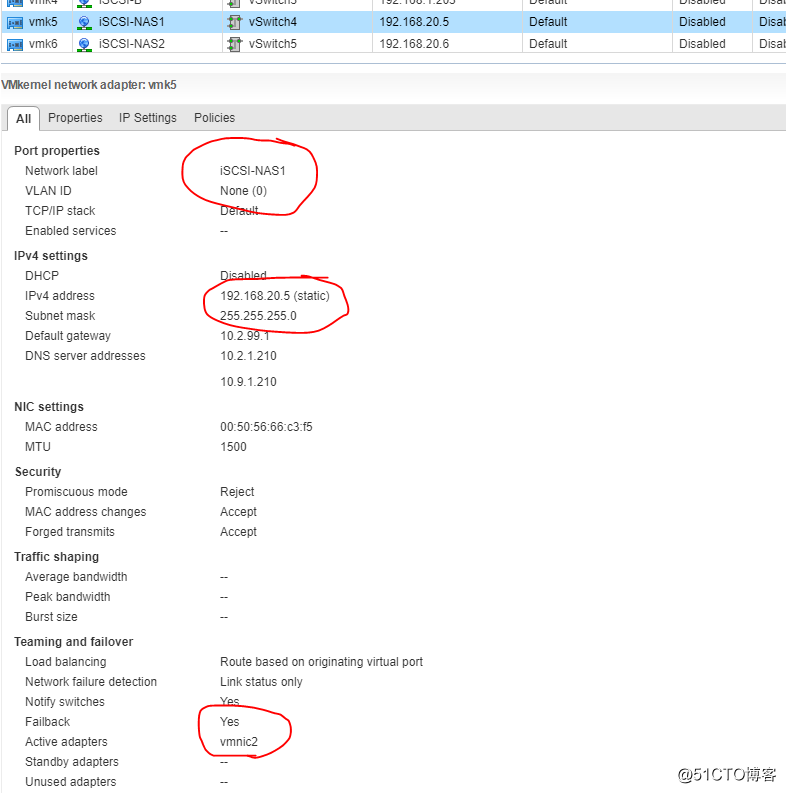

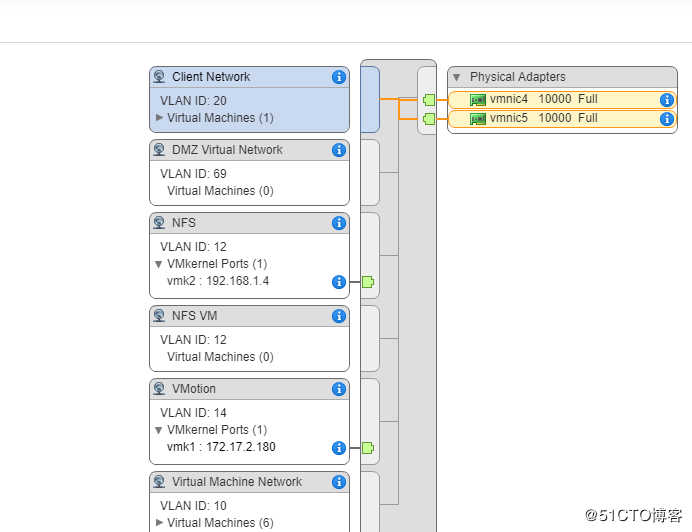

为了使用MPIO,我们需要配置两个vmkernal,每个vmkernal单独绑定一个标准的虚拟交换机,每个虚拟交换机上绑定一个物理端口,最后在ISCSI Software Adapter上添加我们的vmkernal

首先来创建vmkernal port

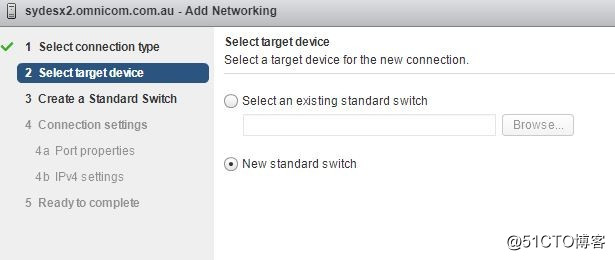

点击新建

标准交换机

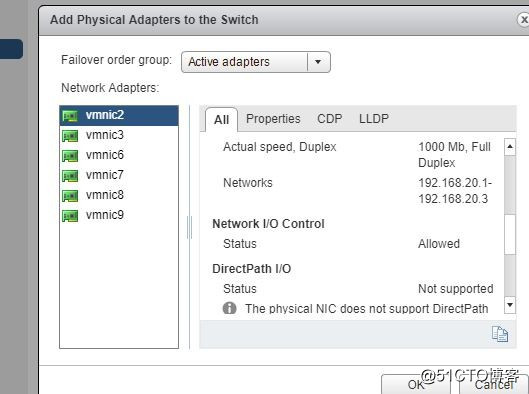

绑定一个物理网卡

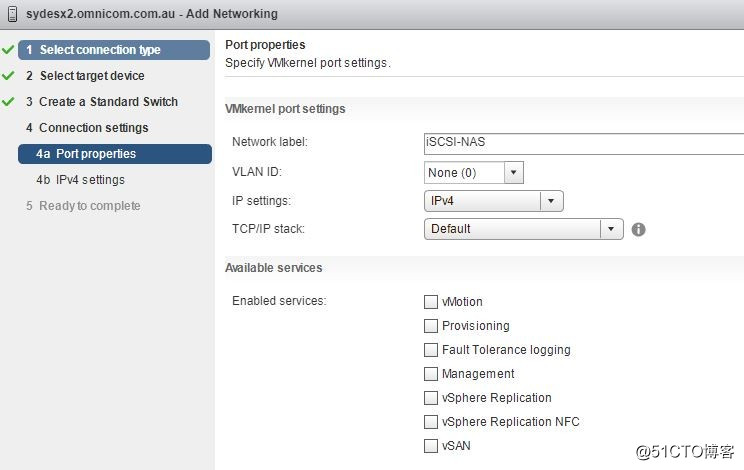

取名字,其他的不用勾选

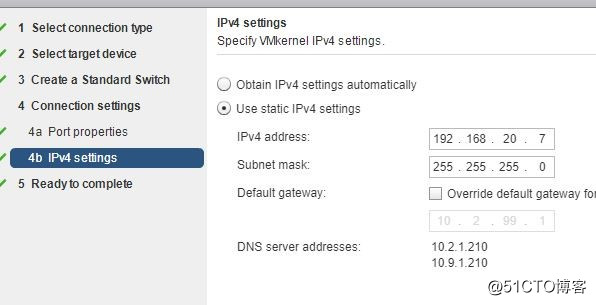

给个IP地址

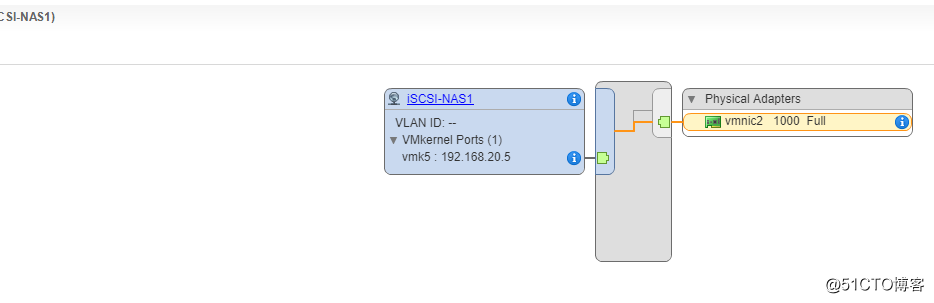

创建好的效果如下所示,这里我在两个新的标准交换机上创建了2个vmkernal

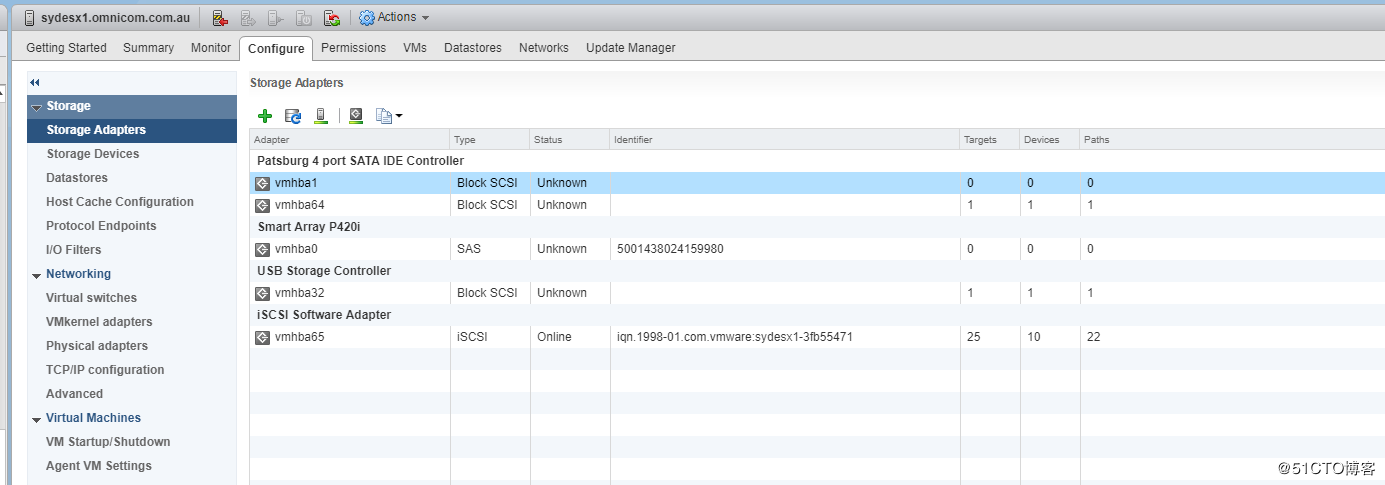

下一步是配置iSCSI software Adapter

如果没有现成的,需要新建有一个。如果之前已经有了其他的ISCSI连接的存储,可以继续用同一个ISCSI Software Adapter 配置新的连接

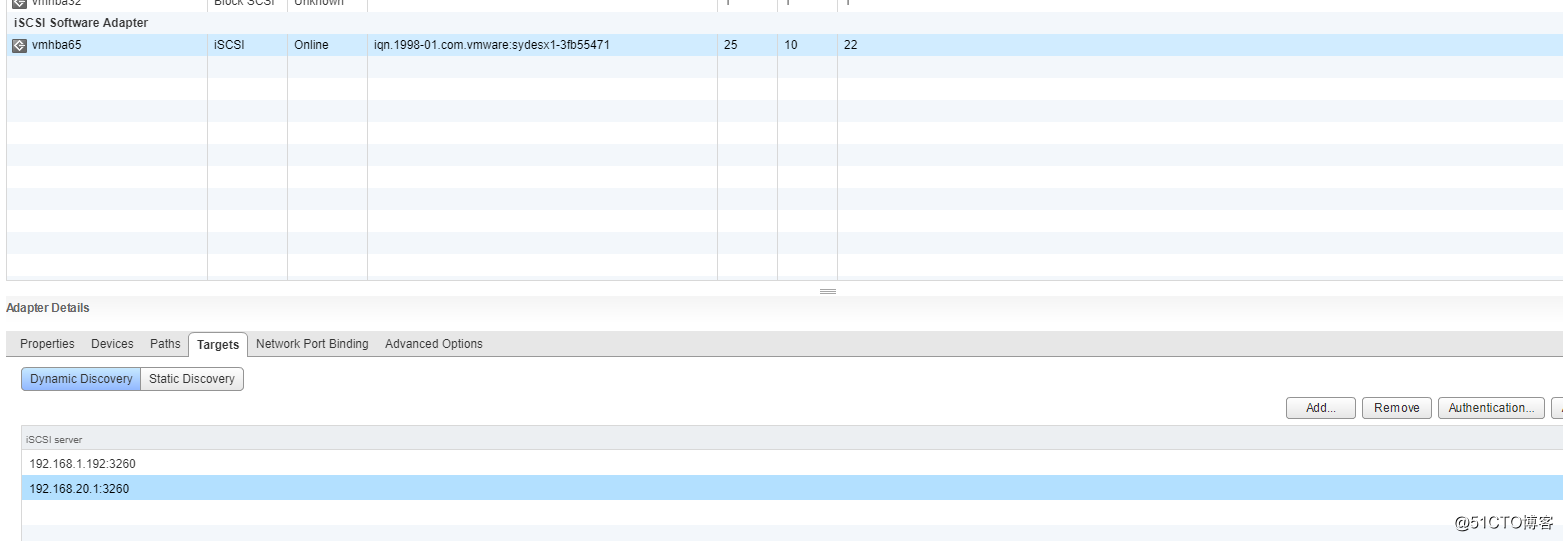

添加Target的IP,注意他默认会自动继承父类的authentication的设置,如果之前的ISCSI的存储设置了chap验证,这里会默认自动进行同样的配置,如果不需要,可以单独取消

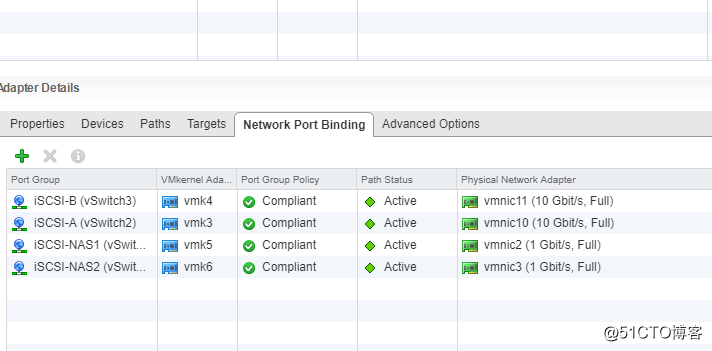

端口绑定里面把前面我们创建的2个vmkernal都加进去

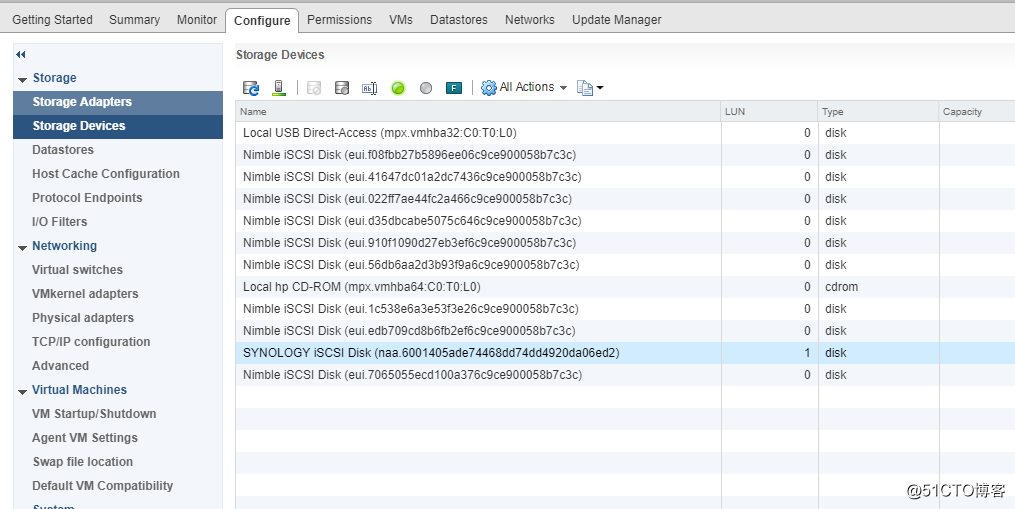

然后重新扫描一下Storage Adapter,应该就可以自动检测出target,device和path了。

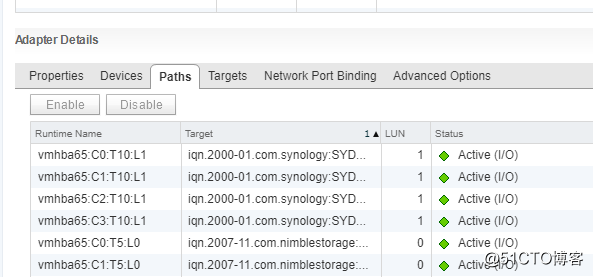

可以看见 我这里成功检测出了多条路径

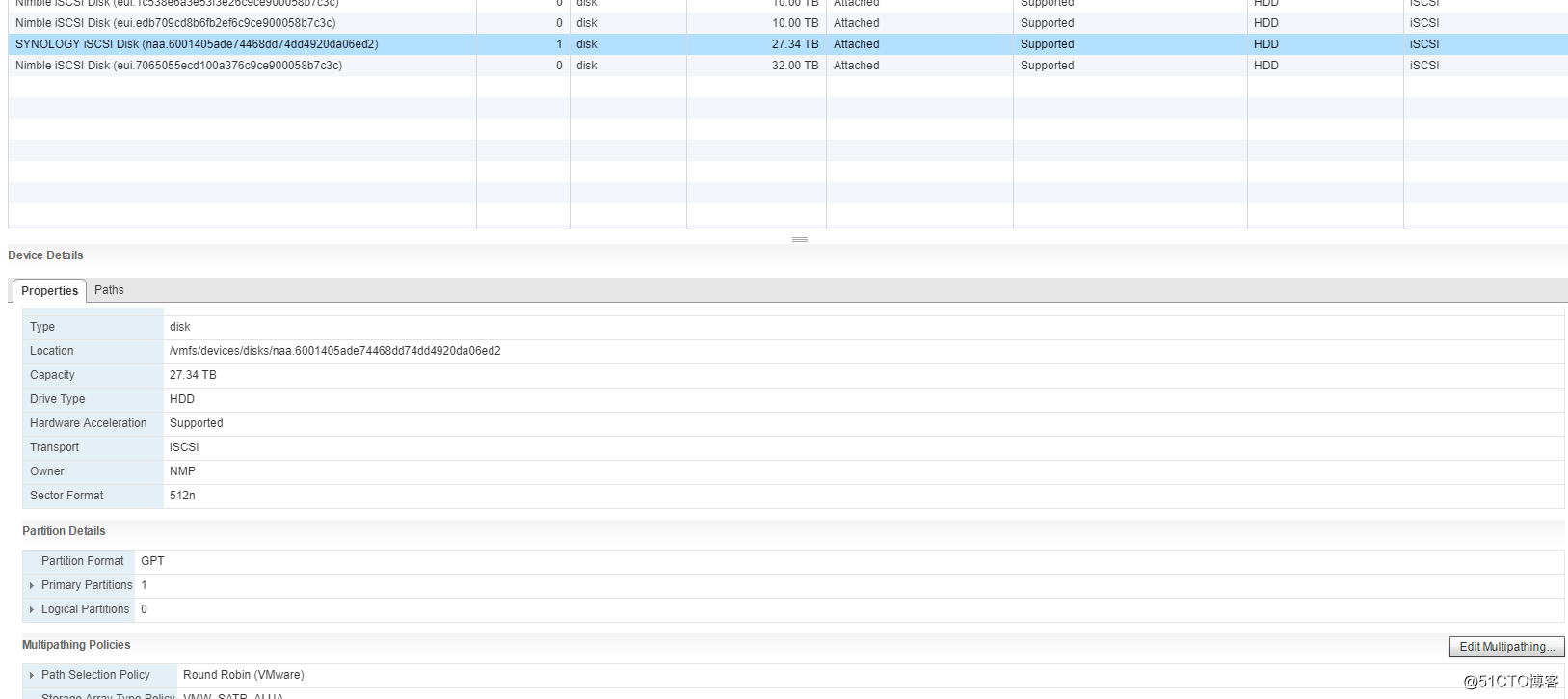

最后,还需要设置一下多路径psp的规则

这里简单的提一下,vmware 的psa架构是专门用于存储的多路径配置的。psa的基本作用是发现物理路径,并给物理路径分配对应的failover和load balance的规则。psa里面系统自带的插件叫nmp,第三方的叫mmp。nmp又有spat和psp组成。spat主要是用于多路径的fail over,而psp则负责load balance。有的厂商,例如Nimble会提供自己的插件,安装对应的vib之后就可以使用nimble自己的psp规则,但是synology并没有提供iscsci的插件,因此我们可以使用vmware自带的psp。

选择存储设备 最底下有个按钮 edit multipath

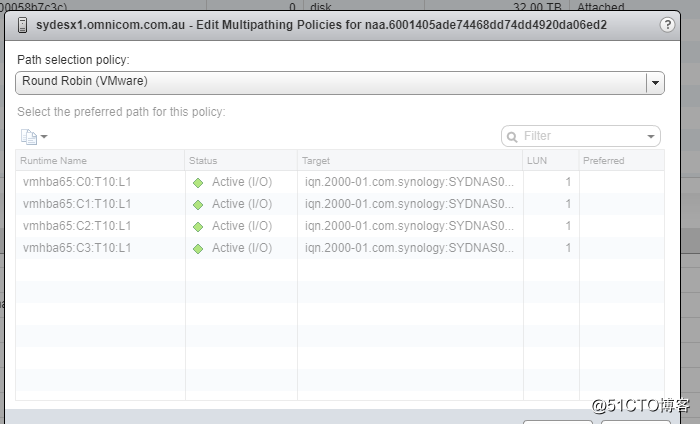

修改psp为 round robin (轮询)

最后测试一下是否工作

在NAS的LUN上新建一个datastore,Storage vomtion 迁移一个虚拟机进去,测试一切正常

esxtop 看看 vmnic2 和 vmnic3 都有流量经过

成功。

PS:NIC teaming和multipath 有啥区别。

Nic teaming是在网络层上设置的,一般是在生产网络或者nfs上面使用。典型的设置是一个标准的虚拟机上面绑定了很多端口组(VLAN),然后出口绑定多个物理网卡。与之连接的物理交换机上也需要配置对应的聚合链路。但是注意标准的虚拟交换机是不支持LACP的。

multipath(MPIO) 则是在软件层面上,由VMWARE的PSA框架来管理负载均衡和失败转移的。典型的设置是多个Vmkernal的虚拟交换机,每个虚拟交换机上都绑定一个唯一的物理端口。物理交换机上设置普通的access/untag端口即可。