网络通信 --> IO多路复用之select、poll、epoll详解

IO多路复用之select、poll、epoll详解

select,pselect,poll,epoll,I/O多路复用就是通过一种机制,一个进程可以监视多个描述符,一旦某个描述符就绪(一般是读就绪或者写就绪),能够通知程序进行相应的读写操作。但select,pselect,poll,epoll本质上都是同步I/O,因为他们都需要在读写事件就绪后自己负责进行读写,也就是说这个读写过程是阻塞的,而异步I/O则无需自己负责进行读写,异步I/O的实现会负责把数据从内核拷贝到用户空间。I/O多路复用技术的最大优势是系统开销小,系统不必创建进程/线程,也不必维护这些进程/线程,从而大大减小了系统的开销。一、使用场景

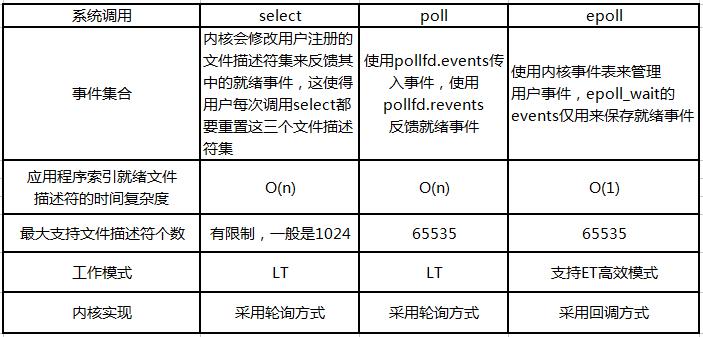

二、select、poll、epoll简介

其中epoll是Linux所特有,而select则应该是POSIX所规定,一般操作系统均有实现。1、select

其良好跨平台支持也是它的一个优点。select的一个缺点在于单个进程能够监视的文件描述符的数量存在最大限制,在Linux上一般为1024,可以通过修改宏定义甚至重新编译内核的方式提升这一限制,但是这样也会造成效率的降低。select本质上是通过设置或者检查存放fd标志位的数据结构来进行下一步处理。这样所带来的缺点是:具体数目可以cat /proc/sys/fs/file-max察看。32位机默认是1024个。64位机默认是2048.如果能给套接字注册某个回调函数,当他们活跃时,自动完成相关操作,那就避免了轮询,这正是epoll与kqueue做的。3、需要维护一个用来存放大量fd的数据结构,这样会使得用户空间和内核空间在传递该结构时复制开销大。2、poll

poll本质上和select没有区别,它将用户传入的数组拷贝到内核空间,然后查询每个fd对应的设备状态,如果设备就绪则在设备等待队列中加入一项并继续遍历,如果遍历完所有fd后没有发现就绪设备,则挂起当前进程,直到设备就绪或者主动超时,被唤醒后它又要再次遍历fd。这个过程经历了多次无谓的遍历。原因是它是基于链表来存储的,但是同样有一个缺点:1)大量的fd的数组被整体复制于用户态和内核地址空间之间,而不管这样的复制是不是有意义。2)poll还有一个特点是“水平触发”,如果报告了fd后,没有被处理,那么下次poll时会再次报告该fd。通过遍历文件描述符来获取已经就绪的socket。事实上,同时连接的大量客户端在一时刻可能只有很少的处于就绪状态,因此随着监视的描述符数量的增长,其效率也会线性下降。3、epoll

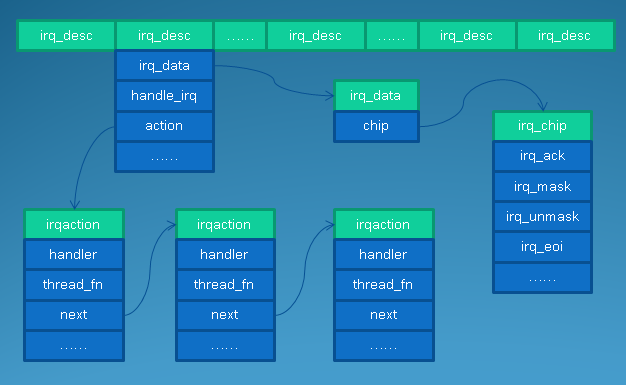

epoll使用一个文件描述符管理多个描述符,将用户关系的文件描述符的事件存放到内核的一个事件表中,这样在用户空间和内核空间的copy只需一次。epoll支持水平触发和边缘触发,最大的特点在于边缘触发,它只告诉进程哪些fd刚刚变为就绪态,并且只会通知一次。还有一个特点是,epoll使用“事件”的就绪通知方式,通过epoll_ctl注册fd,一旦该fd就绪,内核就会采用类似callback的回调机制来激活该fd,epoll_wait便可以收到通知。1、没有最大并发连接的限制,能打开的FD的上限远大于1024(1G的内存上能监听约10万个端口)。2、效率提升,不是轮询的方式,不会随着FD数目的增加效率下降。即Epoll最大的优点就在于它只管你“活跃”的连接,而跟连接总数无关,因此在实际的网络环境中,Epoll的效率就会远远高于select和poll。3、内存拷贝,利用mmap()文件映射内存加速与内核空间的消息传递;即epoll使用mmap减少复制开销。LT(level trigger)和ET(edge trigger)。LT模式是默认模式,LT模式与ET模式的区别如下:应用程序可以不立即处理该事件。下次调用epoll_wait时,会再次响应应用程序并通知此事件。应用程序必须立即处理该事件。如果不处理,下次调用epoll_wait时,不会再次响应应用程序并通知此事件。 LT(level triggered)是缺省的工作方式,并且同时支持block和no-block socket。在这种做法中,内核告诉你一个文件描述符是否就绪了,然后你可以对这个就绪的fd进行IO操作。如果你不作任何操作,内核还是会继续通知你的。 ET(edge-triggered)是高速工作方式,只支持no-block socket。在这种模式下,当描述符从未就绪变为就绪时,内核通过epoll告诉你。然后它会假设你知道文件描述符已经就绪,并且不会再为那个文件描述符发送更多的就绪通知,直到你做了某些操作导致那个文件描述符不再为就绪状态了(比如,你在发送,接收或者接收请求,或者发送接收的数据少于一定量时导致了一个EWOULDBLOCK 错误)。但是请注意,如果一直不对这个fd作IO操作(从而导致它再次变成未就绪),内核不会发送更多的通知(only once)。 ET模式在很大程度上减少了epoll事件被重复触发的次数,因此效率要比LT模式高。epoll工作在ET模式的时候,必须使用非阻塞套接口,以避免由于一个文件句柄的阻塞读/阻塞写操作把处理多个文件描述符的任务饿死。进程只有在调用一定的方法后,内核才对所有监视的文件描述符进行扫描,而epoll事先通过epoll_ctl()来注册一个文件描述符,一旦基于某个文件描述符就绪时,内核会采用类似callback的回调机制,迅速激活这个文件描述符,当进程调用epoll_wait()时便得到通知。(此处去掉了遍历文件描述符,而是通过监听回调的的机制。这正是epoll的魅力所在。)三、select、poll、epoll区别

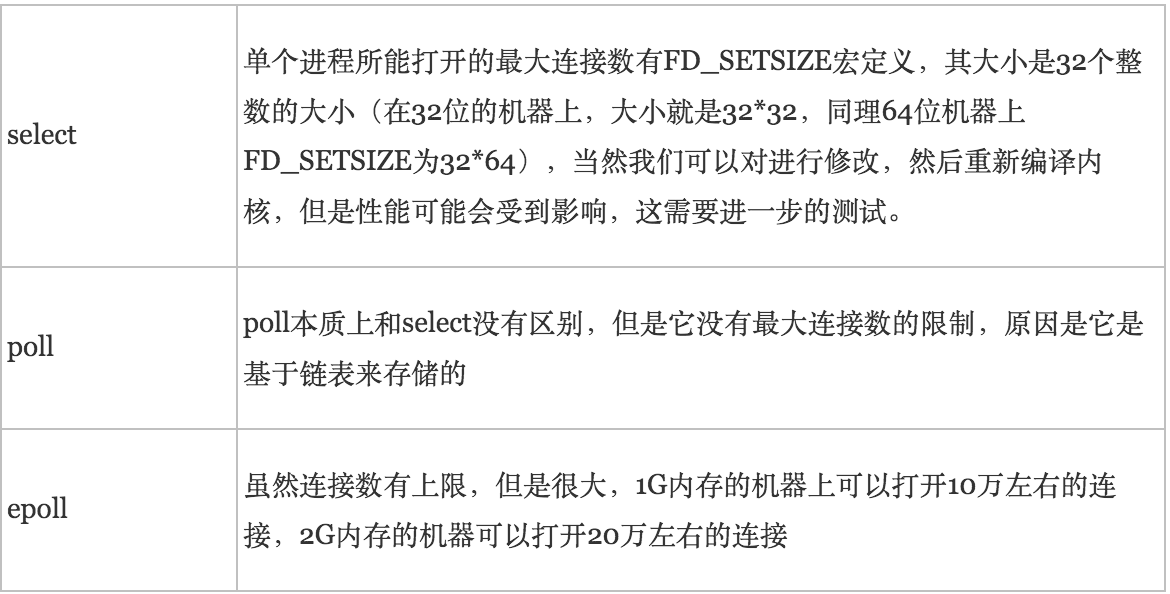

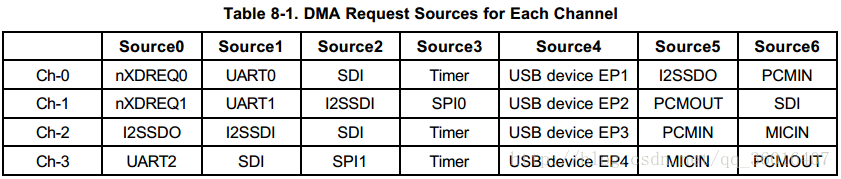

1、支持一个进程所能打开的最大连接数

2、FD剧增后带来的IO效率问题

3、消息传递方式

但是在连接数少并且连接都十分活跃的情况下,select和poll的性能可能比epoll好,毕竟epoll的通知机制需要很多函数回调。2、select低效是因为每次它都需要轮询。但低效也是相对的,视情况而定,也可通过良好的设计改善。详述socket编程之select()和poll()函数

select()函数和poll()函数均是主要用来处理多路I/O复用的情况。比如一个服务器既想等待输入终端到来,又想等待若干个套接字有客户请求到达,这时候就需要借助select或者poll函数了。

(一)select()函数

原型如下:

各个参数含义如下:

- int fdsp1:最大描述符值 + 1

- fd_set *readfds:对可读感兴趣的描述符集

- fd_set *writefds:对可写感兴趣的描述符集

- fd_set *errorfds:对出错感兴趣的描述符集

- struct timeval *timeout:超时时间(注意:对于linux系统,此参数没有const限制,每次select调用完毕timeout的值都被修改为剩余时间,而unix系统则不会改变timeout值)

select函数会在发生以下情况时返回:

- readfds集合中有描述符可读

- writefds集合中有描述符可写

- errorfds集合中有描述符遇到错误条件

- 指定的超时时间timeout到了

当select返回时,描述符集合将被修改以指示哪些个描述符正处于可读、可写或有错误状态。可以用FD_ISSET宏对描述符进行测试以找到状态变化的描述符。如果select因为超时而返回的话,所有的描述符集合都将被清空。

select函数返回状态发生变化的描述符总数。返回0意味着超时。失败则返回-1并设置errno。可能出现的错误有:EBADF(无效描述符)、EINTR(因终端而返回)、EINVAL(nfds或timeout取值错误)。

设置描述符集合通常用如下几个宏定义:

2 FD_SET(int fd, fd_set *fdset); /* turn on the bit for fd in fd_set */

3 FD_CLR(int fd, fd_set *fdset); /* turn off the bit for fd in fd_set */

4 int FD_ISSET(int fd, fd_set *fdset); /* is the bit for fd on in fdset? */

如:

2 FD_ZERO(&rset); /* initialize the set: all bits off */

3 FD_SET(1, &rset); /* turn on bit for fd 1 */

4 FD_SET(4, &rset); /* turn on bit for fd 4 */

5 FD_SET(5, &rset); /* turn on bit for fd 5 */

当select返回的时候,rset位都将被置0,除了那些有变化的fd位。

当发生如下情况时认为是可读的:

- socket的receive buffer中的字节数大于socket的receive buffer的low-water mark属性值。(low-water mark值类似于分水岭,当receive buffer中的字节数小于low-water mark值的时候,认为socket还不可读,只有当receive buffer中的字节数达到一定量的时候才认为socket可读)

- 连接半关闭(读关闭,即收到对端发来的FIN包)

- 发生变化的描述符是被动套接字,而连接的三路握手完成的数量大于0,即有新的TCP连接建立

- 描述符发生错误,如果调用read系统调用读套接字的话会返回-1。

当发生如下情况时认为是可写的:

- socket的send buffer中的字节数大于socket的send buffer的low-water mark属性值以及socket已经连接或者不需要连接(如UDP)。

- 写半连接关闭,调用write函数将产生SIGPIPE

- 描述符发生错误,如果调用write系统调用写套接字的话会返回-1。

注意:

select默认能处理的描述符数量是有上限的,为FD_SETSIZE的大小。

对于timeout参数,如果置为NULL,则表示wait forever;若timeout->tv_sec = timeout->tv_usec = 0,则表示do not wait at all;否则指定等待时间。

如果使用select处理多个套接字,那么需要使用一个数组(也可以是其他结构)来记录各个描述符的状态。而使用poll则不需要,下面看poll函数。

(二)poll()函数

原型如下:

各参数含义如下:

- struct pollfd *fdarray:一个结构体,用来保存各个描述符的相关状态。

- unsigned long nfds:fdarray数组的大小,即里面包含有效成员的数量。

- int timeout:设定的超时时间。(以毫秒为单位)

poll函数返回值及含义如下:

- -1:有错误产生

- 0:超时时间到,而且没有描述符有状态变化

- >0:有状态变化的描述符个数

着重讲fdarray数组,因为这是它和select()函数主要的不同的地方:

pollfd的结构如下:

2 int fd; /* descriptor to check */

3 short events; /* events of interest on fd */

4 short revents; /* events that occured on fd */

5 };

其实poll()和select()函数要处理的问题是相同的,只不过是不同组织在几乎相同时刻同时推出的,因此才同时保留了下来。select()函数把可读描述符、可写描述符、错误描述符分在了三个集合里,这三个集合都是用bit位来标记一个描述符,一旦有若干个描述符状态发生变化,那么它将被置位,而其他没有发生变化的描述符的bit位将被clear,也就是说select()的readset、writeset、errorset是一个value-result类型,通过它们传值,而也通过它们返回结果。这样的一个坏处是每次重新select

的时候对集合必须重新赋值。而poll()函数则与select()采用的方式不同,它通过一个结构数组保存各个描述符的状态,每个结构体第一项fd代表描述符,第二项代表要监听的事件,也就是感兴趣的事件,而第三项代表poll()返回时描述符的返回状态。合法状态如下:

- POLLIN: 有普通数据或者优先数据可读

- POLLRDNORM: 有普通数据可读

- POLLRDBAND: 有优先数据可读

- POLLPRI: 有紧急数据可读

- POLLOUT: 有普通数据可写

- POLLWRNORM: 有普通数据可写

- POLLWRBAND: 有紧急数据可写

- POLLERR: 有错误发生

- POLLHUP: 有描述符挂起事件发生

- POLLNVAL: 描述符非法

对于POLLIN | POLLPRI等价与select()的可读事件;POLLOUT |

POLLWRBAND等价与select()的可写事件;POLLIN 等价与POLLRDNORM |

POLLRDBAND,而POLLOUT等价于POLLWRBAND。如果你对一个描述符的可读事件和可写事件以及错误等事件均感兴趣那么你应该都进行相应的设置。

对于timeout的设置如下:

- INFTIM: wait forever

- 0: return immediately, do not block

- >0: wait specified number of milliseconds

Linux IO模式及 select、poll、epoll详解

同步IO和异步IO,阻塞IO和非阻塞IO分别是什么,到底有什么区别?不同的人在不同的上下文下给出的答案是不同的。所以先限定一下本文的上下文。

本文讨论的背景是Linux环境下的network IO。

一 概念说明

在进行解释之前,首先要说明几个概念:

- 用户空间和内核空间

- 进程切换

- 进程的阻塞

- 文件描述符

- 缓存 I/O

用户空间与内核空间

现在操作系统都是采用虚拟存储器,那么对32位操作系统而言,它的寻址空间(虚拟存储空间)为4G(2的32次方)。操作系统的核心是内核,独立于普通的应用程序,可以访问受保护的内存空间,也有访问底层硬件设备的所有权限。为了保证用户进程不能直接操作内核(kernel),保证内核的安全,操心系统将虚拟空间划分为两部分,一部分为内核空间,一部分为用户空间。针对linux操作系统而言,将最高的1G字节(从虚拟地址0xC0000000到0xFFFFFFFF),供内核使用,称为内核空间,而将较低的3G字节(从虚拟地址0x00000000到0xBFFFFFFF),供各个进程使用,称为用户空间。

进程切换

为了控制进程的执行,内核必须有能力挂起正在CPU上运行的进程,并恢复以前挂起的某个进程的执行。这种行为被称为进程切换。因此可以说,任何进程都是在操作系统内核的支持下运行的,是与内核紧密相关的。

从一个进程的运行转到另一个进程上运行,这个过程中经过下面这些变化:

1. 保存处理机上下文,包括程序计数器和其他寄存器。

2. 更新PCB信息。

3. 把进程的PCB移入相应的队列,如就绪、在某事件阻塞等队列。

4. 选择另一个进程执行,并更新其PCB。

5. 更新内存管理的数据结构。

6. 恢复处理机上下文。

注:总而言之就是很耗资源,具体的可以参考这篇文章:进程切换

进程的阻塞

正在执行的进程,由于期待的某些事件未发生,如请求系统资源失败、等待某种操作的完成、新数据尚未到达或无新工作做等,则由系统自动执行阻塞原语(Block),使自己由运行状态变为阻塞状态。可见,进程的阻塞是进程自身的一种主动行为,也因此只有处于运行态的进程(获得CPU),才可能将其转为阻塞状态。当进程进入阻塞状态,是不占用CPU资源的。

文件描述符fd

文件描述符(File descriptor)是计算机科学中的一个术语,是一个用于表述指向文件的引用的抽象化概念。

文件描述符在形式上是一个非负整数。实际上,它是一个索引值,指向内核为每一个进程所维护的该进程打开文件的记录表。当程序打开一个现有文件或者创建一个新文件时,内核向进程返回一个文件描述符。在程序设计中,一些涉及底层的程序编写往往会围绕着文件描述符展开。但是文件描述符这一概念往往只适用于UNIX、Linux这样的操作系统。

缓存 I/O

缓存 I/O 又被称作标准 I/O,大多数文件系统的默认 I/O 操作都是缓存 I/O。在 Linux 的缓存 I/O 机制中,操作系统会将 I/O 的数据缓存在文件系统的页缓存( page cache )中,也就是说,数据会先被拷贝到操作系统内核的缓冲区中,然后才会从操作系统内核的缓冲区拷贝到应用程序的地址空间。

缓存 I/O 的缺点:

数据在传输过程中需要在应用程序地址空间和内核进行多次数据拷贝操作,这些数据拷贝操作所带来的 CPU 以及内存开销是非常大的。

二 IO模式

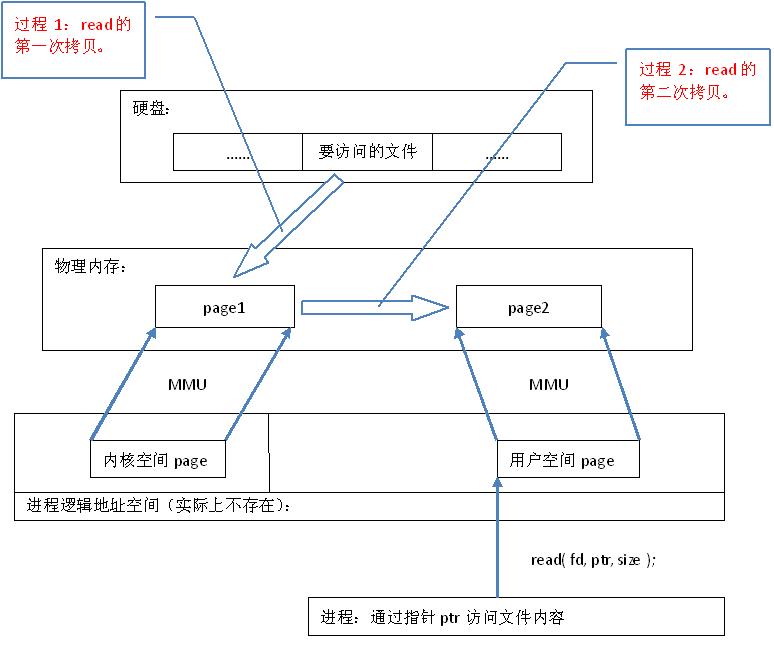

刚才说了,对于一次IO访问(以read举例),数据会先被拷贝到操作系统内核的缓冲区中,然后才会从操作系统内核的缓冲区拷贝到应用程序的地址空间。所以说,当一个read操作发生时,它会经历两个阶段:

1. 等待数据准备 (Waiting for the data to be ready)

2. 将数据从内核拷贝到进程中 (Copying the data from the kernel to the process)

正式因为这两个阶段,linux系统产生了下面五种网络模式的方案。

- 阻塞 I/O(blocking IO)

- 非阻塞 I/O(nonblocking IO)

- I/O 多路复用( IO multiplexing)

- 信号驱动 I/O( signal driven IO)

- 异步 I/O(asynchronous IO)

注:由于signal driven IO在实际中并不常用,所以我这只提及剩下的四种IO Model。

阻塞 I/O(blocking IO)

在linux中,默认情况下所有的socket都是blocking,一个典型的读操作流程大概是这样:

当用户进程调用了recvfrom这个系统调用,kernel就开始了IO的第一个阶段:准备数据(对于网络IO来说,很多时候数据在一开始还没有到达。比如,还没有收到一个完整的UDP包。这个时候kernel就要等待足够的数据到来)。这个过程需要等待,也就是说数据被拷贝到操作系统内核的缓冲区中是需要一个过程的。而在用户进程这边,整个进程会被阻塞(当然,是进程自己选择的阻塞)。当kernel一直等到数据准备好了,它就会将数据从kernel中拷贝到用户内存,然后kernel返回结果,用户进程才解除block的状态,重新运行起来。

所以,blocking IO的特点就是在IO执行的两个阶段都被block了。

非阻塞 I/O(nonblocking IO)

linux下,可以通过设置socket使其变为non-blocking。当对一个non-blocking socket执行读操作时,流程是这个样子:

当用户进程发出read操作时,如果kernel中的数据还没有准备好,那么它并不会block用户进程,而是立刻返回一个error。从用户进程角度讲 ,它发起一个read操作后,并不需要等待,而是马上就得到了一个结果。用户进程判断结果是一个error时,它就知道数据还没有准备好,于是它可以再次发送read操作。一旦kernel中的数据准备好了,并且又再次收到了用户进程的system call,那么它马上就将数据拷贝到了用户内存,然后返回。

所以,nonblocking IO的特点是用户进程需要不断的主动询问kernel数据好了没有。

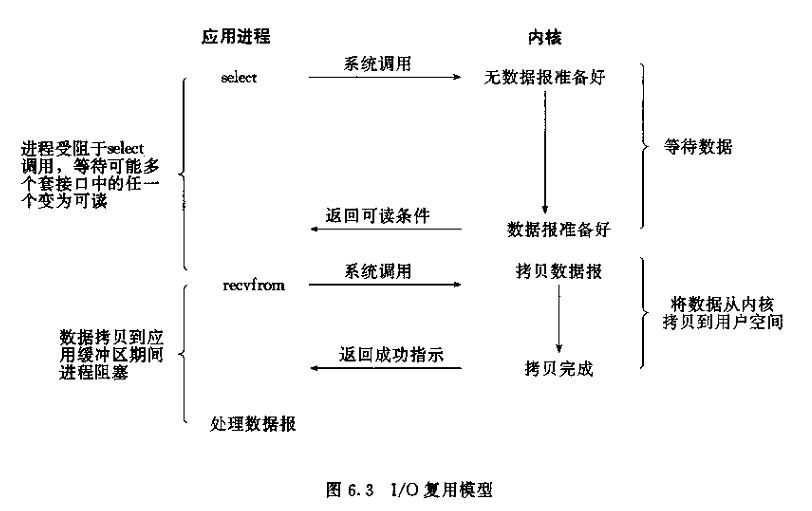

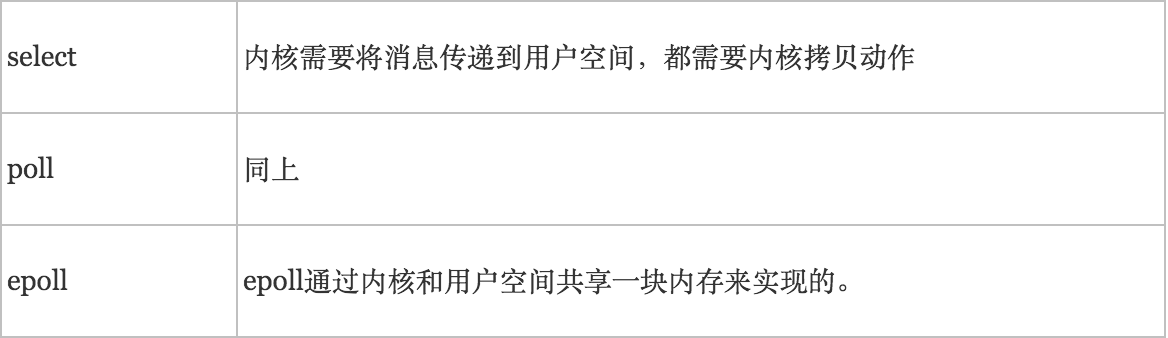

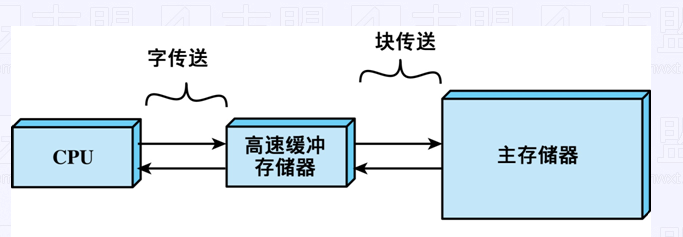

I/O 多路复用( IO multiplexing)

IO multiplexing就是我们说的select,poll,epoll,有些地方也称这种IO方式为event driven IO。select/epoll的好处就在于单个process就可以同时处理多个网络连接的IO。它的基本原理就是select,poll,epoll这个function会不断的轮询所负责的所有socket,当某个socket有数据到达了,就通知用户进程。

当用户进程调用了select,那么整个进程会被block,而同时,kernel会“监视”所有select负责的socket,当任何一个socket中的数据准备好了,select就会返回。这个时候用户进程再调用read操作,将数据从kernel拷贝到用户进程。

所以,I/O 多路复用的特点是通过一种机制一个进程能同时等待多个文件描述符,而这些文件描述符(套接字描述符)其中的任意一个进入读就绪状态,select()函数就可以返回。

这个图和blocking IO的图其实并没有太大的不同,事实上,还更差一些。因为这里需要使用两个system call (select 和 recvfrom),而blocking IO只调用了一个system call (recvfrom)。但是,用select的优势在于它可以同时处理多个connection。

所以,如果处理的连接数不是很高的话,使用select/epoll的web server不一定比使用multi-threading + blocking IO的web server性能更好,可能延迟还更大。select/epoll的优势并不是对于单个连接能处理得更快,而是在于能处理更多的连接。)

在IO multiplexing Model中,实际中,对于每一个socket,一般都设置成为non-blocking,但是,如上图所示,整个用户的process其实是一直被block的。只不过process是被select这个函数block,而不是被socket IO给block。

异步 I/O(asynchronous IO)

inux下的asynchronous IO其实用得很少。先看一下它的流程:

用户进程发起read操作之后,立刻就可以开始去做其它的事。而另一方面,从kernel的角度,当它受到一个asynchronous read之后,首先它会立刻返回,所以不会对用户进程产生任何block。然后,kernel会等待数据准备完成,然后将数据拷贝到用户内存,当这一切都完成之后,kernel会给用户进程发送一个signal,告诉它read操作完成了。

总结

blocking和non-blocking的区别

调用blocking IO会一直block住对应的进程直到操作完成,而non-blocking IO在kernel还准备数据的情况下会立刻返回。

synchronous IO和asynchronous IO的区别

在说明synchronous IO和asynchronous IO的区别之前,需要先给出两者的定义。POSIX的定义是这样子的:

- A synchronous I/O operation causes the requesting process to be blocked until that I/O operation completes;

- An asynchronous I/O operation does not cause the requesting process to be blocked;

两者的区别就在于synchronous IO做”IO operation”的时候会将process阻塞。按照这个定义,之前所述的blocking IO,non-blocking IO,IO multiplexing都属于synchronous IO。

有人会说,non-blocking IO并没有被block啊。这里有个非常“狡猾”的地方,定义中所指的”IO operation”是指真实的IO操作,就是例子中的recvfrom这个system call。non-blocking IO在执行recvfrom这个system call的时候,如果kernel的数据没有准备好,这时候不会block进程。但是,当kernel中数据准备好的时候,recvfrom会将数据从kernel拷贝到用户内存中,这个时候进程是被block了,在这段时间内,进程是被block的。

而asynchronous IO则不一样,当进程发起IO 操作之后,就直接返回再也不理睬了,直到kernel发送一个信号,告诉进程说IO完成。在这整个过程中,进程完全没有被block。

各个IO Model的比较如图所示:

通过上面的图片,可以发现non-blocking IO和asynchronous IO的区别还是很明显的。在non-blocking IO中,虽然进程大部分时间都不会被block,但是它仍然要求进程去主动的check,并且当数据准备完成以后,也需要进程主动的再次调用recvfrom来将数据拷贝到用户内存。而asynchronous IO则完全不同。它就像是用户进程将整个IO操作交给了他人(kernel)完成,然后他人做完后发信号通知。在此期间,用户进程不需要去检查IO操作的状态,也不需要主动的去拷贝数据。

三 I/O 多路复用之select、poll、epoll详解

select,poll,epoll都是IO多路复用的机制。I/O多路复用就是通过一种机制,一个进程可以监视多个描述符,一旦某个描述符就绪(一般是读就绪或者写就绪),能够通知程序进行相应的读写操作。但select,poll,epoll本质上都是同步I/O,因为他们都需要在读写事件就绪后自己负责进行读写,也就是说这个读写过程是阻塞的,而异步I/O则无需自己负责进行读写,异步I/O的实现会负责把数据从内核拷贝到用户空间。(这里啰嗦下)

select

int select (int n, fd_set *readfds, fd_set *writefds, fd_set *exceptfds, struct timeval *timeout);

select 函数监视的文件描述符分3类,分别是writefds、readfds、和exceptfds。调用后select函数会阻塞,直到有描述副就绪(有数据 可读、可写、或者有except),或者超时(timeout指定等待时间,如果立即返回设为null即可),函数返回。当select函数返回后,可以 通过遍历fdset,来找到就绪的描述符。

select目前几乎在所有的平台上支持,其良好跨平台支持也是它的一个优点。select的一 个缺点在于单个进程能够监视的文件描述符的数量存在最大限制,在Linux上一般为1024,可以通过修改宏定义甚至重新编译内核的方式提升这一限制,但 是这样也会造成效率的降低。

poll

int poll (struct pollfd *fds, unsigned int nfds, int timeout);

不同与select使用三个位图来表示三个fdset的方式,poll使用一个 pollfd的指针实现。

struct pollfd {

int fd; /* file descriptor */

short events; /* requested events to watch */

short revents; /* returned events witnessed */

};

pollfd结构包含了要监视的event和发生的event,不再使用select“参数-值”传递的方式。同时,pollfd并没有最大数量限制(但是数量过大后性能也是会下降)。 和select函数一样,poll返回后,需要轮询pollfd来获取就绪的描述符。

从上面看,select和poll都需要在返回后,

通过遍历文件描述符来获取已经就绪的socket。事实上,同时连接的大量客户端在一时刻可能只有很少的处于就绪状态,因此随着监视的描述符数量的增长,其效率也会线性下降。

epoll

epoll是在2.6内核中提出的,是之前的select和poll的增强版本。相对于select和poll来说,epoll更加灵活,没有描述符限制。epoll使用一个文件描述符管理多个描述符,将用户关系的文件描述符的事件存放到内核的一个事件表中,这样在用户空间和内核空间的copy只需一次。

一 epoll操作过程

epoll操作过程需要三个接口,分别如下:

int epoll_create(int size);//创建一个epoll的句柄,size用来告诉内核这个监听的数目一共有多大

int epoll_ctl(int epfd, int op, int fd, struct epoll_event *event);

int epoll_wait(int epfd, struct epoll_event * events, int maxevents, int timeout);

1. int epoll_create(int size);

创建一个epoll的句柄,size用来告诉内核这个监听的数目一共有多大,这个参数不同于select()中的第一个参数,给出最大监听的fd+1的值,参数size并不是限制了epoll所能监听的描述符最大个数,只是对内核初始分配内部数据结构的一个建议。

当创建好epoll句柄后,它就会占用一个fd值,在linux下如果查看/proc/进程id/fd/,是能够看到这个fd的,所以在使用完epoll后,必须调用close()关闭,否则可能导致fd被耗尽。

2. int epoll_ctl(int epfd, int op, int fd, struct epoll_event *event);

函数是对指定描述符fd执行op操作。

- epfd:是epoll_create()的返回值。

- op:表示op操作,用三个宏来表示:添加EPOLL_CTL_ADD,删除EPOLL_CTL_DEL,修改EPOLL_CTL_MOD。分别添加、删除和修改对fd的监听事件。

- fd:是需要监听的fd(文件描述符)

- epoll_event:是告诉内核需要监听什么事,struct epoll_event结构如下:

struct epoll_event {

__uint32_t events; /* Epoll events */

epoll_data_t data; /* User data variable */

};

//events可以是以下几个宏的集合:

EPOLLIN :表示对应的文件描述符可以读(包括对端SOCKET正常关闭);

EPOLLOUT:表示对应的文件描述符可以写;

EPOLLPRI:表示对应的文件描述符有紧急的数据可读(这里应该表示有带外数据到来);

EPOLLERR:表示对应的文件描述符发生错误;

EPOLLHUP:表示对应的文件描述符被挂断;

EPOLLET: 将EPOLL设为边缘触发(Edge Triggered)模式,这是相对于水平触发(Level Triggered)来说的。

EPOLLONESHOT:只监听一次事件,当监听完这次事件之后,如果还需要继续监听这个socket的话,需要再次把这个socket加入到EPOLL队列里

3. int epoll_wait(int epfd, struct epoll_event * events, int maxevents, int timeout);

等待epfd上的io事件,最多返回maxevents个事件。

参数events用来从内核得到事件的集合,maxevents告之内核这个events有多大,这个maxevents的值不能大于创建epoll_create()时的size,参数timeout是超时时间(毫秒,0会立即返回,-1将不确定,也有说法说是永久阻塞)。该函数返回需要处理的事件数目,如返回0表示已超时。

二 工作模式

epoll对文件描述符的操作有两种模式:LT(level trigger)和ET(edge trigger)。LT模式是默认模式,LT模式与ET模式的区别如下:

LT模式:当epoll_wait检测到描述符事件发生并将此事件通知应用程序,应用程序可以不立即处理该事件。下次调用epoll_wait时,会再次响应应用程序并通知此事件。

ET模式:当epoll_wait检测到描述符事件发生并将此事件通知应用程序,应用程序必须立即处理该事件。如果不处理,下次调用epoll_wait时,不会再次响应应用程序并通知此事件。

1. LT模式

LT(level triggered)是缺省的工作方式,并且同时支持block和no-block socket.在这种做法中,内核告诉你一个文件描述符是否就绪了,然后你可以对这个就绪的fd进行IO操作。如果你不作任何操作,内核还是会继续通知你的。

2. ET模式

ET(edge-triggered)是高速工作方式,只支持no-block socket。在这种模式下,当描述符从未就绪变为就绪时,内核通过epoll告诉你。然后它会假设你知道文件描述符已经就绪,并且不会再为那个文件描述符发送更多的就绪通知,直到你做了某些操作导致那个文件描述符不再为就绪状态了(比如,你在发送,接收或者接收请求,或者发送接收的数据少于一定量时导致了一个EWOULDBLOCK 错误)。但是请注意,如果一直不对这个fd作IO操作(从而导致它再次变成未就绪),内核不会发送更多的通知(only once)

ET模式在很大程度上减少了epoll事件被重复触发的次数,因此效率要比LT模式高。epoll工作在ET模式的时候,必须使用非阻塞套接口,以避免由于一个文件句柄的阻塞读/阻塞写操作把处理多个文件描述符的任务饿死。

3. 总结

假如有这样一个例子:

1. 我们已经把一个用来从管道中读取数据的文件句柄(RFD)添加到epoll描述符

2. 这个时候从管道的另一端被写入了2KB的数据

3. 调用epoll_wait(2),并且它会返回RFD,说明它已经准备好读取操作

4. 然后我们读取了1KB的数据

5. 调用epoll_wait(2)......

LT模式:

如果是LT模式,那么在第5步调用epoll_wait(2)之后,仍然能受到通知。

ET模式:

如果我们在第1步将RFD添加到epoll描述符的时候使用了EPOLLET标志,那么在第5步调用epoll_wait(2)之后将有可能会挂起,因为剩余的数据还存在于文件的输入缓冲区内,而且数据发出端还在等待一个针对已经发出数据的反馈信息。只有在监视的文件句柄上发生了某个事件的时候

ET 工作模式才会汇报事件。因此在第5步的时候,调用者可能会放弃等待仍在存在于文件输入缓冲区内的剩余数据。

当使用epoll的ET模型来工作时,当产生了一个EPOLLIN事件后,

读数据的时候需要考虑的是当recv()返回的大小如果等于请求的大小,那么很有可能是缓冲区还有数据未读完,也意味着该次事件还没有处理完,所以还需要再次读取:

while(rs){

buflen = recv(activeevents[i].data.fd, buf, sizeof(buf), 0);

if(buflen < 0){

// 由于是非阻塞的模式,所以当errno为EAGAIN时,表示当前缓冲区已无数据可读

// 在这里就当作是该次事件已处理处.

if(errno == EAGAIN){

break;

}

else{

return;

}

}

else if(buflen == 0){

// 这里表示对端的socket已正常关闭.

}

if(buflen == sizeof(buf){

rs = 1; // 需要再次读取

}

else{

rs = 0;

}

}

Linux中的EAGAIN含义

Linux环境下开发经常会碰到很多错误(设置errno),其中EAGAIN是其中比较常见的一个错误(比如用在非阻塞操作中)。

从字面上来看,是提示再试一次。这个错误经常出现在当应用程序进行一些非阻塞(non-blocking)操作(对文件或socket)的时候。

例如,以 O_NONBLOCK的标志打开文件/socket/FIFO,如果你连续做read操作而没有数据可读。此时程序不会阻塞起来等待数据准备就绪返回,read函数会返回一个错误EAGAIN,提示你的应用程序现在没有数据可读请稍后再试。

又例如,当一个系统调用(比如fork)因为没有足够的资源(比如虚拟内存)而执行失败,返回EAGAIN提示其再调用一次(也许下次就能成功)。

三 代码演示

下面是一段不完整的代码且格式不对,意在表述上面的过程,去掉了一些模板代码。

#define IPADDRESS "127.0.0.1"

#define PORT 8787

#define MAXSIZE 1024

#define LISTENQ 5

#define FDSIZE 1000

#define EPOLLEVENTS 100

listenfd = socket_bind(IPADDRESS,PORT);

struct epoll_event events[EPOLLEVENTS];

//创建一个描述符

epollfd = epoll_create(FDSIZE);

//添加监听描述符事件

add_event(epollfd,listenfd,EPOLLIN);

//循环等待

for ( ; ; ){

//该函数返回已经准备好的描述符事件数目

ret = epoll_wait(epollfd,events,EPOLLEVENTS,-1);

//处理接收到的连接

handle_events(epollfd,events,ret,listenfd,buf);

}

//事件处理函数

static void handle_events(int epollfd,struct epoll_event *events,int num,int listenfd,char *buf)

{

int i;

int fd;

//进行遍历;这里只要遍历已经准备好的io事件。num并不是当初epoll_create时的FDSIZE。

for (i = 0;i < num;i++)

{

fd = events[i].data.fd;

//根据描述符的类型和事件类型进行处理

if ((fd == listenfd) &&(events[i].events & EPOLLIN))

handle_accpet(epollfd,listenfd);

else if (events[i].events & EPOLLIN)

do_read(epollfd,fd,buf);

else if (events[i].events & EPOLLOUT)

do_write(epollfd,fd,buf);

}

}

//添加事件

static void add_event(int epollfd,int fd,int state){

struct epoll_event ev;

ev.events = state;

ev.data.fd = fd;

epoll_ctl(epollfd,EPOLL_CTL_ADD,fd,&ev);

}

//处理接收到的连接

static void handle_accpet(int epollfd,int listenfd){

int clifd;

struct sockaddr_in cliaddr;

socklen_t cliaddrlen;

clifd = accept(listenfd,(struct sockaddr*)&cliaddr,&cliaddrlen);

if (clifd == -1)

perror("accpet error:");

else {

printf("accept a new client: %s:%d

",inet_ntoa(cliaddr.sin_addr),cliaddr.sin_port); //添加一个客户描述符和事件

add_event(epollfd,clifd,EPOLLIN);

}

}

//读处理

static void do_read(int epollfd,int fd,char *buf){

int nread;

nread = read(fd,buf,MAXSIZE);

if (nread == -1) {

perror("read error:");

close(fd); //记住close fd

delete_event(epollfd,fd,EPOLLIN); //删除监听

}

else if (nread == 0) {

fprintf(stderr,"client close.

");

close(fd); //记住close fd

delete_event(epollfd,fd,EPOLLIN); //删除监听

}

else {

printf("read message is : %s",buf);

//修改描述符对应的事件,由读改为写

modify_event(epollfd,fd,EPOLLOUT);

}

}

//写处理

static void do_write(int epollfd,int fd,char *buf) {

int nwrite;

nwrite = write(fd,buf,strlen(buf));

if (nwrite == -1){

perror("write error:");

close(fd); //记住close fd

delete_event(epollfd,fd,EPOLLOUT); //删除监听

}else{

modify_event(epollfd,fd,EPOLLIN);

}

memset(buf,0,MAXSIZE);

}

//删除事件

static void delete_event(int epollfd,int fd,int state) {

struct epoll_event ev;

ev.events = state;

ev.data.fd = fd;

epoll_ctl(epollfd,EPOLL_CTL_DEL,fd,&ev);

}

//修改事件

static void modify_event(int epollfd,int fd,int state){

struct epoll_event ev;

ev.events = state;

ev.data.fd = fd;

epoll_ctl(epollfd,EPOLL_CTL_MOD,fd,&ev);

}

//注:另外一端我就省了

四 epoll总结

在 select/poll中,进程只有在调用一定的方法后,内核才对所有监视的文件描述符进行扫描,而epoll事先通过epoll_ctl()来注册一 个文件描述符,一旦基于某个文件描述符就绪时,内核会采用类似callback的回调机制,迅速激活这个文件描述符,当进程调用epoll_wait() 时便得到通知。(此处去掉了遍历文件描述符,而是通过监听回调的的机制。这正是epoll的魅力所在。)

epoll的优点主要是一下几个方面:

1.

监视的描述符数量不受限制,它所支持的FD上限是最大可以打开文件的数目,这个数字一般远大于2048,举个例子,在1GB内存的机器上大约是10万左

右,具体数目可以cat

/proc/sys/fs/file-max察看,一般来说这个数目和系统内存关系很大。select的最大缺点就是进程打开的fd是有数量限制的。这对

于连接数量比较大的服务器来说根本不能满足。虽然也可以选择多进程的解决方案(

Apache就是这样实现的),不过虽然linux上面创建进程的代价比较小,但仍旧是不可忽视的,加上进程间数据同步远比不上线程间同步的高效,所以也不是一种完美的方案。

- IO的效率不会随着监视fd的数量的增长而下降。epoll不同于select和poll轮询的方式,而是通过每个fd定义的回调函数来实现的。只有就绪的fd才会执行回调函数。

如果没有大量的idle -connection或者dead-connection,epoll的效率并不会比select/poll高很多,但是当遇到大量的idle- connection,就会发现epoll的效率大大高于select/poll。

参考

用户空间与内核空间,进程上下文与中断上下文[总结]

进程切换

维基百科-文件描述符

Linux 中直接 I/O 机制的介绍

IO - 同步,异步,阻塞,非阻塞 (亡羊补牢篇)

Linux中select poll和epoll的区别

IO多路复用之select总结

IO多路复用之poll总结

IO多路复用之epoll总结

select、poll、epoll之间的区别总结[整理]

select,poll,epoll都是IO多路复用的机制。I/O多路复用就通过一种机制,可以监视多个描述符,一旦某个描述符就绪(一般是读就绪或者写就绪),能够通知程序进行相应的读写操作。但select,poll,epoll本质上都是同步I/O,因为他们都需要在读写事件就绪后自己负责进行读写,也就是说这个读写过程是阻塞的,而异步I/O则无需自己负责进行读写,异步I/O的实现会负责把数据从内核拷贝到用户空间。关于这三种IO多路复用的用法,前面三篇总结写的很清楚,并用服务器回射echo程序进行了测试。连接如下所示:

select:http://www.cnblogs.com/Anker/archive/2013/08/14/3258674.html

poll:http://www.cnblogs.com/Anker/archive/2013/08/15/3261006.html

epoll:http://www.cnblogs.com/Anker/archive/2013/08/17/3263780.html

今天对这三种IO多路复用进行对比,参考网上和书上面的资料,整理如下:

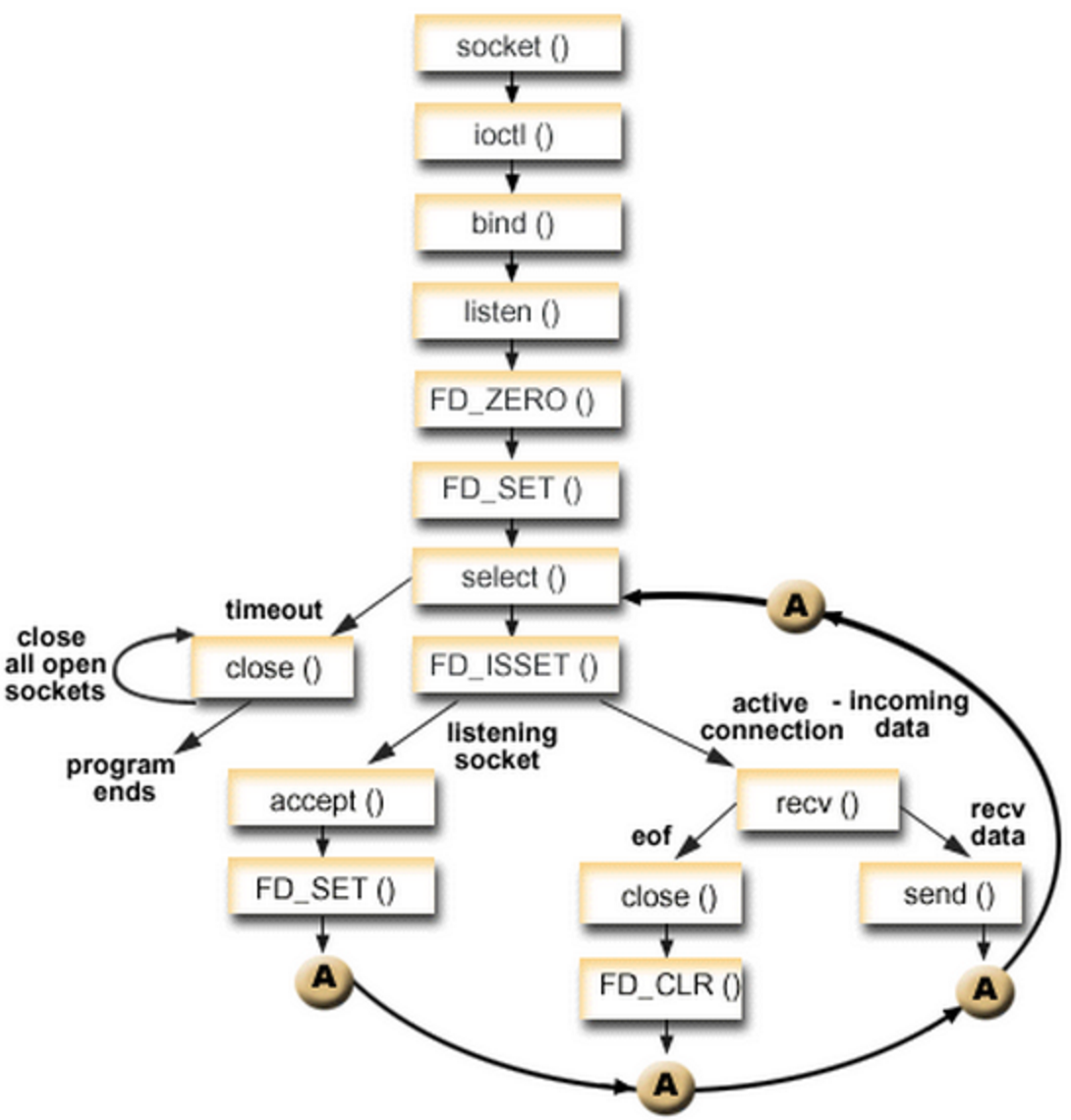

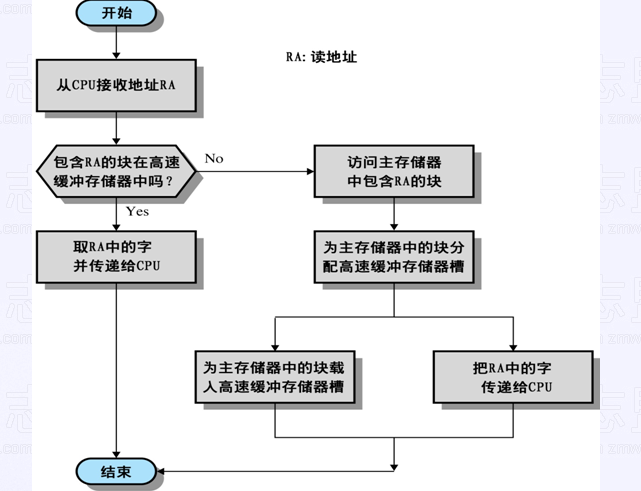

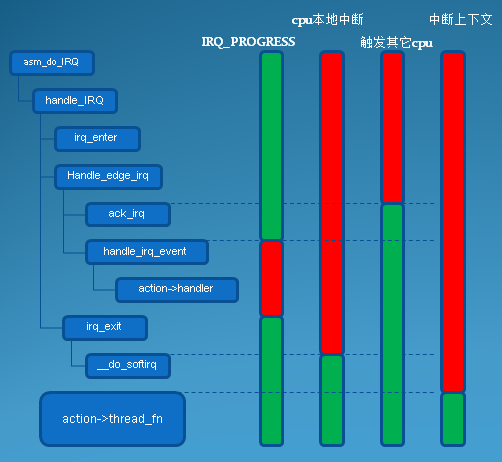

1、select实现

select的调用过程如下所示:

(1)使用copy_from_user从用户空间拷贝fd_set到内核空间

(2)注册回调函数__pollwait

(3)遍历所有fd,调用其对应的poll方法(对于socket,这个poll方法是sock_poll,sock_poll根据情况会调用到tcp_poll,udp_poll或者datagram_poll)

(4)以tcp_poll为例,其核心实现就是__pollwait,也就是上面注册的回调函数。

(5)__pollwait的主要工作就是把current(当前进程)挂到设备的等待队列中,不同的设备有不同的等待队列,对于tcp_poll来说,其等待队列是sk->sk_sleep(注意把进程挂到等待队列中并不代表进程已经睡眠了)。在设备收到一条消息(网络设备)或填写完文件数据(磁盘设备)后,会唤醒设备等待队列上睡眠的进程,这时current便被唤醒了。

(6)poll方法返回时会返回一个描述读写操作是否就绪的mask掩码,根据这个mask掩码给fd_set赋值。

(7)如果遍历完所有的fd,还没有返回一个可读写的mask掩码,则会调用schedule_timeout是调用select的进程(也就是current)进入睡眠。当设备驱动发生自身资源可读写后,会唤醒其等待队列上睡眠的进程。如果超过一定的超时时间(schedule_timeout指定),还是没人唤醒,则调用select的进程会重新被唤醒获得CPU,进而重新遍历fd,判断有没有就绪的fd。

(8)把fd_set从内核空间拷贝到用户空间。

总结:

select的几大缺点:

(1)每次调用select,都需要把fd集合从用户态拷贝到内核态,这个开销在fd很多时会很大

(2)同时每次调用select都需要在内核遍历传递进来的所有fd,这个开销在fd很多时也很大

(3)select支持的文件描述符数量太小了,默认是1024

2 poll实现

poll的实现和select非常相似,只是描述fd集合的方式不同,poll使用pollfd结构而不是select的fd_set结构,其他的都差不多。

关于select和poll的实现分析,可以参考下面几篇博文:

http://blog.csdn.net/lizhiguo0532/article/details/6568964#comments

http://blog.csdn.net/lizhiguo0532/article/details/6568968

http://blog.csdn.net/lizhiguo0532/article/details/6568969

http://www.ibm.com/developerworks/cn/linux/l-cn-edntwk/index.html?ca=drs-

http://linux.chinaunix.net/techdoc/net/2009/05/03/1109887.shtml

3、epoll

epoll既然是对select和poll的改进,就应该能避免上述的三个缺点。那epoll都是怎么解决的呢?在此之前,我们先看一下epoll和select和poll的调用接口上的不同,select和poll都只提供了一个函数——select或者poll函数。而epoll提供了三个函数,epoll_create,epoll_ctl和epoll_wait,epoll_create是创建一个epoll句柄;epoll_ctl是注册要监听的事件类型;epoll_wait则是等待事件的产生。

对于第一个缺点,epoll的解决方案在epoll_ctl函数中。每次注册新的事件到epoll句柄中时(在epoll_ctl中指定EPOLL_CTL_ADD),会把所有的fd拷贝进内核,而不是在epoll_wait的时候重复拷贝。epoll保证了每个fd在整个过程中只会拷贝一次。

对于第二个缺点,epoll的解决方案不像select或poll一样每次都把current轮流加入fd对应的设备等待队列中,而只在epoll_ctl时把current挂一遍(这一遍必不可少)并为每个fd指定一个回调函数,当设备就绪,唤醒等待队列上的等待者时,就会调用这个回调函数,而这个回调函数会把就绪的fd加入一个就绪链表)。epoll_wait的工作实际上就是在这个就绪链表中查看有没有就绪的fd(利用schedule_timeout()实现睡一会,判断一会的效果,和select实现中的第7步是类似的)。

对于第三个缺点,epoll没有这个限制,它所支持的FD上限是最大可以打开文件的数目,这个数字一般远大于2048,举个例子,在1GB内存的机器上大约是10万左右,具体数目可以cat /proc/sys/fs/file-max察看,一般来说这个数目和系统内存关系很大。

总结:

(1)select,poll实现需要自己不断轮询所有fd集合,直到设备就绪,期间可能要睡眠和唤醒多次交替。而epoll其实也需要调用epoll_wait不断轮询就绪链表,期间也可能多次睡眠和唤醒交替,但是它是设备就绪时,调用回调函数,把就绪fd放入就绪链表中,并唤醒在epoll_wait中进入睡眠的进程。虽然都要睡眠和交替,但是select和poll在“醒着”的时候要遍历整个fd集合,而epoll在“醒着”的时候只要判断一下就绪链表是否为空就行了,这节省了大量的CPU时间。这就是回调机制带来的性能提升。

(2)select,poll每次调用都要把fd集合从用户态往内核态拷贝一次,并且要把current往设备等待队列中挂一次,而epoll只要一次拷贝,而且把current往等待队列上挂也只挂一次(在epoll_wait的开始,注意这里的等待队列并不是设备等待队列,只是一个epoll内部定义的等待队列)。这也能节省不少的开销。

参考资料:

http://www.cnblogs.com/apprentice89/archive/2013/05/09/3070051.html

http://www.linuxidc.com/Linux/2012-05/59873p3.htm

http://xingyunbaijunwei.blog.163.com/blog/static/76538067201241685556302/

http://blog.csdn.net/kkxgx/article/details/7717125

https://banu.com/blog/2/how-to-use-epoll-a-complete-example-in-c/epoll-example.c

Linux I/O复用中select poll epoll模型的介绍及其优缺点的比较

关于I/O多路复用:

I/O多路复用(又被称为“事件驱动”),首先要理解的是,操作系统为你提供了一个功能,当你的某个socket可读或者可写的时候,它可以给你一个通知。这样当配合非阻塞的socket使用时,只有当系统通知我哪个描述符可读了,我才去执行read操作,可以保证每次read都能读到有效数据而不做纯返回-1和EAGAIN的无用功。写操作类似。操作系统的这个功能通过select/poll/epoll之类的系统调用来实现,这些函数都可以同时监视多个描述符的读写就绪状况,这样,**多个描述符的I/O操作都能在一个线程内并发交替地顺序完成,这就叫I/O多路复用,这里的“复用”指的是复用同一个线程。

一、I/O复用之select

1、介绍:

select系统调用的目的是:在一段指定时间内,监听用户感兴趣的文件描述符上的可读、可写和异常事件。poll和select应该被归类为这样的系统调用,它们可以阻塞地同时探测一组支持非阻塞的IO设备,直至某一个设备触发了事件或者超过了指定的等待时间——也就是说它们的职责不是做IO,而是帮助调用者寻找当前就绪的设备。

下面是select的原理图:

2、select系统调用API如下:

#include <sys/time.h>

#include <sys/types.h>

#include <unistd.h>

int select(int nfds, fd_set *readfds, fd_set *writefds, fd_set *exceptfds, struct timeval *timeout);fd_set结构体是文件描述符集,该结构体实际上是一个整型数组,数组中的每个元素的每一位标记一个文件描述符。fd_set能容纳的文件描述符数量由FD_SETSIZE指定,一般情况下,FD_SETSIZE等于1024,这就限制了select能同时处理的文件描述符的总量。

3、下面介绍一下各个参数的含义:

1)nfds参数指定被监听的文件描述符的总数。通常被设置为select监听的所有文件描述符中最大值加1;

2)readfds、writefds、exceptfds分别指向可读、可写和异常等事件对应的文件描述符集合。这三个参数都是传入传出型参数,指的是在调用select之前,用户把关心的可读、可写、或异常的文件描述符通过FD_SET(下面介绍)函数分别添加进readfds、writefds、exceptfds文件描述符集,select将对这些文件描述符集中的文件描述符进行监听,如果有就绪文件描述符,select会重置readfds、writefds、exceptfds文件描述符集来通知应用程序哪些文件描述符就绪。这个特性将导致select函数返回后,再次调用select之前,必须重置我们关心的文件描述符,也就是三个文件描述符集已经不是我们之前传入 的了。

3)timeout参数用来指定select函数的超时时间(下面讲select返回值时还会谈及)。

struct timeval

{

long tv_sec; //秒数

long tv_usec; //微秒数

};4、下面几个函数(宏实现)用来操纵文件描述符集:

void FD_SET(int fd, fd_set *set); //在set中设置文件描述符fd

void FD_CLR(int fd, fd_set *set); //清除set中的fd位

int FD_ISSET(int fd, fd_set *set); //判断set中是否设置了文件描述符fd

void FD_ZERO(fd_set *set); //清空set中的所有位(在使用文件描述符集前,应该先清空一下)

//(注意FD_CLR和FD_ZERO的区别,一个是清除某一位,一个是清除所有位)5、select的返回情况:

1)如果指定timeout为NULL,select会永远等待下去,直到有一个文件描述符就绪,select返回;

2)如果timeout的指定时间为0,select根本不等待,立即返回;

3)如果指定一段固定时间,则在这一段时间内,如果有指定的文件描述符就绪,select函数返回,如果超过指定时间,select同样返回。

4)返回值情况:

a)超时时间内,如果文件描述符就绪,select返回就绪的文件描述符总数(包括可读、可写和异常),如果没有文件描述符就绪,select返回0;

b)select调用失败时,返回 -1并设置errno,如果收到信号,select返回 -1并设置errno为EINTR。

6、文件描述符的就绪条件:

在网络编程中,

1)下列情况下socket可读:

a) socket内核接收缓冲区的字节数大于或等于其低水位标记SO_RCVLOWAT;

b) socket通信的对方关闭连接,此时该socket可读,但是一旦读该socket,会立即返回0(可以用这个方法判断client端是否断开连接);

c) 监听socket上有新的连接请求;

d) socket上有未处理的错误。

2)下列情况下socket可写:

a) socket内核发送缓冲区的可用字节数大于或等于其低水位标记SO_SNDLOWAT;

b) socket的读端关闭,此时该socket可写,一旦对该socket进行操作,该进程会收到SIGPIPE信号;

c) socket使用connect连接成功之后;

d) socket上有未处理的错误。

二、I/O复用之poll

1、poll系统调用的原理与原型和select基本类似,也是在指定时间内轮询一定数量的文件描述符,以测试其中是否有就绪者。

2、poll系统调用API如下:

#include <poll.h>

int poll(struct pollfd *fds, nfds_t nfds, int timeout);3、下面介绍一下各个参数的含义:

1)第一个参数是指向一个结构数组的第一个元素的指针,每个元素都是一个pollfd结构,用于指定测试某个给定描述符的条件。

struct pollfd

{

int fd; //指定要监听的文件描述符

short events; //指定监听fd上的什么事件

short revents; //fd上事件就绪后,用于保存实际发生的时间

};待监听的事件由events成员指定,函数在相应的revents成员中返回该描述符的状态(每个文件描述符都有两个事件,一个是传入型的events,一个是传出型的revents,从而避免使用传入传出型参数,注意与select的区别),从而告知应用程序fd上实际发生了哪些事件。events和revents都可以是多个事件的按位或。

2)第二个参数是要监听的文件描述符的个数,也就是数组fds的元素个数;

3)第三个参数意义与select相同。

4、poll的事件类型:

在使用POLLRDHUP时,要在代码开始处定义_GNU_SOURCE

5、poll的返回情况:

与select相同。

三、I/O复用之epoll

1、介绍:

epoll

与select和poll在使用和实现上有很大区别。首先,epoll使用一组函数来完成,而不是单独的一个函数;其次,epoll把用户关心的文件描述符上的事件放在内核里的一个事件表中,无须向select和poll那样每次调用都要重复传入文件描述符集合事件集。

2、创建一个文件描述符,指定内核中的事件表:

#include<sys/epoll.h>

int epoll_create(int size);

//调用成功返回一个文件描述符,失败返回-1并设置errno。size参数并不起作用,只是给内核一个提示,告诉它事件表需要多大。该函数返回的文件描述符指定要访问的内核事件表,是其他所有epoll系统调用的句柄。

3、操作内核事件表:

#include<sys/epoll.h>

int epoll_ctl(int epfd, int op, int fd, struct epoll_event *event);

//调用成功返回0,调用失败返回-1并设置errno。epfd是epoll_create返回的文件句柄,标识事件表,op指定操作类型。操作类型有以下3种:

a)EPOLL_CTL_ADD, 往事件表中注册fd上的事件;

b)EPOLL_CTL_MOD, 修改fd上注册的事件;

c)EPOLL_CTL_DEL, 删除fd上注册的事件。event参数指定事件,epoll_event的定义如下:

struct epoll_event

{

__int32_t events; //epoll事件

epoll_data_t data; //用户数据

};

typedef union epoll_data

{

void *ptr;

int fd;

uint32_t u32;

uint64_t u64;

}epoll_data;在使用epoll_ctl时,是把fd添加、修改到内核事件表中,或从内核事件表中删除fd的事件。如果是添加事件到事件表中,可以往data中的fd上添加事件events,或者不用data中的fd,而把fd放到用户数据ptr所指的内存中(因为epoll_data是一个联合体,只能使用其中一个数据),再设置events。

3、epoll_wait函数

epoll系统调用的最关键的一个函数epoll_wait,它在一段时间内等待一个组文件描述符上的事件。

#include<sys/epoll.h>

int epoll_wait(int epfd, struct epoll_event *events, int maxevents, int timeout);

//函数调用成功返回就绪文件描述符个数,失败返回-1并设置errno。timeout参数和select与poll相同,指定一个超时时间;maxevents指定最多监听多少个事件;events是一个传出型参数,epoll_wait函数如果检测到事件就绪,就将所有就绪的事件从内核事件表(epfd所指的文件)中复制到events指定的数组中。这个数组用来输出epoll_wait检测到的就绪事件,而不像select与poll那样,这也是epoll与前者最大的区别,下文在比较三者之间的区别时还会说到。

四、三组I/O复用函数的比较

相同点:

1)三者都需要在fd上注册用户关心的事件;

2)三者都要一个timeout参数指定超时时间;

不同点:

1)select:

a)select指定三个文件描述符集,分别是可读、可写和异常事件,所以不能更加细致地区分所有可能发生的事件;

b)select如果检测到就绪事件,会在原来的文件描述符上改动,以告知应用程序,文件描述符上发生了什么时间,所以再次调用select时,必须先重置文件描述符;

c)select采用对所有注册的文件描述符集轮询的方式,会返回整个用户注册的事件集合,所以应用程序索引就绪文件的时间复杂度为O(n);

d)select允许监听的最大文件描述符个数通常有限制,一般是1024,如果大于1024,select的性能会急剧下降;

e)只能工作在LT模式。

2)poll:

a)poll把文件描述符和事件绑定,事件不但可以单独指定,而且可以是多个事件的按位或,这样更加细化了事件的注册,而且poll单独采用一个元素用来保存就绪返回时的结果,这样在下次调用poll时,就不用重置之前注册的事件;

b)poll采用对所有注册的文件描述符集轮询的方式,会返回整个用户注册的事件集合,所以应用程序索引就绪文件的时间复杂度为O(n)。

c)poll用nfds参数指定最多监听多少个文件描述符和事件,这个数能达到系统允许打开的最大文件描述符数目,即65535。

d)只能工作在LT模式。

3)epoll:

a)epoll把用户注册的文件描述符和事件放到内核当中的事件表中,提供了一个独立的系统调用epoll_ctl来管理用户的事件,而且epoll采用回调的方式,一旦有注册的文件描述符就绪,讲触发回调函数,该回调函数将就绪的文件描述符和事件拷贝到用户空间events所管理的内存,这样应用程序索引就绪文件的时间复杂度达到O(1)。

b)epoll_wait使用maxevents来制定最多监听多少个文件描述符和事件,这个数能达到系统允许打开的最大文件描述符数目,即65535;

c)不仅能工作在LT模式,而且还支持ET高效模式(即EPOLLONESHOT事件,读者可以自己查一下这个事件类型,对于epoll的线程安全有很好的帮助)。

select/poll/epoll总结:

深度理解select、poll和epoll

在linux 没有实现epoll事件驱动机制之前,我们一般选择用select或者poll等IO多路复用的方法来实现并发服务程序。在大数据、高并发、集群等一些名词唱得火热之年代,select和poll的用武之地越来越有限,风头已经被epoll占尽。

本文便来介绍epoll的实现机制,并附带讲解一下select和poll。通过对比其不同的实现机制,真正理解为何epoll能实现高并发。

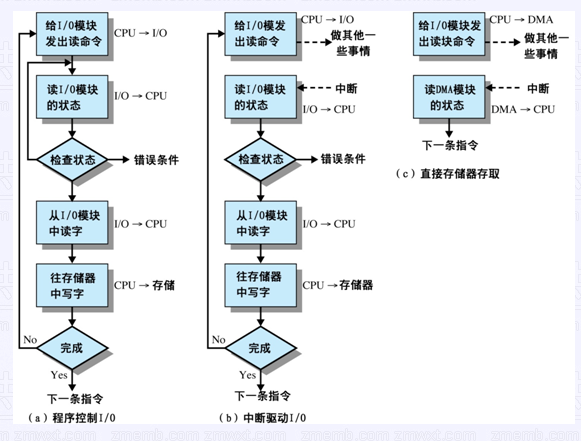

select()和poll() IO多路复用模型

select的缺点:

- 单个进程能够监视的文件描述符的数量存在最大限制,通常是1024,当然可以更改数量,但由于select采用轮询的方式扫描文件描述符,文件描述符数量越多,性能越差;(在linux内核头文件中,有这样的定义:#define __FD_SETSIZE 1024)

- 内核 / 用户空间内存拷贝问题,select需要复制大量的句柄数据结构,产生巨大的开销;

- select返回的是含有整个句柄的数组,应用程序需要遍历整个数组才能发现哪些句柄发生了事件;

- select的触发方式是水平触发,应用程序如果没有完成对一个已经就绪的文件描述符进行IO操作,那么之后每次select调用还是会将这些文件描述符通知进程。

相比select模型,poll使用链表保存文件描述符,因此没有了监视文件数量的限制,但其他三个缺点依然存在。

拿select模型为例,假设我们的服务器需要支持100万的并发连接,则在__FD_SETSIZE 为1024的情况下,则我们至少需要开辟1k个进程才能实现100万的并发连接。除了进程间上下文切换的时间消耗外,从内核/用户空间大量的无脑内存拷贝、数组轮询等,是系统难以承受的。因此,基于select模型的服务器程序,要达到10万级别的并发访问,是一个很难完成的任务。

因此,该epoll上场了。

epoll IO多路复用模型实现机制

由于epoll的实现机制与select/poll机制完全不同,上面所说的 select的缺点在epoll上不复存在。

设想一下如下场景:有100万个客户端同时与一个服务器进程保持着TCP连接。而每一时刻,通常只有几百上千个TCP连接是活跃的(事实上大部分场景都是这种情况)。如何实现这样的高并发?

在select/poll时代,服务器进程每次都把这100万个连接告诉操作系统(从用户态复制句柄数据结构到内核态),让操作系统内核去查询这些套接字上是否有事件发生,轮询完后,再将句柄数据复制到用户态,让服务器应用程序轮询处理已发生的网络事件,这一过程资源消耗较大,因此,select/poll一般只能处理几千的并发连接。

epoll的设计和实现与select完全不同。epoll通过在Linux内核中申请一个简易的文件系统(文件系统一般用什么数据结构实现?B+树)。把原先的select/poll调用分成了3个部分:

1)调用epoll_create()建立一个epoll对象(在epoll文件系统中为这个句柄对象分配资源)

2)调用epoll_ctl向epoll对象中添加这100万个连接的套接字

3)调用epoll_wait收集发生的事件的连接

如此一来,要实现上面说是的场景,只需要在进程启动时建立一个epoll对象,然后在需要的时候向这个epoll对象中添加或者删除连接。同时,epoll_wait的效率也非常高,因为调用epoll_wait时,并没有一股脑的向操作系统复制这100万个连接的句柄数据,内核也不需要去遍历全部的连接。

下面来看看Linux内核具体的epoll机制实现思路。

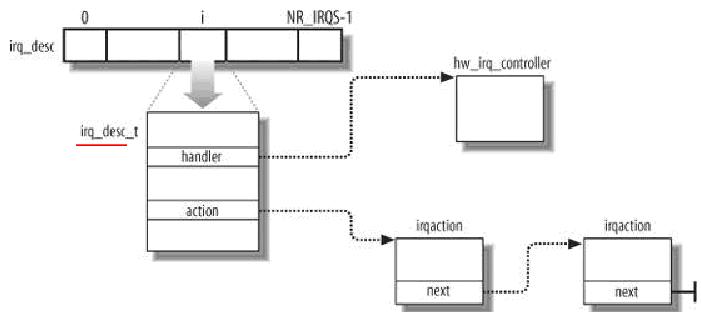

当某一进程调用epoll_create方法时,Linux内核会创建一个eventpoll结构体,这个结构体中有两个成员与epoll的使用方式密切相关。eventpoll结构体如下所示:

- struct eventpoll{

- ....

- /*红黑树的根节点,这颗树中存储着所有添加到epoll中的需要监控的事件*/

- struct rb_root rbr;

- /*双链表中则存放着将要通过epoll_wait返回给用户的满足条件的事件*/

- struct list_head rdlist;

- ....

- };

每一个epoll对象都有一个独立的eventpoll结构体,用于存放通过epoll_ctl方法向epoll对象中添加进来的事件。这些事件都会挂载在红黑树中,如此,重复添加的事件就可以通过红黑树而高效的识别出来(红黑树的插入时间效率是lgn,其中n为树的高度)。

而所有添加到epoll中的事件都会与设备(网卡)驱动程序建立回调关系,也就是说,当相应的事件发生时会调用这个回调方法。这个回调方法在内核中叫ep_poll_callback,它会将发生的事件添加到rdlist双链表中。

在epoll中,对于每一个事件,都会建立一个epitem结构体,如下所示:

- struct epitem{

- struct rb_node rbn;//红黑树节点

- struct list_head rdllink;//双向链表节点

- struct epoll_filefd ffd; //事件句柄信息

- struct eventpoll *ep; //指向其所属的eventpoll对象

- struct epoll_event event; //期待发生的事件类型

- }

当调用epoll_wait检查是否有事件发生时,只需要检查eventpoll对象中的rdlist双链表中是否有epitem元素即可。如果rdlist不为空,则把发生的事件复制到用户态,同时将事件数量返回给用户。

epoll数据结构示意图

从上面的讲解可知:通过红黑树和双链表数据结构,并结合回调机制,造就了epoll的高效。

OK,讲解完了Epoll的机理,我们便能很容易掌握epoll的用法了。一句话描述就是:三步曲。

第一步:epoll_create()系统调用。此调用返回一个句柄,之后所有的使用都依靠这个句柄来标识。

第二步:epoll_ctl()系统调用。通过此调用向epoll对象中添加、删除、修改感兴趣的事件,返回0标识成功,返回-1表示失败。

第三部:epoll_wait()系统调用。通过此调用收集收集在epoll监控中已经发生的事件。

最后,附上一个epoll编程实例。(作者为sparkliang)

- //

- // a simple echo server using epoll in linux

- //

- // 2009-11-05

- // 2013-03-22:修改了几个问题,1是/n格式问题,2是去掉了原代码不小心加上的ET模式;

- // 本来只是简单的示意程序,决定还是加上 recv/send时的buffer偏移

- // by sparkling

- //

- #include <sys/socket.h>

- #include <sys/epoll.h>

- #include <netinet/in.h>

- #include <arpa/inet.h>

- #include <fcntl.h>

- #include <unistd.h>

- #include <stdio.h>

- #include <errno.h>

- #include <iostream>

- using namespace std;

- #define MAX_EVENTS 500

- struct myevent_s

- {

- int fd;

- void (*call_back)(int fd, int events, void *arg);

- int events;

- void *arg;

- int status; // 1: in epoll wait list, 0 not in

- char buff[128]; // recv data buffer

- int len, s_offset;

- long last_active; // last active time

- };

- // set event

- void EventSet(myevent_s *ev, int fd, void (*call_back)(int, int, void*), void *arg)

- {

- ev->fd = fd;

- ev->call_back = call_back;

- ev->events = 0;

- ev->arg = arg;

- ev->status = 0;

- bzero(ev->buff, sizeof(ev->buff));

- ev->s_offset = 0;

- ev->len = 0;

- ev->last_active = time(NULL);

- }

- // add/mod an event to epoll

- void EventAdd(int epollFd, int events, myevent_s *ev)

- {

- struct epoll_event epv = {0, {0}};

- int op;

- epv.data.ptr = ev;

- epv.events = ev->events = events;

- if(ev->status == 1){

- op = EPOLL_CTL_MOD;

- }

- else{

- op = EPOLL_CTL_ADD;

- ev->status = 1;

- }

- if(epoll_ctl(epollFd, op, ev->fd, &epv) < 0)

- printf("Event Add failed[fd=%d], evnets[%d] ", ev->fd, events);

- else

- printf("Event Add OK[fd=%d], op=%d, evnets[%0X] ", ev->fd, op, events);

- }

- // delete an event from epoll

- void EventDel(int epollFd, myevent_s *ev)

- {

- struct epoll_event epv = {0, {0}};

- if(ev->status != 1) return;

- epv.data.ptr = ev;

- ev->status = 0;

- epoll_ctl(epollFd, EPOLL_CTL_DEL, ev->fd, &epv);

- }

- int g_epollFd;

- myevent_s g_Events[MAX_EVENTS+1]; // g_Events[MAX_EVENTS] is used by listen fd

- void RecvData(int fd, int events, void *arg);

- void SendData(int fd, int events, void *arg);

- // accept new connections from clients

- void AcceptConn(int fd, int events, void *arg)

- {

- struct sockaddr_in sin;

- socklen_t len = sizeof(struct sockaddr_in);

- int nfd, i;

- // accept

- if((nfd = accept(fd, (struct sockaddr*)&sin, &len)) == -1)

- {

- if(errno != EAGAIN && errno != EINTR)

- {

- }

- printf("%s: accept, %d", __func__, errno);

- return;

- }

- do

- {

- for(i = 0; i < MAX_EVENTS; i++)

- {

- if(g_Events[i].status == 0)

- {

- break;

- }

- }

- if(i == MAX_EVENTS)

- {

- printf("%s:max connection limit[%d].", __func__, MAX_EVENTS);

- break;

- }

- // set nonblocking

- int iret = 0;

- if((iret = fcntl(nfd, F_SETFL, O_NONBLOCK)) < 0)

- {

- printf("%s: fcntl nonblocking failed:%d", __func__, iret);

- break;

- }

- // add a read event for receive data

- EventSet(&g_Events[i], nfd, RecvData, &g_Events[i]);

- EventAdd(g_epollFd, EPOLLIN, &g_Events[i]);

- }while(0);

- printf("new conn[%s:%d][time:%d], pos[%d] ", inet_ntoa(sin.sin_addr),

- ntohs(sin.sin_port), g_Events[i].last_active, i);

- }

- // receive data

- void RecvData(int fd, int events, void *arg)

- {

- struct myevent_s *ev = (struct myevent_s*)arg;

- int len;

- // receive data

- len = recv(fd, ev->buff+ev->len, sizeof(ev->buff)-1-ev->len, 0);

- EventDel(g_epollFd, ev);

- if(len > 0)

- {

- ev->len += len;

- ev->buff[len] = '�';

- printf("C[%d]:%s ", fd, ev->buff);

- // change to send event

- EventSet(ev, fd, SendData, ev);

- EventAdd(g_epollFd, EPOLLOUT, ev);

- }

- else if(len == 0)

- {

- close(ev->fd);

- printf("[fd=%d] pos[%d], closed gracefully. ", fd, ev-g_Events);

- }

- else

- {

- close(ev->fd);

- printf("recv[fd=%d] error[%d]:%s ", fd, errno, strerror(errno));

- }

- }

- // send data

- void SendData(int fd, int events, void *arg)

- {

- struct myevent_s *ev = (struct myevent_s*)arg;

- int len;

- // send data

- len = send(fd, ev->buff + ev->s_offset, ev->len - ev->s_offset, 0);

- if(len > 0)

- {

- printf("send[fd=%d], [%d<->%d]%s ", fd, len, ev->len, ev->buff);

- ev->s_offset += len;

- if(ev->s_offset == ev->len)

- {

- // change to receive event

- EventDel(g_epollFd, ev);

- EventSet(ev, fd, RecvData, ev);

- EventAdd(g_epollFd, EPOLLIN, ev);

- }

- }

- else

- {

- close(ev->fd);

- EventDel(g_epollFd, ev);

- printf("send[fd=%d] error[%d] ", fd, errno);

- }

- }

- void InitListenSocket(int epollFd, short port)

- {

- int listenFd = socket(AF_INET, SOCK_STREAM, 0);

- fcntl(listenFd, F_SETFL, O_NONBLOCK); // set non-blocking

- printf("server listen fd=%d ", listenFd);

- EventSet(&g_Events[MAX_EVENTS], listenFd, AcceptConn, &g_Events[MAX_EVENTS]);

- // add listen socket

- EventAdd(epollFd, EPOLLIN, &g_Events[MAX_EVENTS]);

- // bind & listen

- sockaddr_in sin;

- bzero(&sin, sizeof(sin));

- sin.sin_family = AF_INET;

- sin.sin_addr.s_addr = INADDR_ANY;

- sin.sin_port = htons(port);

- bind(listenFd, (const sockaddr*)&sin, sizeof(sin));

- listen(listenFd, 5);

- }

- int main(int argc, char **argv)

- {

- unsigned short port = 12345; // default port

- if(argc == 2){

- port = atoi(argv[1]);

- }

- // create epoll

- g_epollFd = epoll_create(MAX_EVENTS);

- if(g_epollFd <= 0) printf("create epoll failed.%d ", g_epollFd);

- // create & bind listen socket, and add to epoll, set non-blocking

- InitListenSocket(g_epollFd, port);

- // event loop

- struct epoll_event events[MAX_EVENTS];

- printf("server running:port[%d] ", port);

- int checkPos = 0;

- while(1){

- // a simple timeout check here, every time 100, better to use a mini-heap, and add timer event

- long now = time(NULL);

- for(int i = 0; i < 100; i++, checkPos++) // doesn't check listen fd

- {

- if(checkPos == MAX_EVENTS) checkPos = 0; // recycle

- if(g_Events[checkPos].status != 1) continue;

- long duration = now - g_Events[checkPos].last_active;

- if(duration >= 60) // 60s timeout

- {

- close(g_Events[checkPos].fd);

- printf("[fd=%d] timeout[%d--%d]. ", g_Events[checkPos].fd, g_Events[checkPos].last_active, now);

- EventDel(g_epollFd, &g_Events[checkPos]);

- }

- }

- // wait for events to happen

- int fds = epoll_wait(g_epollFd, events, MAX_EVENTS, 1000);

- if(fds < 0){

- printf("epoll_wait error, exit ");

- break;

- }

- for(int i = 0; i < fds; i++){

- myevent_s *ev = (struct myevent_s*)events[i].data.ptr;

- if((events[i].events&EPOLLIN)&&(ev->events&EPOLLIN)) // read event

- {

- ev->call_back(ev->fd, events[i].events, ev->arg);

- }

- if((events[i].events&EPOLLOUT)&&(ev->events&EPOLLOUT)) // write event

- {

- ev->call_back(ev->fd, events[i].events, ev->arg);

- }

- }

- }

- // free resource

- return 0;

- }

Mmap的实现原理和应用

很多文章分析了mmap的实现原理。从代码的逻辑来分析,总是觉没有把mmap后读写映射区域和普通的read/write联系起来。不得不产生疑问:

1,普通的read/write和mmap后的映射区域的读写到底有什么区别。

2, 为什么有时候会选择mmap而放弃普通的read/write。

3,如果文章中的内容有不对是或者是不妥的地方,欢迎大家指正。

围绕着这两个问题分析一下,其实在考虑这些问题的同时不免和其他的很多系统机制产生交互。虽然是讲解mmap,但是很多知识还是为了阐明问题做必要的铺垫。这些知识也正是linux的繁琐所在。一个应用往往和系统中的多种机制交互。这篇文章中尽量减少对源代码的引用和分析。把这样的工作留到以后的细节分析中。但是很多分析的理论依据还是来自于源代码。可见源代码的重要地位。

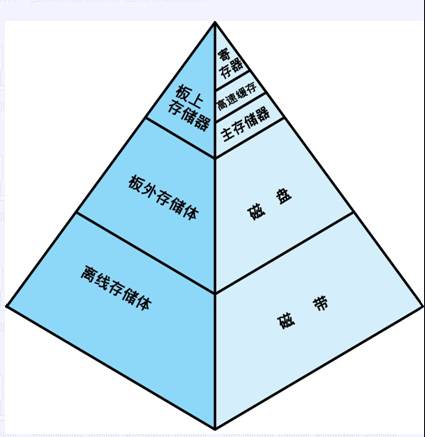

基础知识:

1, 进程每次切换后,都会在tlb base寄存器中重新load属于每一个进程自己的地址转换基地址。在cpu当前运行的进程中都会有current宏来表示当前的进程的信息。应为这个代码实现涉及到硬件架构的问题,为了避免差异的存在在文章中用到硬件知识的时候还是指明是x86的架构,毕竟x86的资料和分析的研究人员也比较多。其实arm还有其他类似的RISC的芯片,只要有mmu支持的,都会有类似的基地址寄存器。

2, 在系统运行进程之前都会为每一个进程分配属于它自己的运行空间。并且这个空间的有效性依赖于tlb base中的内容。32位的系统中访问的空间大小为4G。在这个空间中进程是“自由”的。所谓“自由”不是说对于4G的任何一个地址或者一段空间都可以访问。如果要访问,还是要遵循地址有效性,就是tlb base中所指向的任何页表转换后的物理地址。其中的有效性有越界,权限等等检查。

3, 任何一个用户进程的运行在系统分配的空间中。这个空间可以有

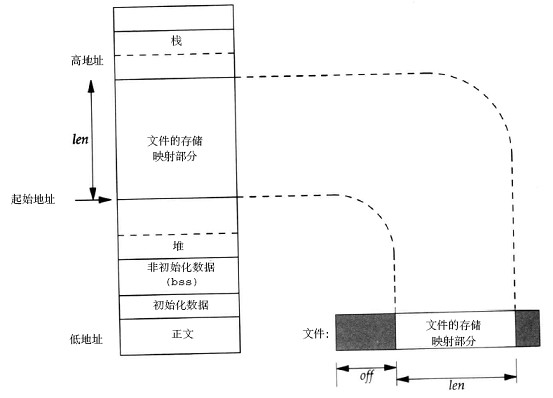

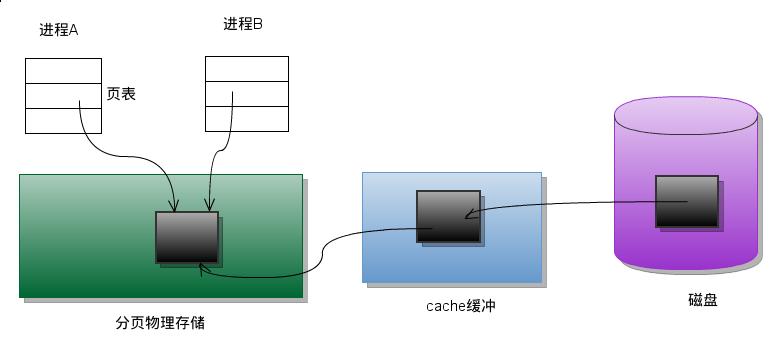

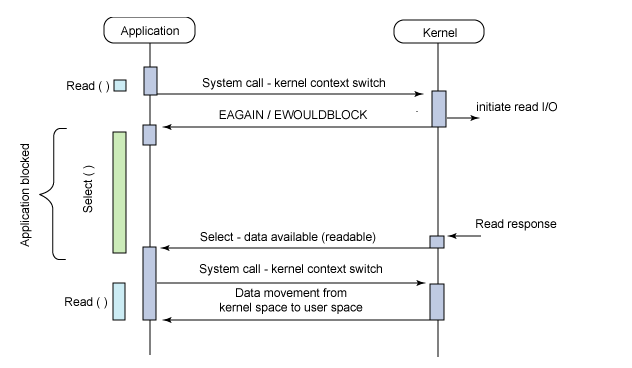

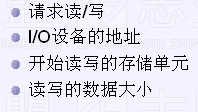

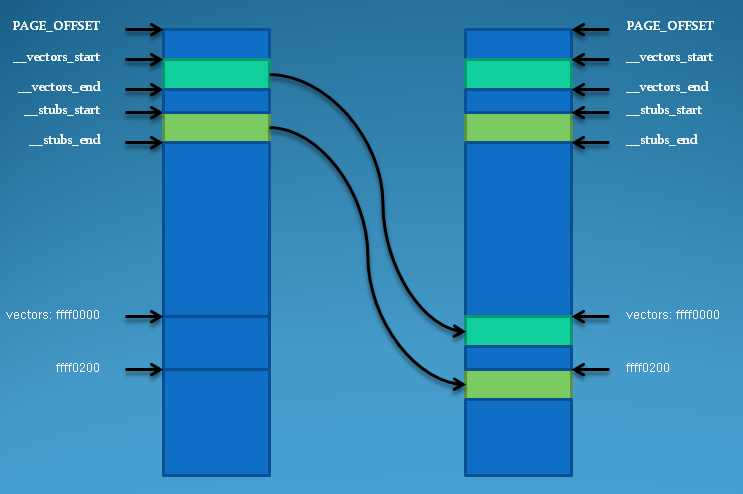

vma:struct vm_area_struct来表示。所有的运行空间可以有这个结构体描述。用户进程可以分为text data 段。这些段的具体在4G中的位置有不同的vma来描述。Vma的管理又有其他机制保证,这些机制涉及到了算法和物理内存管理等。请看一下两个图片:

图 一:

图 二:

系统调用中的write和read:

这里没有指定确切的文件系统类型作为分析的对象。找到系统调用号,然后确定具体的文件系统所带的file operation。在特定的file operation中有属于每一种文件系统自己的操作函数集合。其中就有read和write。

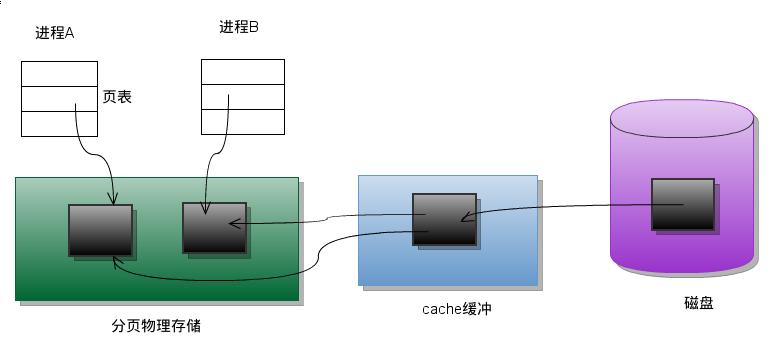

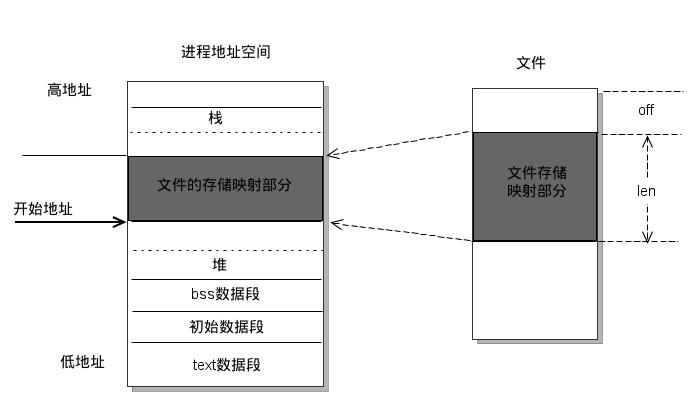

图 三:

在真正的把用户数据读写到磁盘或者是存储设备前,内核还会在page cache中管理这些数据。这些page的存在有效的管理了用户数据和读写的效率。用户数据不是直接来自于应用层,读(read)或者是写入(write)磁盘和存储介质,而是被一层一层的应用所划分,在每一层次中都会有不同的功能对应。最后发生交互时,在最恰当的时机触发磁盘的操作。通过IO驱动写入磁盘和存储介质。这里主要强调page cache的管理。应为page的管理设计到了缓存,这些缓存以page的单位管理。在没有IO操作之前,暂时存放在系统空间中,而并未直接写入磁盘或者存贮介质。

系统调用中的mmap:

当创建一个或者切换一个进程的同时,会把属于这个当前进程的系统信息载入。这些系统信息中包含了当前进程的运行空间。当用户程序调用mmap后。函数会在当前进程的空间中找到适合的vma来描述自己将要映射的区域。这个区域的作用就是将mmap函数中文件描述符所指向的具体文件中内容映射过来。

原理是:mmap的执行,仅仅是在内核中建立了文件与虚拟内存空间的对应关系。用户访问这些虚拟内存空间时,页面表里面是没有这些空间的表项的。当用户程序试图访问这些映射的空间时,于是产生缺页异常。内核捕捉这些异常,逐渐将文件载入。所谓的载入过程,具体的操作就是read和write在管理pagecache。Vma的结构体中有很文件操作集。vma操作集中会有自己关于page cache的操作集合。这样,虽然是两种不同的系统调用,由于操作和调用触发的路径不同。但是最后还是落实到了page cache的管理。实现了文件内容的操作。

Ps:

文件的page cache管理也是很好的内容。涉及到了address space的操作。其中很多的内容和文件操作相关。

效率对比:

这里应用了网上一篇文章。发现较好的分析,着这里引用一下。

Mmap:

#include <stdio.h>

#include <stdlib.h>

#include <sys/types.h>

#include <sys/stat.h>

#include <unistd.h>

#include <sys/mman.h>

void main()

{

int fd = open("test.file", 0);

struct stat statbuf;

char *start;

char buf[2] = {0};

int ret = 0;

fstat(fd, &statbuf);

start = mmap(NULL, statbuf.st_size, PROT_READ, MAP_PRIVATE, fd, 0);

do {

*buf = start[ret++];

}while(ret < statbuf.st_size);

}

Read:

#include <stdio.h>

#include <stdlib.h>

void main()

{

FILE *pf = fopen("test.file", "r");

char buf[2] = {0};

int ret = 0;

do {

ret = fread(buf, 1, 1, pf);

}while(ret);

}

运行结果:

[xiangy@compiling-server test_read]$ time ./fread

real 0m0.901s

user 0m0.892s

sys 0m0.010s

[xiangy@compiling-server test_read]$ time ./mmap

real 0m0.112s

user 0m0.106s

sys 0m0.006s

[xiangy@compiling-server test_read]$ time ./read

real 0m15.549s

user 0m3.933s

sys 0m11.566s

[xiangy@compiling-server test_read]$ ll test.file

-rw-r--r-- 1 xiangy svx8004 23955531 Sep 24 17:17 test.file

可以看出使用mmap后发现,系统调用所消耗的时间远远比普通的read少很多。

共享内存:mmap函数实现

内存映射的应用:

- 以页面为单位,将一个普通文件映射到内存中,通常在需要对文件进行频繁读写时使用,这样用内存读写取代I/O读写,以获得较高的性能;

- 将特殊文件进行匿名内存映射,可以为关联进程提供共享内存空间;

- 为无关联的进程提供共享内存空间,一般也是将一个普通文件映射到内存中。

相关API

#include <sys/mman.h>

void *mmap(void *addr, size_t length, int prot, int flags,

int fd, off_t offset);

void *mmap64(void *addr, size_t length, int prot, int flags,

int fd, off64_t offset);

int munmap(void *addr, size_t length);

int msync(void *addr, size_t length, int flags);mmap函数说明:

-

参数 addr 指明文件描述字fd指定的文件在进程地址空间内的映射区的开始地址,必须是页面对齐的地址,通常设为 NULL,让内核去选择开始地址。任何情况下,mmap 的返回值为内存映射区的开始地址。

-

参数 length 指明文件需要被映射的字节长度。off 指明文件的偏移量。通常 off 设为 0 。

- 如果 len 不是页面的倍数,它将被扩大为页面的倍数。扩充的部分通常被系统置为 0 ,而且对其修改并不影响到文件。

- off 同样必须是页面的倍数。通过 sysconf(_SC_PAGE_SIZE) 可以获得页面的大小。

-

参数 prot 指明映射区的保护权限。通常有以下 4 种。通常是 PROT_READ | PROT_WRITE 。

- PROT_READ 可读

- PROT_WRITE 可写

- PROT_EXEC 可执行

- PROT_NONE 不能被访问

-

参数 flag 指明映射区的属性。取值有以下几种。MAP_PRIVATE 与 MAP_SHARED 必选其一,MAP_FIXED 为可选项。

- MAP_PRIVATE 指明对映射区数据的修改不会影响到真正的文件。

- MAP_SHARED 指明对映射区数据的修改,多个共享该映射区的进程都可以看见,而且会反映到实际的文件。

- MAP_FIXED 要求 mmap 的返回值必须等于 addr 。如果不指定 MAP_FIXED 并且 addr 不为 NULL ,则对 addr 的处理取决于具体实现。考虑到可移植性,addr 通常设为 NULL ,不指定 MAP_FIXED。

-

当 mmap 成功返回时,fd 就可以关闭,这并不影响创建的映射区。

munmap函数说明:

进程退出的时候,映射区会自动删除。不过当不再需要映射区时,可以调用 munmap 显式删除。当映射区删除后,后续对映射区的引用会生成 SIGSEGV 信号。

msync函数说明:

文件一旦被映射后,调用mmap()的进程对返回地址的访问是对某一内存区域的访问,暂时脱离了磁盘上文件的影响。所有对mmap()返回地址空间的操作只在内存中有意义,只有在调用了munmap()后或者msync()时,才把内存中的相应内容写回磁盘文件。

代码实例:

两个进程通过映射普通文件实现共享内存通信

map_normalfile1.c及map_normalfile2.c。编译两个程序,可执行文件分别为map_normalfile1及map_normalfile2。两个程序通过命令行参数指定同一个文件来实现共享内存方式的进程间通信。map_normalfile2试图打开命令行参数指定的一个普通文件,把该文件映射到进程的地址空间,并对映射后的地址空间进行写操作。map_normalfile1把命令行参数指定的文件映射到进程地址空间,然后对映射后的地址空间执行读操作。这样,两个进程通过命令行参数指定同一个文件来实现共享内存方式的进程间通信。

/*-------------map_normalfile1.c-----------*/

#include <stdio.h>

#include <string.h>

#include <sys/mman.h>

#include <sys/types.h>

#include <fcntl.h>

#include <unistd.h>

typedef struct{

char name[4];

int age;

}people;

int main(int argc, char** argv) // map a normal file as shared mem:

{

int fd,i;

people *p_map;

char temp[2] = {'�'};

fd=open(argv[1],O_CREAT|O_RDWR|O_TRUNC,00777);

lseek(fd,sizeof(people)*5-1,SEEK_SET);

write(fd,"",1);

p_map = (people*) mmap( NULL,sizeof(people)*10,PROT_READ|PROT_WRITE,

MAP_SHARED,fd,0 );

close( fd );

temp[0] = 'a';

for(i=0; i<15; i++)

{

temp[0] += 1;

memcpy( ( *(p_map+i) ).name, &temp[0],2 );

( *(p_map+i) ).age = 20+i;

}

printf("initialize over

");

sleep(10);

munmap( p_map, sizeof(people)*10 );

printf( "umap ok

" );

return 0;

}/*-------------map_normalfile2.c-----------*/

#include <stdio.h>

#include <string.h>

#include <sys/mman.h>

#include <sys/types.h>

#include <fcntl.h>

#include <unistd.h>

typedef struct{

char name[4];

int age;

}people;

int main(int argc, char** argv) // map a normal file as shared mem:

{

int fd,i;

people *p_map;

char temp[2] = {'�'};

fd=open(argv[1],O_CREAT|O_RDWR|O_TRUNC,00777);

lseek(fd,sizeof(people)*5-1,SEEK_SET);

write(fd,"",1);

p_map = (people*) mmap( NULL,sizeof(people)*10,PROT_READ|PROT_WRITE,

MAP_SHARED,fd,0 );

close( fd );

temp[0] = 'a';

for(i=0; i<15; i++)

{

temp[0] += 1;

memcpy( ( *(p_map+i) ).name, &temp[0],2 );

( *(p_map+i) ).age = 20+i;

}

printf("initialize over

");

sleep(10);

munmap( p_map, sizeof(people)*10 );

printf( "umap ok

" );

return 0;

}map_normalfile1首先打开或创建一个文件,并把文件的长度设置为5个people结构大小.mmap映射10个people结构大小的内存,利用返回的地址开始设置15个people结构。然后睡眠10S,等待其他进程映射同一个文件,然后解除映射。

通过实验,在map_normalfile1输出initialize over 之后,输出umap ok之前,运行map_normalfile2 file,可以输出设置好的15个people结构

在map_normalfile1 输出umap ok后,运行map_normalfile2则输出结构,前5个people是已设置的,后10结构为0。

1) 最终被映射文件的内容的长度不会超过文件本身的初始大小,即映射不能改变文件的大小.

2) 可以用于进程通信的有效地址空间大小大体上受限于被映射文件的大小,但不完全受限于文件大小.打开文件的大小为5个people结构,映射长度为10个people结构长度,共享内存通信用15个people结构大小。

在linux中,内存的保护是以页为基本单位的,即使被映射文件只有一个字节大小,内核也会为映射分配一个页面大小的内存。当被映射文件小于一个页面大小时,进程可以对从mmap()返回地址开始的一个页面大小进行访问,而不会出错;但是,如果对一个页面以外的地址空间进行访问,则导致错误发生,后面将进一步描述。因此,可用于进程间通信的有效地址空间大小不会超过文件大小及一个页面大小的和。

3)

文件一旦被映射后,调用mmap()的进程对返回地址的访问是对某一内存区域的访问,暂时脱离了磁盘上文件的影响。所有对mmap()返回地址空间的操作只在内存中有意义,只有在调用了munmap()后或者msync()时,才把内存中的相应内容写回磁盘文件,所写内容仍然不能超过文件的大小

技巧:

生成固定大小的文件的两种方式:

/*第一种方法*/

fd = open(PATHNAME, O_RDWR | O_CREAT | O_TRUNC, FILE_MODE);

lseek(fd, filesize-1, SEEK_SET);

write(fd, "", 1);

/*第二种方法*/

ftruncate(fd, filesize);父子进程通过匿名映射实现共享内存

- 匿名内存映射 与 使用 /dev/zero 类型,都不需要真实的文件。要使用匿名映射之需要向 mmap 传入 MAP_ANON 标志,并且 fd 参数 置为 -1 。

- 所谓匿名,指的是映射区并没有通过 fd 与 文件路径名相关联。匿名内存映射用在有血缘关系的进程间。

#include <sys/mman.h>

#include <sys/types.h>

#include <fcntl.h>

#include <unistd.h>

typedef struct{

char name[4];

int age;

}people;

main(int argc, char** argv)

{

int i;

people *p_map;

char temp;

p_map=(people*)mmap(NULL,sizeof(people)*10,PROT_READ|PROT_WRITE,

MAP_SHARED|MAP_ANONYMOUS,-1,0);

if(fork() == 0)

{

sleep(2);

for(i = 0;i<5;i++)

printf("child read: the %d people's age is %d

",i+1,(*(p_map+i)).age);

(*p_map).age = 100;

munmap(p_map,sizeof(people)*10); //实际上,进程终止时,会自动解除映射。

exit();

}

temp = 'a';

for(i = 0;i<5;i++)

{

temp += 1;

memcpy((*(p_map+i)).name, &temp,2);

(*(p_map+i)).age=20+i;

}

sleep(5);

printf( "parent read: the first people,s age is %d

",(*p_map).age );

printf("umap

");

munmap( p_map,sizeof(people)*10 );

printf( "umap ok

" );

}参考:

man pthread_mutexattr_init查看信号量进程间同步实现实例- http://blog.csdn.net/nancygreen/article/details/6558039

- http://blog.chinaunix.net/uid-20564848-id-74123.html

- Linux环境进程间通信(五): 共享内存(上)

驱动总结之mmap函数实现

mmap作为struct file_operations的重要一个元素,mmap主要是实现物理内存到虚拟内存的映射关系,这样可以实现直接访问虚拟内存,而不用使用设备相关的read、write操作,mmap的基本过程是将文件映射到虚拟内存中。在之前的一篇博客中谈到了mmap实现文件复制的操作。

- /*主要是建立虚拟地址到物理地址的页表关系,其他的过程又内核自己完成*/

- static int mem_mmap(struct file* filp,struct

vm_area_struct *vma)

- {

- /*间接的控制设备*/

- struct mem_dev *dev = filp->private_data;

- /*标记这段虚拟内存映射为IO区域,并阻止系统将该区域包含在进程的存放转存中*/

- vma->vm_flags |= VM_IO;

- /*标记这段区域不能被换出*/

- vma->vm_flags |= VM_RESERVED;

- /**/

- if(remap_pfn_range(vma,/*虚拟内存区域*/

- vma->vm_start, /*虚拟地址的起始地址*/

- virt_to_phys(dev->data)>>PAGE_SHIFT, /*物理存储区的物理页号*/

- dev->size, /*映射区域大小*/

- vma->vm_page_prot /*虚拟区域保护属性*/

- ))

- return -EAGAIN;

- return 0;

- }

-

vma->vm_flags |= VM_IO;

- vma->vm_flags |= VM_RESERVED;

上面的两个保护机制就说明了被映射的这段区域具有映射IO的相似性,同时保证这段区域不能随便的换出。就是建立一个物理页与虚拟页之间的关联性。具体原理是虚拟页和物理页之间是以页表的方式关联起来,虚拟内存通常大于物理内存,在使用过程中虚拟页通过页表关联一切对应的物理页,当物理页不够时,会选择性的牺牲一些页,也就是将物理页与虚拟页之间切断,重现关联其他的虚拟页,保证物理内存够用。在设备驱动中应该具体的虚拟页和物理页之间的关系应该是长期的,应该保护起来,不能随便被别的虚拟页所替换。具体也可参看关于虚拟存储器的文章。

接下来就是建立物理页与虚拟页之间的关系,即采用函数remap_pfn_range(),具体的参数如下:

int remap_pfn_range(structvm_area_struct *vma, unsigned long addr,unsigned long pfn, unsigned long size, pgprot_t prot)

1、struct vm_area_struct是一个虚拟内存区域结构体,表示虚拟存储器中的一个内存区域。其中的元素vm_start是指虚拟存储器中的起始地址。

2、addr也就是虚拟存储器中的起始地址,通常可以选择addr = vma->vm_start。

3、pfn是指物理存储器的具体页号,通常通过物理地址得到对应的物理页号,具体采用virt_to_phys(dev->data)>>PAGE_SHIFT.首先将虚拟内存转换到物理内存,然后得到页号。>>PAGE_SHIFT通常为12,这是因为每一页的大小刚好是4K,这样右移12相当于除以4096,得到页号。

4、size区域大小

5、区域保护机制。

返回值,如果成功返回0,否则正数。

测试代码可以直接通过对虚拟内存区域操作,实现不同的操作,如下:

- #include<fcntl.h>

- #include<unistd.h>

- #include<stdio.h>

- #include<stdlib.h>

- #include<sys/types.h>

- #include<sys/stat.h>

- #include<sys/mman.h>

- #include<string.h>

- int main()

- {

- int fd;

- char *start;

- char buf[2048];

- strcpy(buf,"This is a test!!!!");

- fd = open("/dev/memdev0",O_RDWR);

- if(fd == -1)

- {

- printf("Error!!

");

- exit(-1);

- }

- /*创建映射*/

- start = mmap(NULL,2048,PROT_READ|PROT_WRITE,MAP_SHARED,fd,0);

- /*必须检测是否成功*/

- if(start == -1)

- {

- printf("mmap error!!!

");

- exit(-1);

- }

- strcpy(start,buf);

- printf("start = %s,buf = %s

",start,buf);

- strcpy(start,"Test is Test!!!

");

- printf("start = %s,buf = %s

",start,buf);

- /**/

- strcpy(buf,start);

- printf("start = %s,buf=%s

",start,buf);

- /*取消映射关系*/

- munmap(start,2048);

- /*关闭文件*/

- close(fd);

- exit(0);

- }

经过测试,成功得到了驱动。

Linux 内存映射函数 mmap()函数详解

mmap将一个文件或者其它对象映射进内存。文件被映射到多个页上,如果文件的大小不是所有页的大小之和,最后一个页不被使用的空间将会清零。mmap在用户空间映射调用系统中作用很大。

头文件 <sys/mman.h>

函数原型

void* mmap(void* start,size_t length,int prot,int flags,int fd,off_t offset);

int munmap(void* start,size_t length);

mmap()[1] 必须以PAGE_SIZE为单位进行映射,而内存也只能以页为单位进行映射,若要映射非PAGE_SIZE整数倍的地址范围,要先进行内存对齐,强行以PAGE_SIZE的倍数大小进行映射。

用法:

下面说一下内存映射的步骤:

用open系统调用打开文件, 并返回描述符fd.

用mmap建立内存映射, 并返回映射首地址指针start.

对映射(文件)进行各种操作, 显示(printf), 修改(sprintf).

用munmap(void *start, size_t lenght)关闭内存映射.

用close系统调用关闭文件fd.

UNIX网络编程第二卷进程间通信对mmap函数进行了说明。该函数主要用途有三个:

1、将一个普通文件映射到内存中,通常在需要对文件进行频繁读写时使用,这样用内存读写取代I/O读写,以获得较高的性能;

2、将特殊文件进行匿名内存映射,可以为关联进程提供共享内存空间;

3、为无关联的进程提供共享内存空间,一般也是将一个普通文件映射到内存中。

函数:void *mmap(void *start,size_t length,int prot,int flags,int fd,off_t offsize);

参数start:指向欲映射的内存起始地址,通常设为 NULL,代表让系统自动选定地址,映射成功后返回该地址。

参数length:代表将文件中多大的部分映射到内存。

参数prot:映射区域的保护方式。可以为以下几种方式的组合:

PROT_EXEC 映射区域可被执行

PROT_READ 映射区域可被读取

PROT_WRITE 映射区域可被写入

PROT_NONE 映射区域不能存取

参数flags:影响映射区域的各种特性。在调用mmap()时必须要指定MAP_SHARED 或MAP_PRIVATE。

MAP_FIXED 如果参数start所指的地址无法成功建立映射时,则放弃映射,不对地址做修正。通常不鼓励用此旗标。

MAP_SHARED对映射区域的写入数据会复制回文件内,而且允许其他映射该文件的进程共享。

MAP_PRIVATE 对映射区域的写入操作会产生一个映射文件的复制,即私人的“写入时复制”(copy on write)对此区域作的任何修改都不会写回原来的文件内容。

MAP_ANONYMOUS建立匿名映射。此时会忽略参数fd,不涉及文件,而且映射区域无法和其他进程共享。

MAP_DENYWRITE只允许对映射区域的写入操作,其他对文件直接写入的操作将会被拒绝。

MAP_LOCKED 将映射区域锁定住,这表示该区域不会被置换(swap)。

参数fd:要映射到内存中的文件描述符。如果使用匿名内存映射时,即flags中设置了MAP_ANONYMOUS,fd设为-1。有些系统不支持匿名内存映射,则可以使用fopen打开/dev/zero文件,然后对该文件进行映射,可以同样达到匿名内存映射的效果。

参数offset:文件映射的偏移量,通常设置为0,代表从文件最前方开始对应,offset必须是分页大小的整数倍。

返回值:

若映射成功则返回映射区的内存起始地址,否则返回MAP_FAILED(-1),错误原因存于errno 中。

错误代码:

EBADF 参数fd 不是有效的文件描述词

EACCES 存取权限有误。如果是MAP_PRIVATE 情况下文件必须可读,使用MAP_SHARED则要有PROT_WRITE以及该文件要能写入。

EINVAL 参数start、length 或offset有一个不合法。

EAGAIN 文件被锁住,或是有太多内存被锁住。

ENOMEM 内存不足。

系统调用mmap()用于共享内存的两种方式:

(1)使用普通文件提供的内存映射:

适用于任何进程之间。此时,需要打开或创建一个文件,然后再调用mmap()

典型调用代码如下:

fd=open(name, flag, mode); if(fd<0) ...

ptr=mmap(NULL, len , PROT_READ|PROT_WRITE, MAP_SHARED , fd , 0);

通过mmap()实现共享内存的通信方式有许多特点和要注意的地方,可以参看UNIX网络编程第二卷。

(2)使用特殊文件提供匿名内存映射:

适用于具有亲缘关系的进程之间。由于父子进程特殊的亲缘关系,在父进程中先调用mmap(),然后调用

fork()。那么在调用fork()之后,子进程继承父进程匿名映射后的地址空间,同样也继承mmap()返回的地址,这样,父子进程就可以通过映射区

域进行通信了。注意,这里不是一般的继承关系。一般来说,子进程单独维护从父进程继承下来的一些变量。而mmap()返回的地址,却由父子进程共同维护。

对于具有亲缘关系的进程实现共享内存最好的方式应该是采用匿名内存映射的方式。此时,不必指定具体的文件,只要设置相应的标志即可。

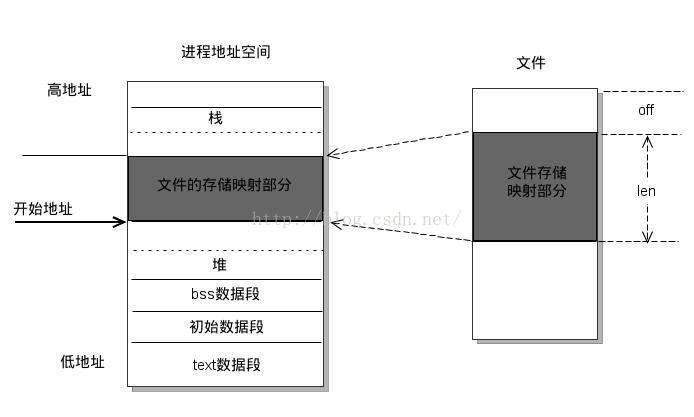

一、概述

内存映射,简而言之就是将用户空间的一段内存区域映射到内核空间,映射成功后,用户对这段内存区域的修改可以直接反映到内核空间,同样,内核空间对这段区域的修改也直接反映用户空间。那么对于内核空间<---->用户空间两者之间需要大量数据传输等操作的话效率是非常高的。

以下是一个把普遍文件映射到用户空间的内存区域的示意图。

图一:

二、基本函数

mmap函数是unix/linux下的系统调用,详细内容可参考《Unix Netword programming》卷二12.2节。

mmap系统调用并不是完全为了用于共享内存而设计的。它本身提供了不同于一般对普通文件的访问方式,进程可以像读写内存一样对普通文件的操作。而Posix或系统V的共享内存IPC则纯粹用于共享目的,当然mmap()实现共享内存也是其主要应用之一。

mmap系统调用使得进程之间通过映射同一个普通文件实现共享内存。普通文件被映射到进程地址空间后,进程可以像访问普通内存一样对文件进行访问,不必再调用read(),write()等操作。mmap并不分配空间,

只是将文件映射到调用进程的地址空间里(但是会占掉你的 virutal memory), 然后你就可以用memcpy等操作写文件,

而不用write()了.写完后,内存中的内容并不会立即更新到文件中,而是有一段时间的延迟,你可以调用msync()来显式同步一下,

这样你所写的内容就能立即保存到文件里了.这点应该和驱动相关。

不过通过mmap来写文件这种方式没办法增加文件的长度,

因为要映射的长度在调用mmap()的时候就决定了.如果想取消内存映射,可以调用munmap()来取消内存映射

- void * mmap(void *start, size_t length, int prot , int flags, int fd, off_t offset)

mmap用于把文件映射到内存空间中,简单说mmap就是把一个文件的内容在内存里面做一个映像。映射成功后,用户对这段内存区域的修改可以直接反映到内核空间,同样,内核空间对这段区域的修改也直接反映用户空间。那么对于内核空间<---->用户空间两者之间需要大量数据传输等操作的话效率是非常高的。

start:要映射到的内存区域的起始地址,通常都是用NULL(NULL即为0)。NULL表示由内核来指定该内存地址

length:要映射的内存区域的大小

prot:期望的内存保护标志,不能与文件的打开模式冲突。是以下的某个值,可以通过or运算合理地组合在一起

PROT_EXEC //页内容可以被执行

PROT_READ //页内容可以被读取

PROT_WRITE //页可以被写入

PROT_NONE //页不可访问

flags:指定映射对象的类型,映射选项和映射页是否可以共享。它的值可以是一个或者多个以下位的组合体

MAP_FIXED :使用指定的映射起始地址,如果由start和len参数指定的内存区重叠于现存的映射空间,重叠部分将会被丢弃。如果指定的起始地址不可用,操作将会失败。并且起始地址必须落在页的边界上。

MAP_SHARED :对映射区域的写入数据会复制回文件内, 而且允许其他映射该文件的进程共享。

MAP_PRIVATE :建立一个写入时拷贝的私有映射。内存区域的写入不会影响到原文件。这个标志和以上标志是互斥的,只能使用其中一个。

MAP_DENYWRITE :这个标志被忽略。

MAP_EXECUTABLE :同上

MAP_NORESERVE :不要为这个映射保留交换空间。当交换空间被保留,对映射区修改的可能会得到保证。当交换空间不被保留,同时内存不足,对映射区的修改会引起段违例信号。

MAP_LOCKED :锁定映射区的页面,从而防止页面被交换出内存。

MAP_GROWSDOWN :用于堆栈,告诉内核VM系统,映射区可以向下扩展。

MAP_ANONYMOUS :匿名映射,映射区不与任何文件关联。

MAP_ANON :MAP_ANONYMOUS的别称,不再被使用。

MAP_FILE :兼容标志,被忽略。

MAP_32BIT :将映射区放在进程地址空间的低2GB,MAP_FIXED指定时会被忽略。当前这个标志只在x86-64平台上得到支持。

MAP_POPULATE :为文件映射通过预读的方式准备好页表。随后对映射区的访问不会被页违例阻塞。

MAP_NONBLOCK :仅和MAP_POPULATE一起使用时才有意义。不执行预读,只为已存在于内存中的页面建立页表入口。

fd:文件描述符(由open函数返回)

offset:表示被映射对象(即文件)从那里开始对映,通常都是用0。 该值应该为大小为PAGE_SIZE的整数倍

返回说明

成功执行时,mmap()返回被映射区的指针,munmap()返回0。失败时,mmap()返回MAP_FAILED[其值为(void *)-1],munmap返回-1。errno被设为以下的某个值

EACCES:访问出错

EAGAIN:文件已被锁定,或者太多的内存已被锁定

EBADF:fd不是有效的文件描述词

EINVAL:一个或者多个参数无效

ENFILE:已达到系统对打开文件的限制

ENODEV:指定文件所在的文件系统不支持内存映射

ENOMEM:内存不足,或者进程已超出最大内存映射数量

EPERM:权能不足,操作不允许

ETXTBSY:已写的方式打开文件,同时指定MAP_DENYWRITE标志

SIGSEGV:试着向只读区写入

SIGBUS:试着访问不属于进程的内存区

- int munmap(void *start, size_t length)

start:要取消映射的内存区域的起始地址

length:要取消映射的内存区域的大小。

返回说明

成功执行时munmap()返回0。失败时munmap返回-1.

int msync(const void *start, size_t length, int flags);

对映射内存的内容的更改并不会立即更新到文件中,而是有一段时间的延迟,你可以调用msync()来显式同步一下, 这样你内存的更新就能立即保存到文件里

start:要进行同步的映射的内存区域的起始地址。

length:要同步的内存区域的大小

flag:flags可以为以下三个值之一:

MS_ASYNC : 请Kernel快将资料写入。

MS_SYNC : 在msync结束返回前,将资料写入。

MS_INVALIDATE : 让核心自行决定是否写入,仅在特殊状况下使用

三、用户空间和驱动程序的内存映射

3.1、基本过程

首先,驱动程序先分配好一段内存,接着用户进程通过库函数mmap()来告诉内核要将多大的内存映射到内核空间,内核经过一系列函数调用后调用对应的驱动程序的file_operation中指定的mmap函数,在该函数中调用remap_pfn_range()来建立映射关系。

3.2、映射的实现

首先在驱动程序分配一页大小的内存,然后用户进程通过mmap()将用户空间中大小也为一页的内存映射到内核空间这页内存上。映射完成后,驱动程序往这段内存写10个字节数据,用户进程将这些数据显示出来。

驱动程序:

- #include <linux/miscdevice.h>

- #include <linux/delay.h>

- #include <linux/kernel.h>

- #include <linux/module.h>

- #include <linux/init.h>

- #include <linux/mm.h>

- #include <linux/fs.h>

- #include <linux/types.h>

- #include <linux/delay.h>

- #include <linux/moduleparam.h>

- #include <linux/slab.h>

- #include <linux/errno.h>

- #include <linux/ioctl.h>

- #include <linux/cdev.h>

- #include <linux/string.h>

- #include <linux/list.h>

- #include <linux/pci.h>

- #include <linux/gpio.h>

- #define DEVICE_NAME "mymap"

- static unsigned char array[10]={0,1,2,3,4,5,6,7,8,9};

- static unsigned char *buffer;

- static int my_open(struct inode *inode, struct file *file)

- {

- return 0;

- }

- static int my_map(struct file *filp, struct vm_area_struct *vma)

- {

- unsigned long page;

- unsigned char i;

- unsigned long start = (unsigned long)vma->vm_start;

- //unsigned long end = (unsigned long)vma->vm_end;

- unsigned long size = (unsigned long)(vma->vm_end - vma->vm_start);

- //得到物理地址

- page = virt_to_phys(buffer);

- //将用户空间的一个vma虚拟内存区映射到以page开始的一段连续物理页面上

- if(remap_pfn_range(vma,start,page>>PAGE_SHIFT,size,PAGE_SHARED))//第三个参数是页帧号,由物理地址右移PAGE_SHIFT得到

- return -1;

- //往该内存写10字节数据

- for(i=0;i<10;i++)

- buffer[i] = array[i];

- return 0;

- }

- static struct file_operations dev_fops = {

- .owner = THIS_MODULE,

- .open = my_open,

- .mmap = my_map,

- };

- static struct miscdevice misc = {

- .minor = MISC_DYNAMIC_MINOR,

- .name = DEVICE_NAME,

- .fops = &dev_fops,

- };

- static int __init dev_init(void)

- {

- int ret;

- //注册混杂设备

- ret = misc_register(&misc);

- //内存分配

- buffer = (unsigned char *)kmalloc(PAGE_SIZE,GFP_KERNEL);

- //将该段内存设置为保留

- SetPageReserved(virt_to_page(buffer));

- return ret;

- }

- static void __exit dev_exit(void)

- {

- //注销设备

- misc_deregister(&misc);

- //清除保留

- ClearPageReserved(virt_to_page(buffer));

- //释放内存

- kfree(buffer);

- }

- module_init(dev_init);

- module_exit(dev_exit);

- MODULE_LICENSE("GPL");

- MODULE_AUTHOR("LKN@SCUT");

应用程序:

- #include <unistd.h>

- #include <stdio.h>

- #include <stdlib.h>

- #include <string.h>

- #include <fcntl.h>

- #include <linux/fb.h>

- #include <sys/mman.h>

- #include <sys/ioctl.h>

- #define PAGE_SIZE 4096

- int main(int argc , char *argv[])

- {

- int fd;

- int i;

- unsigned char *p_map;

- //打开设备

- fd = open("/dev/mymap",O_RDWR);

- if(fd < 0)

- {

- printf("open fail ");

- exit(1);

- }

- //内存映射

- p_map = (unsigned char *)mmap(0, PAGE_SIZE, PROT_READ | PROT_WRITE, MAP_SHARED,fd, 0);

- if(p_map == MAP_FAILED)

- {

- printf("mmap fail ");

- goto here;

- }

- //打印映射后的内存中的前10个字节内容

- for(i=0;i<10;i++)

- printf("%d ",p_map[i]);

- here:

- munmap(p_map, PAGE_SIZE);

- return 0;

- }

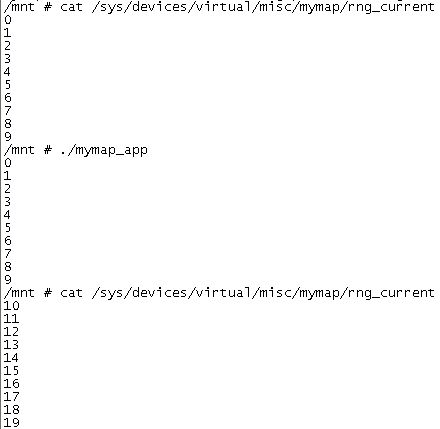

先加载驱动后执行应用程序,用户空间打印如下:

linux内存映射mmap原理分析

一直都对内存映射文件这个概念很模糊,不知道它和虚拟内存有什么区别,而且映射这个词也很让人迷茫,今天终于搞清楚了。。。下面,我先解释一下我对映射这个词的理解,再区分一下几个容易混淆的概念,之后,什么是内存映射就很明朗了。

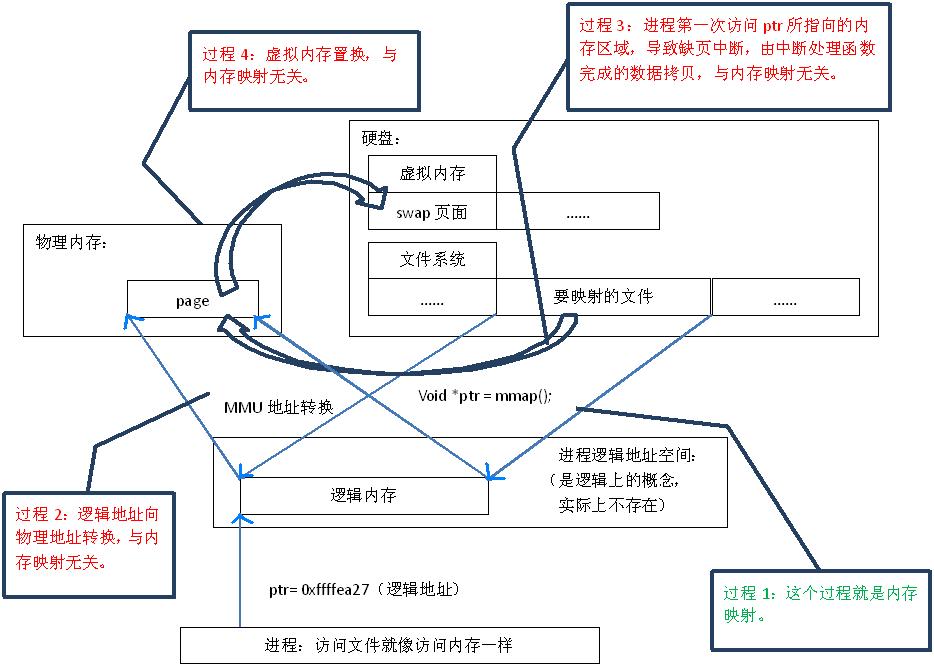

原理

首先,“映射”这个词,就和数学课上说的“一一映射”是一个意思,就是建立一种一一对应关系,在这里主要是只 硬盘上文件 的位置与进程 逻辑地址空间 中一块大小相同的区域之间的一一对应,如图1中过程1所示。这种对应关系纯属是逻辑上的概念,物理上是不存在的,原因是进程的逻辑地址空间本身就是不存在的。在内存映射的过程中,并没有实际的数据拷贝,文件没有被载入内存,只是逻辑上被放入了内存,具体到代码,就是建立并初始化了相关的数据结构(struct address_space),这个过程有系统调用mmap()实现,所以建立内存映射的效率很高。

图1.内存映射原理

既然建立内存映射没有进行实际的数据拷贝,那么进程又怎么能最终直接通过内存操作访问到硬盘上的文件呢?那就要看内存映射之后的几个相关的过程了。

mmap()会返回一个指针ptr,它指向进程逻辑地址空间中的一个地址,这样以后,进程无需再调用read或write对文件进行读写,而只需要通过ptr就能够操作文件。但是ptr所指向的是一个逻辑地址,要操作其中的数据,必须通过MMU将逻辑地址转换成物理地址,如图1中过程2所示。这个过程与内存映射无关。

前面讲过,建立内存映射并没有实际拷贝数据,这时,MMU在地址映射表中是无法找到与ptr相对应的物理地址的,也就是MMU失败,将产生一个缺页中断,缺页中断的中断响应函数会在swap中寻找相对应的页面,如果找不到(也就是该文件从来没有被读入内存的情况),则会通过mmap()建立的映射关系,从硬盘上将文件读取到物理内存中,如图1中过程3所示。这个过程与内存映射无关。

如果在拷贝数据时,发现物理内存不够用,则会通过虚拟内存机制(swap)将暂时不用的物理页面交换到硬盘上,如图1中过程4所示。这个过程也与内存映射无关。

效率

从代码层面上看,从硬盘上将文件读入内存,都要经过文件系统进行数据拷贝,并且数据拷贝操作是由文件系统和硬件驱动实现的,理论上来说,拷贝数据的效率是一样的。但是通过内存映射的方法访问硬盘上的文件,效率要比read和write系统调用高,这是为什么呢?原因是read()是系统调用,其中进行了数据拷贝,它首先将文件内容从硬盘拷贝到内核空间的一个缓冲区,如图2中过程1,然后再将这些数据拷贝到用户空间,如图2中过程2,在这个过程中,实际上完成了 两次数据拷贝 ;而mmap()也是系统调用,如前所述,mmap()中没有进行数据拷贝,真正的数据拷贝是在缺页中断处理时进行的,由于mmap()将文件直接映射到用户空间,所以中断处理函数根据这个映射关系,直接将文件从硬盘拷贝到用户空间,只进行了 一次数据拷贝 。因此,内存映射的效率要比read/write效率高。

图2.read系统调用原理

下面这个程序,通过read和mmap两种方法分别对硬盘上一个名为“mmap_test”的文件进行操作,文件中存有10000个整数,程序两次使用不同的方法将它们读出,加1,再写回硬盘。通过对比可以看出,read消耗的时间将近是mmap的两到三倍。

- #include<unistd.h>

- #include<stdio.h>

- #include<stdlib.h>

- #include<string.h>

- #include<sys/types.h>

- #include<sys/stat.h>

- #include<sys/time.h>

- #include<fcntl.h>

- #include<sys/mman.h>

- #define MAX 10000

- int main()

- {

- int i=0;

- int count=0, fd=0;

- struct timeval tv1, tv2;

- int *array = (int *)malloc( sizeof(int)*MAX );

- /*read*/

- gettimeofday( &tv1, NULL );

- fd = open( "mmap_test", O_RDWR );

- if( sizeof(int)*MAX != read( fd, (void *)array, sizeof(int)*MAX ) )

- {

- printf( "Reading data failed.../n" );

- return -1;

- }

- for( i=0; i<MAX; ++i )

- ++array[ i ];

- if( sizeof(int)*MAX != write( fd, (void *)array, sizeof(int)*MAX ) )

- {

- printf( "Writing data failed.../n" );

- return -1;

- }

- free( array );

- close( fd );

- gettimeofday( &tv2, NULL );

- printf( "Time of read/write: %dms/n", tv2.tv_usec-tv1.tv_usec );

- /*mmap*/

- gettimeofday( &tv1, NULL );

- fd = open( "mmap_test", O_RDWR );

- array = mmap( NULL, sizeof(int)*MAX, PROT_READ|PROT_WRITE, MAP_SHARED, fd, 0 );

- for( i=0; i<MAX; ++i )

- ++array[ i ];

- munmap( array, sizeof(int)*MAX );

- msync( array, sizeof(int)*MAX, MS_SYNC );

- free( array );

- close( fd );

- gettimeofday( &tv2, NULL );

- printf( "Time of mmap: %dms/n", tv2.tv_usec-tv1.tv_usec );

- return 0;

- }

输出结果:

Time of read/write: 154ms

Time of mmap: 68ms

Linux的mmap内存映射机制解析

在讲述文件映射的概念时,不可避免的要牵涉到虚存(SVR 4的VM).实际上,文件映射是虚存的中心概念, 文件映射一方面给用户提供了一组措施,好似用户将文件映射到自己地址空间的某个部分,使用简单的内存访问指令读写文件;另一方面,它也可以用于内核的基本组织模式,在这种模式种,内核将整个地址空间视为诸如文件之类的一组不同对象的映射.中的传统文件访问方式是,首先用open系统调用打开文件,然后使用read, write以及lseek等调用进行顺序或者随即的I/O.这种方式是非常低效的,每一次I/O操作都需要一次系统调用.另外,如果若干个进程访问同一个文件,每个进程都要在自己的地址空间维护一个副本,浪费了内存空间.而如果能够通过一定的机制将页面映射到进程的地址空间中,也就是说首先通过简单的产生某些内存管理数据结构完成映射的创建.当进程访问页面时产生一个缺页中断,内核将页面读入内存并且更新页表指向该页面.而且这种方式非常方便于同一副本的共享.

VM是面向对象的方法设计的,这里的对象是指内存对象:内存对象是一个软件抽象的概念,它描述内存区与后备存储之间的映射.系统可以使用多种类型的后备存储,比如交换空间,本地或者远程文件以及帧缓存等等. VM系统对它们统一处理,采用同一操作集操作,比如读取页面或者回写页面等.每种不同的后备存储都可以用不同的方法实现这些操作.这样,系统定义了一套统一的接口,每种后备存储给出自己的实现方法.这样,进程的地址空间就被视为一组映射到不同数据对象上的的映射组成.所有的有效地址就是那些映射到数据对象上的地址.这些对象为映射它的页面提供了持久性的后备存储.映射使得用户可以直接寻址这些对象.

值得提出的是, VM体系结构独立于Unix系统,所有的Unix系统语义,如正文,数据及堆栈区都可以建构在基本VM系统之上.同时, VM体系结构也是独立于存储管理的,存储管理是由操作系统实施的,如:究竟采取什么样的对换和请求调页算法,究竟是采取分段还是分页机制进行存储管理,究竟是如何将虚拟地址转换成为物理地址等等(Linux中是一种叫Three Level Page Table的机制),这些都与内存对象的概念无关.

一、Linux中VM的实现.

一个进程应该包括一个mm_struct(memory manage struct), 该结构是进程虚拟地址空间的抽象描述,里面包括了进程虚拟空间的一些管理信息: start_code, end_code, start_data, end_data, start_brk, end_brk等等信息.另外,也有一个指向进程虚存区表(vm_area_struct: virtual memory area)的指针,该链是按照虚拟地址的增长顺序排列的.在Linux进程的地址空间被分作许多区(vma),每个区(vma)都对应虚拟地址空间上一段连续的区域, vma是可以被共享和保护的独立实体,这里的vma就是前面提到的内存对象.

下面是vm_area_struct的结构,其中,前半部分是公共的,与类型无关的一些数据成员,如:指向mm_struct的指针,地址范围等等,后半部分则是与类型相关的成员,其中最重要的是一个指向vm_operation_struct向量表的指针vm_ops, vm_pos向量表是一组虚函数,定义了与vma类型无关的接口.每一个特定的子类,即每种vma类型都必须在向量表中实现这些操作.这里包括了: open, close, unmap, protect, sync, nopage, wppage, swapout这些操作.

- struct vm_area_struct {

- /*公共的, 与vma类型无关的 */

- struct mm_struct * vm_mm;

- unsigned long vm_start;

- unsigned long vm_end;

- struct vm_area_struct *vm_next;

- pgprot_t vm_page_prot;

- unsigned long vm_flags;

- short vm_avl_height;

- struct vm_area_struct * vm_avl_left;

- struct vm_area_struct * vm_avl_right;

- struct vm_area_struct *vm_next_share;

- struct vm_area_struct **vm_pprev_share;

- /* 与类型相关的 */

- struct vm_operations_struct * vm_ops;

- unsigned long vm_pgoff;

- struct file * vm_file;

- unsigned long vm_raend;

- void * vm_private_data;

- };

vm_ops: open, close, no_page, swapin, swapout……

二、驱动中的mmap()函数解析

设备驱动的mmap实现主要是将一个物理设备的可操作区域(设备空间)映射到一个进程的虚拟地址空间。这样就可以直接采用指针的方式像访问内存的方式访问设备。在驱动中的mmap实现主要是完成一件事,就是实际物理设备的操作区域到进程虚拟空间地址的映射过程。同时也需要保证这段映射的虚拟存储器区域不会被进程当做一般的空间使用,因此需要添加一系列的保护方式。

- /*主要是建立虚拟地址到物理地址的页表关系,其他的过程又内核自己完成*/

- static int mem_mmap(struct file* filp,struct vm_area_struct *vma)

- {

- /*间接的控制设备*/

- struct mem_dev *dev = filp->private_data;

- /*标记这段虚拟内存映射为IO区域,并阻止系统将该区域包含在进程的存放转存中*/

- vma->vm_flags |= VM_IO;

- /*标记这段区域不能被换出*/

- vma->vm_flags |= VM_RESERVED;

- /**/

- if(remap_pfn_range(vma,/*虚拟内存区域*/

- vma->vm_start, /*虚拟地址的起始地址*/

- virt_to_phys(dev->data)>>PAGE_SHIFT, /*物理存储区的物理页号*/

- dev->size, /*映射区域大小*/

- vma->vm_page_prot /*虚拟区域保护属性*/

- ))

- return -EAGAIN;

- return 0;

- }

具体的实现分析如下:

vma->vm_flags |= VM_IO;

vma->vm_flags |= VM_RESERVED;

上面的两个保护机制就说明了被映射的这段区域具有映射IO的相似性,同时保证这段区域不能随便的换出。就是建立一个物理页与虚拟页之间的关联性。具体原理是虚拟页和物理页之间是以页表的方式关联起来,虚拟内存通常大于物理内存,在使用过程中虚拟页通过页表关联一切对应的物理页,当物理页不够时,会选择性的牺牲一些页,也就是将物理页与虚拟页之间切断,重现关联其他的虚拟页,保证物理内存够用。在设备驱动中应该具体的虚拟页和物理页之间的关系应该是长期的,应该保护起来,不能随便被别的虚拟页所替换。具体也可参看关于虚拟存储器的文章。

接下来就是建立物理页与虚拟页之间的关系,即采用函数remap_pfn_range(),具体的参数如下:

int remap_pfn_range(structvm_area_struct *vma, unsigned long addr,unsigned long pfn, unsigned long size, pgprot_t prot)

1、struct vm_area_struct是一个虚拟内存区域结构体,表示虚拟存储器中的一个内存区域。其中的元素vm_start是指虚拟存储器中的起始地址。

2、addr也就是虚拟存储器中的起始地址,通常可以选择addr = vma->vm_start。

3、pfn是指物理存储器的具体页号,通常通过物理地址得到对应的物理页号,具体采用virt_to_phys(dev->data)>>PAGE_SHIFT.首先将虚拟内存转换到物理内存,然后得到页号。>>PAGE_SHIFT通常为12,这是因为每一页的大小刚好是4K,这样右移12相当于除以4096,得到页号。

4、size区域大小

5、区域保护机制。

返回值,如果成功返回0,否则正数。

三、系统调用mmap函数解析

介绍完VM的基本概念后,我们可以讲述mmap和munmap系统调用了.mmap调用实际上就是一个内存对象vma的创建过程,

1、mmap函数

Linux提供了内存映射函数mmap,它把文件内容映射到一段内存上(准确说是虚拟内存上),通过对这段内存的读取和修改,实现对文件的读取和修改 。普通文件被映射到进程地址空间后,进程可以向访问普通内存一样对文件进行访问,不必再调用read(),write()等操作。

先来看一下mmap的函数声明:

- 头文件:

- <unistd.h>

- <sys/mman.h>

- 原型: void *mmap(void *addr, size_t length, int prot, int flags, int fd, off_t offsize);

- /*

- 返回值: 成功则返回映射区起始地址, 失败则返回MAP_FAILED(-1).

- 参数:

- addr: 指定映射的起始地址, 通常设为NULL, 由系统指定.

- length: 将文件的多大长度映射到内存.

- prot: 映射区的保护方式, 可以是:

- PROT_EXEC: 映射区可被执行.

- PROT_READ: 映射区可被读取.

- PROT_WRITE: 映射区可被写入.

- PROT_NONE: 映射区不能存取.

- flags: 映射区的特性, 可以是:

- MAP_SHARED: 对映射区域的写入数据会复制回文件, 且允许其他映射该文件的进程共享.

- MAP_PRIVATE: 对映射区域的写入操作会产生一个映射的复制(copy-on-write), 对此区域所做的修改不会写回原文件.

- 此外还有其他几个flags不很常用, 具体查看linux C函数说明.

- fd: 由open返回的文件描述符, 代表要映射的文件.

- offset: 以文件开始处的偏移量, 必须是分页大小的整数倍, 通常为0, 表示从文件头开始映射.

- */

mmap的作用是映射文件描述符fd指定文件的 [off,off + len]区域至调用进程的[addr, addr + len]的内存区域, 如下图所示:

mmap系统调用的实现过程是

1.先通过文件系统定位要映射的文件;

2.权限检查,映射的权限不会超过文件打开的方式,也就是说如果文件是以只读方式打开,那么则不允许建立一个可写映射;

3.创建一个vma对象,并对之进行初始化;

4.调用映射文件的mmap函数,其主要工作是给vm_ops向量表赋值;

5.把该vma链入该进程的vma链表中,如果可以和前后的vma合并则合并;

6.如果是要求VM_LOCKED(映射区不被换出)方式映射,则发出缺页请求,把映射页面读入内存中.

2、munmap函数

munmap(void * start, size_t length):

该调用可以看作是mmap的一个逆过程.它将进程中从start开始length长度的一段区域的映射关闭,如果该区域不是恰好对应一个vma,则有可能会分割几个或几个vma.

msync(void * start, size_t length, int flags):

把映射区域的修改回写到后备存储中.因为munmap时并不保证页面回写,如果不调用msync,那么有可能在munmap后丢失对映射区的修改.其中flags可以是MS_SYNC, MS_ASYNC, MS_INVALIDATE, MS_SYNC要求回写完成后才返回, MS_ASYNC发出回写请求后立即返回, MS_INVALIDATE使用回写的内容更新该文件的其它映射.该系统调用是通过调用映射文件的sync函数来完成工作的.

brk(void * end_data_segement):

将进程的数据段扩展到end_data_segement指定的地址,该系统调用和mmap的实现方式十分相似,同样是产生一个vma,然后指定其属性.不过在此之前需要做一些合法性检查,比如该地址是否大于mm->end_code, end_data_segement和mm->brk之间是否还存在其它vma等等.通过brk产生的vma映射的文件为空,这和匿名映射产生的vma相似,关于匿名映射不做进一步介绍.库函数malloc就是通过brk实现的.

四、实例解析

下面这个例子显示了把文件映射到内存的方法,源代码是:

- /************关于本文 档********************************************

- *filename: mmap.c

- *purpose: 说明调用mmap把文件映射到内存的方法

- *wrote by: zhoulifa(zhoulifa@163.com) 周立发(http://zhoulifa.bokee.com)

- Linux爱好者 Linux知识传播者 SOHO族 开发者 最擅长C语言

- *date time:2008-01-27 18:59 上海大雪天,据说是多年不遇

- *Note: 任何人可以任意复制代码并运用这些文档,当然包括你的商业用途

- * 但请遵循GPL

- *Thanks to:

- * Ubuntu 本程序在Ubuntu 7.10系统上测试完全正常

- * Google.com 我通常通过google搜索发现许多有用的资料

- *Hope:希望越来越多的人贡献自己的力量,为科学技术发展出力

- * 科技站在巨人的肩膀上进步更快!感谢有开源前辈的贡献!

- *********************************************************************/

- #include <sys/mman.h> /* for mmap and munmap */

- #include <sys/types.h> /* for open */

- #include <sys/stat.h> /* for open */

- #include <fcntl.h> /* for open */

- #include <unistd.h> /* for lseek and write */

- #include <stdio.h>

- int main(int argc, char **argv)

- {

- int fd;

- char *mapped_mem, * p;

- int flength = 1024;

- void * start_addr = 0;

- fd = open(argv[1], O_RDWR | O_CREAT, S_IRUSR | S_IWUSR);

- flength = lseek(fd, 1, SEEK_END);

- write(fd, "�", 1); /* 在文件最后添加一个空字符,以便下面printf正常工作 */

- lseek(fd, 0, SEEK_SET);

- mapped_mem = mmap(start_addr, flength, PROT_READ, //允许读

- MAP_PRIVATE, //不允许其它进程访问此内存区域

- fd, 0);

- /* 使用映射区域. */

- printf("%s ", mapped_mem); /* 为了保证这里工作正常,参数传递的文件名最好是一个文本文件 */

- close(fd);

- munmap(mapped_mem, flength);

- return 0;

- }

编译运行此程序:

gcc -Wall mmap.c

./a.out text_filename

上面的方法因为用了PROT_READ,所以只能读取文件里的内容,不能修改,如果换成PROT_WRITE就可以修改文件的内容了。又由于 用了MAAP_PRIVATE所以只能此进程使用此内存区域,如果换成MAP_SHARED,则可以被其它进程访问,比如下面的

- #include <sys/mman.h> /* for mmap and munmap */

- #include <sys/types.h> /* for open */

- #include <sys/stat.h> /* for open */

- #include <fcntl.h> /* for open */

- #include <unistd.h> /* for lseek and write */

- #include <stdio.h>

- #include <string.h> /* for memcpy */

- int main(int argc, char **argv)

- {

- int fd;

- char *mapped_mem, * p;

- int flength = 1024;

- void * start_addr = 0;

- fd = open(argv[1], O_RDWR | O_CREAT, S_IRUSR | S_IWUSR);

- flength = lseek(fd, 1, SEEK_END);

- write(fd, "�", 1); /* 在文件最后添加一个空字符,以便下面printf正常工作 */

- lseek(fd, 0, SEEK_SET);

- start_addr = 0x80000;

- mapped_mem = mmap(start_addr, flength, PROT_READ|PROT_WRITE, //允许写入

- MAP_SHARED, //允许其它进程访问此内存区域

- fd, 0);

- * 使用映射区域. */

- printf("%s ", mapped_mem); /* 为了保证这里工作正常,参数传递的文件名最好是一个文本文 */

- while((p = strstr(mapped_mem, "Hello"))) { /* 此处来修改文件 内容 */

- memcpy(p, "Linux", 5);

- p += 5;

- }

- close(fd);

- munmap(mapped_mem, flength);

- return 0;

- }

五、mmap和共享内存对比

共享内存允许两个或多个进程共享一给定的存储区,因为数据不需要来回复制,所以是最快的一种进程间通信机制。共享内存可以通过mmap()映射普通文件(特殊情况下还可以采用匿名映射)机制实现,也可以通过系统V共享内存机制实现。应用接口和原理很简单,内部机制复杂。为了实现更安全通信,往往还与信号灯等同步机制共同使用。

对比如下:

mmap机制:就是在磁盘上建立一个文件,每个进程存储器里面,单独开辟一个空间来进行映射。如果多进程的话,那么不会对实际的物理存储器(主存)消耗太大。

shm机制:每个进程的共享内存都直接映射到实际物理存储器里面。

1、mmap保存到实际硬盘,实际存储并没有反映到主存上。优点:储存量可以很大(多于主存);缺点:进程间读取和写入速度要比主存的要慢。

2、shm保存到物理存储器(主存),实际的储存量直接反映到主存上。优点,进程间访问速度(读写)比磁盘要快;缺点,储存量不能非常大(多于主存)

使用上看:如果分配的存储量不大,那么使用shm;如果存储量大,那么使用mmap。

mmap - 用户空间与内核空间

mmap概述

共享内存可以说是最有用的进程间通信方式,也是最快的IPC形式, 因为进程可以直接读写内存,而不需要任何数据的拷贝。对于像管道和消息队列等通信方式,则需要在内核和用户空间进行四次的数据拷贝,而共享内存则只拷贝两次数据: 一次从输入文件到共享内存区,另一次从共享内存区到输出文件。实际上,进程之间在共享内存时,并不总是读写少量数据后就解除映射,有新的通信时,再重新建立共享内存区域。而是保持共享区域,直到通信完毕为止,这样,数据内容一直保存在共享内存中,并没有写回文件。共享内存中的内容往往是在解除映射时才写回文件的。因此,采用共享内存的通信方式效率是非常高的。

传统文件访问

UNIX访问文件的传统方法是用open打开它们, 如果有多个进程访问同一个文件,

则每一个进程在自己的地址空间都包含有该文件的副本,这不必要地浪费了存储空间. 下图说明了两个进程同时读一个文件的同一页的情形.

系统要将该页从磁盘读到高速缓冲区中, 每个进程再执行一个存储器内的复制操作将数据从高速缓冲区读到自己的地址空间.

共享存储映射

现在考虑另一种处理方法: 进程A和进程B都将该页映射到自己的地址空间, 当进程A第一次访问该页中的数据时, 它生成一个缺页中断.

内核此时读入这一页到内存并更新页表使之指向它.以后, 当进程B访问同一页面而出现缺页中断时, 该页已经在内存,

内核只需要将进程B的页表登记项指向次页即可. 如下图所示:

mmap系统调用使得进程之间通过映射同一个普通文件实现共享内存,普通文件被映射到进程地址空间后,进程可以像访问普通内存一样对文件进行访问,不必再调用read和write等。

mmap用户空间

用户空间mmap函数原型

头文件 sys/mman.h

void *mmap(void *start, size_t length, int prot, int flags, int fd, off_t offset);

int munmap(void *start, size_t length);

int msync ( void * addr , size_t len, int flags) 通过调用msync()实现磁盘上文件内容与共享内存区的内容一致

作用:

mmap将一个文件或者其他对象映射进内存,当文件映射到进程后,就可以直接操作这段虚拟地址进行文件的读写等操作。

参数说明:

start:映射区的开始地址

length:映射区的长度

prot:期望的内存保护标志

—-PROT_EXEC //页内容可以被执行

—-PROT_READ //页内容可以被读取

—-PROT_WRITE //页可以被写入

—-PROT_NONE //页不可访问

flags:指定映射对象的类型

—-MAP_FIXED

—-MAP_SHARED 与其它所有映射这个对象的进程共享映射空间

—-MAP_PRIVATE 建立一个写入时拷贝的私有映射。内存区域的写入不会影响到原文件

—-MAP_ANONYMOUS 匿名映射,映射区不与任何文件关联

fd:如果MAP_ANONYMOUS被设定,为了兼容问题,其值应为-1

offset:被映射对象内容的起点

通过共享映射的方式修改文件

系统调用mmap可以将文件映射至内存(进程空间),如此可以把对文件的操作转为对内存的操作,以此避免更多的lseek()、read()、write()等系统调用,这点对于大文件或者频繁访问的文件尤其有用,提高了I/O效率。

下面例子中测试所需的data.txt文件内容如下:

aaaaaaaaa

bbbbbbbbb

ccccccccc

ddddddddd/*

* mmap file to memory

* ./mmap1 data.txt

*/

#include <stdio.h>

#include <sys/stat.h>

#include <sys/mman.h>

#include <fcntl.h>

#include <stdlib.h>

int main(int argc, char *argv[])

{

int fd = -1;

struct stat sb;

char *mmaped = NULL;

fd = open(argv[1], O_RDWR);

if (fd < 0) {

fprintf(stderr, "open %s fail

", argv[1]);

exit(-1);

}

if (stat(argv[1], &sb) < 0) {

fprintf(stderr, "stat %s fail

", argv[1]);

goto err;

}

/* 将文件映射至进程的地址空间 */

mmaped = (char *)mmap(NULL, sb.st_size, PROT_READ | PROT_WRITE, MAP_SHARED, fd, 0);

if (mmaped == (char *)-1) {

fprintf(stderr, "mmap fail

");

goto err;

}

/* 映射完后, 关闭文件也可以操纵内存 */

close(fd);

printf("%s", mmaped);

mmaped[5] = '$';

if (msync(mmaped, sb.st_size, MS_SYNC) < 0) {

fprintf(stderr, "msync fail

");

goto err;

}

return 0;

err:

if (fd > 0)

close(fd);

if (mmaped != (char *)-1)

munmap(mmaped, sb.st_size);

return -1;

}通过共享映射实现两个进程之间的通信

两个程序映射同一个文件到自己的地址空间, 进程A先运行, 每隔两秒读取映射区域, 看是否发生变化.

进程B后运行, 它修改映射区域, 然后推出, 此时进程A能够观察到存储映射区的变化

进程A的代码:

#include <sys/mman.h>

#include <sys/stat.h>

#include <fcntl.h>

#include <stdio.h>

#include <stdlib.h>

#include <unistd.h>

#include <error.h>

#define BUF_SIZE 100

int main(int argc, char **argv)