MMoE模型(Multi-gate Mixture-of-Experts)

-

模型原始论文

Modeling Task Relationships in Multi-task Learning with Multi-gate Mixture-of-Experts -

模型架构

-

模型原理 。

-

模型特点

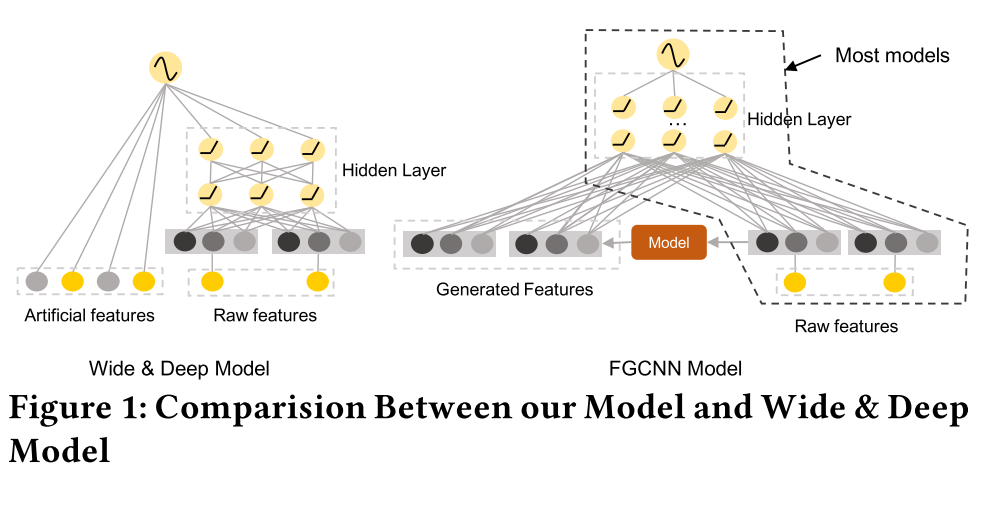

基于神经网络的多任务学习本质上就是在多个任务之间加一个共享表示层,从数学上可以证明这个共享表示层可以起到正则化的效果,提高模型的泛化能力,最简单的共享层就是如上图(a)所示。本文是提出一个多层共享表示层的模型,如上图(b),MoE(Mixed of Experts),也就是在多个任务之间学习多个共享层,然后mixture起来。在mixture的时候可以加上单gate和多gate的学习机制。 -

模型案例

drawbridge/keras-mmoe

一网打尽Google、Amazon、Microsoft、Facebook在2018年KDD上的论文:神经网络、大规模计算是热点

论文笔记:Multi-task Learning with MMoE

YouTube视频简析

FGCNN模型(Feature Generation by Convolutional Neural Network)

-

模型原始论文

Feature Generation by Convolutional Neural Network for Click-Through Rate Prediction -

模型架构

-

模型原理

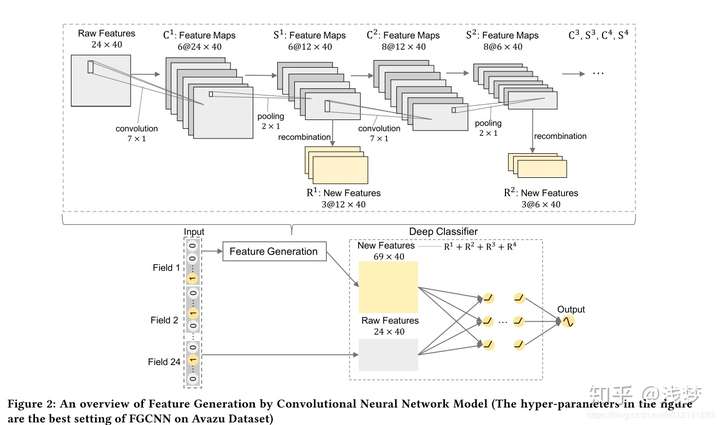

1.分组嵌入:原始特征既要作为后续模型的输入,又要作为FGCNN模块的输入,所以原始特征的embedding向量和FGCNN的embedding向量分开训练,以避免梯度耦合的问题。

2.卷积层和池化层

3.重组层:将池化后的Feature Maps(图2中Si)展平成一个向量,然后使用单层的神经网络进行特征组合,输出维度R^i受超参数控制

4.拼接层:将重组后生成的特征拼接上原始的特征作为新的输入 -

模型特点

- 使用重组层进行特征生成缓解了CCPM中CNN无法有效捕获全局组合特征的问题

- FGCNN作为一种特征生成方法,可以和任意模型进行组合

-

模型案例

DeepCTR/deepctr/models/fgcnn.py

CCPM&FGCNN:使用CNN进行特征生成的CTR预测模型