《Salient Object Detection: A Survey》作者:Ali Borji、Ming-Ming Cheng、Huaizu Jiang and Jia Li

基本按照文章中文献出现的顺序。

一、L. Itti, C. Koch, and E. Niebur, “A model of saliency-based visual attention for rapid scene analysis,” IEEE TPAMI, 1998.

一个用于快速场景分析的基于显著性的视觉注意模型【1】。目前(2018-07-06),这篇short paper被引量9000+,有点吓人O(∩_∩)O哈哈~

这是一个早期的显著性检测模型,它首次通过认知心理学(psychology)、神经科学、计算机视觉等多学科,掀起了第一波浪潮。这个模型是一个基于中心包围(center-surrounded)机制的自底向上的通用计算框架和心理学方法的较早期的实现。这篇文章展示了一个可以检测场景中空间不连续性的检测模型。

论文的提出主要是受到灵长类动物早期视觉系统的神经结构和行为所启发而产生了视觉注意系统。灵长类动物具有很强的实时处理复杂场景的能力,视觉信息进行深入的处理之前,对所收集到的感觉信息进行选择,这些选择可能减少场景理解的复杂性,这个选择过程在一个空间有限的视野区域即所谓的注意焦点(focus of attention, FOA)中完成,它搜索场景的方式可以是快速、自下而上(bottom-up,BU)、显著驱动和任务独立的方式,也可以是慢速、自上而下(top-down,TD)、意志控制和任务相关的方式。注意模型包括“动态路由”模型,在此模型中,通过皮层视觉继承,从一个小的视野区域中得到的信息可以不断前行。通过皮层连接的动态修正或在TD和BU的控制下对活跃区建立特定的瞬时模式,来选择注意区域。

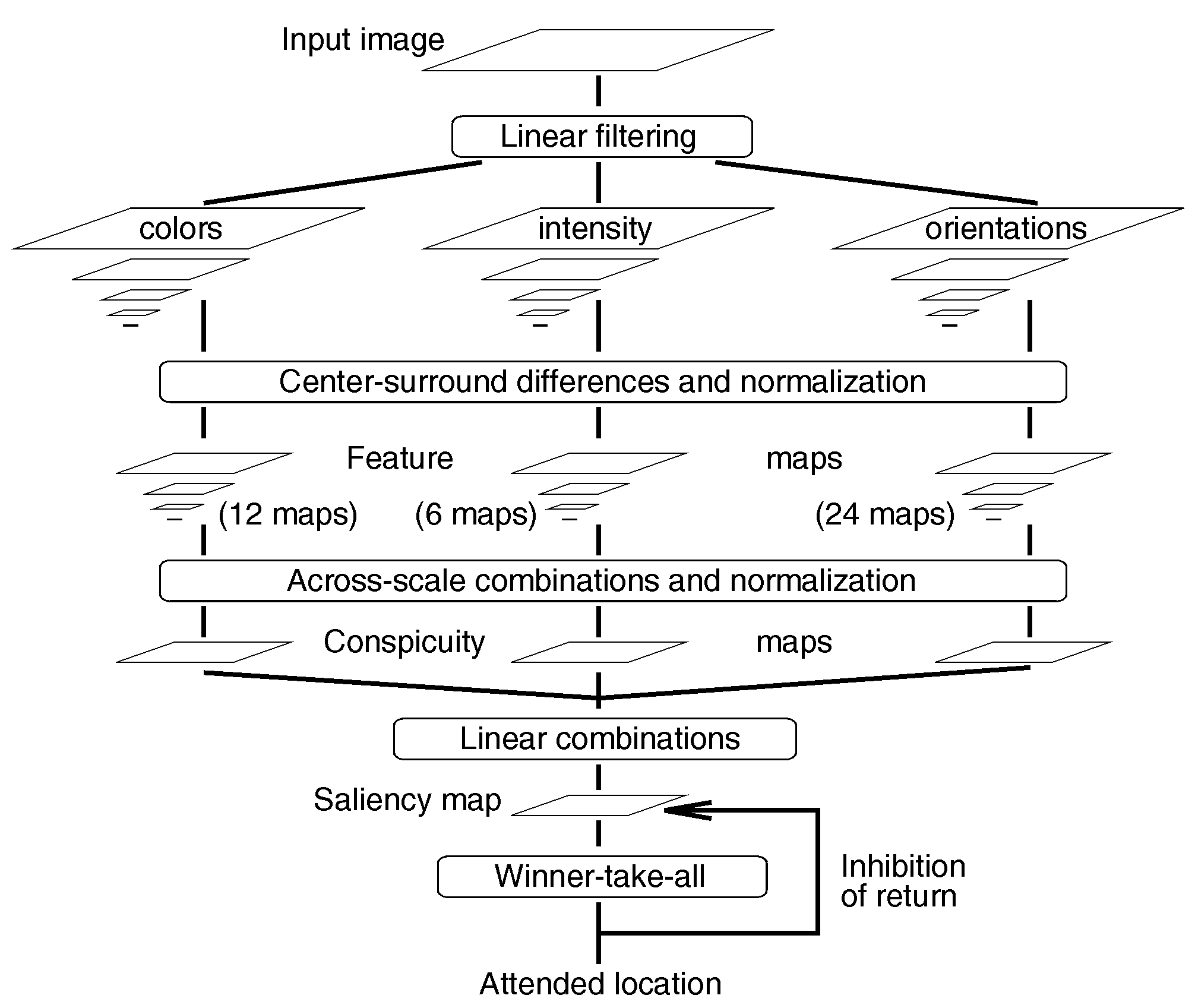

这篇文章所使用的模型建立在由Koch和Ullman所提出的生物模型和其他几个模型。它和所谓的特征整合模型相关,解释了人类视觉搜索策略。视觉输入首先被分为一系列特征地形图。然后在每个图中,不同的空间位置通过竞争获取显著性,只有从周围脱颖而出的位置才能保留。所有的特征图以纯粹的BU方式输入到高级的显著性图,它对整个视觉场景的局部醒目度进行地形编码。在灵长类动物中,人们相信这种图存在于后顶叶皮层(posterior parietal cortex)中,同时也存在于枕核丘脑(pulvinar nuclei ofthalamus)中。模型的显著性图被认为是产生注意转移的内部动力。因此这个模型表示了BU显著性可以引导注意转移,不需要TD。这个模型可以进行并行处理,提高运算速度,而且可以根据特征的重要性,为特征加上权值,特征越重要,权值越大。

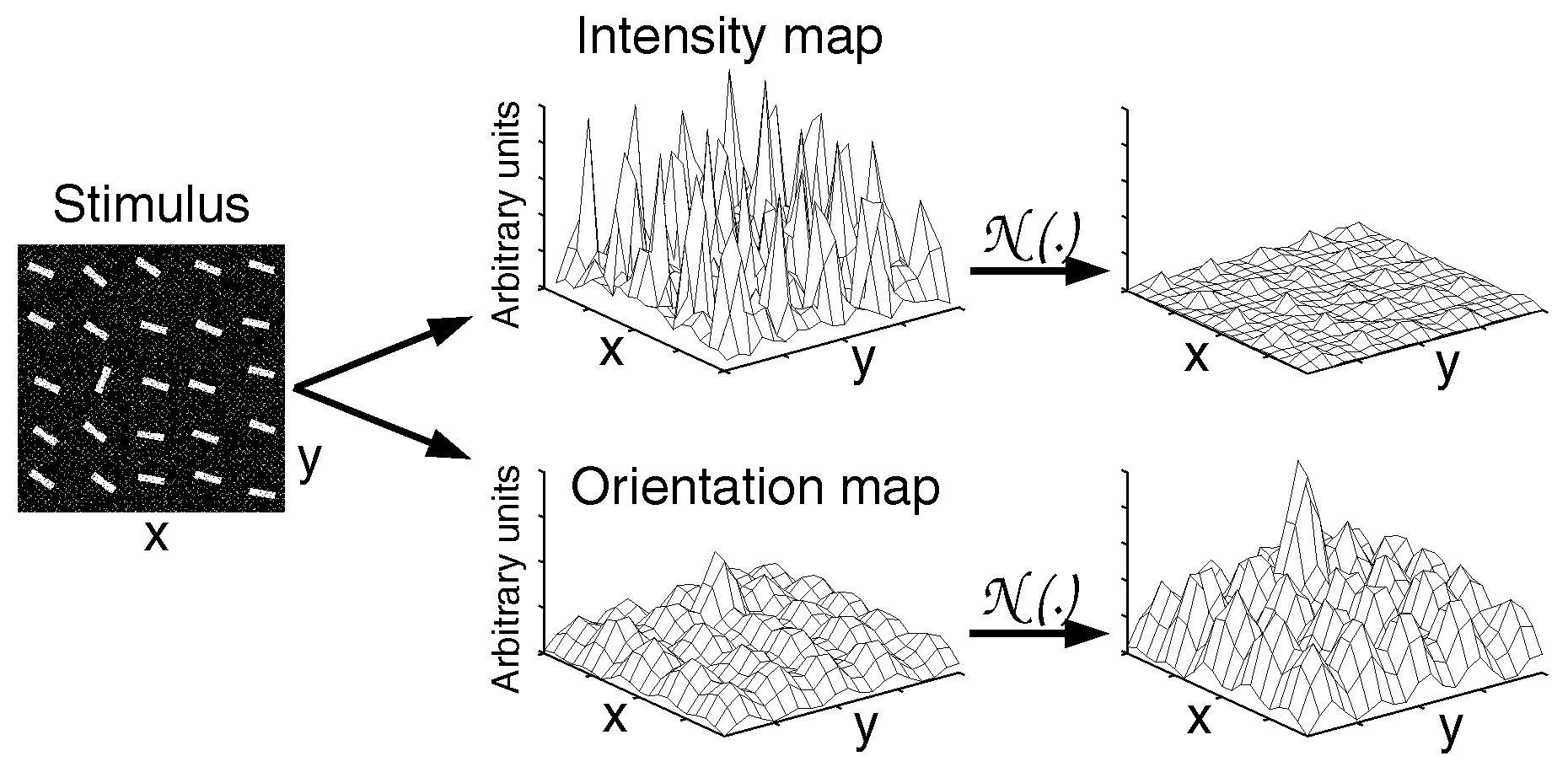

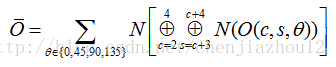

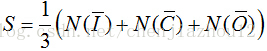

上图为整个模型的结构图,首先输入一张彩色图片,采用高斯金字塔对该图片进行下采样,生成9张尺度图,其中尺度0表示该尺度图像与原图像的像素面积比例是1:1,尺度8表示该尺度图像与源图像面积为1:256。“Center-surround” difference operations,即中央周边差操作,是根据人眼生理结构设计的。人眼感受野对于视觉信息输入中反差大的特征反应强烈,例如中央亮周边暗的情况、中央是绿色周边是红色的情况等,这都属于反差较大的视觉信息。在高斯金字塔中,尺度较大的图像细节信息较多,而尺度较小的图像由于高斯平滑和减抽样操作使得其更能反映出局部的图像背景信息,因而将尺度较大的图像和尺度较小的图像进行跨尺度减操作(across-scale),能得到局部中心和周边背景信息的反差信息。跨尺度减的具体算法如下:通过将代表周边背景信息的较小尺度的图像进行线性插值,使之与代表中心信息的较大尺度的图像具有相同大小,然后进行点对点的减操作,即中央周边差操作,这样的跨尺度减操作使用符号Θ表示。对每个特征通道的高斯金字塔进行中央周边差操作,依次检测图像中的特征不联系性,即中心和周边背景信息反差对比强烈的区域,很好地模仿了视网膜上探测突出目标的生理机制。在模型中,代表中心信息的图像尺度c取c∈{2,3,4},代表周边背景信息的图像尺度s取s=c+δ,其中δ∈{3,4},从而在每个特征通道里可以产生6个尺度对,即{2-5,2-6,3-6,3-7,4-7,4-8},在每个特征通道可以产生6张中央周边差结果图,所以7个通道共有42张中央周边差图,中央周边差结果图在该模型中被称为特征图(Feature Map)。

早期视觉特征提取

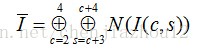

①、亮度提取,用r,g,b分别表示图像红、绿、蓝三个通道的值,因此亮度I可以表示为I=(r+g+b)/3,由于输入图片是9个尺度的高斯金字塔图片,所以I也对应于9个尺度高斯金子塔亮度图。

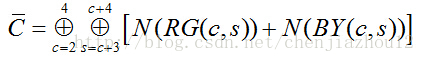

②、颜色提取,r,g,b通道采用I进行归一化以从亮度中解耦色调。产生了四个宽调谐(broadly-tuned)的颜色通道,从这些颜色通道中产生四个高斯金字塔R,G,B,Y。

R=r-(g+b)/2,G=g-(r+b)/2,B=b-(r+g)/2,Y=(r+g)/2-|r-g|/2-b,如果为负数则设为0。

③、方向特征,方向特征主要是使用Gabor滤波器对图像的亮度特征在0°,45°,90°,135°四个主要方向上进行滤波得到的。因此,Gabor滤波器可以很好地模拟人类视皮层简单细胞的信号处理特点,其结果直接体现了图像局部方向特征的信息。在Gabor滤波器某个方向的滤波结果中,给定区域的能量可以反映该区域灰度图在该方向的特征是否强烈,即反映了区域内的该方向的直线或者规则纹理的朝向特征是否明显。因此方向特征的提取可以直接使用几个方向的Gabor滤波器进行滤波获得。

I(c,s)=|I(c)ΘI(s)| c∈(2,3,4),s=s+δ,δ∈(3,4)

RG(c,s)=|(R(c)-G(c))Θ(G(s)-R(s))|

BY(c,s)=|(B(c)-Y(c))Θ(Y(s)-B(s))|

第三组特征图集:采用方向Gabor金字塔得到局部方向信息,采用4角度和6尺度来表示角度和方向。最后得到方向特征图:O(c,s,θ)=|O(c,θ)ΘO(s,θ)|

显著性图

感谢原文博主的解析,详见https://blog.csdn.net/chenjiazhou12/article/details/39456589

二、 接下来的计算研究开始用显著图来进行固定预测(fixation prediction)以及理解人类的视觉注意机制。

第二波浪潮来自于三篇文章【7】【8】【9】,它们将显著性检测问题定义为二进制分割问题。它们也是《Salient Object Detection: A Survey》一文所主要关注的。这三篇(注意观察前两篇的版本)文章分别是:

1、T. Liu, J. Sun, N. Zheng, X. Tang, and H.-Y. Shum, “Learning to detect a salient object,” in CVPR, 2007, pp. 1–8.

这篇文章将显著性检测定义为图像分割问题,它将显著性目标从图像背景中分隔出来。

提出了一系列新颖的特征,包括多尺度对比度,中心环绕直方图和颜色空间分布,以在本地,区域和全局描述显著性目标。

引入了条件随机场用于高效地将这些新颖的特征组合起来,以服务于后续的显著性目标检测。

创建了一个大型的精心标注的图像数据库。

链接附上:https://ivrl.epfl.ch/achanta/SalientRegionDetection/SalientRegionDetection.html

2、T. Liu, Z. Yuan, J. Sun, J. Wang, N. Zheng, X. Tang, and H.-Y. Shum, “Learning to detect a salient object,” IEEE TPAMI, vol. 33, no. 2, pp. 353–367, 2011.

3、R. Achanta, F. Estrada, P. Wils, and S. Süsstrunk, “Salient region detection and segmentation,” in Comp. Vis. Sys., 2008.

该文章提出了一种使用亮度和颜色的低级特征来确定图像中的显著性区域的新方法。该方法快速、易于实现,并且能够生成和原始输入图像尺寸以及分辨率一致的显著图。

三、那么,什么是显著性目标检测呢?

在计算机视觉领域,它包括两个阶段:

1)首先检测到最显著的目标;

2)然后准确地分割出该目标的边界。