学习目标

- 了解 scrapyd的使用流程

1. scrapyd的介绍

scrapyd是一个用于部署和运行scrapy爬虫的程序,它允许你通过JSON API来部署爬虫项目和控制爬虫运行,scrapyd是一个守护进程,监听爬虫的运行和请求,然后启动进程来执行它们

所谓json api本质就是post请求的webapi

2. scrapyd的安装

scrapyd服务: pip install scrapyd

scrapyd客户端: pip install scrapyd-client

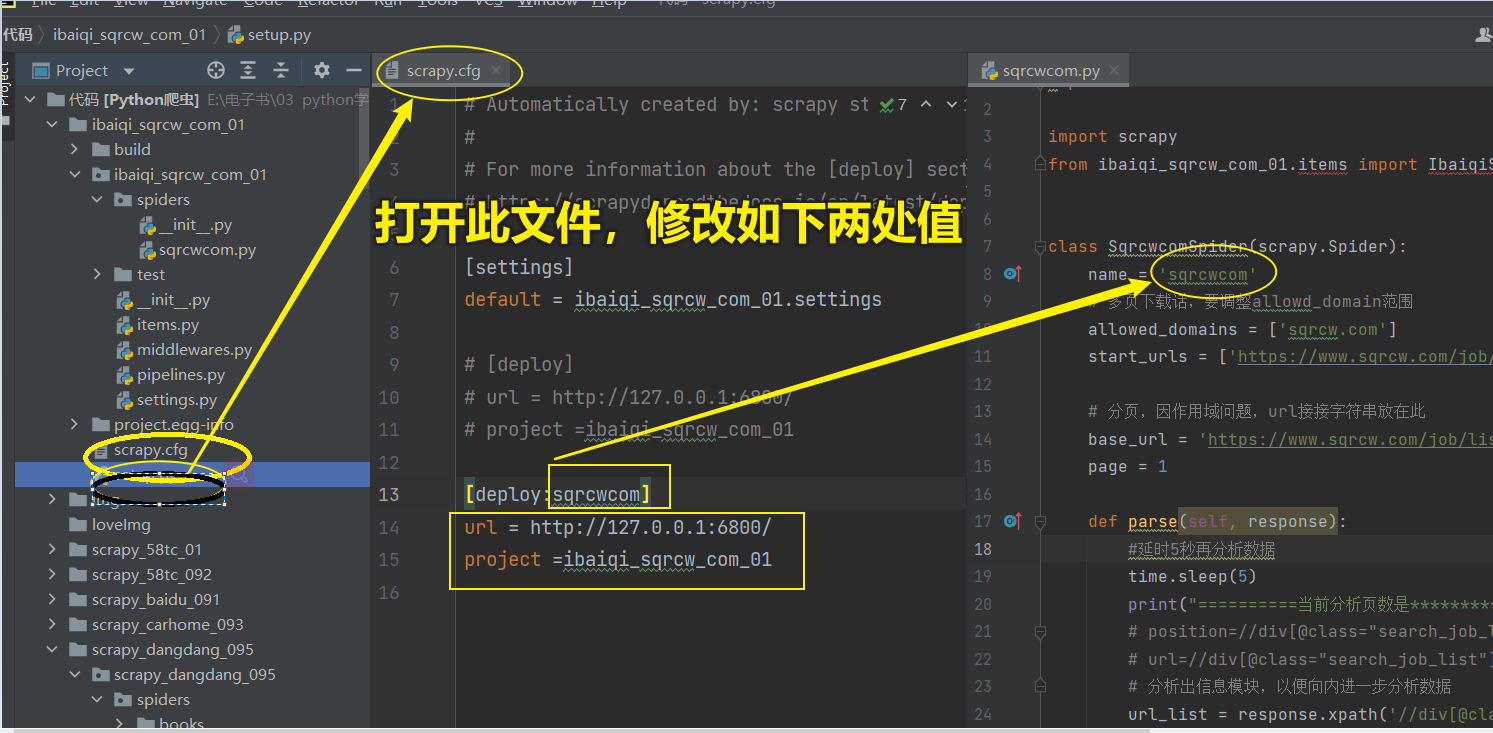

3.修改采集成功项目中scrpy.cfg 文件中配置

图片3-1

4.先启动scrapyd服务

启动命名: scrapyd

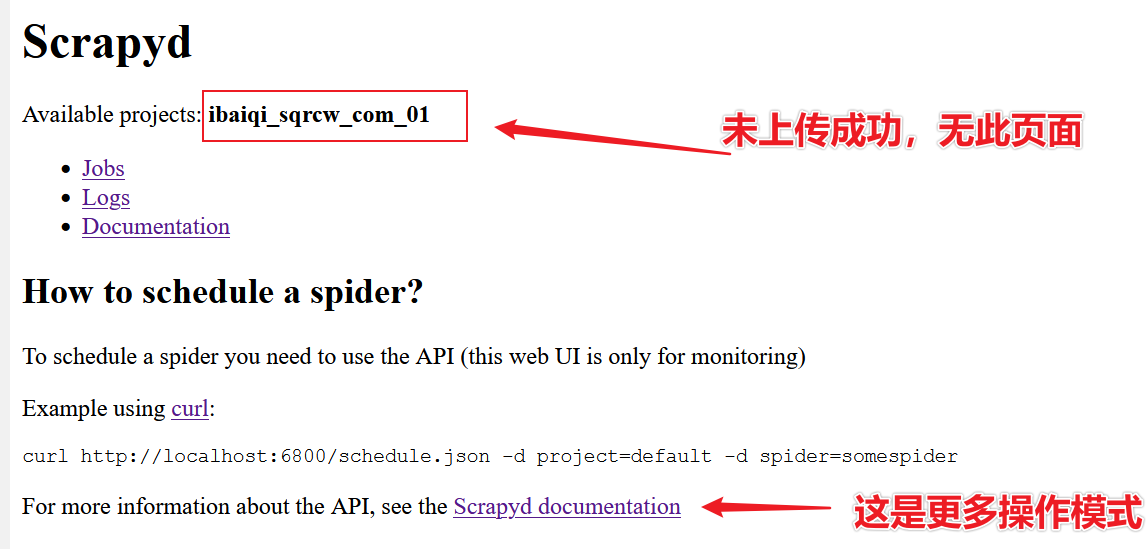

浏览器打开:http://127.0.0.1:6800/

浏览器打开页面如下图(但没有红色方框中内容)

- 点击job可以查看任务监控界面

5.部署项目到scrapyd

打开页面中,可见部署语法格式:

curl http://localhost:6800/schedule.json -d project=default -d spider=somespider

如上链接:

project=default(部署名称,即本例 scrapy.cfg配置文件中project的值)

spider=你开发蜘蛛的名称,本例中 sqrcwcom

本例代码:curl http://127.0.0.1:6800/schedule.json -d project=ibaiqi_sqrcw_com_01 -d spider=sqrcwcom

但在CMD操作成功,以管理员身份运行的

部署成功后,可见下图

点击Jobs,可查看正在运行状态