https://blog.csdn.net/xyk_hust/article/details/86702700

1 固定值的贪婪策略

固定贪婪策略的值,使得算法整个运行过程中保持一定的探索。实现方式直接而简单,在不少情况下对收敛性的负面影响并不大,尤其是奖励常常取负值时候。

通常应用在状态空间有限的简单环境中;

2 epsilon衰减贪婪策略

2.1 初始状态下探索,然后最终使得epsilon上升,得到最终的固定贪婪值。初期的值使得算法能够有效探索。在DRL常用。

2.2 进行绕圈,一定程度下重新初始化探索

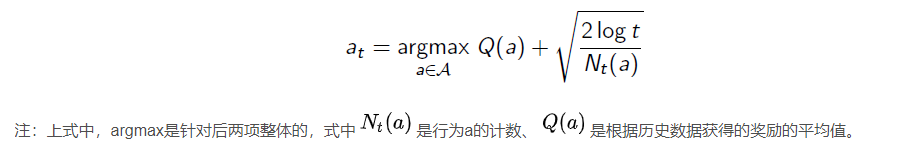

3 UCB方法

置信区间上界(Upper Confidence Bound, UCB)指导行为选择。由Hoeffding不等式推导得到

4 熵相关方法

4.1 A3C,状态下得到的行为选择值数组后,可以计算熵项目,给予一定权重添加到奖励r上,使得倾向选择最大熵对应的状态,然后衰减该权重,形成策略?

4.2 SAC?

5 其它

对于Actor-Critic架构,Actor选择行为,用DDPG的正态分布等,对sigma进行衰减类似于贪婪策略,用A2C算法的离散方式,状态可选动作下,动作数组取softmax,然后进行概率取样,属于概率方法吧。