当使用requests库的时候,会出现中文乱码的情况

Python HTTP库requests中文页面乱码解决方案!

分析

根据这两篇文章可知:

分析requests的源代码发现,text返回的是处理过的Unicode型的数据,而使用content返回的是bytes型的原始数据。也就是说,r.content相对于r.text来说节省了计算资源,content是把内容bytes返回. 而text是decode成Unicode. 如果headers没有charset字符集的化,text()会调用chardet来计算字符集,这又是消耗cpu的事情.

import requests

response = requests.get('http://www.dytt8.net/index.htm')

print(response.text[200:300])

这里测试使用电影天堂的网页,因为网页不太标准

输出为

输出了乱码

response.encoding

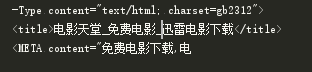

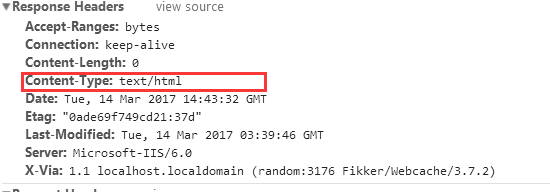

从第二篇文章可以知道reqponse header只指定了type,但是没有指定编码(一般现在页面编码都直接在html页面中),查找原网页可以看到

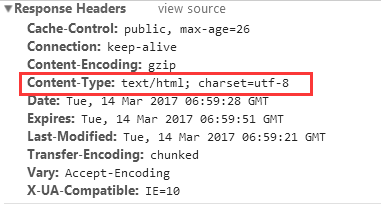

再找一个标准点的网页查看,比如博客园的网页博客园

response herders的Content-Type指定了编码类型

《HTTP权威指南》里第16章国际化里提到,如果HTTP响应中Content-Type字段没有指定charset,则默认页面是'ISO-8859-1'编码。这处理英文页面当然没有问题,但是中文页面,就会有乱码了!

解决

如果在确定使用text,并已经得知该站的字符集编码时,可以使用 r.encoding = ‘xxx’ 模式, 当你指定编码后,requests在text时会根据你设定的字符集编码进行转换.

使用apparent_encoding可以获得真实编码

>>> response.apparent_encoding 'GB2312'

这是程序自己分析的,会比较慢

还可以从html的meta中抽取

>>> requests.utils.get_encodings_from_content(response.text) ['gb2312']

解决方法

# response.encoding = response.apparent_encoding response.encoding = 'gb2312'

这时候的输出为