举例:用蒙特卡罗方法来学习状态值函数Vπ(s)。如上所述,估计Vπ(s)是对于所有到达过该状态的回报取平均值。这里又分为first-visit MC methods和every-visit MC methods。这里,我们只考虑first MC methods,即在一个episode内,我们只记录s的第一次访问,并对它取平均回报。现在我们假设有如下一些样本,取折扣因子γ=1,即直接计算累积回报,则有根据first MC methods,对出现过状态s的episode的累积回报取均值,有Vπ(s)≈ (2 + 1 – 5 + 4)/4 = 0.5. 容易知道,当我们经过无穷多的episode后,Vπ(s)的估计值将收敛于其真实值。

在一条轨迹下来以后,更新Q值后,做第二条轨迹,这样就做到了不依赖MDP模型的强化学习方法。

然而该方法缺乏环境探索,难以更新策略

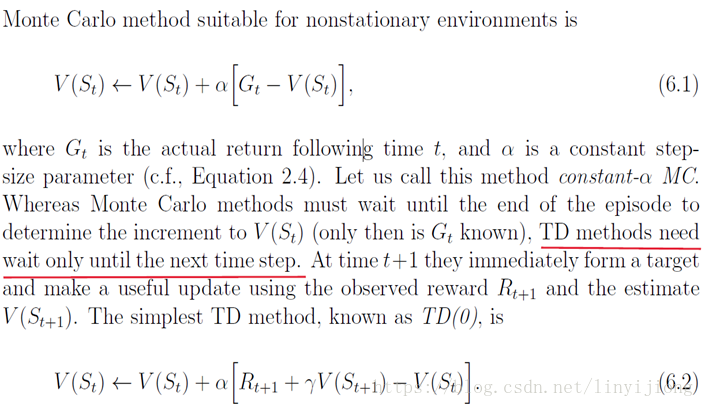

在TD算法里,我们走了一步得到了一步真实的奖赏,再往后走还没走,所以不知道后面真实的奖赏是多少,但可以通过之前的V值来估计之后的奖赏,这两个加起来就是当前知道的信息,用它来替代这个G,来减去老(此前的)的预估均值值,我们称这个过程为时序差分(公式6.2)。

-------------------------------------------------------------------------------------

以上内容转自: