一句话:

DNN-NLP已经形成了一整套相关技术,包括WordEmbedding、SentenceEmbedding、带注意力机制的编解码器模型、Transformer和各种预训练模型。

预训练模型+针对具体任务的精细调节已成为NLP处理的新范式,使用大规模文本语料库进行预训练,然后使用特定任务的小数据集进行微调。ELMo、BERT、GPT 等模型已经被广泛使用。基于BERT和GPT,又开发了一系列的新的方法,如XLNet(Google)、UNILM(UNIfied pretrained Language Model,微软)、MASS (MAsked Sequence to Sequence pre-training,微软)、XLM(Facebook) 等。

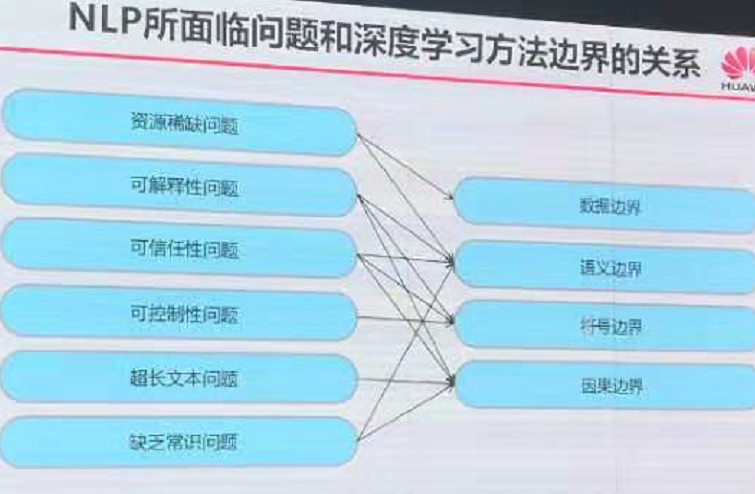

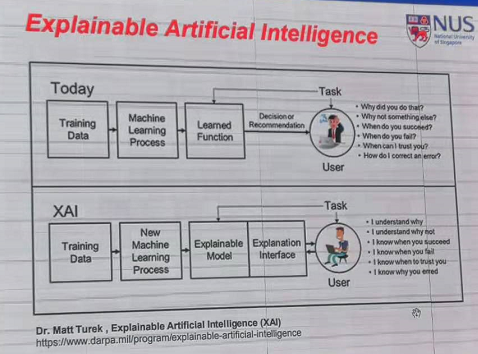

未来不会只是基于规则的模型,同样也不会只是基于DNN的模型,应当是可解释的、有知识的、终生学习的模型,深度学习和语言学研究应该互相帮助

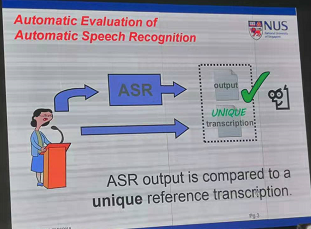

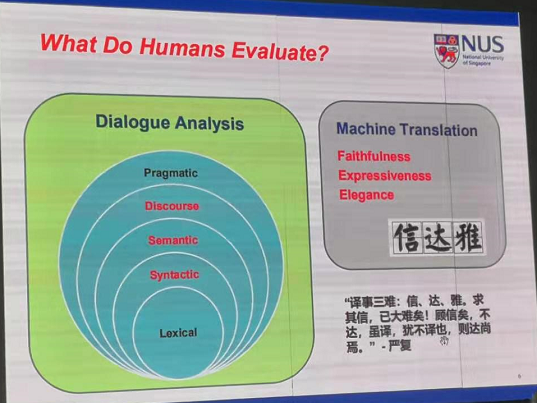

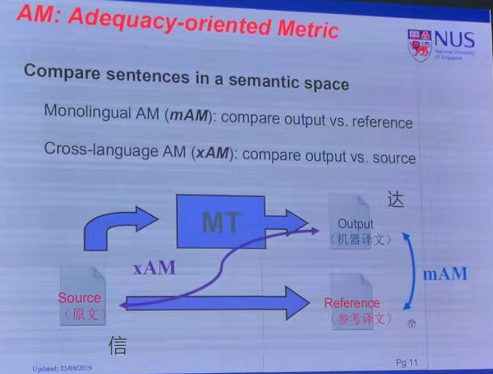

李海洲 -- adequcy-fluency evaluation of natural language

二。黄海燕

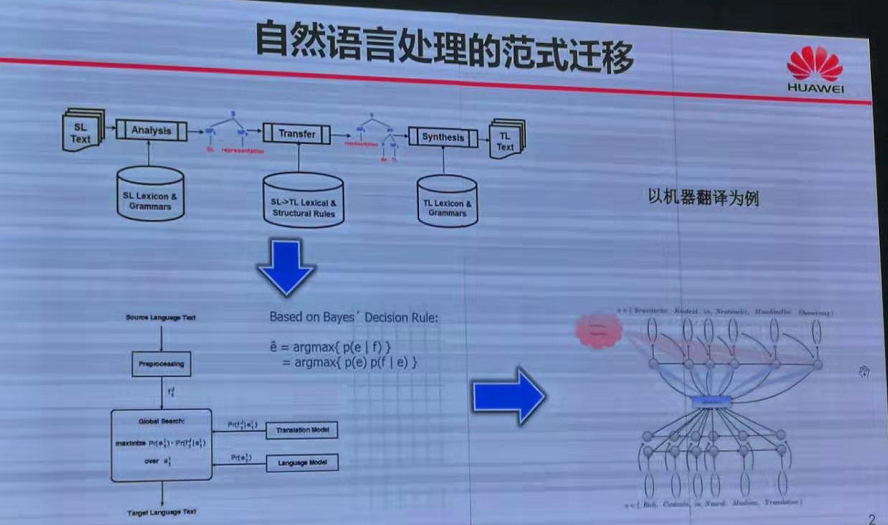

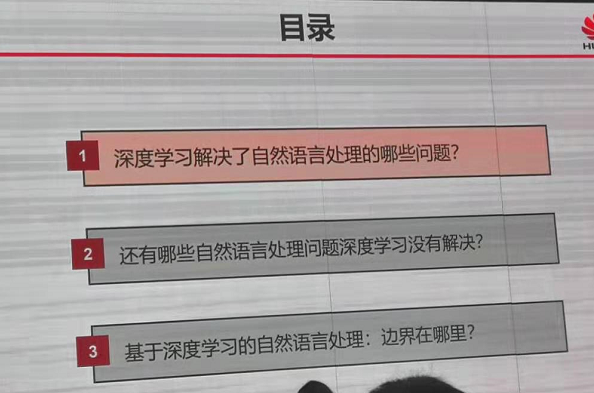

三 刘群 基于深度学习的nlp 边界在哪里