本篇博文为使用python爬虫爬取糗事百科content并将爬取内容存入excel中保存·.

实验环境:Windows10 代码编辑工具:pycharm

使用selenium(自动化测试工具)+phantomjs(无界面的浏览器 也可以使用Firefox或者chrome)+beautiful soup来爬取并解析页面

代码如下:

#_*_coding:utf-8_*_

from selenium import webdriver

from bs4 import BeautifulSoup

import xlwt

import sys

reload(sys)

sys.setdefaultencoding("gbk")

driver=webdriver.PhantomJS();

driver.set_window_size(1120, 550)

wbk=xlwt.Workbook()

sheet=wbk.add_sheet("sheet1")

class Crawl_spider(object):

def __init__(self,page):

self.page=page

def crawl(self):

index=1

row=0

contents=[]

while self.page <= 2: #此处可根据要爬取的页面数量做修改

url='https://www.qiushibaike.com/8hr/page/'+str(self.page)

driver.get(url)

html = driver.page_source

soup = BeautifulSoup(html, "lxml")

print soup.title.string #打印每个页面的title

for item in soup.findAll("div", {"class": "content"}):

string = str(index) + ':'+ item.getText().strip()

sheet.write(row,0,string)

row+=1

index += 1

self.page+=1

wbk.save('lucky.xls')

spider1=Crawl_spider(1) #实例化一个对象

spider1.crawl()

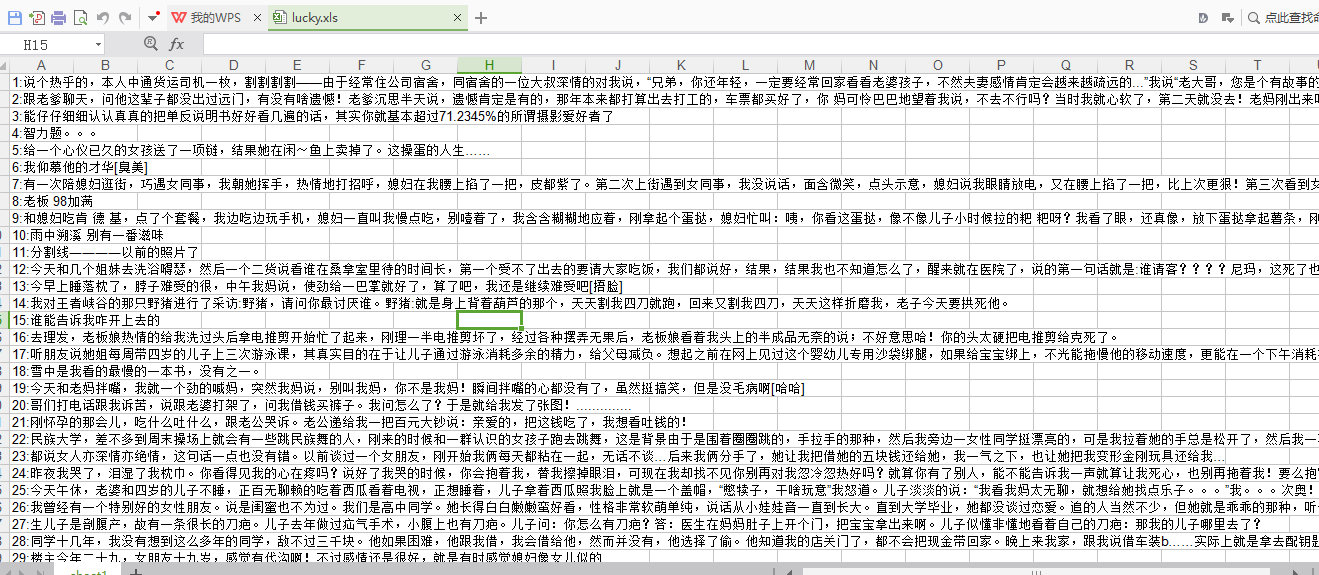

实验结果:生成一个名为lucky的xls文件