上传centOS6.7-hadoop-2.6.4.tar.gz

解压 tar -zxvf centOS6.7-hadoop-2.6.4.tar.gz

hadoop相关修改配置

1 修改 /root/apps/hadoop/etc/hadoop 目录下的hadoop-env.sh

vi hadoop-env.sh 中 export JAVA_HOME=${JAVA_HOME}修改为 export JAVA_HOME=/root/apps/jdk1.7.0_80保存退出

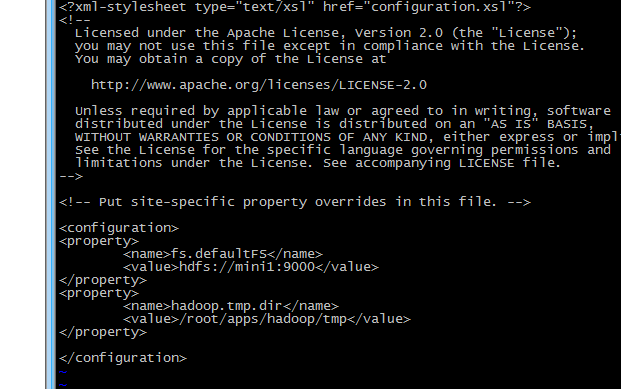

2 修改 core-site.xml

<!-- 指定HADOOP所使用的文件系统schema(URI),HDFS的老大(NameNode)的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://mini:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/root/apps/hadoop/tmp</value>

</property>

修改后的文件内容如下:

保存退出。

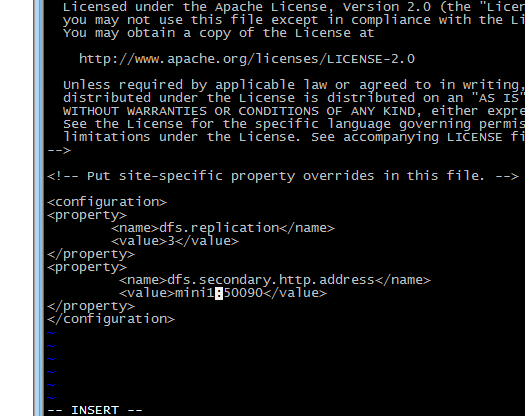

3修改hdfs-site.xml

<!-- 指定HDFS副本的数量 -->

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.secondary.http.address</name>

<value>mini1:50090</value>

</property>

修改后的文件为:

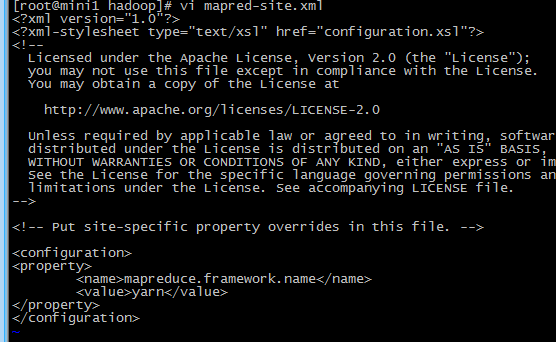

4 修改 mapred-site.xml(mv mapred-site.xml.template mapred-site.xml)

没有该文件,先cp一份(cp mapred-site.xml.template mapred-site.xml)

<!-- 指定mr运行在yarn上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

5修改yarn-site.xml

<!-- 指定YARN的老大(ResourceManager)的地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>weekend-1206-01</value>

</property>

<!-- reducer获取数据的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

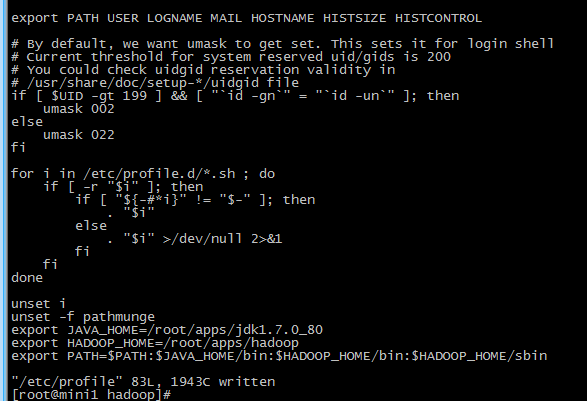

将hadoop添加到环境变量

vi /etc/proflie

export JAVA_HOME=/root/apps/jdk1.7.0_80

export HADOOP_HOME=/root/apps/hadoop

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

修改后的文件如下

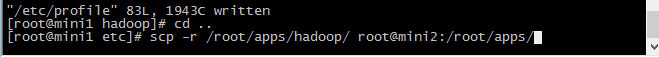

把修改后的hadoop发送到mini2,mini3

scp -r /root/apps/hadoop/ root@mini2:/root/apps/

scp -r /root/apps/hadoop/ root@mini3:/root/apps/

把修改的环境变量文件cp到mini2,mini3

scp -r /etc/profile root@mini2:/etc/profile

scp -r /etc/profile root@mini3:/etc/profile

在mini1,mini2,mini3上重新加载一下

source /etc/profile

完成