一、学习资源

https://www.bilibili.com/video/BV1yD4y1U73C?p=8

二、步骤

1、下载安装包

根据自己hadoop的版本下载相应的安装包

https://spark.apache.org/downloads.html

2、放到虚拟机中,进行解压和安装

解压压缩包:tar xvzf spark-2.2.0-bin-hadoop2.7.tgz

移动解压包到指定文件:mv spark-2.2.0-bin-hadoop2.7 /export/servers/spark

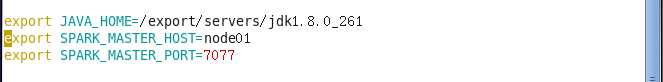

3、修改配置文件spark-env.sh

先将spark-env.sh.template复制一份命名为spark-env.sh:cp spark-env.sh.template spark-env.sh

打开配置文件:vim spark-env.sh

在配置文件中增加一下内容:

注:打开配置文件中,点击“a"进行编辑,然后单击”Esc"退出编辑,最后:wq保存退出

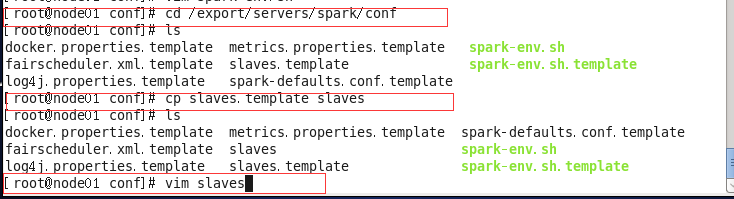

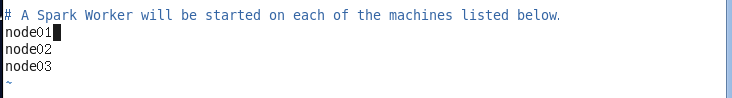

4、修改配置文件slaves

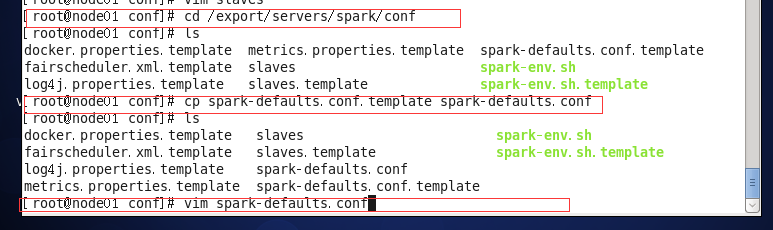

5、配置HistoryServer

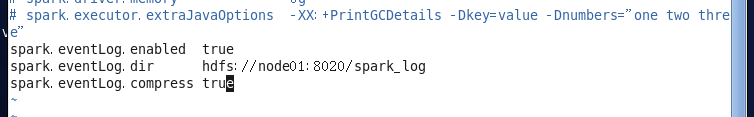

在spark-defaults.conf末尾增加一下内容

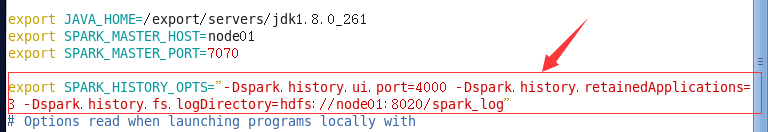

在spark-env.sh末尾增加以下内容

6、为Spark创建HDFS中的日志目录(执行此命令,一定要开启hadoop:start-all.sh)

![]()

7、分发和运行

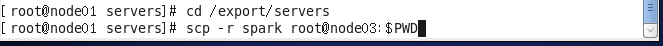

分别给node02和node03进行分发:

启动

cd /export/servers/spark

sbin/start-all.sh

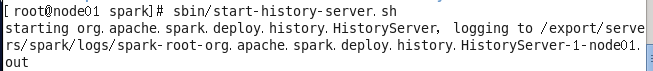

sbin/start-history-server.sh

8.检测完成配置