1、 之前第四节教材中,我们已经创建了共享服务提供Shared Services Provider(简称SSP)

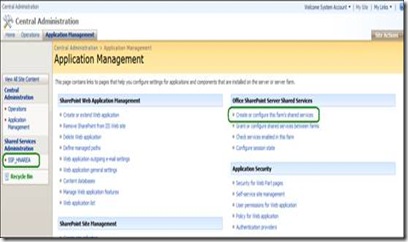

,并且取名为SSP_HNAREA。这一节,我们接着讲如何配置SSP的执行爬网计划。首先,打开管理中心Central Administration,单击应用程序管理Application Managerment,

,单击选项Create or configure this farm’s shared services。或者直接单击面板右侧的选项

Shared Services Administration中的SSP对象。

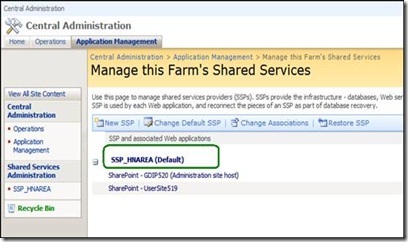

2、打开SSP管理设置界面,选择和单击要设置的SSP对象。

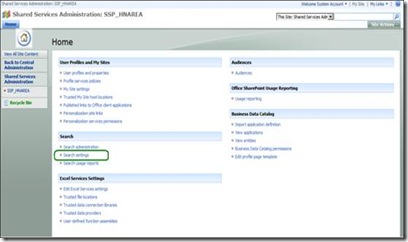

弹出该SSP_HNAREA的设置主界面,并且单击选项“Search”à”Search Settings”。

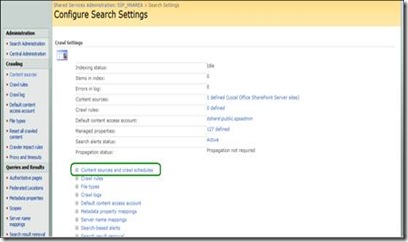

3、 在如下界面中,我们单击选项“Content sources and crawl schedules”(内容源和爬网计划)

,进行内容源和爬网计划的创建和设置。

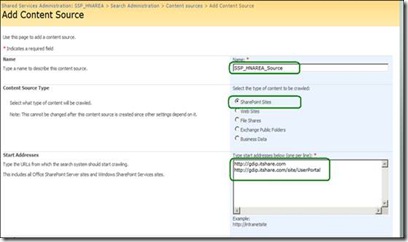

4、单击“New Content Source”选项,创建一个内容源,并且设置派往计划:

设置数据源名称、选择被爬网的内容的类型、爬网的开始地址。(注意:这里我输入的http://gdip.itshare.com/sites/UserPortal,其实是错误的,只需要输入最上面的开始地址,即可。)

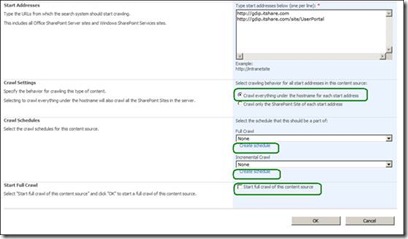

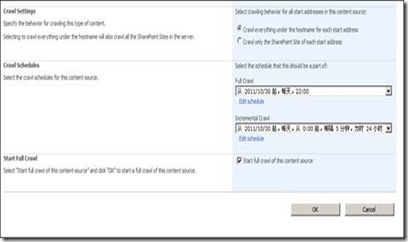

5、接下来,我们要设置参数”Crawl Settiings”、”Crawl Schedules”,

Crawl Settings有两种方式:爬网范围为整个开始地址的网站的全部内容,和爬网范围为开始抵制的网站的网站首页。

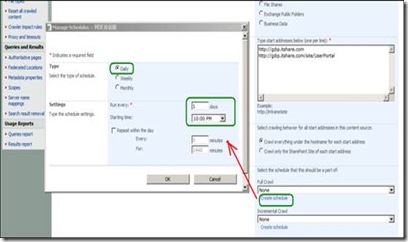

6、设定完整爬网:单击”Full Crawl”下面的选项”Create Schedules”,创建一个爬网计划。设置参数,可以参考实际情况和网路使用情况以及系统访问负担情况来考虑设定。

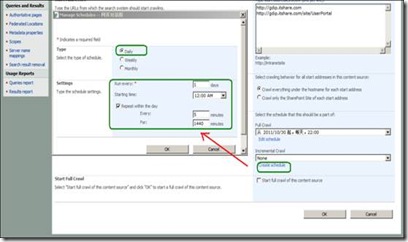

7、设定增量爬网:单击”Incremental Crawl”下面的选项”Create Schedules”,创建一个爬网计划。设置参数,可以参考实际情况和网路使用情况以及系统访问负担情况来考虑设定。

8、最后,你可以选中勾上“Start full crawl for this content source”来手动启动本次的完整爬网计划。

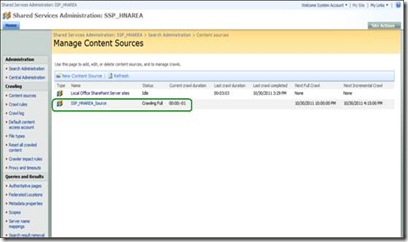

单击按钮“确定”,便开始完整爬网。如下图。

附:

大家也可以尝试使用Search Settings的其他功能选项,比如“Metadata property mapping”(映射属性)来了解爬网的搜索内容。