一、信息论基础:

熵:

联合熵:实际上就是描述一对随机变量平均所需要的信息量。

条件熵:给定随机变量 X 的情况下,随机变量 Y 的条件熵定义为:

熵率:

相对熵(KL距离):两个概率分布 p(x) 和 q(x) 的相对熵定义为:

交叉熵:如果一个随机变量 X ~ p(x),q(x)为用于近似 p(x)的概率分布,那么,随机变量 X 和模型 q 之间的交叉熵定义为:

由此,我们可以根据模型 q 和一个含有大量数据的 L 的样本来计算交叉熵。在设计模型 q 时,我们的目的是使交叉熵最小,从而使模型最接近真实的概率分布 p(x)。

困惑度:

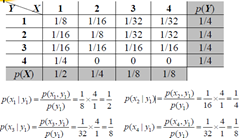

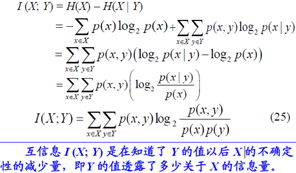

互信息:

当两个汉字 x 和 y 关联度较强时,其互信息值 I(x, y)>0;x 与y 关系弱时,I(x, y)≈0;而当I(x, y)<0时,x 与 y 称为 “互补分布”。在汉语分词研究中,有学者用双字耦合度的概念代替互信息:设 ci,ci+1是两个连续出现的汉字,统计样本中ci,ci+1连续出现在一个词中的次数和连续出现的总次数,二者之比就是ci,ci+1的双字耦合度:

有些汉字在实际应用中出现虽然比较频繁,但是连续在一起出现的情况比较少,一旦连在一起出现,就很可能是一个词。这种情况下计算出来的互信息会比较小,而实际上两者的结合度应该是比较高的。而双字耦合度恰恰计算的是两个连续汉字出现在一个词中的概率,并不考虑两个汉字非连续出现的情况。

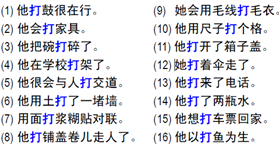

例如:词汇消歧:

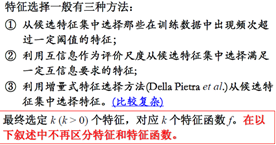

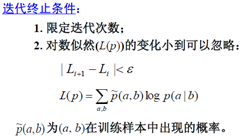

*概率p*(a|b)的推导说明: