100天搞定机器学习|Day19-20 加州理工学院公开课:机器学习与数据挖掘

100天搞定机器学习|Day21 Beautiful Soup

100天搞定机器学习|Day23-25 决策树及Python实现

本文为3Blue1Brown之《What is a Neural Network?》学习笔记

观看地址:bilibili.com/video/av15532370

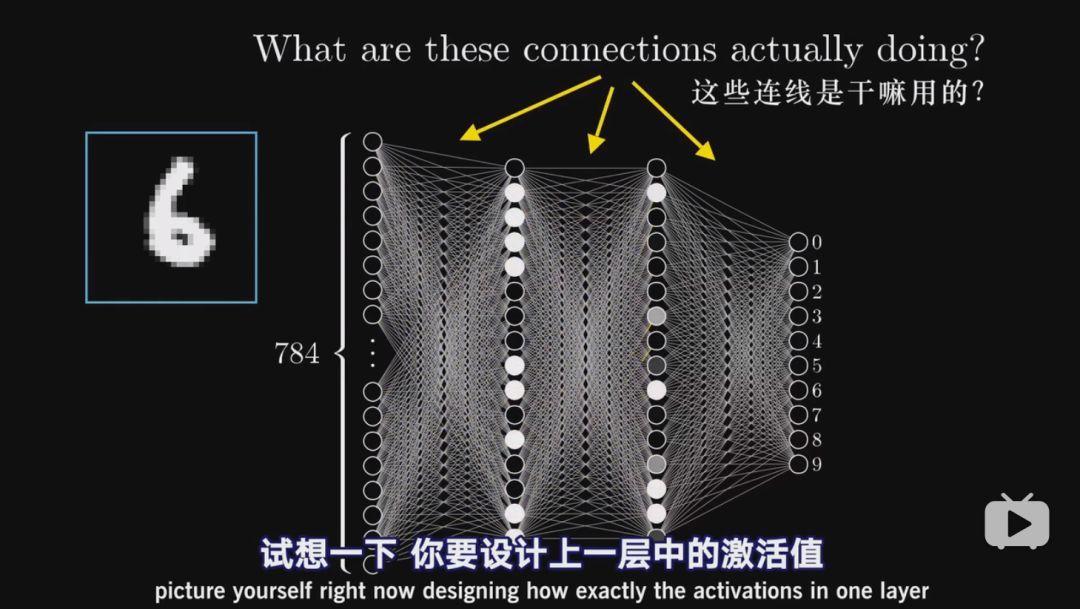

这集Grant大佬假设大家都没有神经网络的基础,为新手讲解神经网络基本概念,让大家再听说神经网络学习的时候,可以明白究竟是什么意思。大佬选择经典的多层感知器(MLP)结构解决手写数字识别问题,理由是理解了经典原版,才能更好地理解功能强大的变种,比如CNN和LSTM。

首先看看神经元和他们是怎么连接的

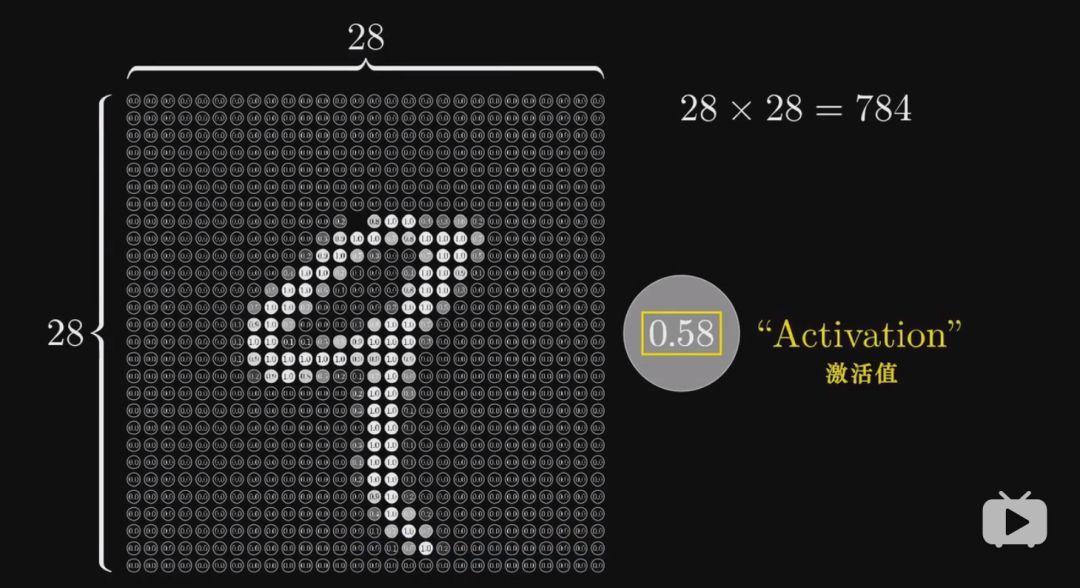

神经元可以理解为一个装着0到1之间数字的容器。以28*28输入图像每一个像素为例,每一个原点都是一个神经元,其中数字代表对于像素的灰度值,0表示纯黑,1表示纯白,这个数字在神经网络里称作“激活值”。

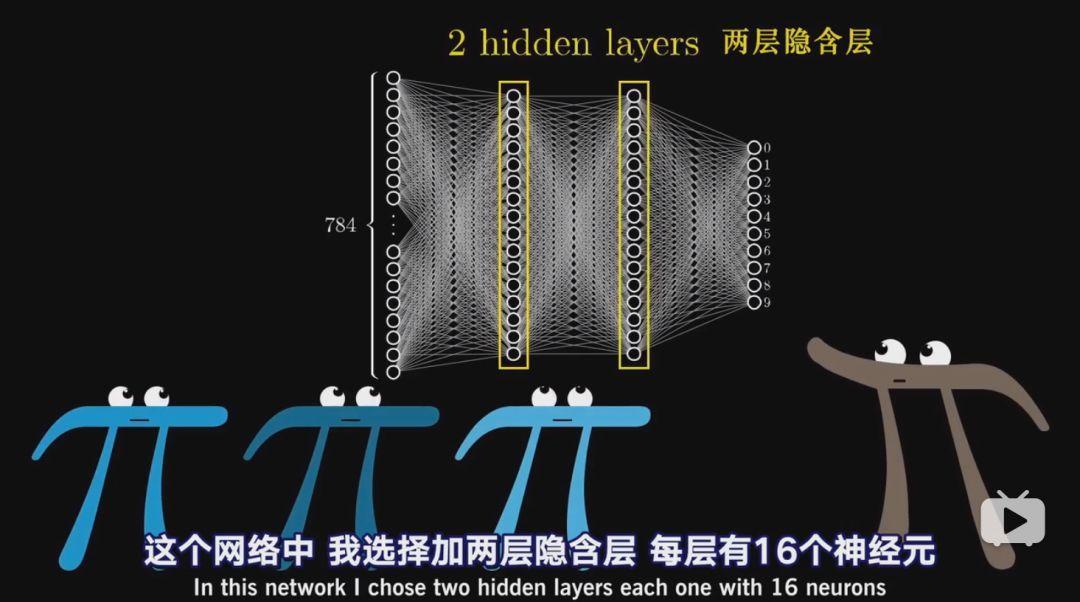

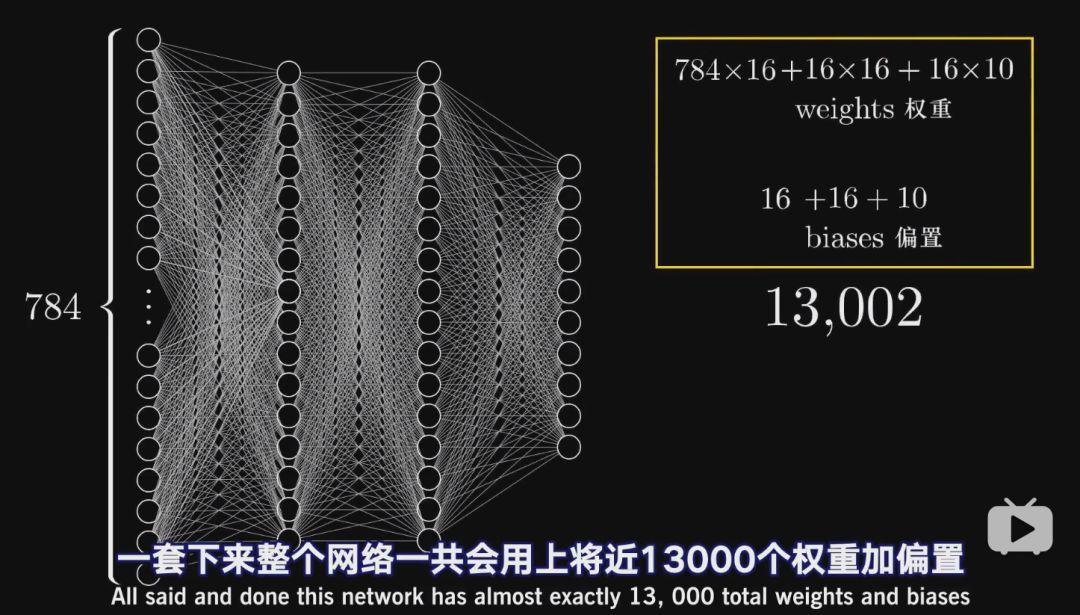

这784个神经元就组成了网络的第一层,最后一层的十个神经元代表0-9这十个数,同样的,他们的激活值也在0-1之间,代表了输入图像对应哪个数字的可能性。网络中间层被称为隐含层,可以看做黑箱,数字识别的具体工作就在这里完成,这里加了两层隐含层,每层有16个神经元——随便设置的,只是为了显得好看,后期还可以再调整。

神经网络处理信息的核心机制正是如此,一层的激活值通过一定的运算,得出下一层的激活值。上面也提到784个神经元代表的是数字图案,那么下一层激活值也会产生某些特殊的图案,最终在输出层最亮的神经元表示神经网络的选择。

我们再看看如何训练,为什么这种层状结构就能识别数字呢?

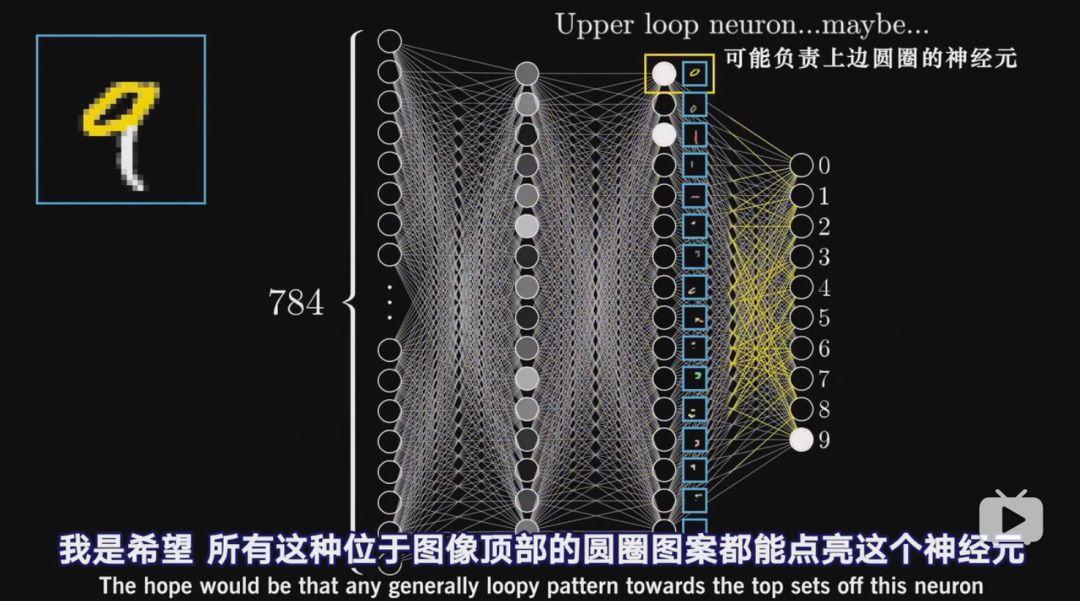

我们可以把数字进行拆解,理想状况下希望倒数第二层的各个神经元可以分别对应上一个笔画。

再来看隐含层第一层,当输入为9或8的上面带圈的数字时,某个神经元的激活值就会接近1,希望所有这种位于图像顶部的圆圈图案都能点亮这个神经元,这样,从第三次到输出层,我们只需要学习哪些部件能组合出哪个数字即可。

但是如何识别圆圈呢?同理可以把它拆分成更细微的问题。

于是我们希望网络第二层的各个神经元对应这些短边,第二层就能把所有关联短边的八到十个神经元都点亮,接着就能点亮对于顶部圆圈和长竖条的神经元。

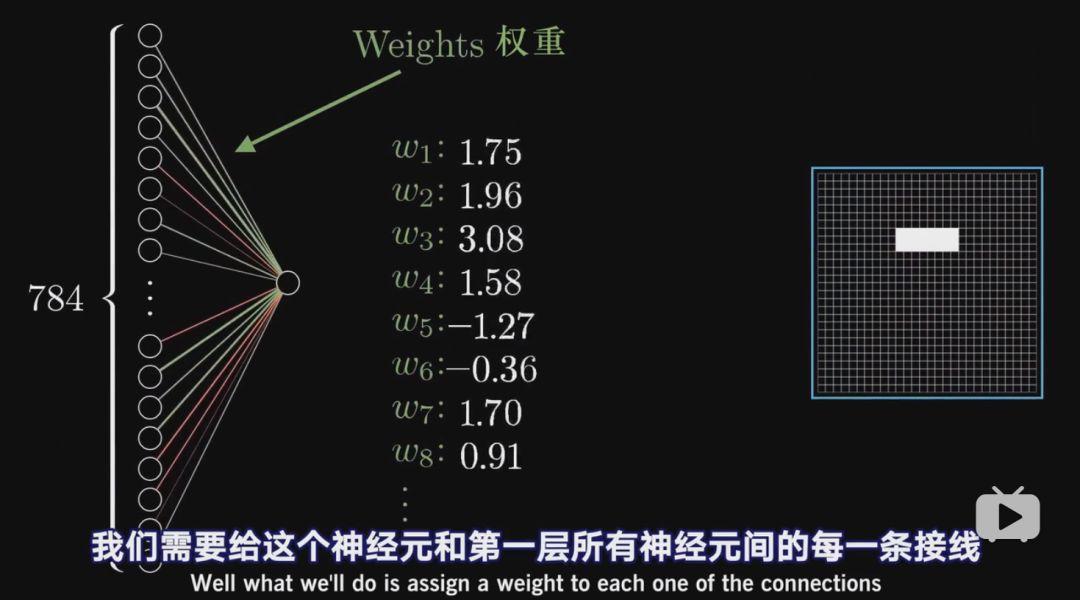

然后我们看看连线的作用

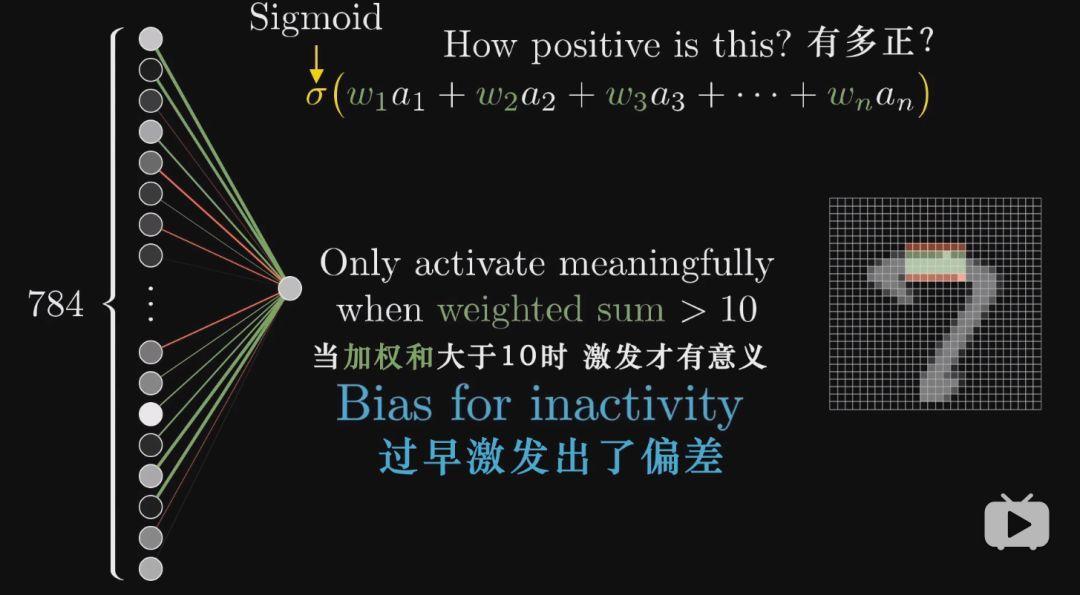

如何让第二层(隐含层的第一层)中的这一个神经元能够能够识别出图像的这一块区域是否存在一条边?

我们设计让第二层的某一个神经元能正确识别图像中的这块区域里是否存在一条边。

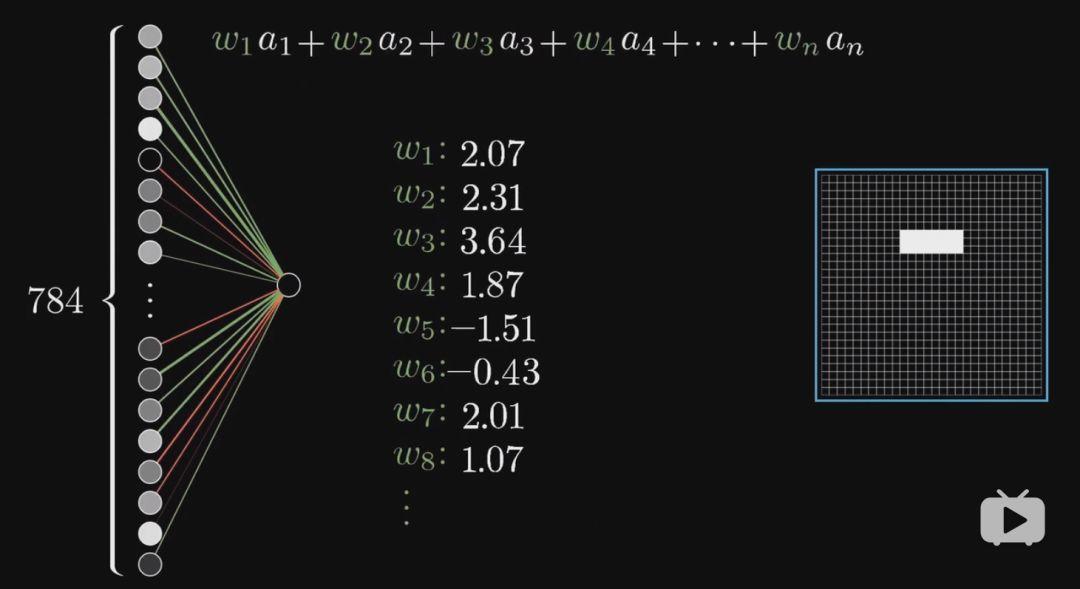

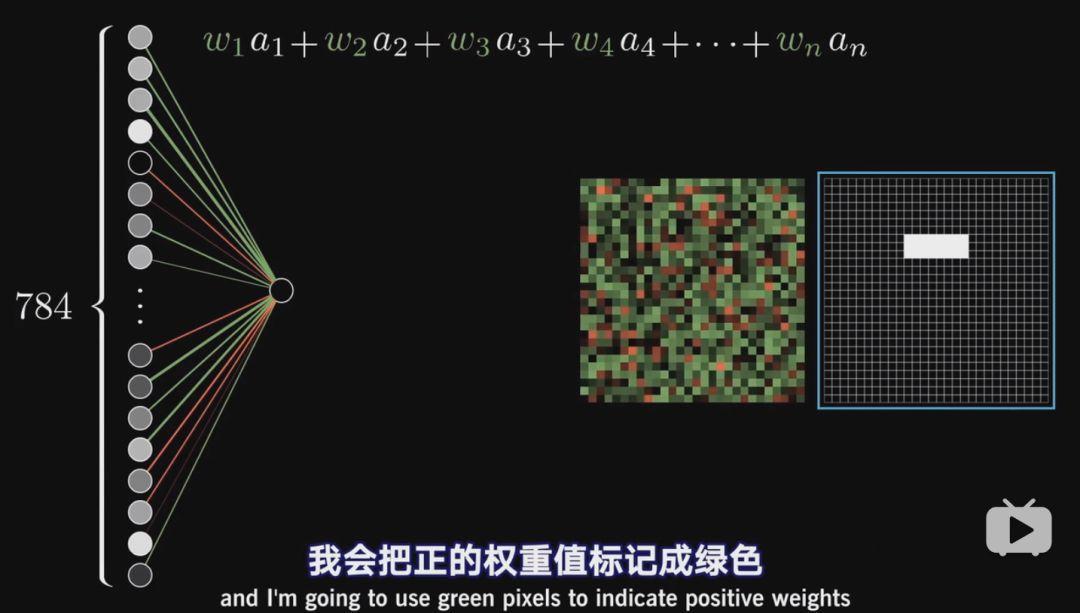

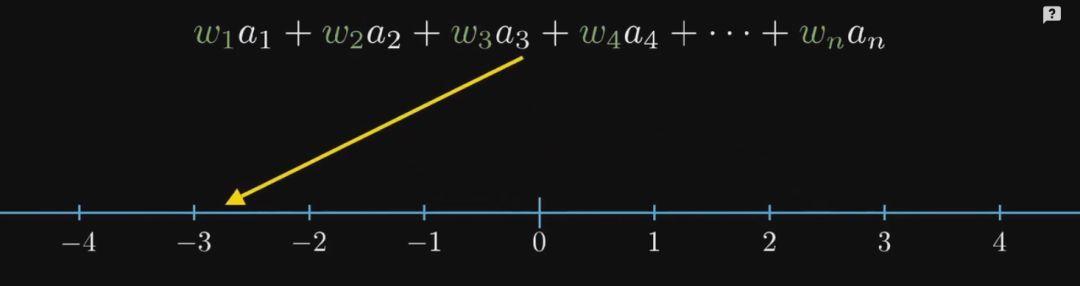

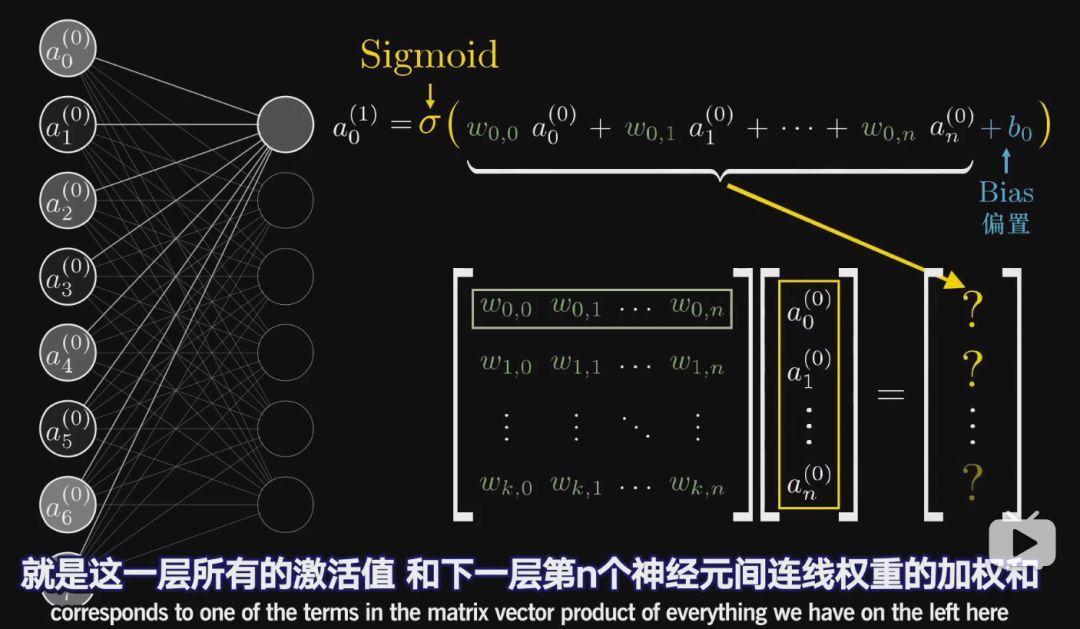

我们拿出第一层(输入层/第0层)的激活值,并赋上权重(要关注区域的权重为正值,否则为0),这样对所有像素值求加权和,就只会累加关注区域的像素值了。

绿色为正值,红色为负值,颜色越暗表示权重越接近0

所以想要识别是否存在一条边,只需要给周围一圈的像素都赋予负权重

计算的加权值可以使任意大小的

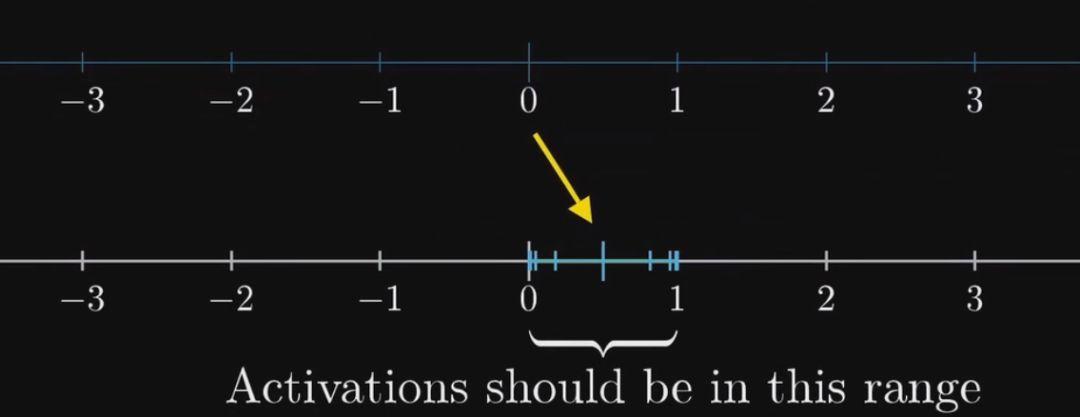

但是我们需要的是将其压缩到0-1之间

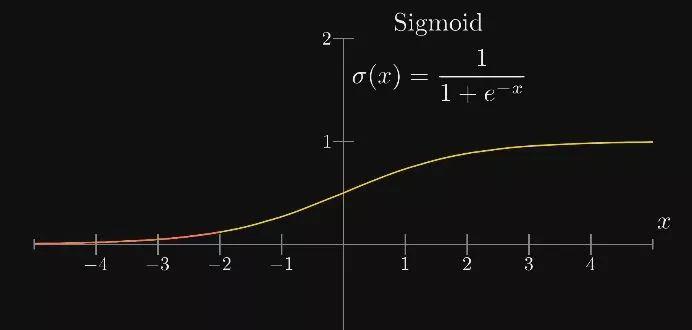

这里就需要Sigmoid函数了,这就是激活函数。

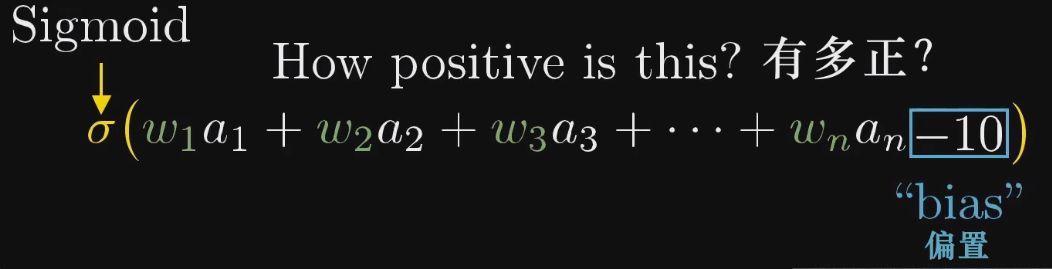

激活值实际上就是一个对加权之和到底有多正的打分,但是有时加权之和大于0时,也不想点亮神经元,比如想要加权和大于10时才让他激发,这里就还需要加上一个偏置值,保证不随便激发。

权重告诉我们第二个神经元关注什么样的像素图案

bias告诉我们加权和要多大才能让神经元的激发有意义

这里有13000多个参数需要调整,所以这里所谓的学习就是找到正确的权重和偏置。刚开始讲到我们把神经元看作是数字容器,但是这些数字取决于输入的图像,所以把神经元看过一个函数才更准确,它的输入是上一层所有神经元的输出,它的输出是一个0-1之间的值。其实整个神经网络也是一个函数,输入784个值,输出10个值。不过它是一个包含了13000个权重、偏置参数的极其复杂的函数。

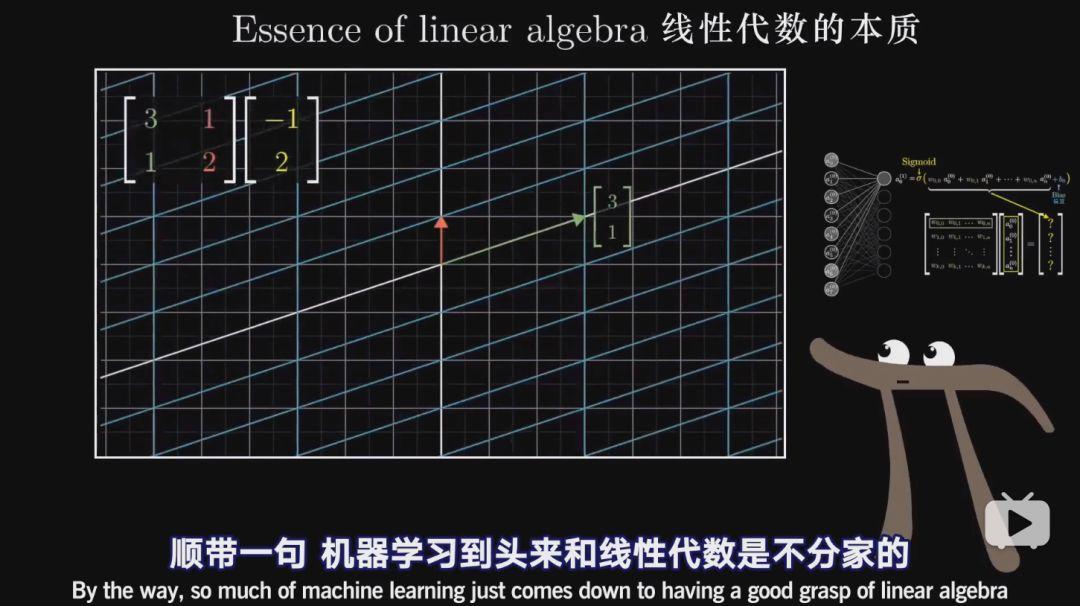

需要注意的是,机器学习尤其是神经网络运算与线性代数是密不可分的,之前有过介绍,请移步:

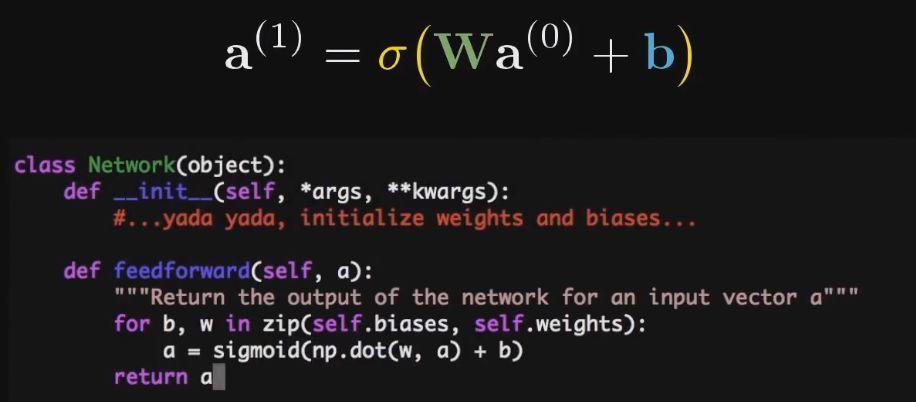

神经网络中需要大量的矩阵乘法和sigmoid映射运算

这种运算方式,非常适合编程,比如可以用Python的numpy很简单的实现。

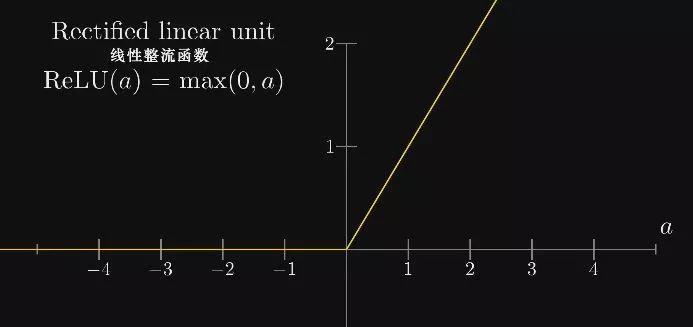

最后需要一提的是,现在神经网络基本不再使用sigmoid了,比较流行的是ReLU(线性整流函数)。