一:介绍

1.Spark的模式

Local:本地运行模式,主要用于开发、测试

Standalone:使用Spark自带的资源管理框架运行Spark程序,30%左右

Yarn: 将spark应用程序运行在yarn上,绝大多数使用情况,60%左右,因为已经有了一个hadoop框架,就不再再搭建standalone框架了

Mesos:

二:Local模式安装

1.解压

使用自己编译产生的tgz压缩包。

2.建立软连接

3.复制配置文件

4.修改env.sh文件

三:运行测试

1.启动HDFS

2.准备测试路径

3.开始测试

./run-example SparkPi 10<----------------10代表迭代的次数

4.shell的测试

5.shell效果

四:问题(HDFS问啥要启动的问题)

1.HDFS启动的原因

如果不启动HDFS,在./spark-shell的时候会出现错误。

2.不启动HDFS会出现的问题

3.下面的配置是真正的spark local,不再需要考虑hadoop

4.启动./spark-shell

没有其他服务。

可以成功启动。

五:页面

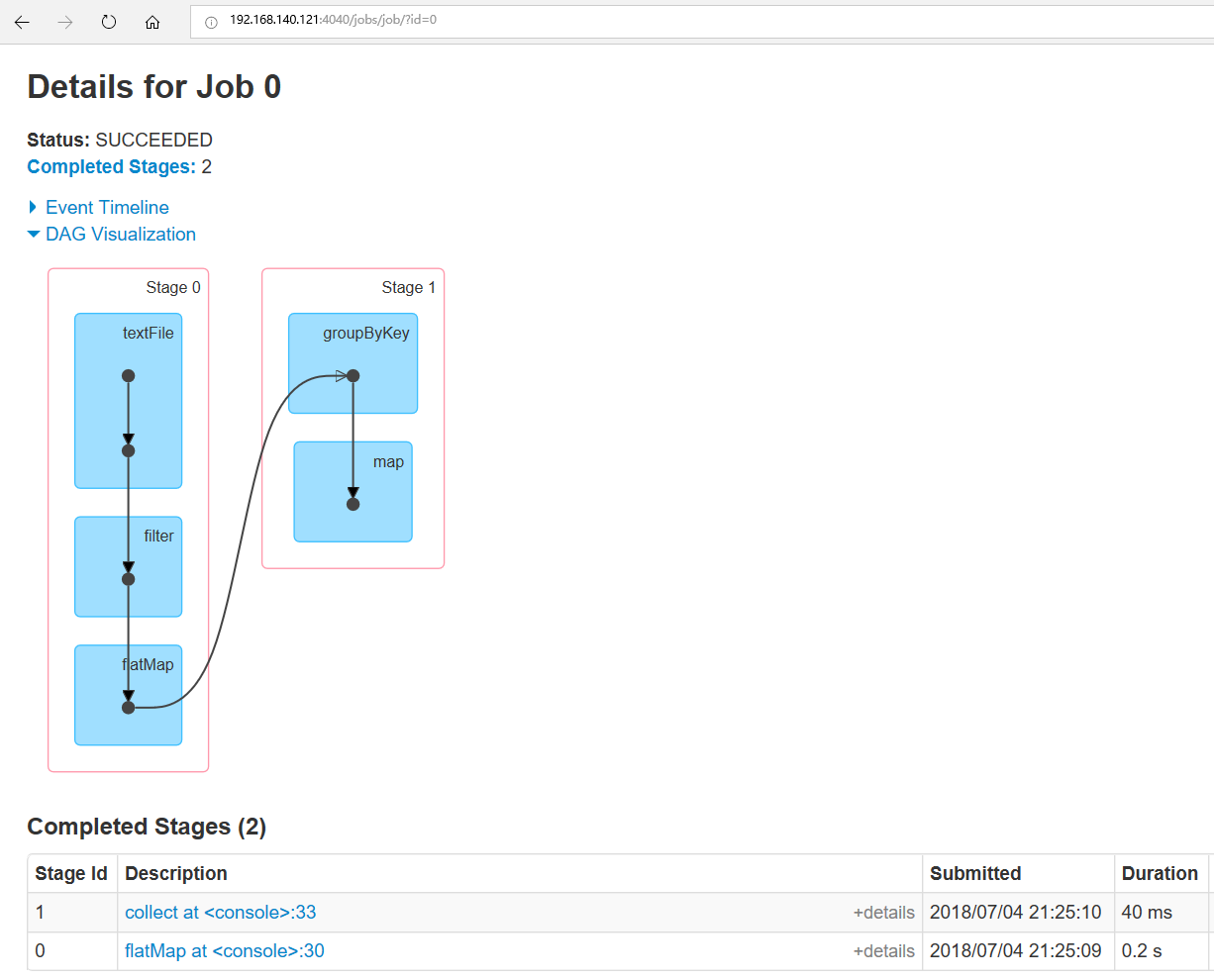

1.程序示例

这个是后来的补充。

1 sc.textFile("/user/beifeng/mapreduce/wordcount/input/wc.input"). 2 filter(_.length>0). 3 flatMap(_.split(" ").map((_,1))). 4 groupByKey(). 5 map(tuple=>(tuple._1,tuple._2.toList.sum)). 6 collect()

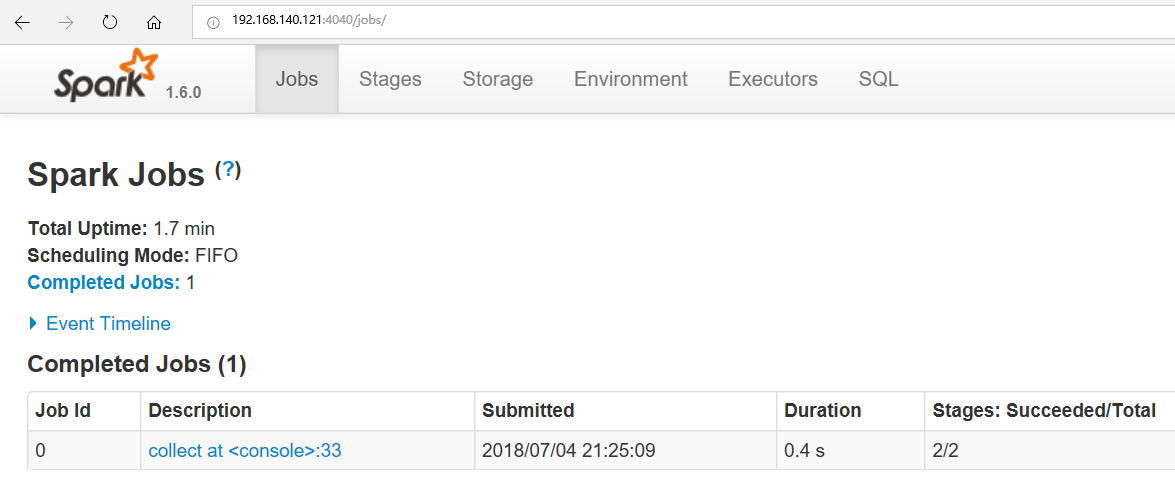

2.4040端口可以访问

、

、

点进去: