此文是基于上一篇文章:Hive默认数据库修改配置

(HBase先在集群master01、master02、slave01、slave02、slave03环境配置)

一、安装包初始安装

上传hbase-1.2.6-bin.tar.gz到/install目录;

解压安装到/software目录:

tar -zxvf hbase-1.2.6-bin.tar.gz -C /software/

配置运行环境文件:vi /etc/profile

JAVA_HOME=/software/jdk1.7.0_79 HADOOP_HOME=/software/hadoop-2.7.3 HBASE_HOME=/software/hbase-1.2.6 PATH=$PATH:$JAVA_HOME/bin:$JAVA_HOME/lib:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$HBASE_HOME/bin export PATH JAVA_HOME HADOOP_HOME HBASE_HOME

分发环境配置到每个机器:

su -lc "scp -r /etc/profile slave01:/etc/"

每个机器执行以下语句,让环境配置立即生效:

source /etc/profile

二、配置HBase集群文件:

cd /software/hbase-1.2.6/conf

①vi hbase-env.sh

修改:

29 export JAVA_HOME=/software/jdk1.7.0_79

#关闭HBase内置的zookeeper实现,准备启用外接的zookeeper来实现

132 export HBASE_MANAGES_ZK=false

②修改HBase的主配置文件:vi hbase-site.xml

configuration中添加:

<!-- 指定HBase在hdfs在上存储的路径 -->

<property> <name>hbase.rootdir</name> <value>hdfs://ns1/user/hbase</value> </property>

<!-- 指定hbase是分布式的,HBase可以部署为分布式的NOSQL数据库,这点与hive不同 -->

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<!-- 指定外部zookeeper集群,多个用","分割 -->

<property> <name>hbase.zookeeper.quorum</name> <value>slave01:2181,slave02:2181,slave03:2181</value> </property>

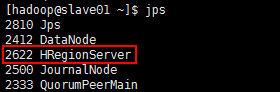

③指定HBase的集群从节点,类似于hadoop下的slave从节点

vi regionservers

内容:(删除localhost)

slave01

slave02

slave03

分发hbase配置到各个机器:

su -lc "scp -r /software/hbase-1.2.6 slave01:/software"

因为hbase需要去连接hdfs,所以要拷贝这个配置文件:

每个机器都要执行:(并修改hbase-1.2.6文件夹的用户权限)

cp -a /software/hadoop-2.7.3/etc/hadoop/{core-site.xml,hdfs-site.xml} /software/hbase-1.2.6/conf/

chown -R hadoop:hadoop /software/hbase-1.2.6/

三、启动测试安装和配置是否生效:大数据学习交流QQ群:217770236 让我们一起学习大数据

【slave各节点启动zookeeper集群:】

cd /software/zookeeper-3.4.10/bin/ && ./zkServer.sh start && cd - && jps

【master01启动HDFS集群:】

cd /software/ && start-dfs.sh && jps

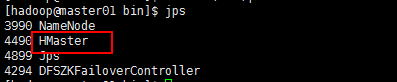

【master01启动HBase:】

cd /software/hbase-1.2.6/bin && start-hbase.sh && jps

【master02上启动HBase:】

cd /software/hbase-1.2.6/bin && hbase-daemon.sh start master && jps

如有节点启动出现故障:

单独启动master:

cd /software/hbase-1.2.6/bin && hbase-daemon.sh start master && jps

单独启动regionserver:

cd /software/hbase-1.2.6/bin && hbase-daemon.sh start regionserver && jps

通过命令终端查看:

hbase(main):009:0> status

通过web终端查看:

http://master01的IP地址:16010/

由于CloudDeskTop要进行java客户端的开发所以也要配置HBase;

su -lc "scp -r /etc/profile slave01:/etc/" source /etc/profile su -lc "scp -r /software/hbase-1.2.6 slave01:/software" #修改用户权限 chown -R hadoop:hadoop /software/hbase-1.2.6/