一、概述

1.1 说明

虽然目前 Hadoop 的最新版本为 3.0.0,但是我安装的 Hadoop 的版本为 2.7.3。

1.2 参考资料

官方文档:

http://hadoop.apache.org/docs/r2.7.3/index.html

二、Hadoop 的安装

2.1 Java 安装

由于 Hadoop 基于 Java,需要 Java 的支持,因此,需要首先安装好 Java。

2.2 ssh 的安装

Hadoop 集群需要 ssh 作支撑,因此需要安装 ssh。

sudo apt install openssh-server

sudo apt install openssh-client

2.3 Hadoop 下载

从 Apache 上下载 Hadoop 的安装包(是个压缩包,解压即可)

http://www.apache.org/dyn/closer.cgi/hadoop/common/

2.4 Hadoop 安装

首先,使用 tar -xzf hadoop-2.7.3.tar.gz 对安装包进行解压。

然后,将解压后的文件改名 sudo mv hadoop-2.7.3 hadoop.

最后,将该安装目录放到 /usr/local/ 目录下。sudo cp hadoop /usr/local.

三、Hadoop 的配置

详细配置:

https://www.digitalocean.com/community/tutorials/how-to-install-hadoop-on-ubuntu-13-10

3.1 配置环境变量

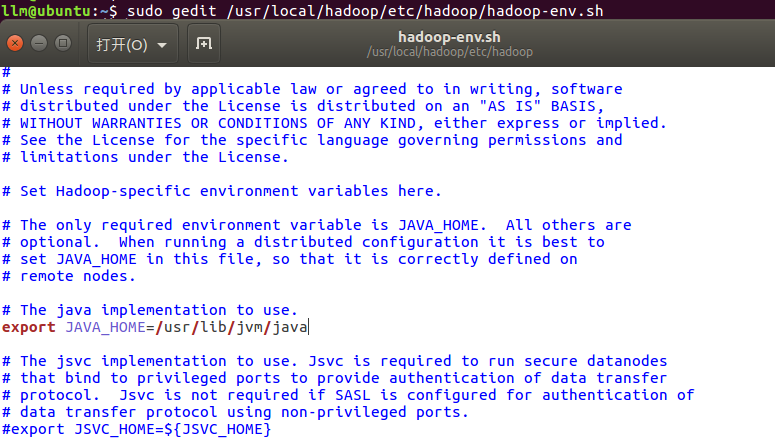

进入 /usr/local/hadoop/etc/hadoop/hadoop-env.sh 文件,修改如下:

set to the root of your Java installation

export JAVA_HOME=/usr/java/latest

3.2 安装测试

在 /usr/local/hadoop/ 下运行 bin/hadoop:

四、安装与配置常常出现的问题

4.1 配置过程中,dataNode 无法启动

主要原因是多次 format namenode ,而 datanode 不会进行 format 操作,从而造成 namenode 和 datanode 的 clusterID 不一致,致使 datanode 无法启动。建议查看datanode上面的log信息。

解决办法:修改每一个 datanode 上面的 CID (位于 dfs/data/current/VERSION 文件夹中)使两者一致。

或者:是删除datanode里面的dfs.datanode.data.dir目录和tmp目录,然后再启动start-dfs.sh

4.2 master 与 slaves 安装目录的问题

master 和所有的 slaves 的 hadoop 安装路径要一致,而且所有的配置文件

4.3 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

网上查了一下资料,说是32位 hadoop 部署在了64为linux上。hadoop2.2.0遇到64位操作系统平台报错,重新编译hadoop :http://blog.csdn.net/bamuta/article/details/13506893