1.1上下文切换

单核处理器也支持多线程执行代码,CPU通过给每个线程分配CPU时间片来实现这个机制。时间片是CPU分配给各个线程的时间,因为时间片非常短,所以CPU通过不停的切换线程执行。

CPU通过时间片分配算法来循环执行任务,当前任务执行一个时间片后会切换到下一个任务。但是在切换之前会保存上一个任务的状态,以便下一次切换回下一个任务时,可以再加载这个任务的状态,所以任务从保存到在加载的过程就是一次上下午切换。

这就像我们同时读两本书,当我们再度一本英文的技术书时,发现某个单词不认识,于是打开英文词典,但是在放下技术书之前我们需要记下这本书读到了多少页的多少行,等查完单词之后,在能够继续读这本书。这样切换会影响读书的效率,同样上下文切换也会影响多线程的执行速度。

1.1.1多线程一定快吗

public class ConcurrencyTest {

private static final long count = 100001;

public static void main(String[] args) throws InterruptedException {

concurrency();

serial();

}

private static void concurrency() throws InterruptedException {

long startTime = System.currentTimeMillis();

Thread thread = new Thread(() -> {

int a = 0;

for (long i = 0; i < count; i++) {

a += 5;

}

});

thread.start();

int b = 0;

for (long i = 0; i < count; i++) {

b--;

}

thread.join();

long endTime = System.currentTimeMillis();

System.out.println(endTime - startTime+"ms,b = "+b);

}

private static void serial(){

long startTime = System.currentTimeMillis();

int a = 0;

for (long i = 0; i < count; i++) {

a += 5;

}

int b = 0;

for (long i = 0; i < count; i++) {

b--;

}

long endTime = System.currentTimeMillis();

System.out.println(endTime - startTime+"ms,b = "+b+"---a="+a);

}

}

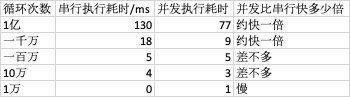

从表中发现,当并发执行累加操作不超过百万次时,速度会比串行执行累加操作要慢,为什么并发执行的速度会比串行慢呢?这是因为线程的创建和上下文切换的开销。

1.1.2 测试上下文的切换次数和时长

1.1.3如何减少上下文切换

减少上下文切换的方法有 无锁并发编程、CAS算法、使用最少线程和使用协程

1.无锁并发编程:多线程竞争时,会引起上下文的切换,所以多线程处理数据时,可以用一些办法来避免使用锁,如将数据的ID按照Hash算法取模分段,不同的线程处理不同的数据。

2.CAS算法。java的Atomic包使用CAS算法来更新数据,而不需要加锁。

3.使用最少线程:避免创建不需要的线程,比如任务很少,但是创建了很多线程来处理,这样会造成大量线程处于等待状态。

4.协程:在单线程里实现多任务的调度,并在单线程里维持多个任务间的切换。

1.1.4减少上下文切换的实战(通过减少线上的大量waiting的线程,来减少上下文的切换次数)

1.用jstack命令dump线程信息,看看pid为31177的进程都在做什么

sudo -u admin /opt/ifeve/java/bin/jstack 31177 > /home/tengfei.fangtf/dump12

2.统计所用线程分别处于什么状态,发现300多个线程处于waiting(onobject-monitor)状态

3.打开dump文件查看处于WAITING(onobject-monitor)的线程都在做什么。发现这些线程基本全是JBOSS的工作线程,在await。说明JBOSS线程池里面接收到的任务太少,大量线程空闲

4.减少JBOSS的工作线程数,找到JBOSS的线程池配置信息,将maxThread降到100.

5.重启JBOSS在dump线程信息,waiting的线程少了,系统上下文切换的次数就会少,因为每一次从WAITING到RUNNING都会进行一次上下文的切换,也可以使用cnstat命令

1.2 死锁

public class DeatLockDemo {

private static String A = "A";

private static String B = "B";

public static void main(String[] args) {

new DeatLockDemo().deadLock();

}

private void deadLock() {

Thread thread = new Thread(() -> {

synchronized (A){

try {

Thread.currentThread().sleep(2000);

} catch (InterruptedException e) {

e.printStackTrace();

}

synchronized (B){

System.out.println("1");

}

}

});

Thread thread1 = new Thread(() -> {

synchronized (B){

synchronized (A){

System.out.println("2");

}

}

});

thread.start();

thread1.start();

}

}

在复杂的场景,你可能会遇到这样问题,比如t1拿到锁之后,因为一些异常情况没有释放锁(死循环),又或者是t1拿到一个数据库锁释放锁的时候抛出异常,没有释放掉

一旦出现死锁,业务是可感知的,因为不能继续提供服务了,那么只能通过dump线程查看到底是哪个线程出现了问题。

避免死锁的几个常见方法

1.避免一个线程同时获取多个锁

2.避免一个线程在锁内占用多个资源,尽量保证每个锁只能占用一个资源

3.尝试使用定时锁,使用lock.tryLock(timeout)来替代使用内部锁机制

4.对于数据库锁,加锁和解锁必须在一个数据库里,否则会出现解锁失败的情况

1.3 资源限制

1.什么是资源限制

资源限制是指在并发编程时,程序的执行速度受限于计算机硬件资源或软件资源。例如,服务器的带宽只用2MB/s,系统启动10个线程下载资源,下载速度不会变成10mb/s,所以在进行并发编程时,要考虑这些资源的限制。硬件资源限制有带宽上传/下载速度、硬盘读写速度和cpu的处理速度。软件资源限制有数据库的连接数和socket连接数

2.资源限制引发的问题

在并发编程中,将代码执行速度加快的原则是将代码中串行执行的部分变成并发执行,但是如果将某段串行代码并发执行,因为受限于资源,仍然在串行执行,这时候程序不仅不会加快执行,反而会更慢,因为增加了上下文的切换和资源调度时间。例如,之前看到一段程序使用多线程在办公网并发地下载和处理数据时,导致CPU利用率达到100%,几个小时都不能运行完成任务,后来修改了单线程,一个小时就执行完成了。

3.如何解决资源限制的问题

对于硬件资源限制,可以考虑使用集群并行执行程序,既然单机的资源限制,那么就让程序在多机上运行。比如使用ODPS/Hadoop或者自己搭建集群,不同的机器处理不同的数据。可以通过“数据ID%机器数”,计算得到一个机器编号,然后有对应编号的机器处理这笔数据。

对于软件资源限制,可以考虑使用资源池将资源复用。比如使用连接池将数据库和Socket连接复用,或者在调用对方webswevice接口获取数据是只建立一个连接。

4.在资源限制情况下进行并发编程

如何在资源限制的情况下,让程序执行的更快呢?方法就是,根据不同资源限制调整的并发度,比如下载文件程序依赖于两个资源——带宽和硬盘读写速度。有数据库操作时,涉及数据库连接数,如果SQL语句执行非常快,而线程的数量比数据库连接数大很多,则某些线程会被阻塞,等待数据库连接。

1.4 本章小结

本章介绍了在进行并发编程时遇到的问题,并给出了一些解决意见,有的并发程序写得不严谨,在并发下如果出现问题,定位起来会比较耗时和棘手,所以Java开发工程师,多使用jdk并发包提供的并发容器和工具类来解决并发问题,因为这些类已经通过了充分的测试和优化,均可解决本文的问题