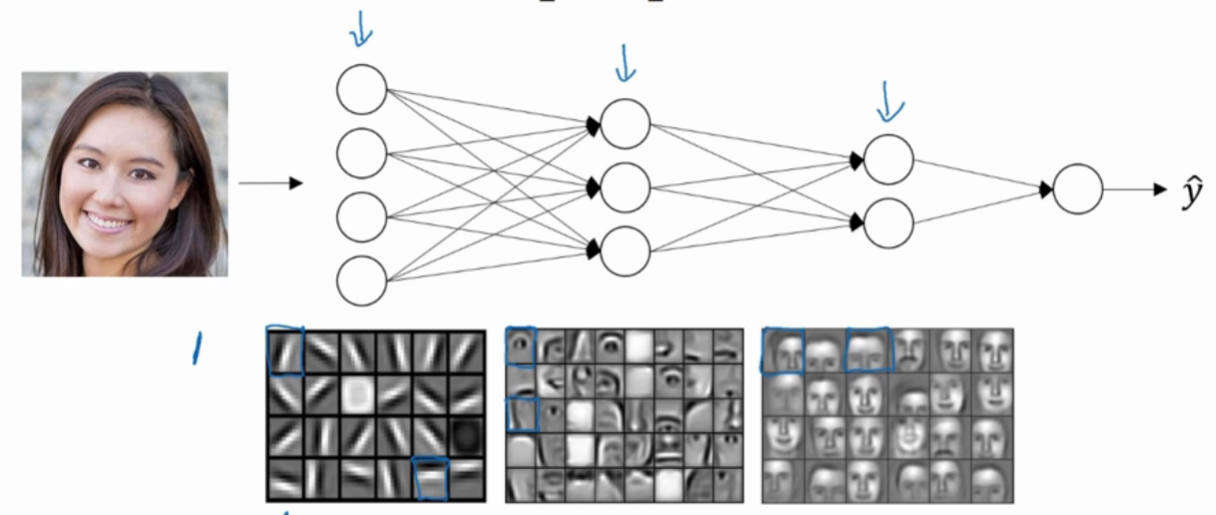

- 通过深层神经网络首先会选取一些边缘信息(卷积中的核只有3X3 5X5非常小),总之是一些边角之类的低层信息(边缘信息是为了将要观察的事物与周围环境分割开来)

- 随着网络深度的增加,卷积核的有效感受野越来越大,也就意味着高层的卷积核能够覆盖更大尺度上的特征

例如CNN

CNN就是尺度上不断降维,特征上不断升维。卷积核尺寸不变,但是卷积的对象不断池化,也就相当于卷积核的尺寸扩大了。

尺度上越降维,大尺度上的特征数量就越多,但是也越稀疏。

拿汉字举例:小尺度上,无非横竖撇捺几个特征;中等尺度上,各种偏旁部首几百种;大尺度上,就是几千上万个汉字了。

不断地使用某个尺寸的特征去组合成下一个更大尺度的更多的特征,

参数训练减少

很多数学函数用深网络比浅网络要容易学习得多,比如很多个数异或,用深网络,学习到一棵树,计算复杂度为$ log_N $ 。用单隐层学习的话,需要 (2^{n-1})个隐藏单元。

局部特征关联