1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

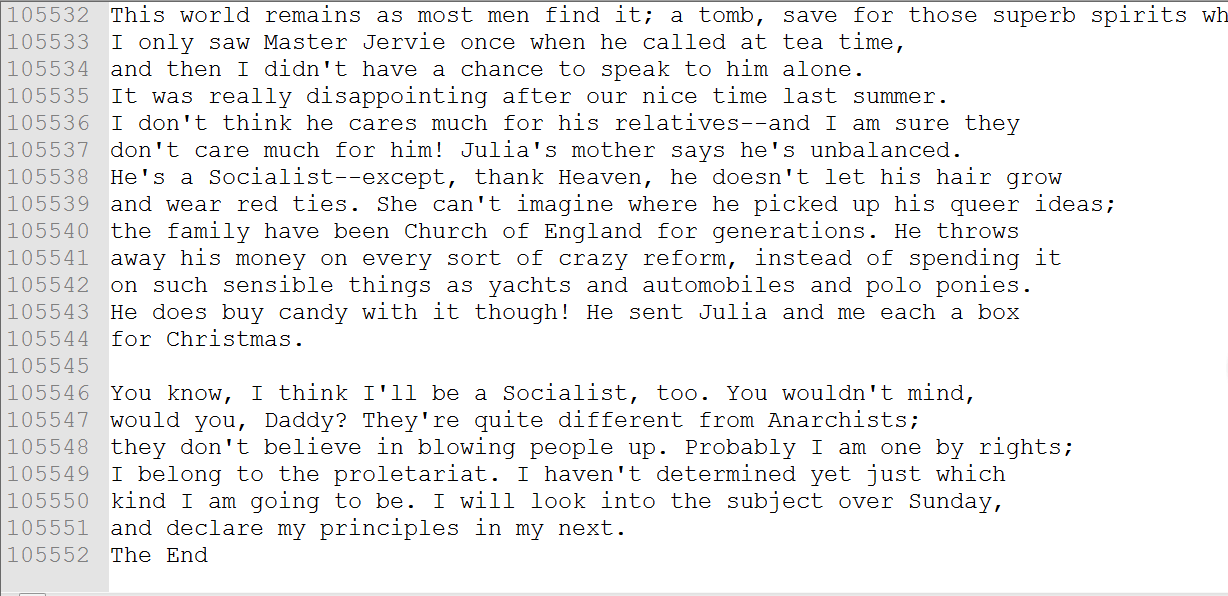

到http://novel.tingroom.com/duanpian/2123/英文小说网下载英文小说,总共10万多行

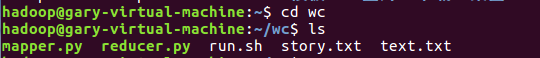

通过WinSCP将该文件放置在虚拟机的wc文件目录下

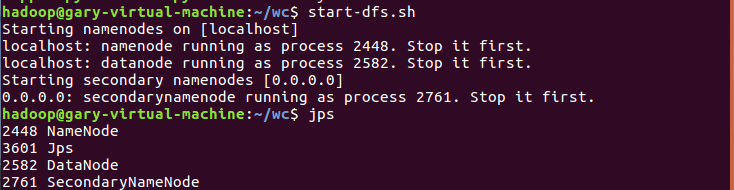

启动hadoop

将wc文件夹的story.txt上传文件至hdfs的hive文件夹

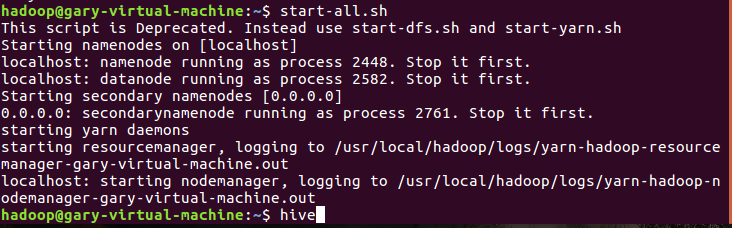

启动Hive

创建原始文档表

导入文件内容到表docs并查看

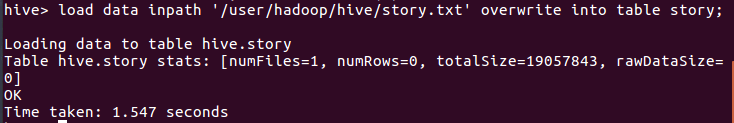

导入文件:

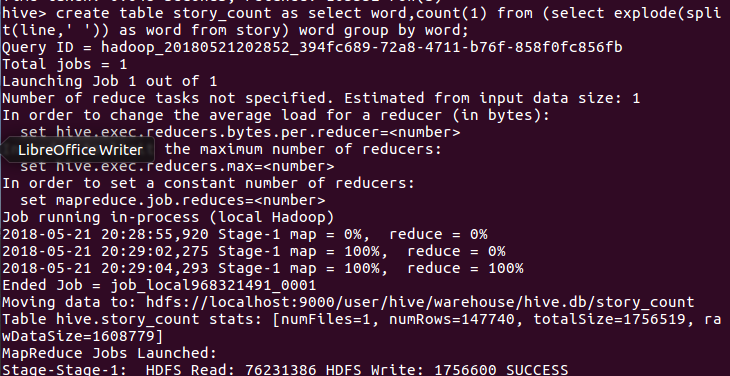

用HQL进行词频统计,结果放在表story_count里

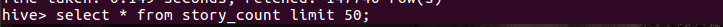

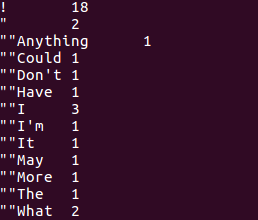

查看统计结果

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

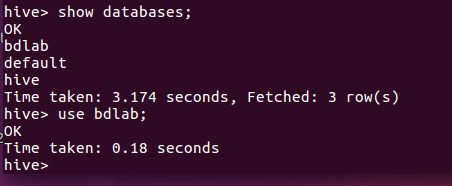

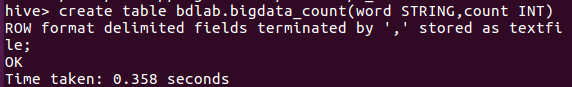

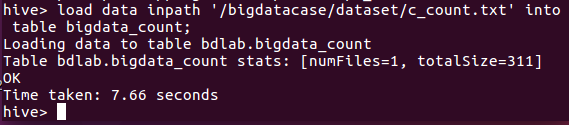

同上,将爬虫大作业产生的txt文件放入bdlab数据库表bigdata_count中:

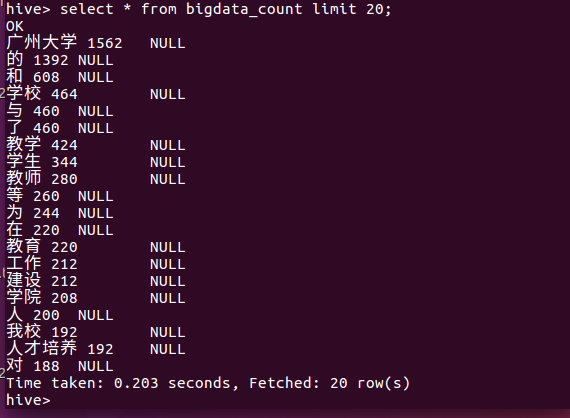

通过QQ邮箱,将爬虫大作业文本文件下载并放于虚拟机 /home/hadoop/wc 目录下,爬虫一共爬取了广州大学新闻网的全部新闻,共8300多条。

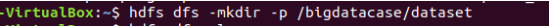

创建用于存放csv数据目录:

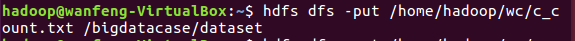

把文件放入文件夹中

查看文件中的数据:

导入数据库表中

查看数据:

主要是爬取广州大学的校园新闻,让我们能更进一步地了解到其他校园的校园新闻,获取其他学校的信息,来对比我们学校与其学校的异同之处。