对于流量回放这个词,很多同学并不陌生,但绝大多数公司因种种原因并没有进行实践,最现实的原因是由于做全链路的流量回放有大量的写操作,必然要涉及到系统改造,数据加工脱敏等,技术难度和风险相对较高,并非每一家公司都如阿里巴巴一样具备大流量的应用场景,在系统改造不彻底的情况下,存在投入产出失衡的现象,这不仅是技术的问题,也需要文化的支持,从个人角度而言我们依然可以进行一些模拟,这次我总结了以goreplay工具的轻量级流量回放使用方法。

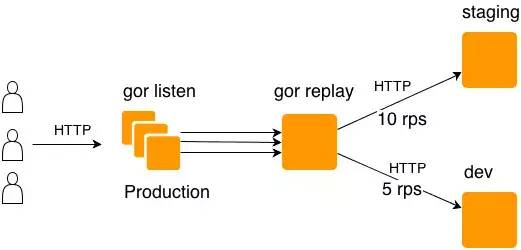

首先简单描述下goreplay工作流:

我们什么情况下可以用gorepaly去验证呢?

1.在预发布环境需要真实流量做功能的回归与验证;

2.验证网络带宽流量阈值

3.真实线上流量对比验证

如何去验证?

提供源码下载包,注意 :使用goreplay均在root权限或者使用sudo执行;

https://pan.baidu.com/s/1cfBnfbLaQntak4SMD8YPKw 密码:jcfl

1.下载完解压缩

tar xvf gor_1.0-RC2_x64.tar.gz

2.捕捉流量并通过终端输出

sudo ./goreplay --input-raw :8003 --output-stdout

上述命令将监控8003端口上所有的流量,并通过终端stdout输出。你可以通过浏览器或者curl访问8003端口,然后在终端查看gor输出所有的http请求。

3.捕捉流量并实时同步到另一台机器

sudo ./goreplay --input-raw :8003 --output-http="http://example:8005"

上述命令将8003端口的流量实时同步访问http://example:8005服务器,你在访问第一台服务器时,将看到流量以相同的顺序请求到第二台.

4.将捕捉流量保存到文件中,然后释放到其它机器,建议实战的时候使用该模式

有时候实时同步流量是很难做到的, 所以Goreplay提供了这种先保存后释放的模式:

第一步, 通过--output-file保存流量:

sudo ./goreplay --input-raw :8003 --output-file=requests.gor

上述命令将8003端口的流量,保存到requests.gor文件中(必须是.gor后缀,其它后缀经测释放时有问题)。

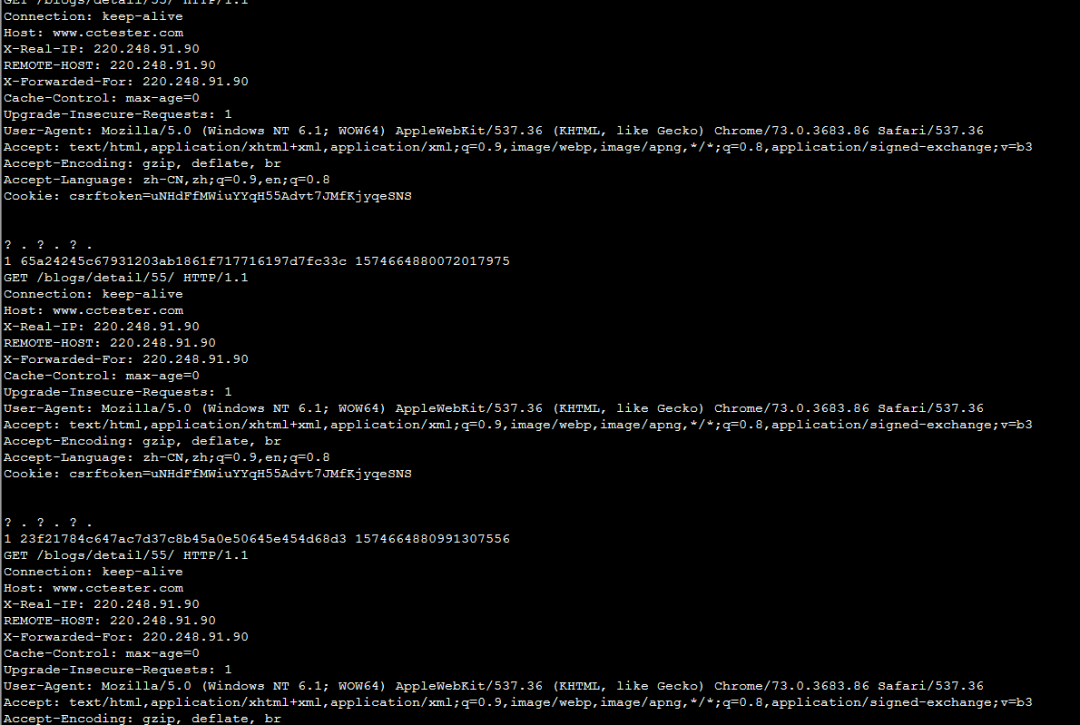

我们打开录制完成的gor文件发现,它保存了我们所有的请求内容(如下图):

第二步,如上图保存的流量,我们可以原来的方式执行释放:

./goreplay --input-file requests.gor --output-http="http://localhost:8005"

上述命令将释放所有保存在requests.gor中的请求通过相同的时间顺序释放到服务器http://localhost:8005。

附上常用的参数解释:

--input-raw #用来捕捉http流量,需要指定ip地址和端口

--input-file #接收通过--output-file保存流量的文件

--input-tcp #将多个 Goreplay 实例获取的流量聚集到一个 Goreplay 实例

--output-stdout #终端输出

--output-tcp #将获取的流量转移至另外的 Goreplay 实例

--output-http #流量释放的对象server,需要指定ip地址和端口 --output-file #录制流量时指定的存储文件

Goreplay的限速加速机制和请求过滤

无论是限速或者加速都具有现实意义,也是流量回放的亮点之一:

1.限速机制:

由于生产服务器配置一般远高于测试服务器配置,所以直接将生产服务器全部流量同步到测试服务器是不可行的,goreplay提供了两种策略:

限制每秒的请求数

sudo ./goreplay --input-tcp :888 --output-http "http://staging.com|20"# (每秒请求数限制20个以内)

sudo ./goreplay --input-raw :80 --output-tcp "replay.local:888|20%" # (每秒请求数限制20%以内)

基于Header或Url的参数限制一些请求,为指定的header或者url的请求设定限制的百分比。

sudo ./goreplay --input-raw :80 --output-tcp "replay.local:888|20%" --http-header-limiter "X-API-KEY: 20%"

sudo ./goreplay --input-raw :80 --output-tcp "replay.local:888|20%" --http-param-limiter "api_key: 20%"

2.可以限制一些流量,我们就可以进行流量翻倍,也就是我刚刚提到的流量加速:

./gor --input-file '696_0.gor|1000%' --input-file-loop --output-http 'http://www.xxx.com' --output-http-workers 10 --stats --output-http-stats

1000%等于翻了10倍,workers代表消费的进程数,流量翻倍建议梯度缓慢增加,防止造成应用直接宕机的情况;

3.请求过滤:

当你需要捕捉指定路径的请求流量时,可以使用该机制, 如只同步/api路径下的请求

sudo ./goreplay --input-raw :8080 --output-http staging.com --http-allow-url /api

这样的方法可以对单请求进行压测,也是非常实用

另外还有其它一些参数用法:

--http-disallow-url #不允许正则匹配的Url

--http-allow-header #允许的 Header 头

--http-disallow-header #不允许的 Header 头

--http-allow-method #允许的请求方法,传入值为GET, POST, OPTION

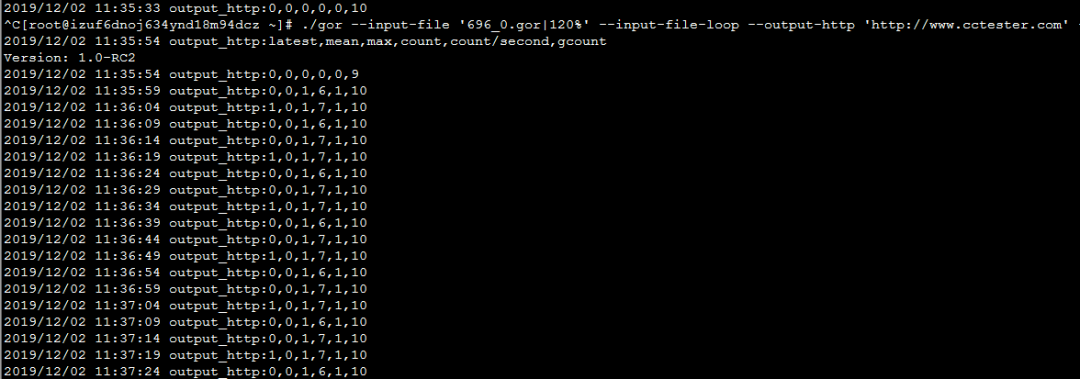

执行结果查看:

./gor --input-file '696_0.gor|1000%' --input-file-loop --output-http 'http://www.cctester.com' --output-http-workers 10 --stats --output-http-stats

执行结果的查看,在很多文档中,并没有对执行结果有详尽的阐述,但结果的查看对性能测试具有最直接的意义,性能测试人员一般会从客户端工直接获取结果,不过相对成熟的互联网公司一般不会局限于此,我们有更多的服务端工具进行统计,很多公司会自己去研发,也有付费的工具如听云等,goreplay提供的结果相对简单(如下图),最后一列为取样数,倒数第二列为取样/时间,可以理解为我们常见的qps;