Hive简介

- Hive是构建在Hadoop之上的数据操作平台

- Hive是一个SQL解析引擎,它将SQL转译成MapReduce作业,并在Hadoop上运行

- Hive表是HDFS的一个文件目录,一个表名对应一个目录名,如果存在分区表的话,则分区值对应子目录名。

Hive的安装与配置

hive2.3.5百度网盘版本下载链接

链接:https://pan.baidu.com/s/1jmHa2DruuuyueEL22zI_yg

提取码:xj5p

Dbvis客户端操作页面

链接:https://pan.baidu.com/s/1gTXBdx8PKvcQGazeqMuotg

提取码:1x3o

下载完毕通过XFTP上传到指定的安装目录

将压缩包解压到对应目录

tar -zxvf /usr/localhost/apache-hive-2.3.5-bin.tar.gz

将解压的目录重命名为hive

mv apache-hive-2.3.5-bin/ hive

设置hive的环境的变量

vim /etc/profile

编辑内容如下(在profile文件)

export HIVE_HOME=/usr/local/hive(视自己的安装目录修改)

export PATH=$PATH:$HIVE_HOME/bin

刷新文件(保存后)

source /etc/profile

切换到hive的配置文件目录

cd /usr/local/hive/conf/

以模板复制一个hive-site.xml

cp hive-default.xml.template hive-site.xml

编辑hive-site.xml文件

vim hive-site.xml

将以下内容插入到hive-site.xml文件,在configuration里添加

<property><!--数据库用户名-->

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property><!--数据块密码-->

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

<property><!--连接字符串-->

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://127.0.0.1:3306/hive?createDatabaseIfNotExist=true</value>

</property>

<property><!--驱动类-->

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<!--关闭数据库的版本检查-->

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

接下来将mysql的数据库驱动包放置到hive下的lib目录中

链接:https://pan.baidu.com/s/1sTODKz6Drsr-sF8x3Ha1PQ

提取码:fxpy

如果自己有则可以使用自己的版本我这个是5.1.32的

初始化Hive元数据

schematool -dbType mysql -initSchema

进入hdfs配置目录下修改hdfs-site.xml

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

修改core-site.xml

<property> <name>hadoop.proxyuser.root.hosts</name> <value>*</value> </property> <property> <name>hadoop.proxyuser.root.groups</name> <value>*</value> </property>

使用scp命令发送到slave1与slave2两台节点上

scp hdfs-site.xml core-site.xml root@slave1:/usr/local/hadoop-2.8.0/etc/hadoop/

scp hdfs-site.xml core-site.xml root@slave2:/usr/local/hadoop-2.8.0/etc/hadoop/

重启服务 格式化namenode节点

hdfs namenode -format

两种链接HIVE的方法

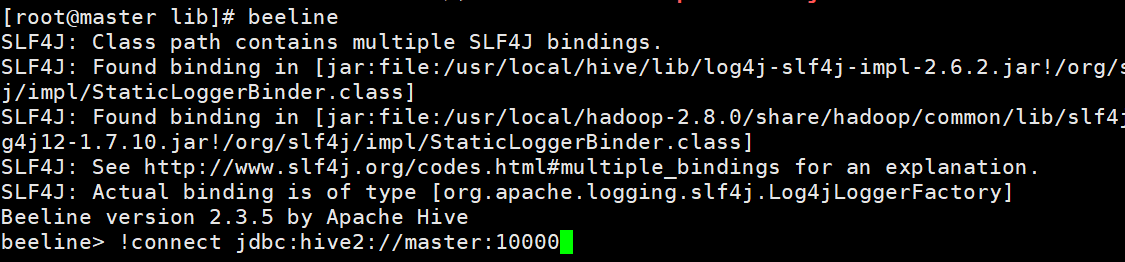

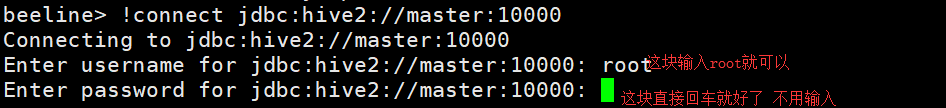

第一种:

在自己的主节点上打开服务hiveserver2

在复制一个主节点beeline连接

在输入!connect jdbc:hive2://master:10000

第二种:

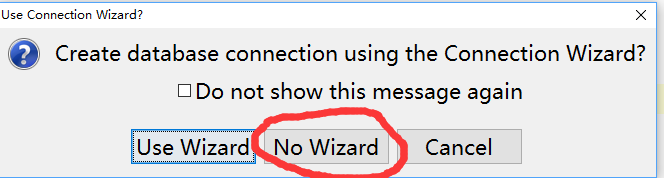

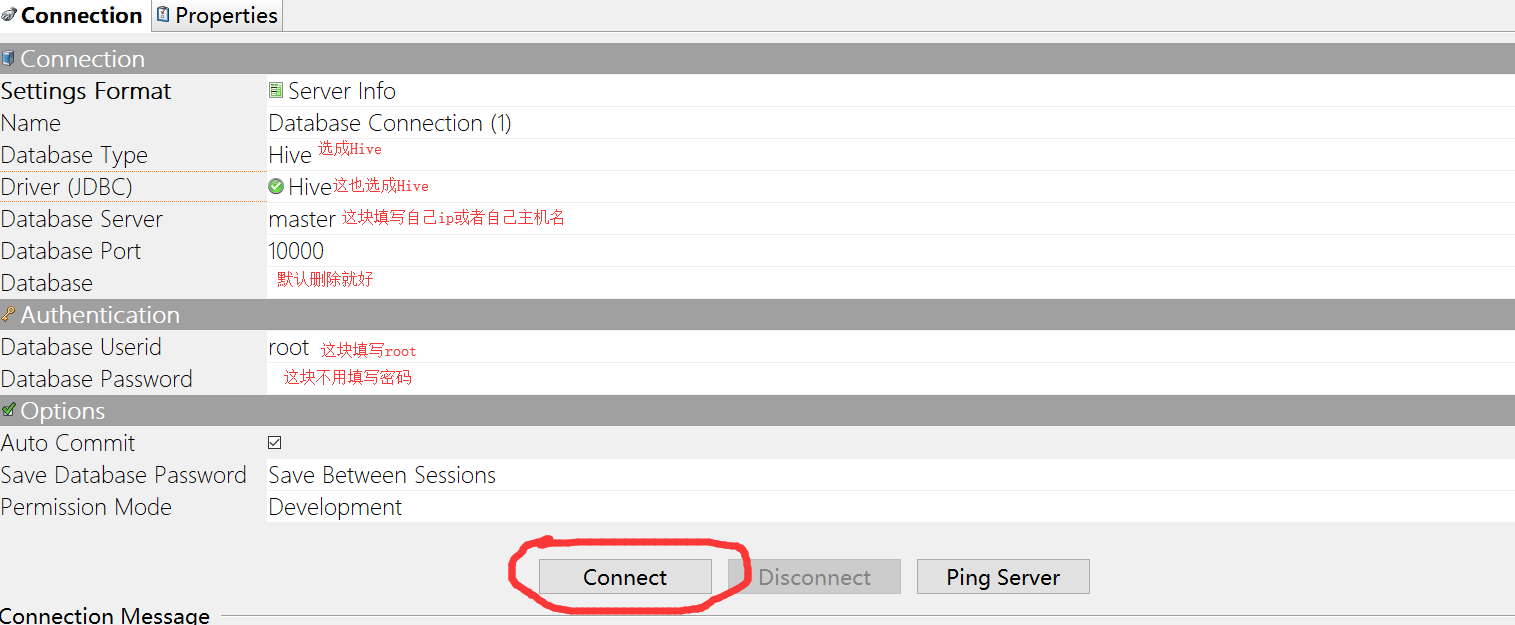

dbvis客户端连接,在上面下载完可以直接使用

注意:不要解压到中文目录文件夹下