浅谈 Hellinger Distance

2016.05.24

最近在看 Hellinger Distance(海林格距离), 平时看多了欧式距离,马氏距离等等,貌似介绍这个的材料不是很多,例如:维基百科上的一些,和 下列这个链接上的pdf材料:http://www.tcs.tifr.res.in/~prahladh/teaching/2011-12/comm/lectures/l12.pdf 大家凑合着看看吧,我这里简要的介绍下,有理解不对的地方,烦劳指点下。

Hellinger Distance 又称 Bhattacharyya distance,因为作者的姓氏叫 Anil Kumar Bhattacharya。在概率和统计学中,Hellinger Distance 被用来衡量两个概率分布之间的相似性,属于 f-divergence 的一种。而 f-divergence 又是什么呢?一个 f-divergence 是一个函数 Df(P||Q) 用来衡量两个概率分布P and Q 之间的不同。

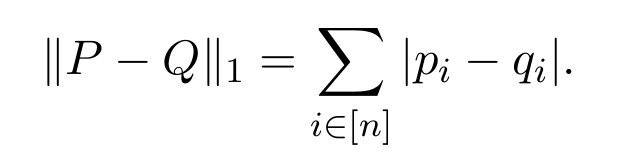

我们假设基于[n],有两个概率分布 P = {pi}i∈[n], Q = {qi}i∈[n] 。一个很自然的方法来定义两者之间的距离就是考虑两个概率向量 P and Q 之间的 L1-distance:

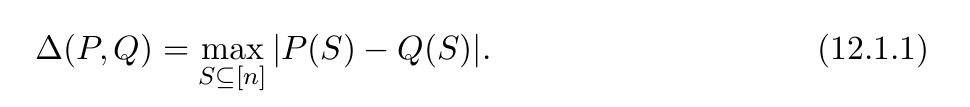

总的变换距离(the total variation distance),记为 Δ(P, Q),是上述等式的一半。

显然:

定义:

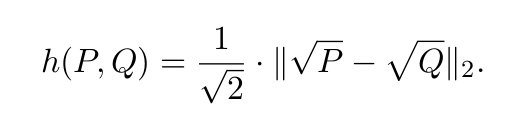

对于概率分布 P = {pi}i∈[n], Q = {qi}i∈[n],两者之间的Hellinger distance 定义为:

根据定义,Hellinger distance 是一种满足三角不等式(triangle inequality)的度量。根号下2是为了确保对于所有的概率分布,都有 h(P, Q) <= 1。

相关的性质:

x