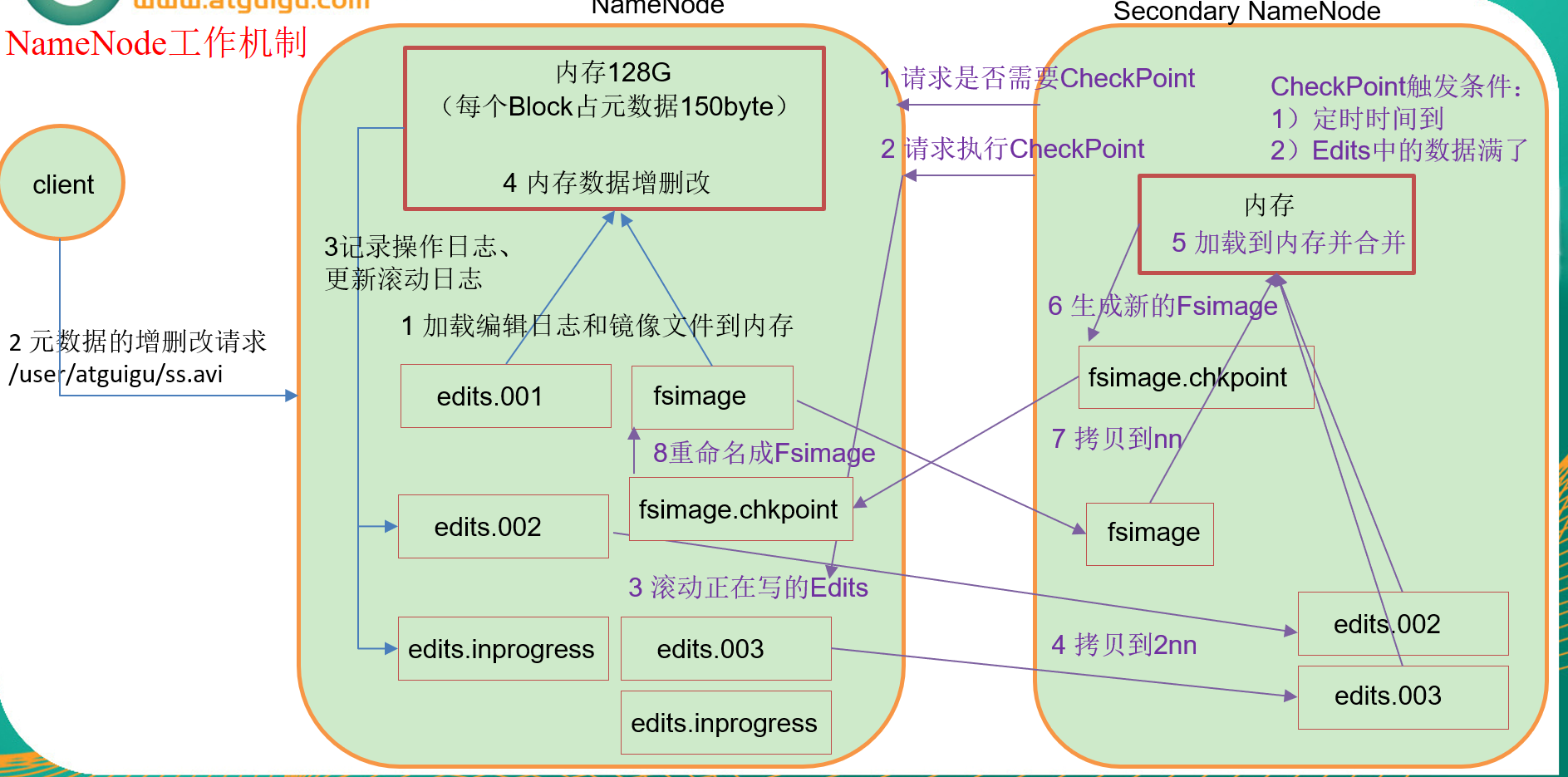

一、NameNode & SecondaryNameNode 工作机制

1. 第一阶段:NameNode启动

(1)第一次启动NameNode格式化后,创建Fsimage和Edits文件。如果不是第一次启动,直接加载编辑日志和镜像文件到内存。

(2)客户端对元数据进行增删改的请求。

(3)NameNode记录操作日志,更新滚动日志。

(4)NameNode在内存中对数据进行增删改。

2. 第二阶段:Secondary NameNode工作

(1)Secondary NameNode询问NameNode是否需要CheckPoint。直接带回NameNode是否检查结果。

(2)Secondary NameNode请求执行CheckPoint。

(3)NameNode滚动正在写的Edits日志。

(4)将滚动前的编辑日志和镜像文件拷贝到Secondary NameNode。

(5)Secondary NameNode加载编辑日志和镜像文件到内存,并合并。

(6)生成新的镜像文件fsimage.chkpoint。

(7)拷贝fsimage.chkpoint到NameNode。

(8)NameNode将fsimage.chkpoint重新命名成fsimage。

工作机制:

Fsimage:NameNode内存中元数据序列化后形成的文件。

Edits:记录客户端更新元数据信息的每一步操作(可通过Edits运算出元数据)。

NameNode启动时,先滚动Edits并生成一个空的edits.inprogress,然后加载Edits和Fsimage到内存中,此时NameNode内存就持有最新的元数据信息。Client开始对NameNode发送元数据的增删改的请求,这些请求的操作首先会被记录到edits.inprogress中(查询元数据的操作不会被记录在Edits中,因为查询操作不会更改元数据信息),如果此时NameNode挂掉,重启后会从Edits中读取元数据的信息。然后,NameNode会在内存中执行元数据的增删改的操作。

由于Edits中记录的操作会越来越多,Edits文件会越来越大,导致NameNode在启动加载Edits时会很慢,所以需要对Edits和Fsimage进行合并(所谓合并,就是将Edits和Fsimage加载到内存中,照着Edits中的操作一步步执行,最终形成新的Fsimage)。SecondaryNameNode的作用就是帮助NameNode进行Edits和Fsimage的合并工作。

SecondaryNameNode首先会询问NameNode是否需要CheckPoint(触发CheckPoint需要满足两个条件中的任意一个,定时时间到和Edits中数据写满了)。直接带回NameNode是否检查结果。SecondaryNameNode执行CheckPoint操作,首先会让NameNode滚动Edits并生成一个空的edits.inprogress,滚动Edits的目的是给Edits打个标记,以后所有新的操作都写入edits.inprogress,其他未合并的Edits和Fsimage会拷贝到SecondaryNameNode的本地,然后将拷贝的Edits和Fsimage加载到内存中进行合并,生成fsimage.chkpoint,然后将fsimage.chkpoint拷贝给NameNode,重命名为Fsimage后替换掉原来的Fsimage。NameNode在启动时就只需要加载之前未合并的Edits和Fsimage即可,因为合并过的Edits中的元数据信息已经被记录在Fsimage中。

二、 Fsimage和Edits 介绍

1、感念:

2、oiv查看Fsimage文件

语法:hdfs oiv -p 文件类型 -i镜像文件 -o 转换后文件输出路径

进入对应目录

[hui@hadoop103 current]$ pwd

/opt/module/hadoop-2.7.2/data/tmp/dfs/name/current

[hui@hadoop103 current]$ hdfs oiv -p XML -i fsimage_0000000000000000050 -o /opt/module/hadoop-2.7.2/fsimage.xml

查看输出文件:

[hui@hadoop103 hadoop-2.7.2]$ cat fsimage.xml <?xml version="1.0"?> <fsimage><NameSection> <genstampV1>1000</genstampV1><genstampV2>1004</genstampV2><genstampV1Limit>0</genstampV1Limit><lastAllocatedBlockId>1073741828</lastAllocatedBlockId><txid>50</txid></NameSection> <INodeSection><lastInodeId>16394</lastInodeId><inode><id>16385</id><type>DIRECTORY</type><name></name><mtime>1599270491174</mtime><permission>hui:supergroup:rwxr-xr-x</permission><nsquota>9223372036854775807</nsquota><dsquota>-1</dsquota></inode> <inode><id>16386</id><type>DIRECTORY</type><name>user</name><mtime>1599625011446</mtime><permission>hui:supergroup:rwxr-xr-x</permission><nsquota>-1</nsquota><dsquota>-1</dsquota></inode> <inode><id>16387</id><type>DIRECTORY</type><name>xajh</name><mtime>1597202263118</mtime><permission>hui:supergroup:rwxr-xr-x</permission><nsquota>-1</nsquota><dsquota>-1</dsquota></inode> <inode><id>16388</id><type>FILE</type><name>huasan</name><replication>3</replication><mtime>1597202263109</mtime><atime>1597202262028</atime><perferredBlockSize>134217728</perferredBlockSize><permission>hui:supergroup:rw-r--r--</permission><blocks><block><id>1073741825</id><genstamp>1001</genstamp><numBytes>20</numBytes></block> </blocks> </inode> <inode><id>16389</id><type>DIRECTORY</type><name>h1</name><mtime>1599625346250</mtime><permission>hui:supergroup:rwxr-xr-x</permission><nsquota>-1</nsquota><dsquota>-1</dsquota></inode> </INodeSection> <INodeReferenceSection></INodeReferenceSection><SnapshotSection><snapshotCounter>0</snapshotCounter></SnapshotSection> <INodeDirectorySection><directory><parent>16385</parent><inode>16389</inode><inode>16386</inode></directory> <directory><parent>16386</parent><inode>16387</inode></directory> <directory><parent>16387</parent><inode>16388</inode></directory> </INodeDirectorySection> <FileUnderConstructionSection></FileUnderConstructionSection> <SnapshotDiffSection><diff><inodeid>16385</inodeid></diff></SnapshotDiffSection> <SecretManagerSection><currentId>0</currentId><tokenSequenceNumber>0</tokenSequenceNumber></SecretManagerSection><CacheManagerSection><nextDirectiveId>1</nextDirectiveId></CacheManagerSection> </fsimage> [hui@hadoop103 hadoop-2.7.2]$

3、. oev查看Edits文件

[hui@hadoop103 current]$ hdfs oev -p XML -i edits_0000000000000000044-0000000000000000050 -o /opt/module/hadoop-2.7.2/edits.xml

[hui@hadoop103 hadoop-2.7.2]$ cat edits.xml <?xml version="1.0" encoding="UTF-8"?> <EDITS> <EDITS_VERSION>-63</EDITS_VERSION> <RECORD> <OPCODE>OP_START_LOG_SEGMENT</OPCODE> <DATA> <TXID>44</TXID> </DATA> </RECORD> <RECORD> <OPCODE>OP_RENAME_OLD</OPCODE> <DATA> <TXID>45</TXID> <LENGTH>0</LENGTH> <SRC>/h1/dept.txt</SRC> <DST>/user/dept.txt</DST> <TIMESTAMP>1599624920629</TIMESTAMP> <RPC_CLIENTID>32f5d836-daa5-4f4a-8287-043652333859</RPC_CLIENTID> <RPC_CALLID>3</RPC_CALLID> </DATA> </RECORD> <RECORD> <OPCODE>OP_DELETE</OPCODE> <DATA> <TXID>46</TXID> <LENGTH>0</LENGTH> <PATH>/user/dept.txt</PATH> <TIMESTAMP>1599625011446</TIMESTAMP> <RPC_CLIENTID>14b9105f-0565-4f54-866e-8253affcf1f1</RPC_CLIENTID> <RPC_CALLID>3</RPC_CALLID> </DATA> </RECORD> <RECORD> <OPCODE>OP_DELETE</OPCODE> <DATA> <TXID>47</TXID> <LENGTH>0</LENGTH> <PATH>/h1/h2/h3/dept.txt</PATH> <TIMESTAMP>1599625194889</TIMESTAMP> <RPC_CLIENTID>d3cea48b-7302-4546-bb9f-0336d8f4dafa</RPC_CLIENTID> <RPC_CALLID>3</RPC_CALLID> </DATA> </RECORD> <RECORD> <OPCODE>OP_DELETE</OPCODE> <DATA> <TXID>48</TXID> <LENGTH>0</LENGTH> <PATH>/h1/h2/h3</PATH> <TIMESTAMP>1599625237599</TIMESTAMP> <RPC_CLIENTID>26ad40fd-dfd9-40bb-a669-2a3fe6707e6a</RPC_CLIENTID> <RPC_CALLID>2</RPC_CALLID> </DATA> </RECORD> <RECORD> <OPCODE>OP_DELETE</OPCODE> <DATA> <TXID>49</TXID> <LENGTH>0</LENGTH> <PATH>/h1/h2</PATH> <TIMESTAMP>1599625346250</TIMESTAMP> <RPC_CLIENTID>935b2a33-ba2f-4f2f-9dec-9d3a68af7b62</RPC_CLIENTID> <RPC_CALLID>3</RPC_CALLID> </DATA> </RECORD> <RECORD> <OPCODE>OP_END_LOG_SEGMENT</OPCODE> <DATA> <TXID>50</TXID> </DATA> </RECORD> </EDITS> [hui@hadoop103 hadoop-2.7.2]$

三、CheckPoint时间设置

通常情况下:SecondaryNameNode每隔一小时执行一次,但是可用修改 hdfs-default.xml 进行修改:

property> <name>dfs.namenode.checkpoint.period</name> <value>3600</value> </property >

一分钟检查一次操作次数,当操作次数达到1百万时,SecondaryNameNode执行

<property> <name>dfs.namenode.checkpoint.txns</name> <value>1000000</value> <description>操作动作次数</description> </property> <property> <name>dfs.namenode.checkpoint.check.period</name> <value>60</value> <description> 1分钟检查一次操作次数</description> </property >

四、NameNode 故障处理

NameNode故障后,可以采用如下两种方法恢复数据。

1. kill -9 NameNode进程

2. 删除NameNode存储的数据(/opt/module/hadoop-2.7.2/data/tmp/dfs/name

rm -rf /opt/module/hadoop-2.7.2/data/tmp/dfs/name/*

3. 拷贝SecondaryNameNode中数据到原NameNode存储数据目录

scp -r atguigu@hadoop105:/opt/module/hadoop-2.7.2/data/tmp/dfs/namesecondary/* ./name/

重新启动NameNode

sbin/hadoop-daemon.sh start namenode

第二钟 方式

使用-importCheckpoint选项启动NameNode守护进程,从而将SecondaryNameNode中数据拷贝到NameNode目录中。

1、修改hdfs-site.xml中的

<property> <name>dfs.namenode.checkpoint.period</name> <value>120</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>/opt/module/hadoop-2.7.2/data/tmp/dfs/name</value> </property>

2、kill -9 NameNode进程

3、删除NameNode存储的数据(/opt/module/hadoop-2.7.2/data/tmp/dfs/name)

rm -rf /opt/module/hadoop-2.7.2/data/tmp/dfs/name/*

4、如果SecondaryNameNode不和NameNode在一个主机节点上,需要将SecondaryNameNode存储数据的目录拷贝到NameNode存储数据的平级目录,并删除in_use.lock文件

[hui@hadoop103 dfs]$ scp -r hui@hadoop104:/opt/module/hadoop-2.7.2/data/tmp/dfs/namesecondary ./

[hui@hadoop103 namesecondary]$ rm -rf in_use.lock

[hui@hadoop103 dfs]$ pwd

/opt/module/hadoop-2.7.2/data/tmp/dfs

[hui@hadoop103 dfs]$ ls

data name namesecondary

5、导入检查点数据

bin/hdfs namenode -importCheckpoint

6、启动 NameNode

sbin/hadoop-daemon.sh start namenode