线性回归

Q:(y=w_1x_1+w_2x_2^2+w_3x_3^3+b) 是线性回归吗?

是,线性与否是对于模型参数(w)来说的,(x)是已知量。

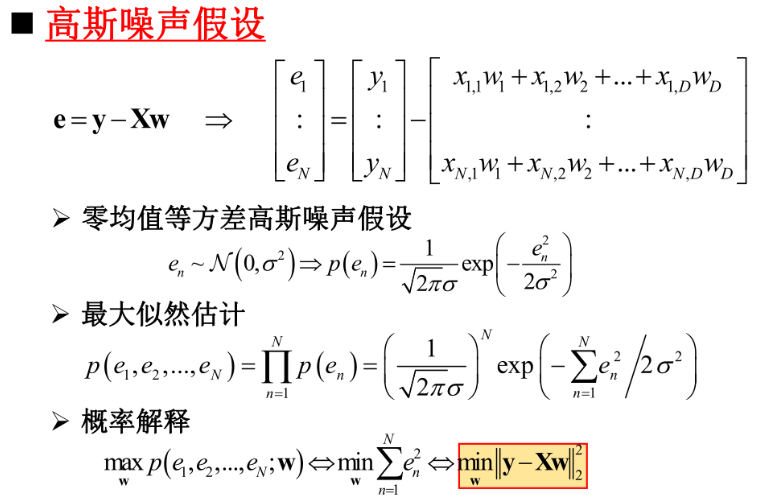

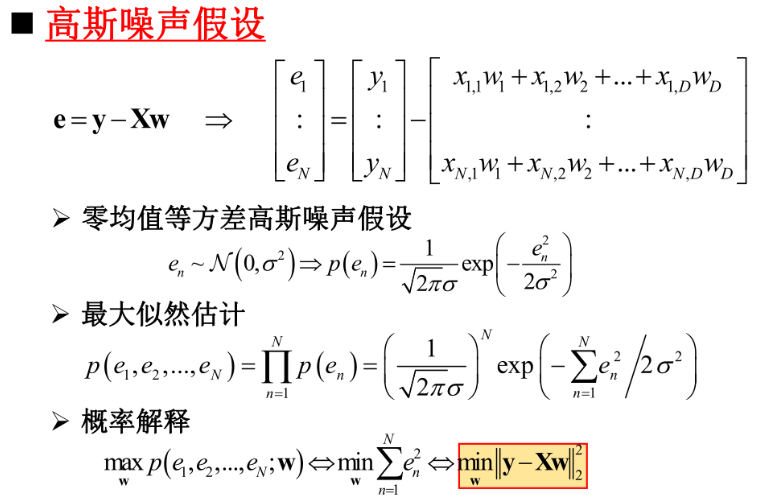

Q:线性回归所用的最小二乘法的几何解释和概率解释。

几何解释:子空间(X)上的正交投影。

概率解释:零均值等方差高斯假设下的最大似然估计。实际上,$||cdot ||_2^2$已经带有高斯假设了。

##逻辑斯蒂回归

####Q:线性回归的任务是预测,能否用来分类?

可以,已知线性回归是$z=w^TX$,其中$w$是向量,$X$是矩阵。通过$y=frac{1}{1+e^{-z}}$即可将$z$限制在0~1之间用于表示分类概率。

####Note:逻辑斯蒂回归直接得到后验概率$P(y|x)$,而不是先得到先验概率$P(x)$和似然概率$P(x|y)$,因此逻辑斯蒂回归属于判决模型(discriminative model),而非生成模型(generative model)。

##多分类学习

####Note:OvO(One vs. One),OvR(One vs. Rest)。

##类别不平衡问题

####Q:以二分类为例,假设正样本总数($N^+$)少,而负样本总数($N^-$)多。那么模型在降低损失时,会看重样本多的负样本,这样总体损失小。但对于正样本而言,损失很大。

**再缩放策略:**

- 阈值移动 (类别平衡时的 $frac{p}{1-p}>1 Rightarrow frac{p}{1-p} frac{N^-}{N^+}>1$,基于贝叶斯分类;同时也可以将损失函数加权,给正样本损失更多关注)

- 过采样 (增多正样本:样本复制; 样本插值; 样本生成(GAN))

- 欠采样 (多次随机抽取负样本,再融合,以防损失信息)

Focal loss:(FL(p_t)=(1-p_t)^gamma log(p_t))

- 自适应样本加权

- 容易分类样本权重降低((p_t

ightarrow 1 Rightarrow (1-p_t)

ightarrow 0))

- 促使分类器学习困难样本!

级联分类器(Cascaded Classfier)人脸检测

随机采样一致(Random Sample Consensus)