提交命令sc.textFile(“hdfs://hadoop101:50070/data/wordcount.txt”).collect()

spark报异常

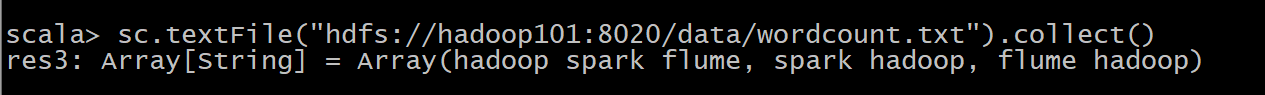

这里时HDFS端口问题,将50070端口改为8020再提交

sc.textFile(“hdfs://hadoop101:8020/data/wordcount.txt”).collect()

单独安装的Hadoop的fs.defaultFS默认端口号为50070,而CDH中默认为8020。

比如可以使用"hdfs://namenode:8020/user/asin/test.txt"在程序中访问你的文件。

二、启动进程过多,会使spark报错:ERROR XSDB6: Another instance of Derby may have already booted the database /export/servers/spark/metastore_db.

解决方案如下: