前提条件(环境要求)

jdk版本:1.7+

scala版本:1.10.4+

maven版本:3.3.3+

本博客中使用的软件版本

spark版本:spark-1.6.1.tar.gz(源码)

jdk版本:jdk-8u151-linux-x64.tar.gz

maven版本:apache-maven-3.3.9.tar.gz

scala版本:scala-2.10.4.tgz

以上软件都可以到官网下载

本文章约束两个目录

/opt/softwares 安装包

/opt/modules 安装的目录

编译方式:

打包编译make-distribution.sh

一、环境配置

1、将spark、jdk、maven、scala软件包上传到Linux系统指定的目录:/opt/softwares/

2、maven安装与配置

tar -zxvf apache-maven-3.3.9.tar.gz -C /opt/modules

在/etc/profile配置文件中最底部配置以下信息

#MAVEN#

export MAVEN_HOME=/opt/modules/apache-maven-3.3.9

export PATH=$PATH:$MAVEN_HOME/bin

3 、java安装与配置

tar -zxvf jdk-8u151-linux-x64.tar.gz -C /opt/modules

在/etc/profile配置文件中最底部配置以下信息

#JAVA_HOME#

export JAVA_HOME=/opt/modules/jdk1.8.0_151

export CLASSPATH=.:$JAVA_HOME/jre/lib/rt.jar:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

export PATH=$PATH:$JAVA_HOME/bin

4、scala安装与配置

tar -zxvf scala-2.10.4.tgz -C /opt/modules

在/etc/profile配置文件中最底部配置以下信息

#scala#

export SCALA_HOME=/opt/modules/scala-2.10.4

export PATH=$PATH:$SCALA_HOME/bin

5、maven仓库配置

将repository-1.6.1.zip解压到~/.m2文件夹中

6、解压spark源码包

tar -zxvf spark-1.6.1.tar.gz -C /opt/modules

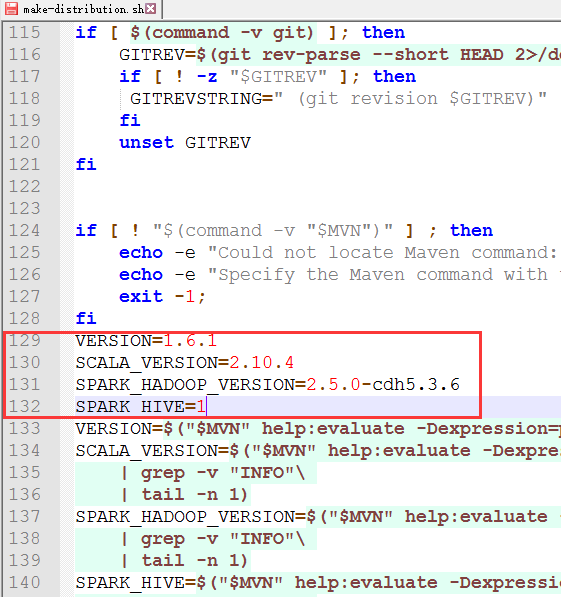

7、修改make-distribution.sh文件内容(在/opt/modules/spark-1.6.1目录中)

在129行添加以下内容

VERSION=1.6.1

SCALA_VERSION=2.10.4

SPARK_HADOOP_VERSION=2.5.0-cdh5.3.6

SPARK_HIVE=1

note:

SCALA_VERSION配置上你的scala的版本, 可能是2.10.x 或者2.11.x

SPARK_HADOOP_VERSION配置上你的hadoop版本

SPARK_HIVE 1表示需要将hive的打包进去, 非1数字表示不打包hive

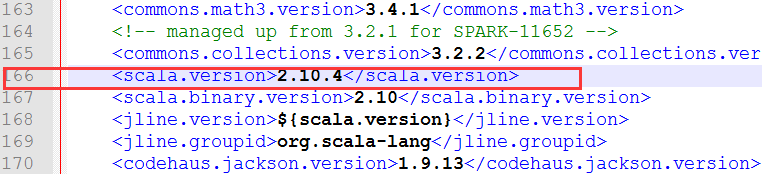

8、修改pom.xml文件 (在/opt/modules/spark-1.6.1目录中)

在166行 scala版本修改成你对应的版本 我这里是修改成 2.10.4

在2522行 scala版本修改成你对应的版本 我这里是修改成 2.10.4

9、添加依赖服务文件

前提:使用的scala版本是2.10.4,pom.xml文件中也进行了修改

复制scala-2.10.4.tgz和zinc-0.3.5.3.tgz到spark根目录的build文件夹中, 并解压

10、编译spark

在spark目录中执行命令

./make-distribution.sh --tgz

-Phadoop-2.4

-Dhadoop.version=2.5.0-cdh5.3.6

-Pyarn

-Phive -Phive-thriftserver

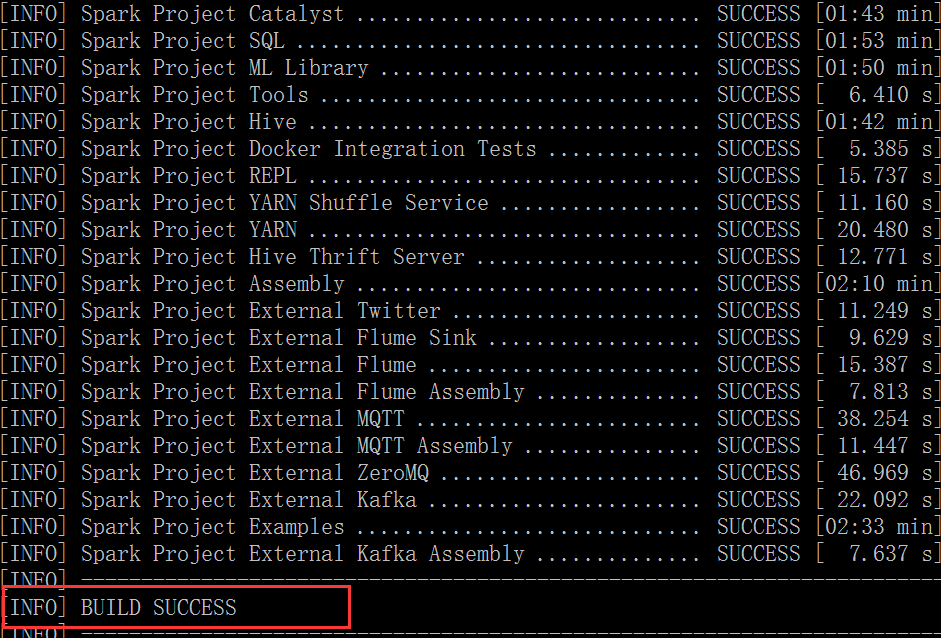

11、最终spark编译成功标志

12、需要注意的几点

1)如果maven不是国内的镜像下载会比较慢 ,建议改成国内镜像

配置镜像(修改settings.xml文件)

<mirror>

<id>aliyun</id>

<mirrorOf>central</mirrorOf>

<name>aliyun repository</name>

<url>http://maven.aliyun.com/nexus/content/groups/public/</url>

</mirror>

<mirror> <!– cdh 版本编译 可选指定-->

<id>cloudera</id>

<mirrorOf>central</mirrorOf>

<name>cloudera repository</name>

<url>https://repository.cloudera.com/artifactory/cloudera-repos/</url>

</mirror>

2)配置域名解析服务器

# vi /etc/resolv.conf

内容:

nameserver 8.8.8.8

nameserver 8.8.4.4

3)编译可能出现的问题

在编译的过程中,可能卡死,然后不进行编译的情况出现,如果超过十分钟没有动静的话,可以考虑是否是编译出现问题。问题出现

原因是:网络不好、机器内存不够、其他原因。解决方案:

1. 关闭编译的进程。直接退出当前会话,然后从新进入在编译。

2. 添加虚拟机内存(最好4G+),重启虚拟机再编译