环境:

CentOS7

hadoop2.6.4已安装两个节点:master、slave1

过程:

把下载的scala、spark压缩包拷贝到/usr/hadoop-2.6.4/thirdparty目录下。

安装scala:

$ sudo tar -zxvf scala-2.11.8.tgz

修改环境变量文件 /etc/profile,添加以下内容:

export SCALA_HOME=/usr/hadoop-2.6.4/thirdparty/scala-2.11.8 export PATH=$PATH:$SCALA_HOME/bin

source 使之生效

$ source /etc/profile

验证 Scala 安装

slave1参照 master 机器安装步骤进行安装。

Spark 安装:

解压

$ sudo tar -zxvf spark-1.6.1-bin-hadoop2.6.tgz

修改环境变量文件 /etc/profile, 添加以下内容

export SPARK_HOME=/usr/hadoop-2.6.4/thirdparty/spark-1.6.1-bin-hadoop2.6 export PATH=$PATH:$SPARK_HOME/bin

source 使之生效

$ source /etc/profile

Spark 配置

进入 Spark 安装目录下的 conf 目录, 拷贝 spark-env.sh.template 到 spark-env.sh

$ cp spark-env.sh.template spark-env.sh

在其中添加以下配置信息:

export SCALA_HOME=/usr/hadoop-2.6.4/thirdparty/scala-2.10.4 export JAVA_HOME=/usr/java/jdk1.8.0_101 export HADOOP_HOME=/usr/hadoop-2.6.4 export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop export SPARK_MASTER_IP=192.168.23.101 export SPARK_LOCAL_DIRS=/usr/hadoop-2.6.4/thirdparty/spark-1.6.1-bin-hadoop2.6 export SPARK_WORKER_MEMORY=512m

JAVA_HOME 指定 Java 安装目录;

SCALA_HOME 指定 Scala 安装目录;

SPARK_MASTER_IP 指定 Spark 集群 Master 节点的 IP 地址;

SPARK_WORKER_MEMORY 指定的是 Worker 节点能够分配给 Executors 的最大内存大小;

HADOOP_CONF_DIR 指定 Hadoop 集群配置文件目录。

SPARK_WORKER_MEMORY 根据主机内存设置spark运行内存大小。

slaves

将 slaves.template 拷贝到 slaves

$ sudo cp slaves.template slaves

编辑其内容为

master

slave1

设置spark安装目录的所有组/用户:

$ sudo chown -R hadoop:hadoop spark-1.6.1-bin-hadoop2.6

slave1参照 master 机器安装步骤进行安装。

启动 Spark 集群

启动 Hadoop 集群

$ start-dfs.sh

启动 Spark 集群

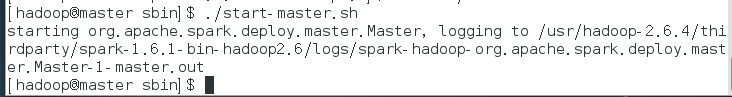

启动 Master 节点

运行 $SPARK_HOME/sbin 下面, start-master.sh

jps查看进程,多了一个Master进程

启动所有 Worker 节点

运行 $SPARK_HOME/sbin 下面,start-slaves.sh

jps查看进程,可以发现多了一个Work进程。

(由于虚拟机性能较差,因此后续步骤未实际验证,仅供参考)

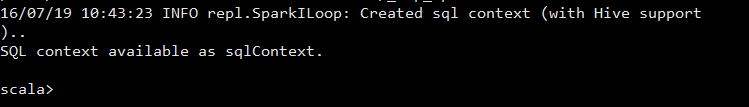

运行 spark-shell,可以进入 Spark 的 shell 控制台

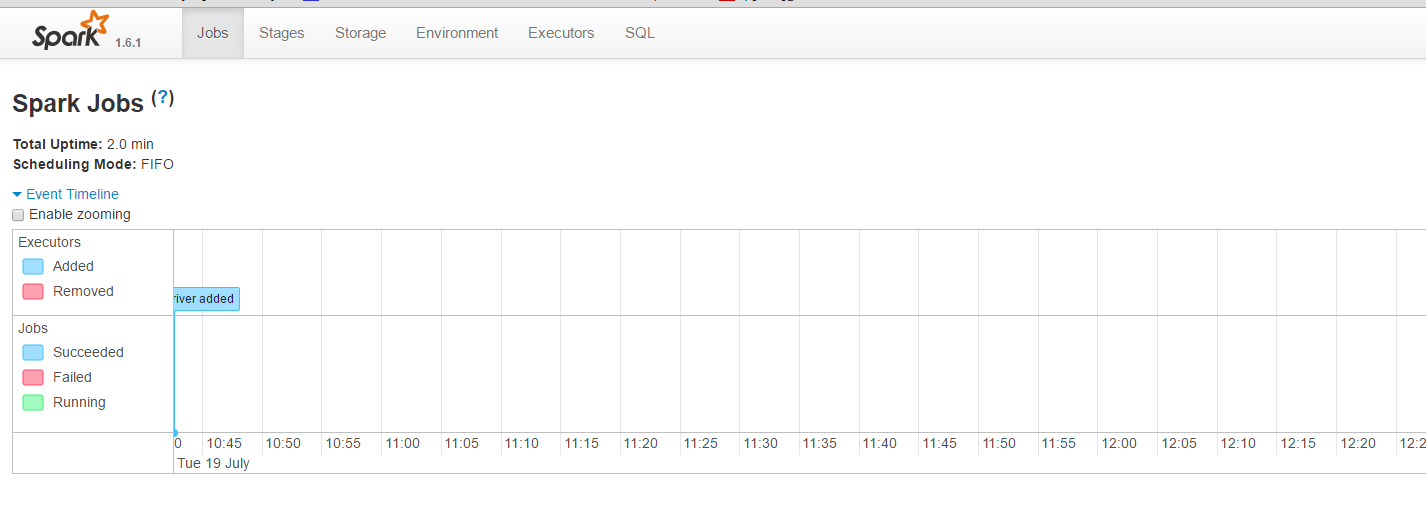

浏览器访问 SparkUI

可以从 SparkUI 上查看一些 如环境变量、Job、Executor等信息。

至此,整个 Spark 分布式集群的搭建就到这里结束。

停止 Spark 集群

停止 Master 节点

运行$SPARK_HOME/sbin,下面的stop-master.sh 来停止 Master 节点。

停止 Slaves 节点

运行$SPARK_HOME/sbin,下面的stop-slaves.sh (注意是stop-slavers 有s) 可以停止所有的 Worker 节点

最后再停止 Hadoop 集群。

原文地址:http://blog.csdn.net/sa14023053/article/details/51953836