牛顿方法(此方法为续学习笔记二)

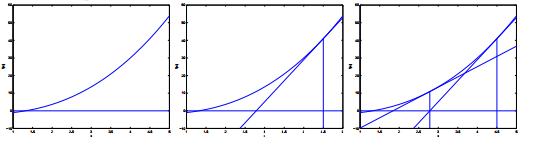

如果我们想找到一个x,使得f(x)=0。那么先随机找一个x_0,在该点处做切线,这条切线与x轴交点为x_1,在x_1处做f的切线,以此类推。

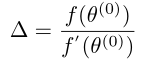

记x_0与x_1之间的距离为Delta。那么,

(将自变量改为theta),

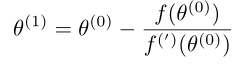

(将自变量改为theta), 。因为Delta是两个相邻自变量的距离,那么,

。因为Delta是两个相邻自变量的距离,那么,

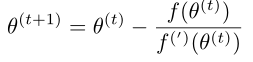

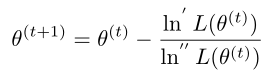

,此式可以推广为

,此式可以推广为 。

。

记f为ln‘L,即f为似然韩式的导数,那么, 。

。

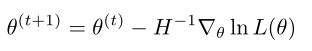

一般化的牛顿方法中theta是一个向量,可以写成

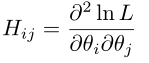

。其中,H是海森矩阵(Hession matrix)。该矩阵满足下列式子,

。其中,H是海森矩阵(Hession matrix)。该矩阵满足下列式子,

。牛顿方法比梯度上升算法能更快的求出theta,更快的对logistics回归模型进行拟合。

。牛顿方法比梯度上升算法能更快的求出theta,更快的对logistics回归模型进行拟合。

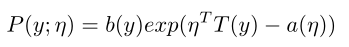

指数分布族

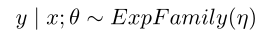

满足该式的 ,成为指数分布族。eta成为自然参数,T(y)为充分统计量,通常T(y)=y。固定函数a,b,T,那么这就是以eta为参数的概率分布集。

,成为指数分布族。eta成为自然参数,T(y)为充分统计量,通常T(y)=y。固定函数a,b,T,那么这就是以eta为参数的概率分布集。

伯努利和高斯分布都属于指数分布族

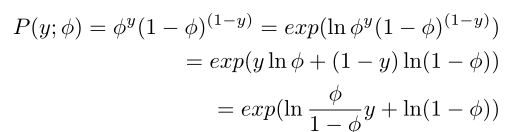

伯努利

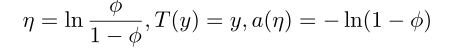

,那么对应关系为

,那么对应关系为

。通过变形,可以得到,

。通过变形,可以得到,

。

。

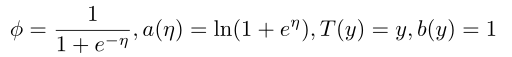

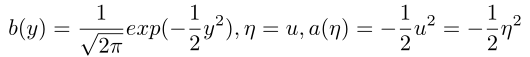

高斯分布

在高斯分布进行最大似然估计的时候,sigma对于最后所要求的结果没有影响,所以假设sigma为1,即高斯分布的方差为1。

,对应关系为

,对应关系为

所以伯努利分布和高斯分布都是指数分布族。

广义线性模型

使用最小二乘法(y属于实数)和logistics回归方法(y取0,1)进行建模,都属于广义线性模型。

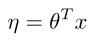

假设

1.

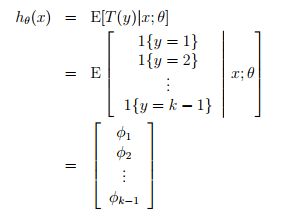

2.给定一个x,我们的目标是求出E[T(y)|x],即h(x)=E[T(y)|x]

3.

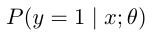

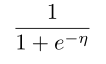

由以上得知,伯努利分布满足第一点。根据第二点,对于固定的theta和x,我们的目标是求出h(x)=E[T(y)|x],即

=

= =

= ,根据第三个条件,即为

,根据第三个条件,即为 。

。

此处跳过高斯分布,进行一个更加复杂例子的讲解。

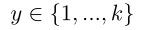

多项式分布(Multinomial)

,参数为,

,参数为, ,

, ,可以把最后一个参数写成1减去前k-1个参数得到的,所以,实际上,参数数量只有k-1个。

,可以把最后一个参数写成1减去前k-1个参数得到的,所以,实际上,参数数量只有k-1个。

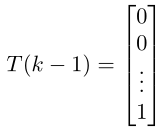

接下来把多项式分布写成指数分布族的形式。

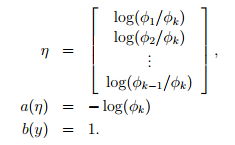

定义k个k-1维的列向量

引入指示函数(indicator function notation)

1{true}=1,1{false}=0

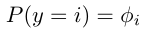

规定T(y)i=1{y=i},i:T(y)的第i个元素。那么,可以得到

其中, 那么,

那么,

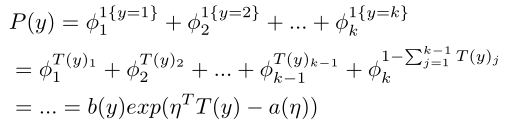

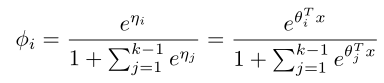

(i=1,2,...,k-1)

(i=1,2,...,k-1)

那么此时的学习算法为,

这类算法成为softmax regression,它是logistics回归的推广,因为后者处理的y只有两个结果,前者处理的y有k个结果。