各位好!从今天起,我将用几个篇幅的文字向大家介绍一下我的一个开源作品——YayCrawler,其在GitHub上的网址是:https://github.com/liushuishang/YayCrawler,欢迎大家关注和反馈。

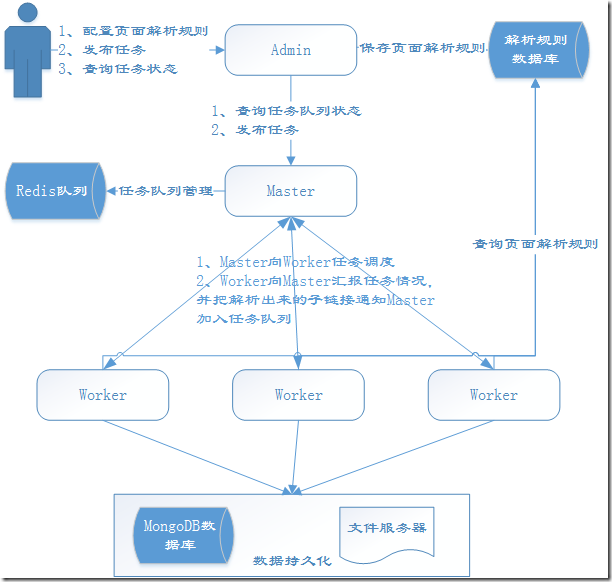

YayCrawler是一个基于WebMagic开发的分布式通用爬虫框架,开发语言是Java。我们知道目前爬虫框架很多,有简单的,也有复杂的,有轻量型的,也有重量型的。您也许会问:你这个爬虫框架的优势在哪里呢?额,这个是一个很重要的问题!在这个开篇中,我先简单的介绍一下我这个爬虫框架的特点,后面的章幅会详细介绍并讲解它的实现,一图胜千言:

1、分布式:YayCrawler就是一个大哥(Master)多个小弟(Worker)的架构(这种结构才是宇宙的真理),当然大哥还有一个小秘(Admin)和外界交往。

2、通用性:我们很多时候需要爬取不同网站的数据,各个网站的结构和内容都有很大的差别,基本上大部分人都是遇到一个网站写一份代码,没法做到工具的复用。YayCrawler就是想改变这种情况,把不同的部分抽象出来,用规则来指导爬虫做事。也就是说用户可以在界面上配置如何抓取某个页面的数据的规则,等爬虫在爬取这个页面的时候就会用这个事先配置好的规则来解析数据,然后把数据持久化。

3、可扩展的任务队列:任务队列由Redis实现,根据任务的状态有四种不同的任务队列:初始、执行中、成功、失败。您也可以扩展不同的任务调度算法,默认是公平调度。

4、可定义持久化方式:爬取结果中,属性数据默认持久化到MongoDB,图片会被下载到文件服务器,当然您可以扩展更多的存储方式。

5、稳定和容错:任何一个失败的爬虫任务都会重试和记录,只有任务真正成功了才会被移到成功队列,失败会有失败的原因描述。

6、反监控组件:网站为了防止爬虫也是煞费苦心,想了一系列的监控手段来反爬虫。作为对立面,我们自然也要有反监控的手段来保障我们的爬虫任务,目前主要考虑的因素有:cookie失效(需要登陆)、刷验证码、封IP(自动换代理)。

7、可以对任务设置定时刷新,比如隔一天更新某个网站的数据。

……

上面说了一大堆优点的目的只有一个:希望您能有兴趣继续看下去,哈哈。

言归正传,本文作为开篇,只是一个总览,现在我们来整理一下后续文章的结构安排:

- 开源通用爬虫框架YayCrawler-运行与调试

- 开源通用爬虫框架YayCrawler-框架的运行机制

- 开源通用爬虫框架YayCrawler-页面的抽取规则定义

- 开源通用爬虫框架YayCrawler-任务队列详解

- 开源通用爬虫框架YayCrawler-页面下载器详解

- 开源通用爬虫框架YayCrawler-规则解析器详解

- 开源通用爬虫框架YayCrawler-数据持久化详解

- 开源通用爬虫框架YayCrawler-反监控组件详解

- 开源通用爬虫框架YayCrawler-案例演示

- 开源通用爬虫框架YayCrawler-待完善的功能