接下来就是最关键的步骤,安装hadoop搭建HDFS分布式文件系统,主要是配置伪分布式的操作

下边是我操作过程

Hadoop安装及HDFS伪分布式配置

1、解压hadoop(此处省略了上传hadoop jar包的过程,其操作在jdk配置上传jdk jar包方法相同)此处是

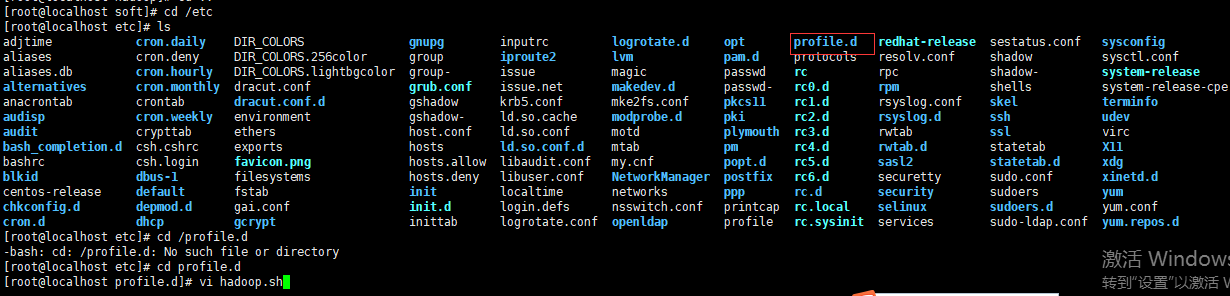

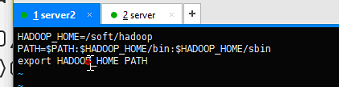

2、配置hadoop.sh文件

此处配置的目录仍为 hadoop/profile.d,与jdk,目录一致,如果目录不一致当配置完成后开启服务时会报错提示JAVA_HOME CON'T FOUND

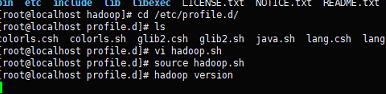

3、验证配置

至此,hadoop安装配置完成,接下来搭建HDFS

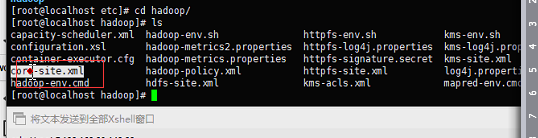

4、接下来在etc/hadoopcore-site.xml文件及hdfs-site.xml文件,这里我们打开npp进行配置

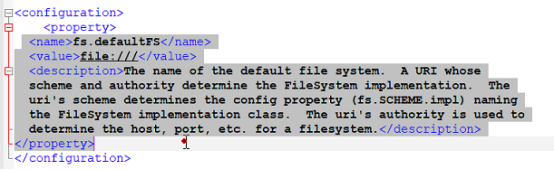

配置Core-site.xml

(1)从core-default.xml中找到以下内容配置到core-site.xml中

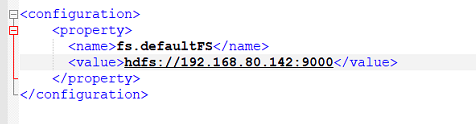

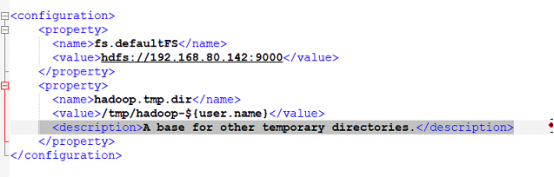

(2)Fs.defaultFS value值为hdfs:+对应主机ip

注:Hadoop.tmp.dir代表临时文件 在配置时需要注意,hadoop先自带的tmp临时文件会定期清理所以需要自己建立一个tmp文件,value值即对应的tmp文件所在目录

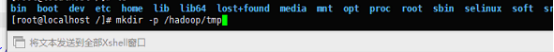

(3)自己建立目录

core-site.xml配置完成,接下来配置Hdfs-site.xml

配置hdfs-site.xml

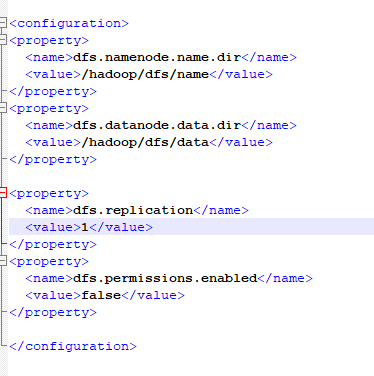

(1)对于HDFS来说最主要就是两部分namenode和datanode接下来配置这两部分

这里的value值均是刚刚我们建立的文件路径

(2)在hdfs-site.xml中配置副本数,value 代表副本数 伪分布式下一般为1

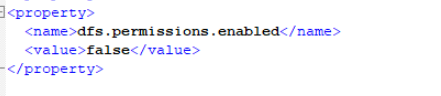

(2)权限配置

权限检查,将里边的部分改成false

最终配置内容如下

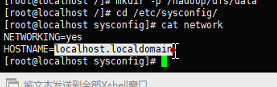

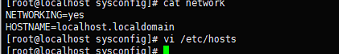

5、检查虚拟机主机名是否更改(这里需要注意这一步是必须的,如果更改一定要配置映射)下边是我的主机名,这里代表着没有更改

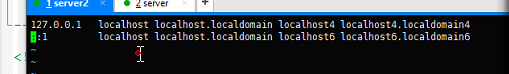

6、格式化hadoop

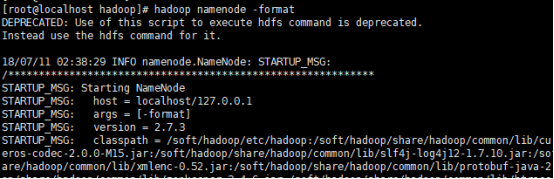

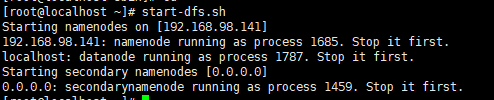

7、格式化完成后进入hadoop目录下sbin 运行start-dfs.sh,成功运行及完成配置

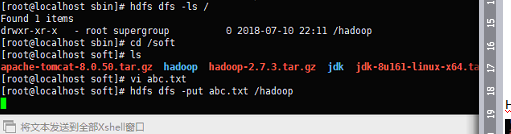

尝试在Hdfs下存文件