Background

这篇blog的起源是,在四刷西瓜书时,遇到了许多熟悉但又似乎陌生的数学概念,尤其集中在线代/微积分/概率论以及最优化之中。想当年我的概率论分数还挺高的,咋遇到这些问题依然百思不得其解捏?其一是基础其实并不扎实,只是知道公式、会计算而已;其二是学了这么多theory之后,更关注这些公式背后的insight和motivation,自然会多出许多“为什么要这样...”以及“为什么不这样...”的疑问。这篇帖子也就是记录那些大二时被我忽略的,但又充满着智慧的数学知识点。

为什么不能用 MVUE 替代 MLE ?

极大似然估计是个经典的老话题了,大二的时候学起来觉得这是概率论里最容易理解的一章:不就列个算式求个导取个极值吗?但如今,再次回首,发现自己的理论基础竟如此薄弱。

第四次看西瓜书的时候,在第七章中偶然看见了极大似然估计。先是一番回忆,想起了极大似然估计得到的方差(hat{sigma}^2_{MLE})是有偏的,即:

很显然,极大似然估计得到的方差是真正方差的有偏估计,它低估了方差的值。在PRML中提到,这也是曲线拟合问题(RSS损失函数)中遇到的过拟合问题的核心。(我的理解是由于方差的低估,更贴近于数据集中的样本了(曲线更扭曲/复杂了),从而过拟合)。上面的公式在各个网站的解释数不胜数了,不再赘述。

OK,现在捋顺一下思路:我们用极大似然来计算方差 -> 但是得到的方差是有偏的 -> 我们又知道偏离的程度 ((frac{N-1}{N})) 。

那么难道不会很自然地产生一个问题吗?:为什么不直接用:

,即方差的无偏估计量,来进行估计捏???这个统计量不是无偏并且一致的吗??

这个疑惑困扰了我一个下午,但是搜索的结果全是有偏的证明,而没有人提到这个问题。

直到我看到了这篇:Properties of Maximum Likelihood Estimation (MLE) 普渡大学的讲义。终于弄明白了。

CRLB Bound

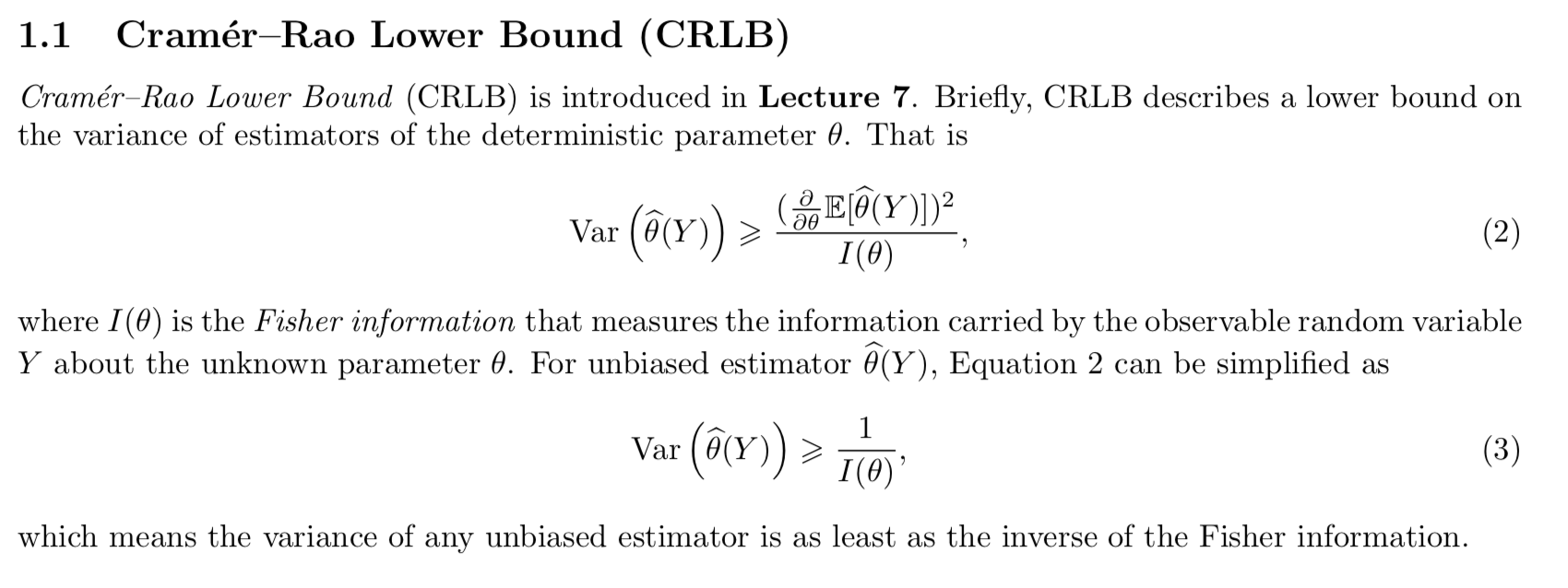

在我们的大学概率论中,只提到了MLE的渐近一致性(也许这个也没提到,我们只是会算而已)。而在这个lecture中,强调了收敛的效率(速度)。当估计量的方差等于 Cram ́er–Rao Lower Bound (CRLB) 时,其被称为高效估计量 (Efficient Estimator),大致就是收敛得更快。CRLB的具体计算如下:

再具体些,MLE中有偏的那个方差估计量(hat{sigma}^2_{MLE})是满足 CRLB 的:

!!!这里我就不写推导了,因为MLE是有偏估计,计算比较复杂,感兴趣的童鞋自己可以算一下,总之是等于CRLB bound的。!!!

而 (frac{N}{N-1}hat{sigma}^2_{MLE}) (我们称之为Minimum Variance Unbiased Estimator (MVUE) ) 并不等于 CRLB。来给大家整个活证明一下:

Proof that MVUE is not efficient

首先,很显然的,我们的MVUE估计量 (hat{sigma}^2_{mathrm{MVUE}}=frac{1}{|D_c|-1}sum_{xin D_c}(x-hat{mu}_c)(x-hat{mu}_c)^mathrm{T}) 是无偏的(其中 (|D_c|=N) 即样本数量。关于为什么除以 (N-1) 才是方差的无偏估计量的证明已经太多太多了,这里我就不证了),那么只要用CRLB的简化形式即可 (式 (3)):

我们先来计算Fisher信息量 (I(sigma^2)):(这里我们估计的参数是 (sigma^2) ,这个二阶导我是用mathematica算的)

其中,(f) 为 (y) (包含 N 个高斯分布样本的样本集) 的分布函数:

接着,我们还需要计算 (mathrm{Var}left(hat{sigma}^2_{mathrm{MVUE}}(Y) ight)):

这个计算涉及到高斯分布方差的方差,可以参考这个解法。

因此得证,MVUE 估计量 (hat{sigma}^2_{mathrm{MVUE}}=frac{1}{|D_c|-1}sum_{xin D_c}(x-hat{mu}_c)(x-hat{mu}_c)^mathrm{T}) 并不满足 CRLB。

所以,为了收敛得更快(用尽量少的样本估计得更准),MLE估计量自然更优秀。