(没太听明白,以后再听)

1. 如何欺骗神经网络?

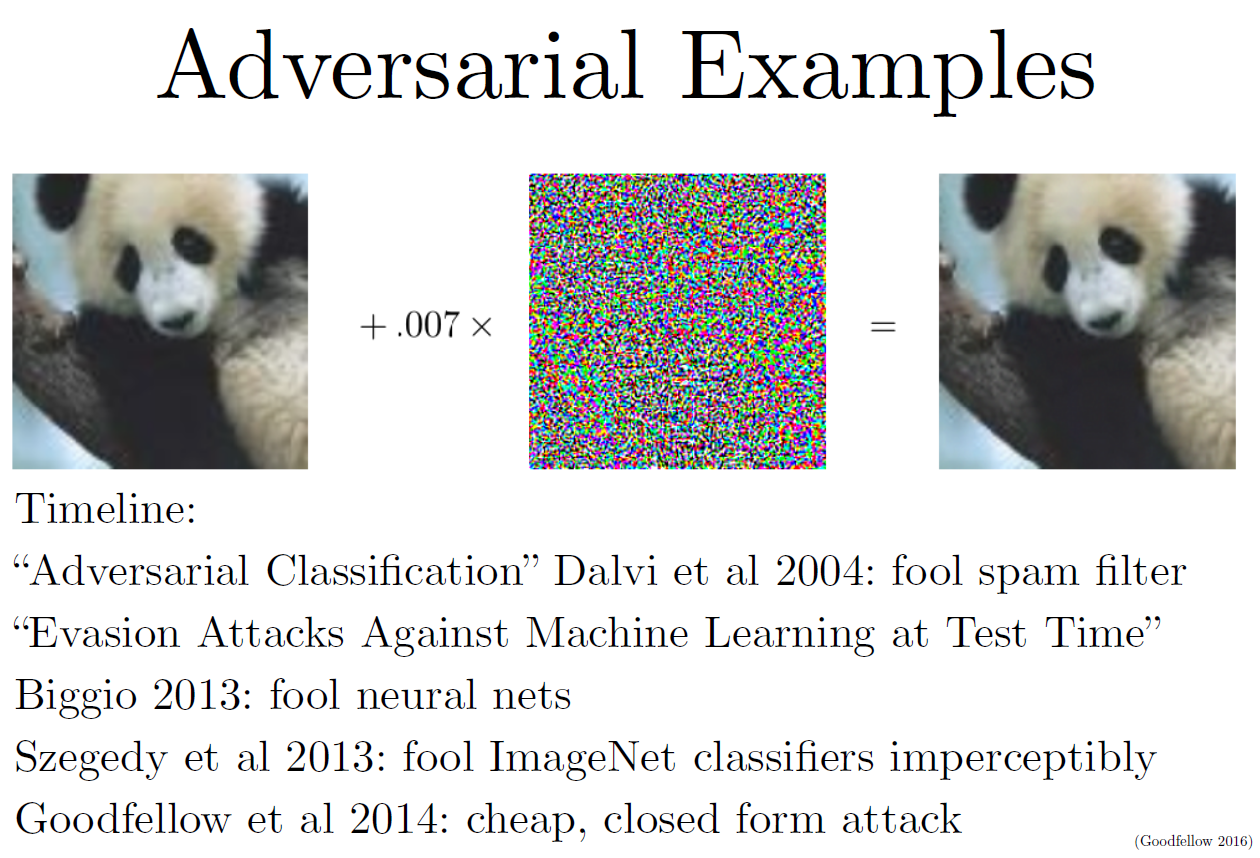

这部分研究最开始是想探究神经网络到底是如何工作的。结果人们意外的发现,可以只改变原图一点点,人眼根本看不出变化,但是神经网络会给出完全不同的答案。比如下图,左边的熊猫被识别成熊猫,但是加上中间的小“噪音”一样的数值,右图的熊猫就识别不出来了。而且这个小“噪音”不是随机的,它更像是offset,是某种系统误差,叠加到图片上去,总是可以欺骗神经网络。

2. 神经网络从权重到输出的映射是非线性的,非常复杂,非常难优化、训练。但是从输入到输出的映射可以看成线性的,是可以预测的,优化出输入要比优化出权重容易得多。可以利用输入到输出的线性关系,很方便地生成可以欺骗(或者叫攻击)神经网络的样例。

FGSM (Fast Gradient Step Method):一种对抗方法。这个方法的核心思想是在每一步优化的过程中加入少量噪声,让预测结果朝目标类别偏移,或者如你所愿远离正确的类别。

Transferability Attack:在自己的网络上找到攻击样例,这个样例往往也能攻破其他神经网络。

3. 对抗样例可以用来训练网络得到更好的效果。

4. 总结