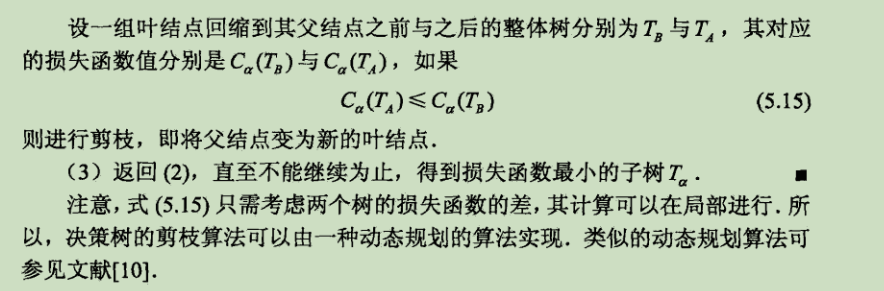

主要过程包含特征选择,决策树生成,决策树剪枝

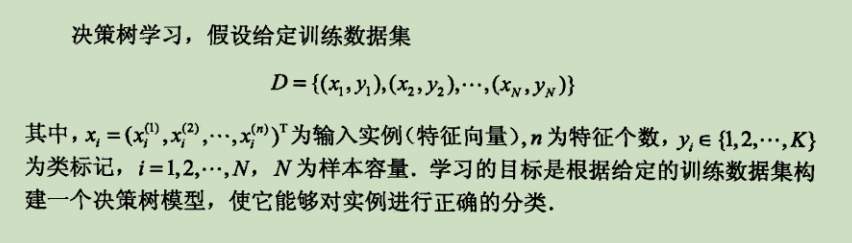

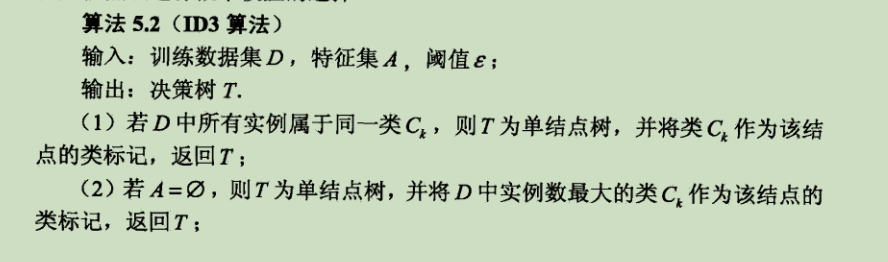

特征选择:

https://www.pkudodo.com/2018/11/30/1-5/

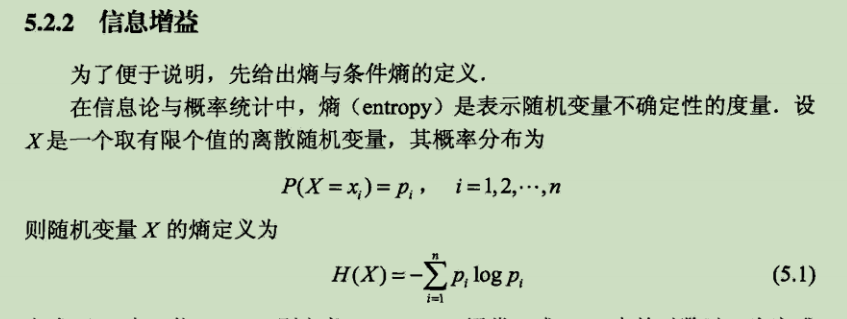

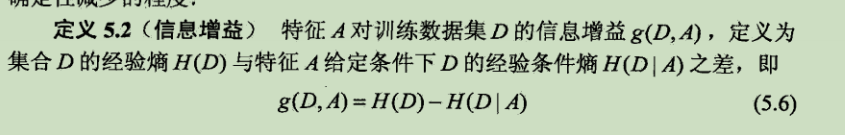

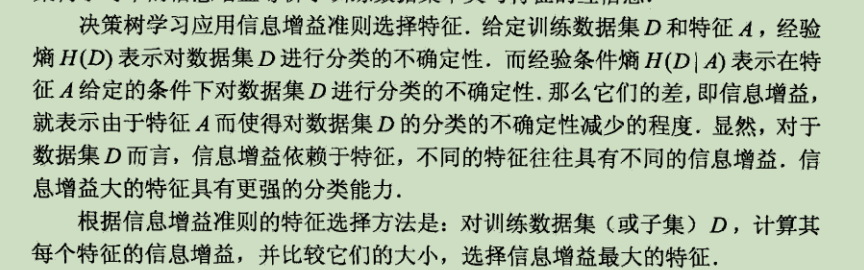

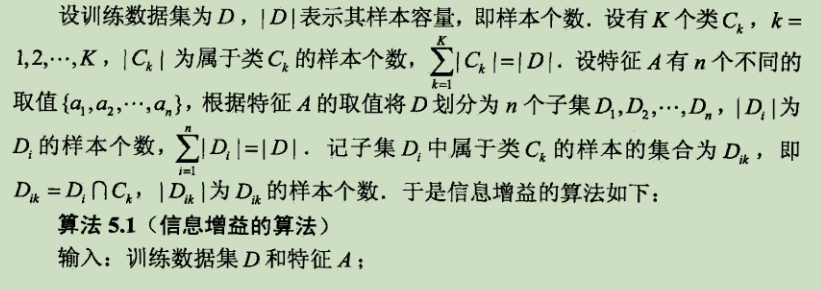

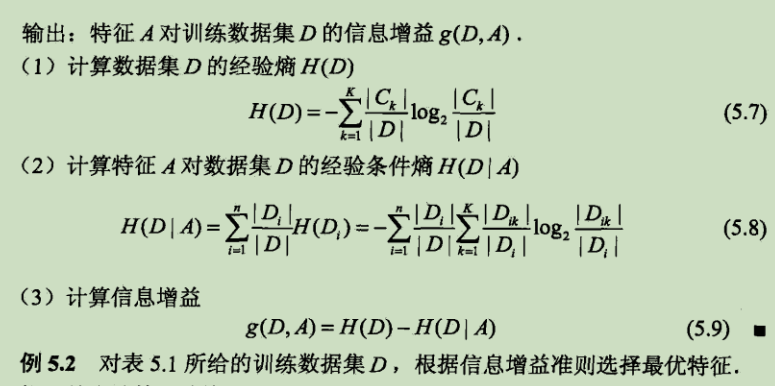

上式是什么意思?不着急慢慢来。我们先看下面这张图。我们假设D和B是两个判断节点,它们在同一个分支中,D通过对样本特征A的值新型判断后进入了A分支。那么在D节点中我们的信息熵肯定是比较高的,令D节点中此时的信息熵是H(D)。然后经过D的一次判断,信息熵减少了,此时到了节点B,因为B节点的信息熵依靠于D对特征A的判断,所以节点B的信息熵设为H(D|A)。我们要让信息熵下降得最快,也就是他们之间的信息熵差值要最大,将这个信息熵差值设为g(D, A),汇总起来就是上图中的式子了。

信息增益值最大,熵从1(root)到0(leaf)的速度越快

CART树

举例说明,CART都是二分类树,因此数据都是2维的,可以理解为含有row 和column的表格

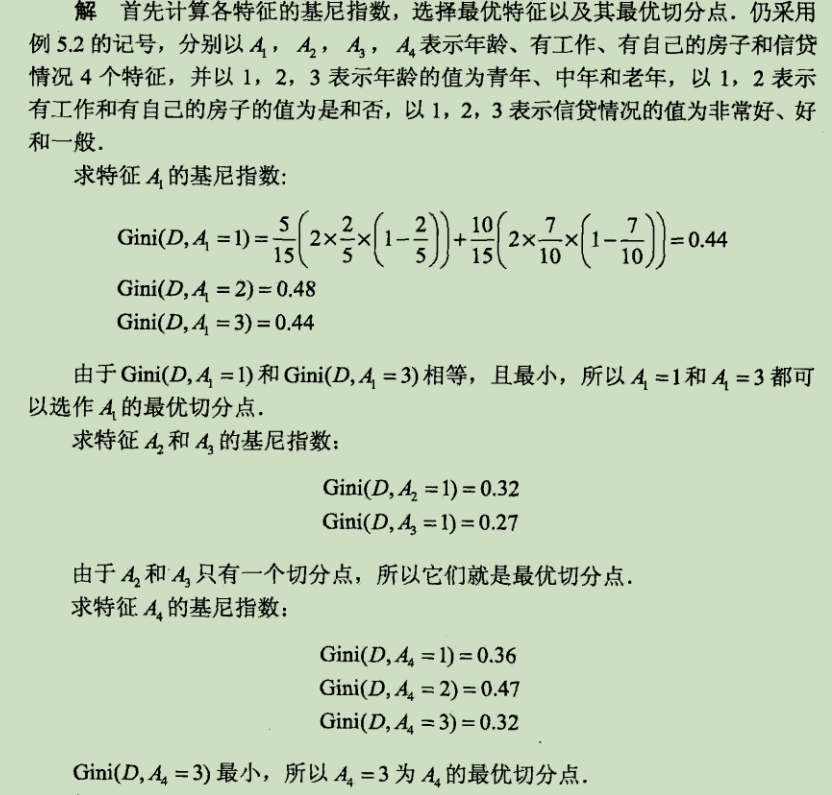

那么根据基尼指数计算公式

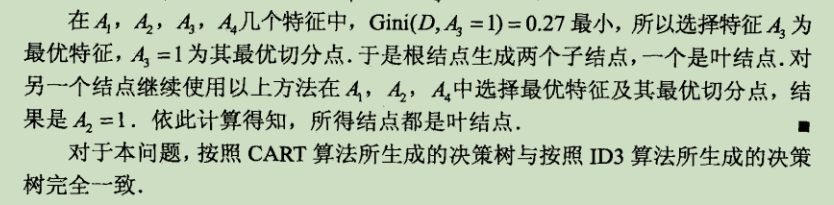

先计算出A1-4的特征切分点,也就是最小的基尼指数

再通过对比A1-A4最小的切分点的基尼指数,求出最优特征