GBDT全称Gradient-boosting decision tree,即用gradient boosting策略训练出来的决策树模型。模型的结果是一组CART树(回归分类树)的组合(T_1, ..., T_K),其中(T_j)学习的是之前(j-1)棵树预测结果的残差。

这种思想就像准备考试前的复习,先做一遍习题册,然后把做错的题目挑出来,在做一次,然后把做错的题目挑出来在做一次,经过反复多轮训练,取得最好的成绩。

而模型最后的输出,是一个样本在各个树中输出的结果的和:

[overline y = sum_{k=1}^K f_k(x)

]

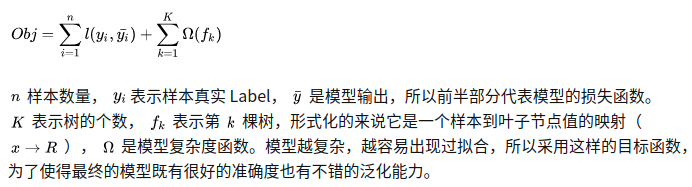

优化目标如下: