前向分布算法

前面我介绍了提升树和AdaBoost算法,它们都是统计学习方法中提升方法中的一类,这两个算法都涉及到了前向分布算法。

前向分布算法的思路是从前向后,每一步学习一个基函数及其系数,最终逐步逼近优化目标函数式。

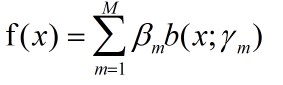

介绍它,还需要介绍一下加法模型:

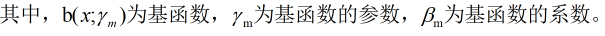

如果给定了损失函数L,那我们的优化目标即为:

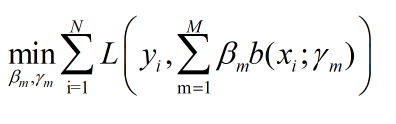

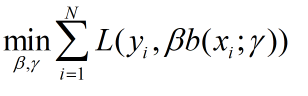

这个数学表达式,看过我之前博客的应该都很清楚,它表达的什么对于这个优化问题,按照前向分布算法的思路,我们不是直接求解总表达式的最小解时的函数,而是分解这个优化问题

即,每一轮训练时,我们只要求训练的基函数达到最优。