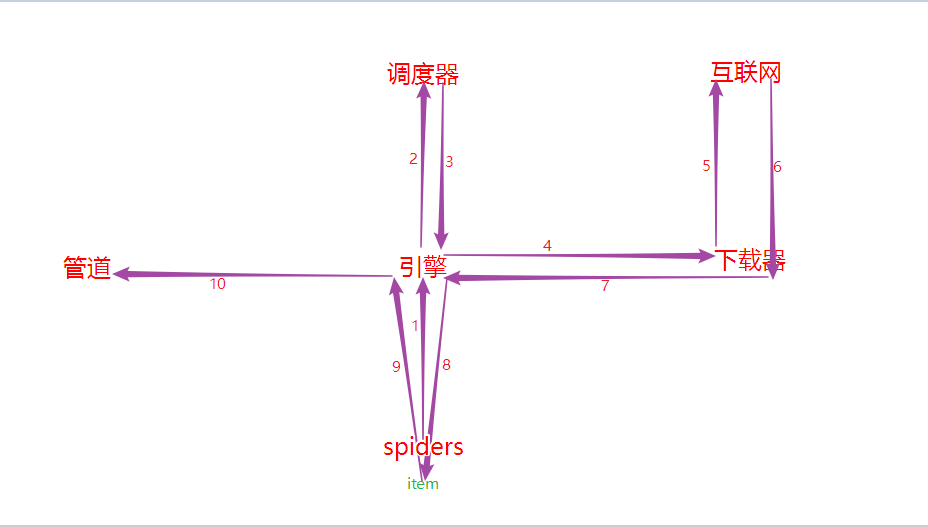

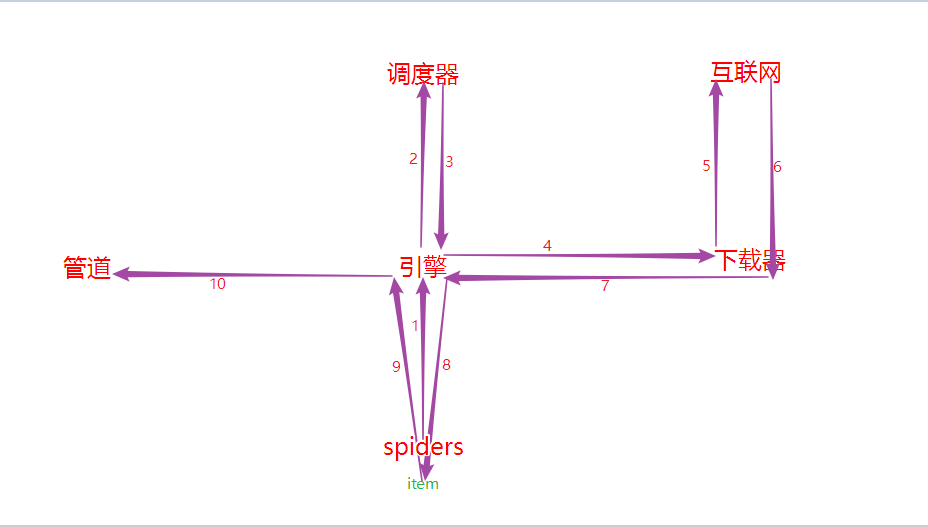

一.Scrapy五大核心组件工作流程

1.核心组件

# 引擎(Scrapy)

对整个系统的数据流进行处理, 触发事务(框架核心).

# 调度器(Scheduler)

用来接受引擎发过来的请求. 由过滤器过滤重复的url并将其压入队列中, 在引擎再次请求的时候返回. 可以想像成一个URL(抓取网页的网址或者说是链接)的优先队列, 由它来决定下一个要抓取的网址是什么.

# 下载器(Downloader)

用于下载网页内容, 并将网页内容返回给蜘蛛(Scrapy下载器是建立在twisted这个高效的异步模型上的).

# 爬虫(Spiders)

爬虫是主要干活的, 它可以生成url, 并从特定的url中提取自己需要的信息, 即所谓的实体(Item). 用户也可以从中提取出链接, 让Scrapy继续抓取下一个页面.

# 项目管道(Pipeline)

负责处理爬虫从网页中抽取的实体, 主要的功能是持久化实体、验证实体的有效性、清除不需要的信息. 当页面被爬虫解析后, 将被发送到项目管道, 并经过几个特定的次序处理数据.

2.工作流程

- spider中的url被封装成请求对象交给引擎(每一个url对应一个请求对象);

- 引擎拿到请求对象之后, 将其全部交给调度器;

- 调度器拿到所有请求对象后, 通过内部的过滤器过滤掉重复的url, 最后将去重后的所有url对应的请求对象压入到队列中, 随后调度器调度出其中一个请求对象, 并将其交给引擎;

- 引擎将调度器调度出的请求对象交给下载器;

- 下载器拿到该请求对象去互联网中下载数据;

- 数据下载成功后会被封装到response中, 随后response会被交给下载器;

- 下载器将response交给引擎;

- 引擎将response交给spiders;

- spiders拿到response后调用回调方法进行数据解析, 解析成功后产生item, 随后spiders将item交给引擎;

- 引擎将item交给管道, 管道拿到item后进行数据的持久化存储.