1.查找命令

bin/hadoop

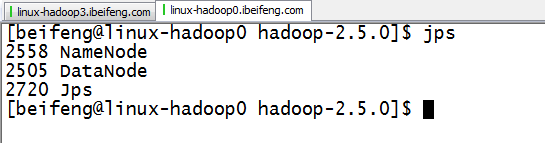

2.启动两个HDFS集群

hadoop0,hadoop1,都是伪分布式的集群

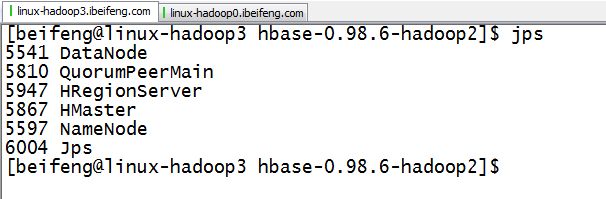

3.启动hadoop3的zookeeper与hbase

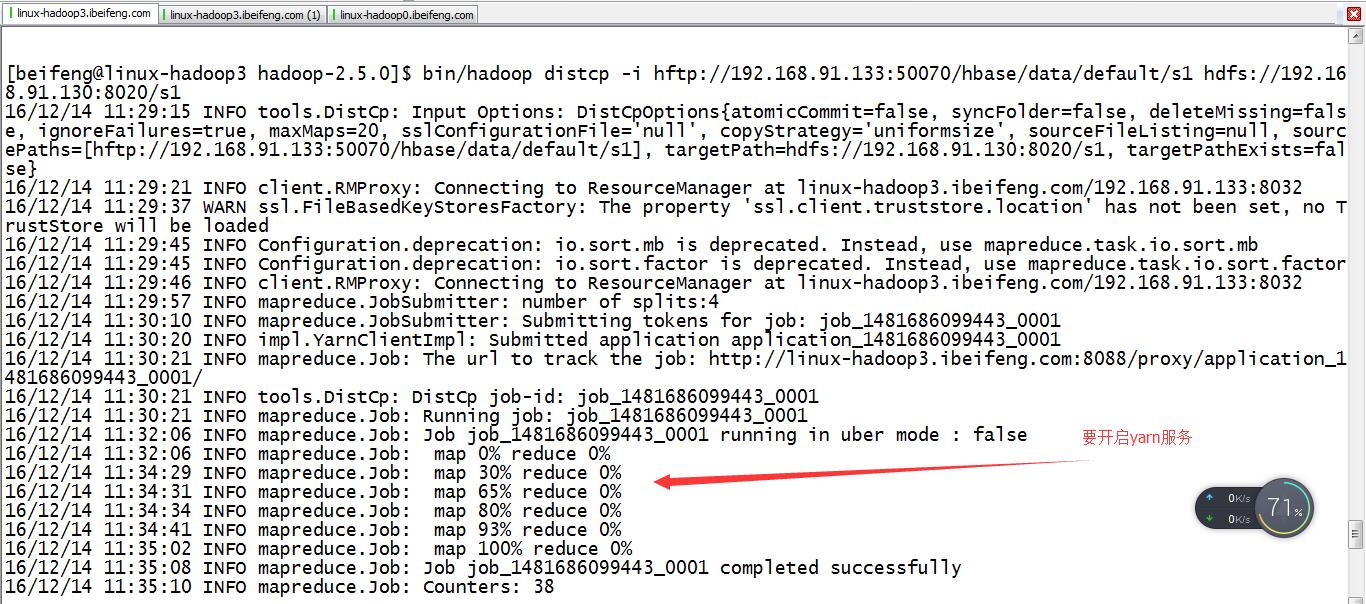

注意点:需要开启yarn服务,因为distcp需要yarn。

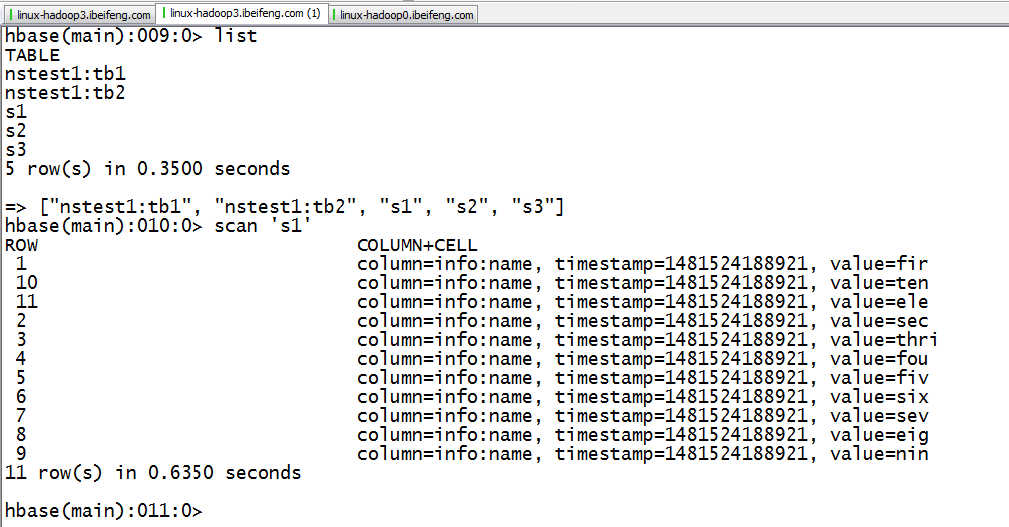

3.在hdfs上可以看到hadoop3上有表s1.

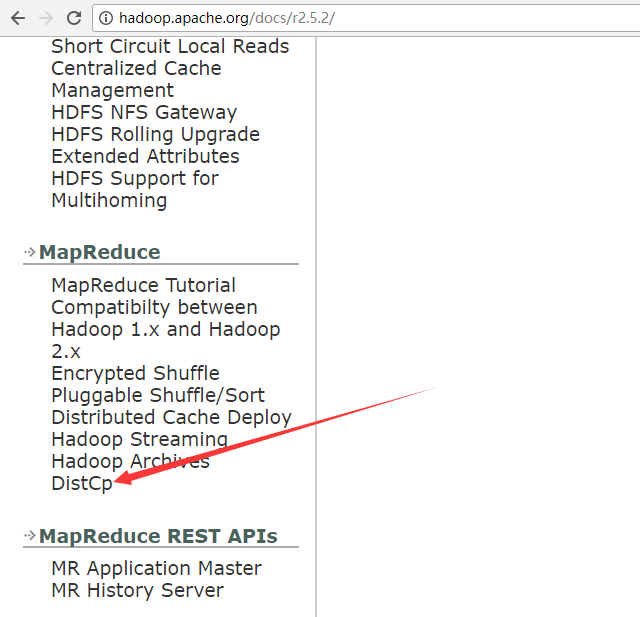

4.官网

下面使用的情况是:不同版本的集群之间进行拷贝,建议查官网。

-----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

5.拷贝hadoop3上的s1到hadoop0

bin/hadoop distcp -i hftp://192.168.91.133:50070/hbase/data/default/s1 hdfs://192.168.91.130:8020/s1

使用hadoop的distcp,因为hbase底层是HDFS,所以要拷贝底层数据,后面关于表,在使用hbase的修复。

hadoop的修复可以看命令bin/hdfs。

hbase的修复命令可以看bin/hbase。

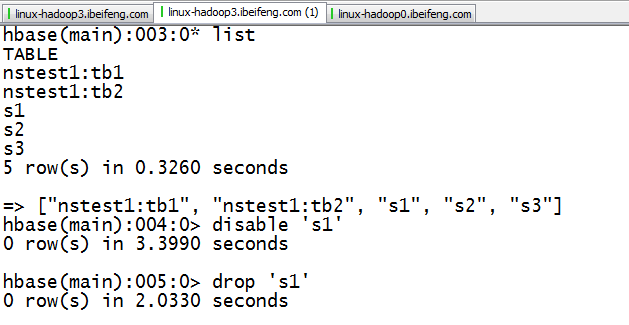

5.删除在hadoop3中的元数据

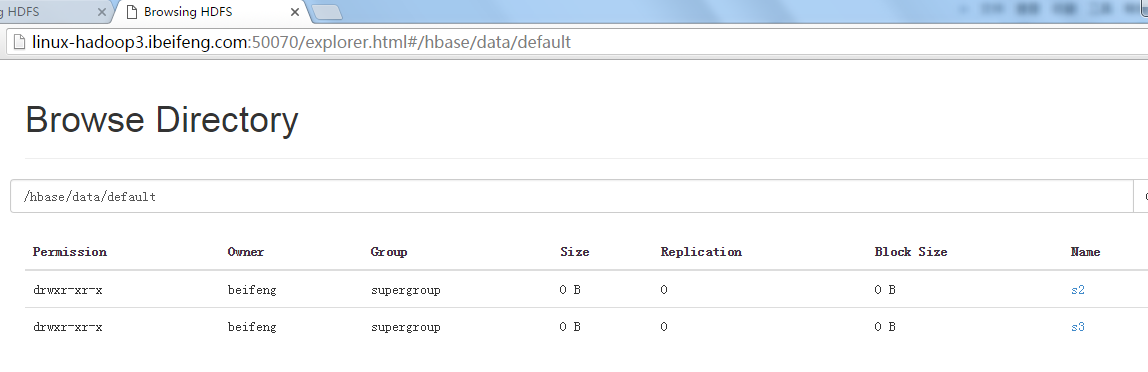

6.在hadoop3的hdfs上同样不再有数据s1

7.重新把数据从hadoop0上迁移到hadoop3上

bin/hadoop distcp -i hftp://192.168.91.130:50070/s1 hdfs://192.168.91.133:8020/hbase/data/default/s1

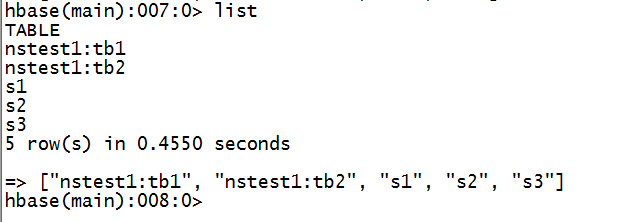

8.hbase中状况

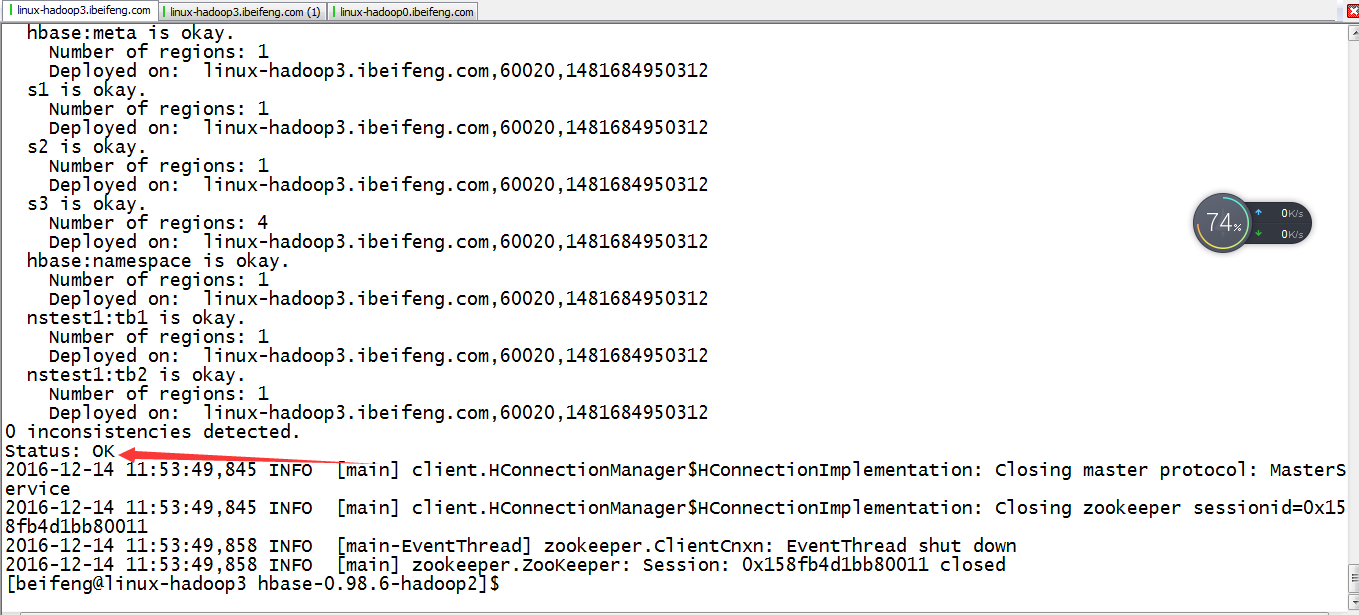

9.修复元数据

bin/hbase hbck -fixAssignments -fixMeta

10.使用