运行scrapy项目,在其他地方运行都没问题的情况下,但在某台服务器部署报错:spider 'xxx not found

在网上搜索此问题,一堆都是爬虫名字写错或目录等问题,但在确信这些都没问题的情况下:

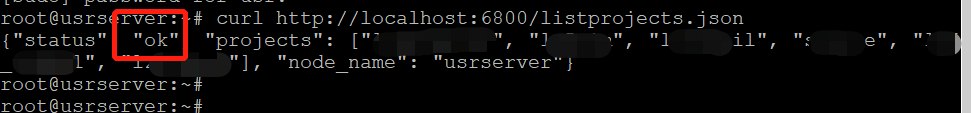

1)通过scrapy官网api查看已经上传至scrapyd服务的项目:

curl http://localhost:6800/listprojects.json

status是ok,证明项目是上传成功的

2)查看项目中的所有爬虫名称:

curl http://localhost:6800/listspiders.json?project=项目名称

发现问题,spiders为空,但打包上传的egg里面确实是有爬虫的,很神奇的现象,也没报其他错误

3)在一顿猛操作后还是有这个问题,最后只能将项目源码上传至服务器运行,运行.py后发现:报错缺少第三方依赖库。这里吐血ing中,装完缺少的依赖库重新运行后正常。。。

但明明使用依赖清单requirements.txt安装过依赖库了,而且!运行打包好的项目也没报缺少库的问题,运行正常没报相关错误。。。

都是血的教训呀!!!