上次安装了scala-2.11.8,这次安装spark-2.1.0版本

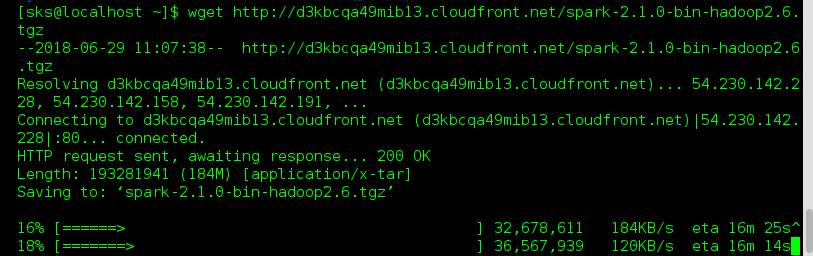

1、下载spark-2.1.0

打开terminal 进入当前用户目录 /home/sks

wget http://d3kbcqa49mib13.cloudfront.net/spark-2.1.0-bin-hadoop2.6.tgz

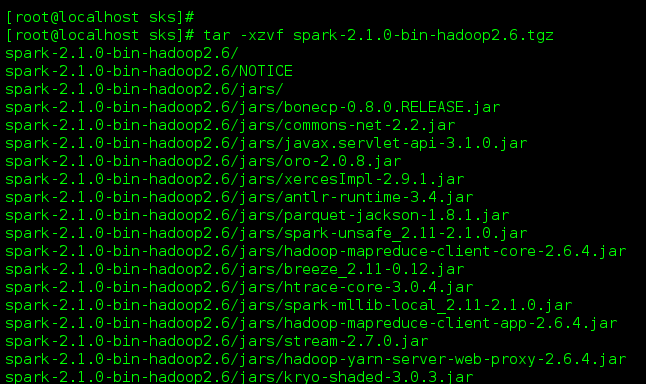

2、解压

tar -zxvf spark-2.1.0-bin-hadoop2.6.tgz

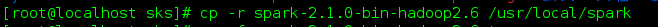

把spark-2.1.0-bin-hadoop2.6文件夹拷贝到 /usr/local/spark中,没有目录创建

mkdir -p /usr/local/spark

cp -r spark-2.1.0-bin-hadoop2.6 /usr/local/spark

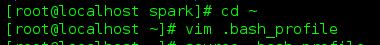

3、设置环境变量

进入根目录:cd ~

增加以下内容:

export SPARK_HOME=/usr/local/spark/spark-2.1.0-bin-hadoop2.6

export PATH=$PATH:$SPARK_HOME/bin

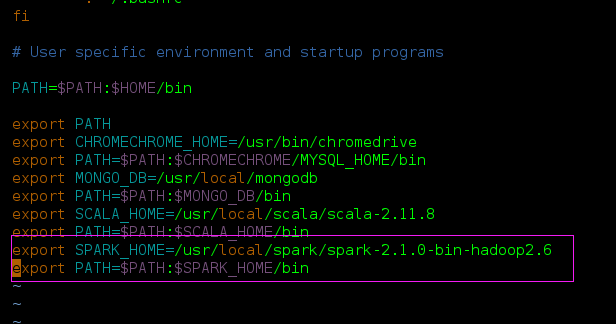

输入:source .bash_profile

使环境变量快速生效

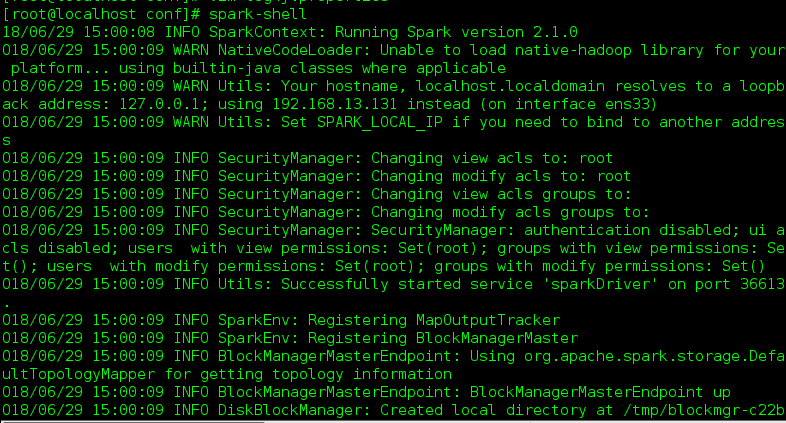

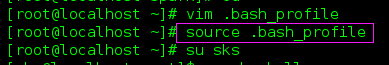

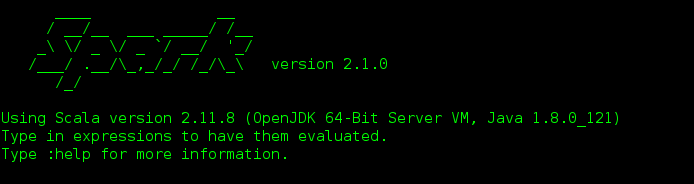

4、验证安装成功

输入spark-shell

说明安装成功

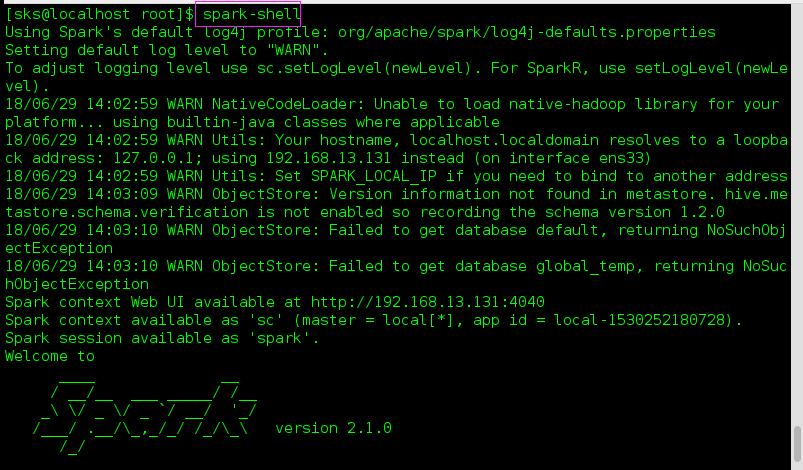

5、修改log4j

看到上面提示信息中有warn

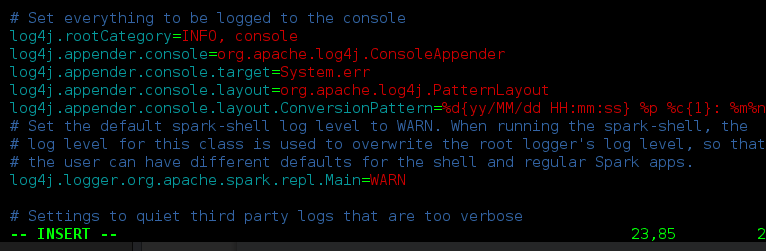

由于Spark core的默认日志级别是warn,所以看到信息不多,现在将Spark安装目录的conf文件夹下

首先进入conf目录,

复制一个文件 cp log4j.properties.template log4j.properties

然后进入log4j.properties 并将log4j.logger.org.apache.spark.repl.Main=INFO (把原来的WARN改为INFO,保存即可)

然后重新打开spark-shell,可以看到更多的打印信息