1.升级python2.7(python2.7.3)

wget http://python.org/ftp/python/2.7.3/Python-2.7.15.tar.bz2

tar -jxvf Python-2.7.15.tar.bz2

cd Python-2.7.15

./configure

make all

make install

make clean

make distclean

mv /usr/bin/python /usr/bin/python2.6.6

ln -s /usr/local/bin/python2.7 /usr/bin/python2.7.15

修改yum

vim /usr/bin/yum

头部:!/usr/bin/python2.6.6

2.安装jdk(version 1.8.0)

yum install -y java-1.8.0-openjdk*

3.安装scala(Scala2.11.8)

下载scala对应版本

tar -zxvf scala.2.11.8.tgz

vim /etc/profile

export SCALA_HOME=/root/scala/scala-2.11.8

export JAVA_HOME=/usr/lib/jvm/java/jre

export PATH=$PATH:$SCALA_HOME/bin

source /etc/profile

安装成功

4.安装hadoop(集群使用)

参考链接

给认证文件授权

chmod 600 ~/.ssh/authorized_keys

http://dblab.xmu.edu.cn/blog/1177-2/

http://www.powerxing.com/install-hadoop/

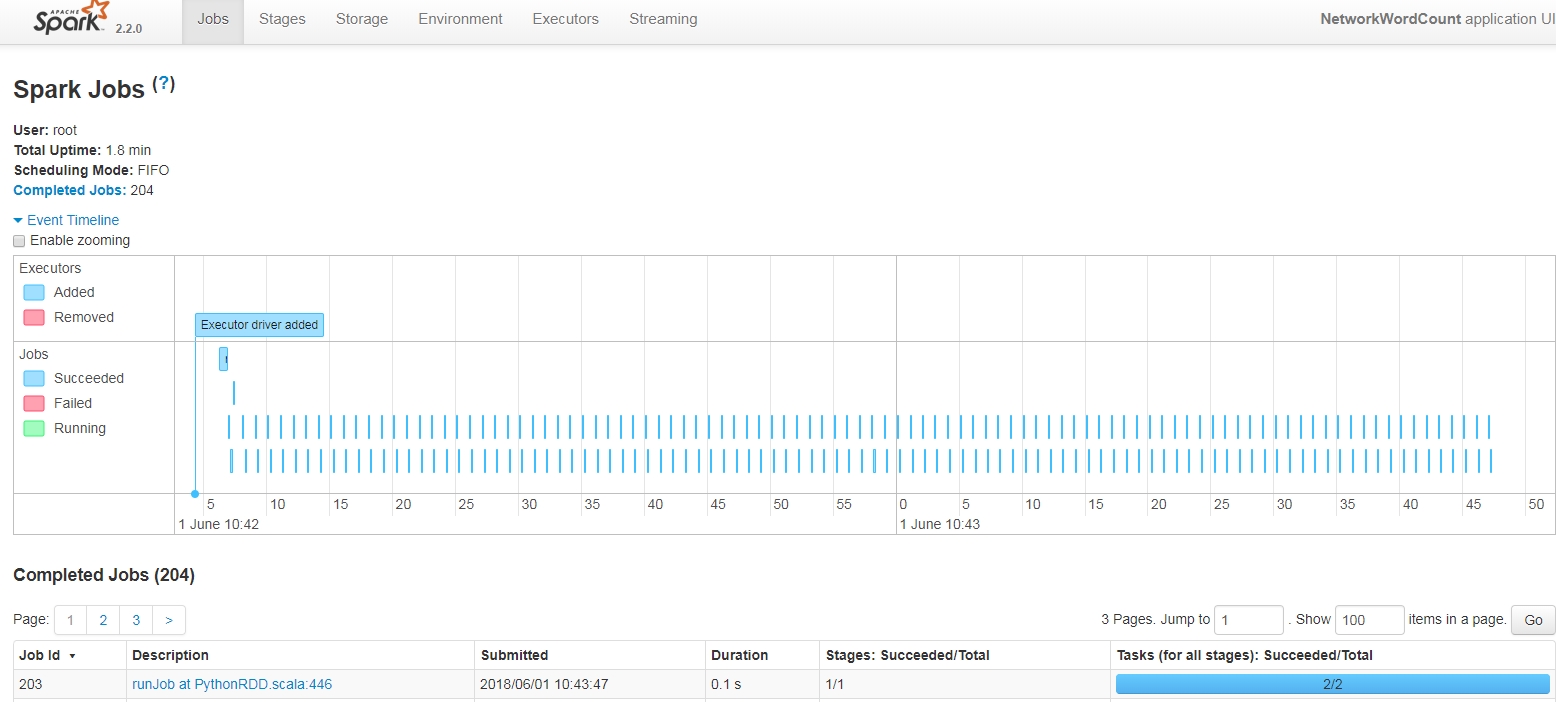

5.安装spark

参考链接

http://dblab.xmu.edu.cn/blog/1187-2/

集群上运行spark

提交python

1.spark-submit xxx.py (单机运行)

2.spark-submit --master spark://host:7077 --executor -memory 10g xxx.py

--master标记指定集群url

spark://host:port 连接指定端口的spark独立集群。默认7707端口

yarn:链接到一个YARN集群,当在YARN上运行时,需要设置环境变量HADOOP_CONF_DIR只想hadoop配置目录,获取集群信息。

local :运行本地模式,单核

local[N]:本地模式,多个核心

local[*]:本地模式,使用尽可能多的核心

常见标记:

--master 表示要链接的集群管理器

--deploy-mode:选择本地启动驱动器程序,还是在集群中的一台工作节点启动。默认本地模式

--class 运行Java或scala程序时应用的主类

--name 应用的显示名,显示在网页界面中

--jars:上传放到应用的classpath中的jar包列表,如果依赖少量jar包,可以应用

--files 需要放到应用工作目录中的文件列表。这个参数一般用来放需要分发到各个节点的数据文件

--py-files 需要添加到pythonpath中的文件列表,可以包含.py .egg以及.zip文件

--executor-memory:执行器进程中使用的内存量,字节为单位。可以使用后缀指定更大的单位。(examp:512m(mb) 15g(GB))

--driver-memory:驱动器进程中使用的内存量,字节为单位。可以使用后缀指定更大的单位。同上