1、volume存储

kubernetes支持以下类型卷:awsElasticBlockStore ,azureDisk ,azureFile ,cephfs ,csi ,downwardAPI ,emptyDir,fc,flocker ,gcePersistentDisk ,gitRepo ,glusterfs ,hostPath, iscsi, local, nfs,persistentVolumeClaim, projected ,portworxVolume ,quobyte ,rbd ,scaleIO, secret,storageos ,vsphereVolume

hostPath:卷将主机节点的文件系统中的文件或目录挂载到集群中

hostPath的用途如下:

运行需要访问 Docker 内部的容器;使用 /var/lib/docker 的 hostPath

在容器中运行 cAdvisor;使用 /dev/cgroups 的 hostPath

允许 pod 指定给定的 hostPath 是否应该在 pod 运行之前存在,是否应该创建,以及它应该以什么形式存在

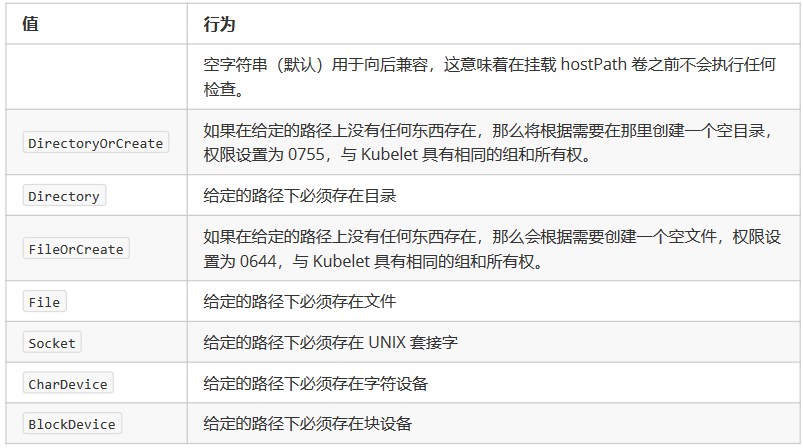

除了所需的 path 属性之外,用户还可以为 hostPath 卷指定 type

使用这种卷类型请注意,因为:

由于每个节点上的文件都不同,具有相同配置(例如从 podTemplate 创建的)的 pod 在不同节点上的行为

可能会有所不同。

当 Kubernetes 按照计划添加资源感知调度时,将无法考虑 hostPath 使用的资源。

在底层主机上创建的文件或目录只能由 root 写入。您需要在特权容器中以 root 身份运行进程,或修改主机

上的文件权限以便写入 hostPath 卷。